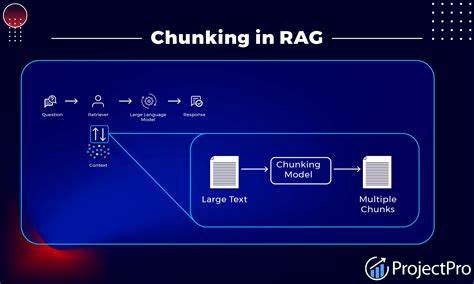

Retrieval-Augmented Generation, kurz RAG, ist ein innovativer Ansatz im Bereich der Künstlichen Intelligenz, der die Vorteile von Wissensdatenbanken und Sprachmodellen kombiniert. Die Effektivität von RAG-Systemen hängt maßgeblich von der Art und Weise ab, wie Inhalte in verarbeitbare Einheiten, sogenannte Chunks, aufgeteilt werden. Die richtige Chunking-Strategie ist entscheidend, um die Leistung und Genauigkeit der Antworten zu optimieren. Doch wie lässt sich die beste Chunking-Methode für ein spezifisches RAG-Projekt identifizieren und bewerten? Diese Frage überfordert viele Entwickler und Datenwissenschaftler, die sich auf Vermutungen oder isolierte Tests verlassen. Ein systematischer Ansatz erleichtert hingegen die Auswahl und Verbesserung der Chunking-Technik erheblich.

Chunking beschreibt den Prozess, umfangreiche Dokumente oder Datenbestände in kleinere, gut handhabbare Abschnitte zu unterteilen. Die Größe, Struktur und Semantik dieser Einheiten sind maßgeblich für die Qualität der nachfolgenden Retrieval- und Generierungsprozesse. Falsches oder unstrukturiertes Chunking kann dazu führen, dass relevante Informationen fragmentiert werden, was wiederum die Genauigkeit der Ergebnisgenerierung beeinträchtigt. Andererseits ermöglicht eine durchdachte Chunking-Strategie, dass die Wissensbasis effektiv durchsucht und kontextuell passgenaue Antworten erzeugt werden. Zunächst ist das Verständnis der verschiedenen existierenden Chunking-Strategien essenziell.

Dazu gehören vor allem das rekursive Zeichensplitting, semantic Chunking und agentic Chunking. Rekursives Zeichensplitting konzentriert sich auf eine technische Aufteilung der Texte in kleinere Teile basierend auf Zeichen- oder Wortanzahl. Diese Vorgehensweise ist relativ schnell umzusetzen, weist jedoch Schwächen bei der Erfassung semantischer Zusammenhänge auf, da die Einheiten oft rein zufällig oder nach festen Längen getrennt sind. Semantic Chunking zielt darauf ab, die Bedeutungseinheiten innerhalb eines Textes zu erkennen und zu bewahren. Anstatt willkürlich zu trennen, werden Abschnitte durch natürliche sprachliche Grenzen oder inhaltlich kohärente Segmente gebildet.

Dies erhöht die Wahrscheinlichkeit, dass ein einzelner Chunk eine komplette kontextuelle Information enthält, wodurch die Relevanz bei der Suche in der Datenbank verbessert wird. Allerdings ist diese Methode komplexer und ressourcenintensiver, da sie häufig auf Natural Language Processing (NLP) und semantische Analysen zurückgreift. Agentic Chunking repräsentiert einen innovativen Ansatz, bei dem automatisierte Agenten auf Basis von vorgegebenen Regeln oder maschinellem Lernen Dokumente selbständig in optimale Abschnitte zerlegen. Diese Technik verbindet die Vorteile des semantischen Verständnisses mit adaptiven Mechanismen zur kontinuierlichen Verbesserung. Trotz des Potenzials ist agentic Chunking anspruchsvoll in der Implementierung und setzt oft spezialisierte Infrastruktur sowie Expertise voraus.

In der Praxis steht oft auch Clustering als eine vereinfachte und kosteneffiziente Alternative zur Debatte. Hierbei werden ähnliche Textabschnitte gruppiert, um eine effiziente Suche zu ermöglichen. Clustering erlaubt eine schnelle Verarbeitung großer Datenmengen, jedoch besteht das Risiko, dass thematisch heterogene, aber oberflächlich ähnliche Texte zusammengelegt werden. Hier muss die Balance zwischen Verarbeitungsgeschwindigkeit und inhaltlicher Präzision gut abgewogen werden. Um die optimale Chunking-Strategie zu bestimmen, ist eine systematische Evaluierung entscheidend.

Ein etabliertes Vorgehen umfasst die Definition klarer Erfolgskriterien, die Durchführung von kontrollierten Tests und die Analyse der Ergebnisse anhand messbarer Metriken. Zur Bewertung eignen sich insbesondere Genauigkeit, Vollständigkeit und Effizienz der Antwortgenerierung. Außerdem ist die Skalierbarkeit der Methode relevant, um auch bei wachsendem Datenvolumen und unterschiedlichen Dokumenttypen konsistente Ergebnisse sicherzustellen. Die Experimentierphase sollte diverse Datensätze und Anwendungsfälle umfassen. Beispielsweise können strukturierte Fachtexte vollkommen andere Anforderungen an das Chunking stellen als unstrukturierte Kundenanfragen oder historische Archive.

Dabei ist es hilfreich, nicht nur quantitative Metriken zu betrachten, sondern auch qualitative Bewertungen durch Experten einzubeziehen. Somit lässt sich die Praxistauglichkeit der Strategie umfassend beurteilen. Ein weiterer wichtiger Aspekt ist die Integration der Chunking-Technik in den gesamten RAG-Workflow. Die Kompatibilität mit genutzten Vektor-Datenbanken, die Anpassung an die Eigenschaften des eingesetzten Sprachmodells und Möglichkeiten zur Nachbearbeitung der Chunks sind entscheidende Faktoren. Auch sollten potenzielle Fehlerquellen, wie Informationsverlust durch zu grobe Aufteilung oder Überlappungen zwischen den Chunks, explizit adressiert und reduziert werden.

Neue Entwicklungen im Bereich großer Kontextfenster bei Sprachmodellen werfen zwar die Frage auf, ob Chunking noch relevant bleibt, doch zeigen Erfahrungen und Studien, dass das Chunking weiterhin unabdingbar ist. Selbst Modelle mit erweiterten Kontextlängen profitieren von durchdachten Chunking-Strategien, da sie damit effizienter und präziser arbeiten können, besonders bei umfangreichen Datensätzen. Zusammenfassend lässt sich festhalten, dass die Auswahl der richtigen Chunking-Strategie ein komplexer, aber lohnender Prozess ist. Wer sich systematisch mit den diversen Methoden auseinandersetzt, fundierte Tests durchführt und die Ergebnisse kritisch analysiert, wird die Qualität seiner RAG-Systeme signifikant steigern können. Zudem schafft eine klare Dokumentation der Prozesse Transparenz und erleichtert zukünftige Anpassungen.

In der Praxis empfiehlt es sich, mit einfachen Methoden wie rekursivem Zeichensplitting zu starten, um erste Modelle zu etablieren und deren Leistung zu beurteilen. Danach kann man schrittweise zu semantischen oder agentischen Ansätzen übergehen, um die Systemperformance weiter zu optimieren. Parallel sollten Monitoring- und Evaluationsmechanismen implementiert werden, damit Veränderungen fundiert nachvollzogen werden können. RAG-Projekte profitieren somit nicht nur von leistungsstarken KI-Komponenten, sondern vor allem von guten Datenaufbereitungsprozessen. Chunking ist hier der Schlüssel, um Wissen effizient zu strukturieren und Zugriffe intelligent zu gestalten.

Nur wer diesen Schritt wohlüberlegt gestaltet, wird langfristig von den Möglichkeiten der Retrieval-Augmented Generation profitieren und seine Anwendungen auf das höchstmögliche Niveau heben.