In der Welt der Programmierung und numerischen Berechnungen sind Gleitkommazahlen allgegenwärtig. Zahlen mit Dezimalstellen, die nicht exakt als Brüche mit Basis zwei dargestellt werden können, werden in Computern durch Gleitkommadarstellungen approximiert. Doch gerade diese Darstellung bringt eine Reihe von Herausforderungen mit sich – besonders wenn es darum geht, zwei solche Zahlen auf Gleichheit oder Ähnlichkeit zu überprüfen. Die naheliegende Methode, Gleitkommazahlen mittels des Gleichheitsoperators (==) direkt zu vergleichen, führt oft zu unerwarteten Ergebnissen und Fehlern. Um dieses Phänomen zu verstehen, muss man tiefer in die Funktionsweise der Gleitkommadarstellung eintauchen und die Konzepte von Genauigkeit und Rundungsfehlern begreifen.

Gleitkommazahlen basieren meist auf dem IEEE 754-Standard, der eine begrenzte Anzahl von Bits verwendet, um Zahlen zu repräsentieren. Dabei wird die Zahl in eine Mantisse und einen Exponenten zerlegt. Dies hat zur Folge, dass viele Dezimalwerte, etwa 0,1, intern nicht exakt gespeichert werden können. Die gespeicherte Zahl ist immer eine Annäherung, eine binäre Bruchzahl, die möglichst nahe am Originalwert liegt. Diese Ungenauigkeit kann sich bei aufeinanderfolgenden Operationen aufsummieren oder durch unterschiedliche Berechnungspfade verstärken.

Deshalb gleicht das Ergebnis von scheinbar identischen Berechnungen nicht immer 1:1 übereinander. Ein klassisches Beispiel veranschaulicht dies: Wenn man floatwerte von 0,1 zehnmal addiert und das Ergebnis mit dem Produkt von 0,1 und 10 vergleicht, weichen diese beiden Resultate geringfügig voneinander ab. Dieses Phänomen entsteht durch verschiedene Rundungs- und Additionsweisen im Binärsystem. Selbst Multiplikationen im gleichen Datentyp können unterschiedliche Gerundeten ergeben, abhängig davon, ob Zwischenergebnisse in höherer Genauigkeit gehalten oder sofort zurückkonvertiert werden. Deshalb ist der naive Vergleich mit "==" zur Gleichheitsprüfung von Gleitkommazahlen oft nicht zweckdienlich und wird von modernen Compilern teilweise mit Warnmeldungen versehen.

Entwickler sind gefordert, alternative Vergleichsstrategien einzusetzen, die die inhärente Ungenauigkeit respektieren und tolerante Vergleichsgrenzen definieren. Eine häufig genutzte Technik ist der sogenannte Epsilon-Vergleich. Dabei wird nicht auf exakte Gleichheit geprüft, sondern darauf, ob zwei Werte innerhalb eines bestimmten Abstands, der Epsilon genannt wird, liegen. Dabei ist Epsilon eine kleine positive Konstante, die als Toleranzschwelle agiert. Die einfachste Form realisiert man durch den Vergleich der absoluten Differenz zweier Werte mit Epsilon.

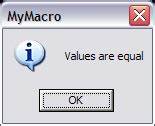

Ist die Differenz kleiner oder gleich diesem Grenzwert, betrachtet man die Werte als „fast gleich“. Hierbei steht man jedoch vor der Herausforderung, einen geeigneten Wert für Epsilon zu bestimmen. Ein standardmäßig oft genutzter Wert ist FLT_EPSILON, definiert im float.h-Header, der die kleinste Zahl beschreibt, die zu 1.0 addiert eine andere darstellt (also die Auflösung des Datentyps im Bereich um 1).

FLT_EPSILON liegt für single precision etwa bei 1,19e-7. Doch Epsilon ist nicht universell gültig für den gesamten Zahlenbereich. Die Granularität der darstellbaren Zahlen hängt vom Exponenten ab: Je größer der Wert, desto größer der Abstand zwischen zwei benachbarten Fließkommazahlen; umgekehrt schrumpft dieser Abstand bei sehr kleinen Zahlen. Ein starrer Absolutwert wie FLT_EPSILON ist deshalb außerhalb eines bestimmten Bereichs entweder zu streng oder zu großzügig. Um diese Problematik zu umgehen, wird oft der relative Epsilon-Vergleich eingesetzt.

Dabei wird die absolute Differenz der beiden Werte nicht mit einem fixen Grenzwert verglichen, sondern proportional zum Betrag der Zahlen. Genauer gesagt: Die Differenz muss kleiner sein als ein kleiner Anteil des größeren Absolutwerts der beiden Zahlen. Auf diese Weise passen sich die Toleranzen dynamisch an die Größenordnung der Werte an. Der relative Vergleich bietet bessere Flexibilität, besitzt aber eine Schwäche, wenn einer der Werte nahe Null liegt. Näherungsweise sollten Werte, die nahe Null liegen, eher mit einer absoluten Toleranz geprüft werden, da die relative Differenz bei Werten nahe Null sehr groß oder sogar undefiniert wird.

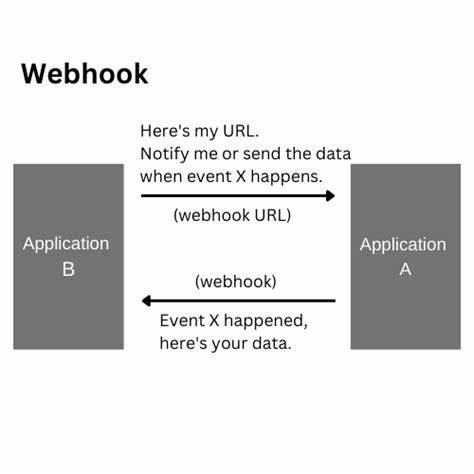

Deshalb existiert in der Praxis oft eine Kombination aus absoluter und relativer Prüfung, um Vergleichsergebnisse sowohl in der Nähe von Null als auch bei größeren Werten sinnvoll zu ermöglichen. Eine fortschrittliche Methode ist die Verwendung von ULPs (Units in the Last Place), also Einheiten im letzten Stellenwert. Dabei wird die Differenz der bitweisen Repräsentation zweier Gleitkommazahlen betrachtet. Die Idee beruht darauf, dass benachbarte Gleitkommazahlen in C/C++ als ganze Zahlen in einer Reihenfolge liegen, sodass die Differenz ihrer Integer-Darstellungen genau angibt, wie viele Zwischenwerte es zwischen den Zahlen gibt. Mit ULP-Vergleich kann präzise angegeben werden, wie nah zwei Zahlen im Speicherlayout beieinanderliegen.

Beispielsweise bedeutet ein Unterschied von einer ULP, dass zwei Zahlen direkt aufeinander folgen. ULP-basierte Vergleiche sind oft hilfreicher, da sie den nativen Fortschritt im Wertebereich berücksichtigen. Allerdings ist die Behandlung von Zahlen mit unterschiedlichem Vorzeichen, NaNs und Spezialwerten wie Unendlich komplizierter. Zudem funktionieren ULP-Vergleiche nahe Null nicht gut, da die Interpretationslogik bei kleinen oder gegensätzlichen Vorzeichen versagt. Diese Aspekte führen zu der Erkenntnis, dass kein einzelner Vergleichsansatz universell richtig und optimal ist.

Ein „Allzweck“-Vergleich benötigt Kontextinformationen über die zu vergleichenden Werte, ihre Entstehung und ihre erwarteten Genauigkeiten. Anwendungen mit hohem Anspruch an numerische Stabilität analysieren typischerweise ihre Algorithmen auf Fehlergrenzen und wählen tolerante Werte basierend auf dem erwarteten Rundungsfehler und der Kondition des Problems. Ein oft übersehener Fehlerherd ist die sogenannte katastrophale Auslöschung. Dabei führen Subtraktionen zweier sehr ähnlicher Zahlen zu einem starken Verlust signifikanter Stellen und heftigen relativen Fehlern im Ergebnis. Klassisches Beispiel ist die Berechnung von sin(π).

Weil π irrational und nicht exakt darstellbar ist, berechnet die Funktion in Wahrheit sin(π plus/minus einem kleinen Fehler). Die Änderung (sin) ist in kleinen Bereichen linear mit einer Steigung nahe -1, sodass das Ergebnis selbst eher den Fehler in π reflektiert als den eigentlichen Wert Null. Das resultierende Ergebnis liegt dann weit entfernt von Null in relativer Hinsicht, was viele Vergleichsalgorithmen scheitern lässt. Hier hilft eher eine Kombination aus präziser Modellierung des Problems sowie angepasster Sonderbehandlung. Ein wichtiger Tipp für Entwickler ist, immer zu verstehen, was die eigenen Zahlen physikalisch oder mathematisch repräsentieren.

Nur so lassen sich sinnvoll Toleranzen ableiten. Der nicht kontextgebundene Einsatz von Vergleichsvorschriften verursacht oft mehr Schaden als Nutzen. Wer beispielsweise Messdaten vergleicht, sollte Fehlertoleranzen aus der Messtechnik übernehmen; bei wissenschaftlichen Simulationen empfiehlt sich die Analyse konditioniertheit und algorithmischer Stabilität. Im praktischen Codieren empfiehlt sich beim Vergleichen von Gleitkommazahlen häufig die Kombination aus einem absolutem und relativem Schwellenwert in einer Funktion. Diese vergleicht zuerst, ob die Werte ausreichend „nah“ aneinander liegen unabhängig von ihrer Größe (absolute Toleranz), und wenn nicht, ob sie in Relation zueinander einen akzeptablen Unterschied aufweisen (relative Toleranz).

Zudem sollte nahe Null stets eine Favorisierung der absoluten Toleranz erfolgen. Als weitere gute Praktik gilt die Beachtung der Rechen- und Repräsentationsarchitektur. Unterschiedliche Prozessoren und Compilerverhalten (etwa x87 FPU vs. SSE auf Intel-Systemen) beeinflussen Rundungsstrategien und können damit Vergleichsergebnisse beeinflussen. Insbesondere in mehrstufigen Builds lohnt sich das Testen unter verschiedenen Compiler-Flags und Hardwareplattformen.

Abschließend lässt sich sagen, dass der Umgang mit Gleitkommazahlen sowohl mathematisches Verständnis als auch pragmatisches Handwerkszeug erfordert. Entwickler sollten die Grenzen der numerischen Genauigkeit kennen, geeignete Vergleichsmethoden adaptieren und sich darüber bewusst sein, dass „Absolutgleichheit“ oft unerreichbar ist. Nur mit dieser Denkweise lassen sich robuste, wartbare und verlässliche Anwendungen erstellen, die Floating-Point-Daten richtig behandeln und unerwartete Fehler vermeiden.