In der heutigen digitalen Welt stellen Betrug und Finanzkriminalität eine der größten Herausforderungen für Unternehmen und Finanzinstitute dar. Die immer ausgeklügelteren Angriffsmethoden erfordern zugleich immer komplexere und innovative Verteidigungsstrategien. Besonders spannend ist dabei die Rolle der Künstlichen Intelligenz (KI), die nicht nur für Angriffe eingesetzt werden kann, sondern auch für den Schutz und die Stärkung von Systemen. Ein Konzept, das sich zunehmend in der Betrugsbekämpfung etabliert, sind sogenannte Red Team/Blue Team Ansätze, bei denen KI-Agenten als Gegenspieler fungieren, um Schwachstellen aufzudecken und gleichzeitig wirksame Verteidigungsmechanismen zu entwickeln. Diese Methode hat das Potenzial, die Art und Weise, wie Unternehmen Betrugsmodelle entwickeln und trainieren, grundlegend zu verändern.

Red Team und Blue Team stammen ursprünglich aus der Cybersicherheit und stellen zwei konkurrierende Gruppen dar, die gegeneinander antreten, um ein System zu testen und zu verteidigen. Das Red Team übernimmt dabei die Rolle des Angreifers, das Blue Team die des Verteidigers. Von diesem Prinzip inspiriert werden heute KI-Agenten eingesetzt, die sich gegenseitig herausfordern: Die „bösen“ Agenten simulieren Betrugsversuche, während die „guten“ Agenten diese Angriffe erkennen und abwehren sollen. Diese Dynamik ermöglicht es, realistische Angriffsszenarien nachzubilden, ohne dabei echte Kundendaten oder Systeme zu gefährden. Gerade bei Finanzprodukten, die komplexe Zahlungsinstrumente und vielfältige Geldbewegungen kombinieren, zeigt sich nach ihrer Markteinführung ein besonders hohes Risiko für Betrug.

Betrüger nutzen Schwachstellen gezielt aus, oft unmittelbar nach dem Launch einer neuen Funktion. Sie testen alle verfügbaren Angriffsvektoren wie gestohlene Kreditkartendaten, gefälschte Identitäten, soziale Manipulation oder technische Sicherheitslücken. Dabei bilden sich schnell Netzwerke, die entdeckte Schwachstellen kollektiv ausnutzen, um möglichst schnell finanzielle Gewinne zu erzielen. Die Herausforderung für die Sicherheitsteams ist es, mit dieser Entwicklung Schritt zu halten und kontinuierlich neue Betrugsmuster zu erkennen und zu verhindern. Durch den Einsatz von KI-Agenten als adversarielle Partner lässt sich dieser Wettlauf der Kreativität zwischen Betrügern und Sicherheitsteams effektiver gestalten.

Die KI kann innerhalb kurzer Zeit große Mengen an Angriffsszenarien generieren und ausführen, die über menschliche Möglichkeiten hinausgehen. Dabei können beispielsweise gestohlene Zugangsdaten automatisiert ausprobiert oder die Kombination verschiedener Schwachstellen erkundet werden. Gleichzeitig lernen die Verteidigungsagenten aus den Angriffen und verbessern kontinuierlich ihre Modelle zur Betrugserkennung. Dieser Ansatz ist besonders in der Testphase vor der Markteinführung neuer Produkte wertvoll. Die KI-Agenten können im Staging- oder Qualitätsprüfungsumfeld simulierte Angriffe starten, um Schwachstellen aufzudecken, lange bevor ein echtes Sicherheitsrisiko für Kunden entsteht.

Darüber hinaus ist es auch denkbar, die KI-Red Team/Blue Team Aktivität im Live-Betrieb fortlaufend anzuwenden. Dabei können kontrollierte Angriffe auf echte Zahlungsvorgänge erfolgen, bei denen das gestohlene Geld auf vom Unternehmen kontrollierte Konten überführt wird. So entsteht ein Praxisfeld für nachhaltige und iterative Verbesserung auf höchstem Sicherheitsniveau. Eine der größten Herausforderungen bei der praktischen Umsetzung sind rechtliche und ethische Fragen, insbesondere wenn gestohlene oder gefälschte Kundendaten in den Versuchsszenarien verwendet werden. Die Compliance-Anforderungen sind streng, weshalb technische Lösungen und organisatorische Vereinbarungen notwendig sind, um solche Tests legal und verantwortungsbewusst zu gestalten.

Die Fähigkeit von KI, mit komplexen Authentifizierungsprozessen und Berechtigungen umzugehen, wird hier ausschlaggebend sein, um ein ausgewogenes Verhältnis zwischen realitätsnahen Tests und Datenschutz zu gewährleisten. Die fortschreitende Verbreitung von Instant Payments und digitalen Bezahlsystemen erhöht den Druck auf Sicherheitsteams weiter. Neue Technologien wie Voice Agents oder Deepfakes bieten modernen Betrügern zusätzliche Angriffsmöglichkeiten, beispielsweise durch Nachahmung von Stimmen oder Identitäten. Gleichzeitig schaffen moderne KI-gestützte Testagenten die Möglichkeit, solche komplexen Betrugsversuche frühzeitig zu erkennen und Gegenmaßnahmen zu entwickeln. Damit wird der Red Team/Blue Team Ansatz unverzichtbar für Unternehmen, die ihre Risiken minimieren und ihr Vertrauen bei Kunden und Regulierungsbehörden sichern wollen.

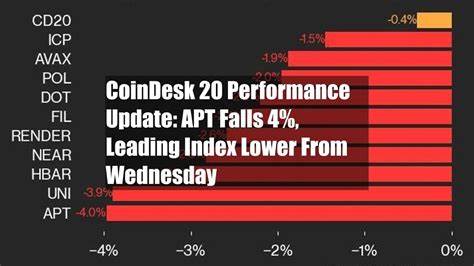

Darüber hinaus gewinnt die Blockchain-Technologie in der Finanzwelt an Bedeutung. Mit zunehmendem Onchain-Transaktionsvolumen und der Nutzung von Smart Contracts entstehen neue Angriffsmöglichkeiten, die gleichermaßen getestet und abgesichert werden müssen. KI-Agenten können helfen, intelligente Verträge auf Schwachstellen zu prüfen und potenzielle Betrugsvektoren aufzudecken, bevor sie realen Schaden anrichten. Die Integration von Red Team/Blue Team Konzepten in Blockchain-Sicherheitspraktiken stellt einen nächsten logischen Schritt in der Weiterentwicklung der Betrugsprävention dar. Schließlich bietet die Nutzung von KI als Gegenspieler im Sicherheitskontext eine Möglichkeit, Schritt für Schritt besser auf die ständig zunehmende Vielfalt und Raffinesse von Betrugsstrategien zu reagieren.

Während traditionelle Mustererkennung und statische Regeln an ihre Grenzen stoßen, sind KI-basierte adaptive Modelle in der Lage, unvorhersehbare komplexe Angriffe zu antizipieren und zu bekämpfen. Für große FinTech-Unternehmen, Banken und Zahlungsdienstleister kann dies nicht nur signifikante finanzielle Verluste verhindern, sondern auch Wettbewerbsvorteile schaffen, indem sie ihren Kunden sichere, vertrauenswürdige Finanzprodukte anbieten. Zusammenfassend lässt sich sagen, dass die Kombination aus Red Team und Blue Team Methoden mit KI-Agenten ein vielversprechender Ansatz ist, um Betrugsmodelle nachhaltig zu verbessern und die Sicherheit von Finanzsystemen zu erhöhen. Die Herausforderung liegt dabei in der Balance zwischen realistischen Angriffen, rechtlichen Rahmenbedingungen und technologischer Umsetzbarkeit. Die Zukunft der Betrugsbekämpfung wird maßgeblich von der Fähigkeit abhängen, intelligente, automatisierte und kontinuierlich lernende Systeme zu etablieren, die gemeinsam als Gegner und Verteidiger agieren.

So können Finanzunternehmen besser gerüstet sein gegen immer raffiniertere Angriffe und den Schutz ihrer Kunden und ihrer wirtschaftlichen Stabilität langfristig gewährleisten.