Wir befinden uns an einer faszinierenden Weggabelung in der Welt der künstlichen Intelligenz. KI-Agenten sind mittlerweile in nahezu jeder Branche präsent, besonders im Softwareentwicklungsbereich, wo sie die Arbeitsweise grundlegend verändern. Doch mit dieser rasanten Entwicklung kommen auch erhebliche Schwierigkeiten bei der Kontrolle und Steuerung der KI-Agenten auf uns zu. Viele Entwickler empfinden den Umgang mit diesen „robotischen Assistenten“ als nahezu unmögliche Mission. Doch mit den richtigen Methoden und Strategien lässt sich diese Herausforderung meistern.

Der Schlüssel zum Erfolg bei der Zusammenarbeit mit KI-Agenten liegt vor allem in sorgfältiger Planung und klar definierten Rahmenbedingungen. Es geht dabei nicht nur um die Auswahl der richtigen Werkzeuge, sondern vor allem darum, die „Materialien“ – also den eigenen Code, die Daten und die Eingaben an die KI – mit Bedacht zu gestalten und sinnvoll miteinander zu verknüpfen. Die Qualität der Inputs bestimmt maßgeblich die Qualität der Resultate. Versteht man KI-Tools als bloße Werkzeuge, darf man nicht vergessen, dass die Technik dahinter sich ununterbrochen weiterentwickelt. Die Tools sind nur eine Plattform, vergleichbar mit der Analogie zu Haushaltsgeräten mit unterschiedlichen Funktionen, doch letztlich gleichem Zweck.

Der eigentliche Unterschied wird durch die „Technik“ ausgemacht, also die Art und Weise, wie der Entwickler die Werkzeuge einsetzt und wie er seine Eingaben strukturiert. Kombiniert mit einem tiefen Verständnis der Werkzeuge und den neuesten Updates, erhält man so eine kraftvolle Arbeitsumgebung. Ein realistisches Selbstbild ist essenziell, wenn man mit KI-Agenten arbeitet. Gute Programmierkenntnisse allein reichen nicht aus. Es braucht Architekturikonen, um komplexe Strukturen zu überblicken, sowie die Fähigkeit, technische Details klar und verständlich zu kommunizieren.

Nur wer seine Stärken und Schwächen kennt, kann gezielt Aufgaben an die KI übergeben und an der richtigen Stelle eingreifen. Eine häufige Falle ist das sogenannte „Vibe Coding“ – launiges, unstrukturiertes Arbeiten mit KI, bei dem man einfach „irgendetwas“ eintippt und hofft, dass die KI perfekte Ergebnisse ausspuckt. Das mag für Prototypen gelegentlich genügen, aber für produktiven Code ist es ein gefährlicher Irrweg. Der beste Weg führt über das Erstellen wiederverwendbarer und modularer Pläne, die in Markdown oder anderen leicht zugänglichen Formaten abgelegt werden. Diese Pläne sind mehr als reine Dokumentation: Sie sind ausführbare Programme, die der KI als Grundlage dienen und deren Entwicklung nachvollziehbar machen.

Die Planung sollte dabei immer in überschaubaren, kleinen Schritten erfolgen. Große Baustellen anzugehen, ohne Zwischenschritte abzusichern, führt dazu, dass KI-Agenten oft Inhalte erfinden, die zwar plausibel klingen, in der Praxis jedoch fehlerhaft sind. Gerade bei komplexen Softwareprojekten ist es essenziell, die Arbeiten in klar umrissene Module aufzuteilen und diese nacheinander und mit jeweils überprüfbaren Ergebnissen abzuarbeiten. Um eine KI so effizient wie möglich zu nutzen, ist es ebenso wichtig, den sogenannten „Weg“ festzulegen. Das bedeutet, dass Sie für Ihre Agenten nicht nur ein Ziel definieren, sondern auch den „Pfad“ skizzieren, wie dieses Ziel zu erreichen ist.

Selbst simple Aufgaben werden für eine KI zum Problem, wenn sie zu vage beschrieben sind oder wichtige Details fehlen. In vielen Fällen führt es dazu, dass die KI unzuverlässige oder unerwünschte Ergebnisse produziert. Gute Ergebnisse erzielen Sie, wenn Sie die KI schrittweise an die Umsetzung heranführen. Ist die eigene Implementierung einer Funktion noch unklar, kann die KI in einem Erklär-Modus (zum Beispiel mit Pseudocode oder Beispielen) das Verständnis unterstützen, bevor produktiver Code generiert wird. Dabei ist die Kommunikation entscheidend: Je mehr Sie an Ihren Dialogen mit der KI auf technische Präzision achten und Bezug auf Ihren vorhandenen Code nehmen, desto besser die Resultate.

Unverzichtbar ist die Bereitschaft, den Plan immer wieder zu überarbeiten. Jede Planung wird zunächst Fehler enthalten. Die KI hat noch nicht die menschliche Fähigkeit, vollständig fehlerfreie Architekturen zu entwerfen. Doch das ist kein Grund zur Frustration, sondern Teil des Prozesses. Revisionen und Anpassungen sind normal und führen schließlich zu einem ausgereiften Plan, den die KI im nächsten Schritt dann mit hoher Genauigkeit umsetzen kann.

Neben der inhaltlichen Planung und Revision ist das Testing eine entscheidende Phase. Viele Entwickler machen den Fehler, der KI blind zu vertrauen und dabei automatisierten Tests oder manuelle Überprüfungen zu vernachlässigen. Doch KI-Agenten modellieren nur Wahrscheinlichkeiten, keine Garantien. Sie haben keine echte Einsicht, was der Code macht oder ob er im konkreten Anwendungskontext korrekt läuft. Daher empfiehlt es sich, Builds und Tests immer selbst durchzuführen oder kontrolliert zu überwachen.

Manueller Test und Inspektion des Outputs, beispielsweise in Browsern bei Webapplikationen, decken Fehler auf, die die KI so nie hätte identifizieren können. Nur so lässt sich sichergehen, dass die Software „wirklich“ funktioniert und die Anforderungen erfüllt werden. Ein weiterer wichtiger Punkt: Nutzen Sie die KI nicht, um direkt in produktiven Systemen umfassende Änderungen automatisch vorzunehmen. Arbeiten Sie in segmentierten Threads, in denen jeweils nur ein kleiner Schritt angelegt, umgesetzt und getestet wird. So behalten Sie die Kontrolle über den Entwicklungsprozess und minimieren das Risiko, dass fehlerhafte oder unerwartete Änderungen Ihr Projekt destabilisieren.

Die Zusammenarbeit mit KI-Agenten deckt oft tieferliegende Probleme in der eigenen Codebasis auf. Häufig gilt: Je schlechter der eigene Code strukturiert ist, desto stärker merkt man es beim Einsatz der Agenten. Dinge, die bisher vielleicht durch Erfahrung oder Glück kompensiert wurden, treten nun offen zutage. Das ist unangenehm, bietet aber gleichzeitig eine große Chance. Die Fehlererkennung durch KI zwingt dazu, die eigene Architektur kritisch zu hinterfragen und gegebenenfalls größere Refaktorierungen oder Designänderungen vorzunehmen.

Hier lohnt es sich, die KI zu nutzen, um in einem separaten Planungsthread genau diese Änderungen vorzubereiten und sicher umzusetzen. So vermeidet man, dass der Agent um schlechte Konstrukte herumwurschtelt, was zu ineffizienten oder fehlerhaften Lösungen führt. Regeln spielen bei der Arbeit mit KI-Agenten eine wichtige Rolle. Sie definieren, wie die KI mit bestimmtem Code umgehen soll und welche Prinzipien einzuhalten sind. Im Idealfall werden diese Regeln in speziellen Dateien abgelegt, ähnlich wie Pläne.

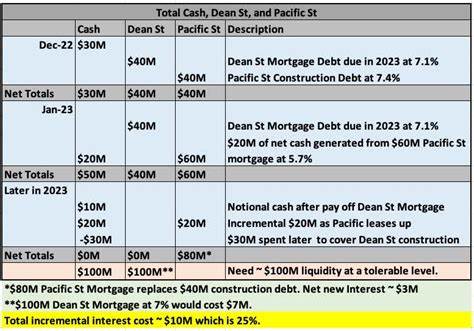

Sie können automatisiert vor jeder Anfrage an die KI hinzugefügt werden und sorgen so für kontinuierliche Einhaltung von Standards. Man unterscheidet dabei verschiedene Arten von Regeln: solche, die immer angewendet werden, oder nur bei bestimmten Dateitypen oder bei bestimmten Anfragen. Diese Differenzierung hilft, die Kontextmenge überschaubar zu halten und verhindert, dass die KI mit zu vielen Informationen überfrachtet wird, was sonst negative Auswirkungen auf das Ergebnis haben kann. Kosten und Ressourceneinsatz sind trotz aller Automatisierung nicht zu vernachlässigen. Der Betrieb von KI-Modellen kann schnell teuer werden, wenn keine Budgetgrenzen gesetzt sind und Modelle unkontrolliert genutzt werden.

Deshalb ist es wichtig, monatliche Limits festzulegen, gezielt nur die tatsächlich notwendigen Modelle zu aktivieren und unbedingt die für die jeweilige Aufgabe optimalen Modelle auszuwählen. Die Modelle unterscheiden sich vor allem in Kosten, Geschwindigkeit und Leistungsvermögen. Einfachere „Action-Modelle“ sind günstiger und perfekt geeignet, wenn ein klar definierter Plan umgesetzt werden soll. Komplexere „Denker-Modelle“ oder „Planungsmodelle“ brauchen mehr Rechenleistung, bieten aber mehr Verstand für die Erstellung und Revision von Plänen. Ein intelligentes Management dieser Ressourcen sorgt für effiziente Resultate ohne finanzielle Überraschungen.

Technisch betrachtet kommunizieren KI-Agenten über definierte Protokolle miteinander, manchmal über Schnittstellen wie das sogenannte Model Context Protocol (MCP). Dies ist ein Schema für den Austausch von Anfragen und Antworten zwischen Modellen und Tools, meist in Form von JSON und Markdown. MCP stellt kein Allheilmittel dar, sondern standardisiert lediglich den Austausch ähnlicher Daten, der auch schon vorher manuell oder halbautomatisch stattfand. Auch wenn MCP vielversprechend klingt, sollte man nicht überheblich erwarten, dass es allein die großen Probleme bei Steuerung und Kontrolle von KI-Agenten löst. Vielmehr bleibt es Aufgabe des Entwicklers, die richtigen Vorgaben zu definieren, den Kontext sinnvoll zu füttern und die Ergebnisse kritisch zu hinterfragen.