Die rasante Entwicklung im Bereich der Künstlichen Intelligenz, insbesondere bei großen Sprachmodellen (Large Language Models, LLMs), hat in den letzten Jahren zu revolutionären Fortschritten im maschinellen Verstehen und Kommunizieren geführt. Diese Modelle können mittlerweile nicht nur Texte verfassen und Fragen beantworten, sondern auch kreative Inhalte erzeugen – und all das verdanken sie der Komplexität ihrer internen Netzwerkparameter. Doch was genau verbirgt sich hinter diesen Netzwerkparametern, wie werden sie erzeugt und wie tragen sie zur Leistungsfähigkeit der Modelle bei? Eine animierte Darstellung bietet faszinierende Einblicke in diese Prozesse und hilft, diese komplexe Materie anschaulich zu erfassen.Große Sprachmodelle basieren auf neuronalen Netzen, die aus riesigen Mengen an künstlichen Neuronen bestehen, die in Schichten organisiert sind. Im Wesentlichen sind diese Netzwerke dafür verantwortlich, Muster in den Eingabedaten zu erkennen und darauf basierende Ausgaben zu generieren.

Für die Verarbeitung natürlicher Sprache bedeutet dies, dass das Modell Kontextinformationen, Wortbedeutungen und grammatikalische Strukturen so verarbeiten kann, dass es sinnvoll und kohärent auf Anfragen reagiert. Die Netzwerkparameter – auch als Gewichte bezeichnet – sind dabei die entscheidenden „Einstellschrauben“, die bestimmen, wie Eingaben verarbeitet und durch das Netzwerk geleitet werden.Die Anzahl der Parameter in modernen LLMs wie GPT-3 oder GPT-4 kann mehrere Milliarden bis hin zu hunderten Milliarden betragen. Jeder dieser Parameter ist eine Zahl, die während des Trainingsprozesses angepasst wird, um Fehler zu minimieren und die Fähigkeit des Modells zu verbessern, genaue Vorhersagen zu treffen. Doch wie genau funktioniert dieses Training? Im Kern basiert es auf der Idee des überwachten Lernens anhand großer Textdatenmengen.

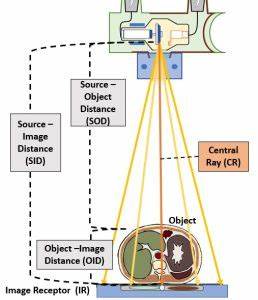

Das Modell wird mit einer Vielzahl von Textbeispielen gefüttert und bekommt die Aufgabe, das nächste Wort oder die nächsten Wörter in einem Satz vorherzusagen. Jedes Mal, wenn das Modell falsch liegt, berechnet es den Fehler und passt seine Parameter ein kleines Stückchen an, um das Ergebnis zu verbessern.Eine animierte Darstellung veranschaulicht dabei, wie ein Eingabesatz zunächst in Zahlenwerte – sogenannte Vektoren – umgewandelt wird. Diese Vektoren durchlaufen dann Schicht für Schicht des neuronalen Netzes. Die Animation zeigt eindrucksvoll, wie die Parameter in Form von Gewichtsmatrizen auf diese Eingabe angewendet werden, um komplexe Transformationen vorzunehmen.

Gleichzeitig werden Aktivierungen der Neuronen visualisiert, wodurch deutlich wird, wie das Modell Schritt für Schritt Kontextinformationen extrahiert und Repräsentationen bildet.Nicht nur die Anpassung der Parameter, sondern auch deren initiale Verteilung spielt eine wichtige Rolle für den Trainingsverlauf und die spätere Leistung des Netzwerks. Die Animation verdeutlicht, wie zu Beginn die Parameter häufig zufällig initialisiert werden, was zu völlig unspezifischen Ausgaben führt. Durch Millionen von Iterationen verändert sich die „Landschaft“ der Parameter, bis das Modell beginnt, strukturierte Muster zu erkennen und sinnvolle Vorhersagen zu treffen. Dies vermittelt ein tiefes Verständnis dafür, wie aus anfänglicher „Unordnung“ gezielte Kompetenz entsteht.

Neben der reinen Darstellung von Parametern und Aktivierungen werden oft weitere Elemente aufgezeigt, beispielsweise der Backpropagation-Algorithmus, der das Rückwärtslaufen der Fehler durch das Netzwerk symbolisiert. Diese Technik ist essentiell, um zu bestimmen, wie jeder einzelne Parameter verändert werden sollte, indem der Gradientenabstieg die Fehlersumme minimiert. Durch die Animation wird sichtbar, wie der Fehler in jeder Modellschicht berechnet und dazu genutzt wird, die Gewichte schrittweise zu justieren.Darüber hinaus kann eine solchermaßen visualisierte Erklärung auch die Bedeutung von speziellen Architekturkomponenten verdeutlichen. Transformer-Modelle, die heute als Standard in LLMs gelten, enthalten beispielsweise Mechanismen wie Selbstaufmerksamkeit (Self-Attention), die es ermöglichen, die Beziehungen zwischen einzelnen Wörtern in einem Satz dynamisch zu gewichten.

In einer Animation lässt sich leicht visualisieren, wie Verschiedenarten von Eingaben unterschiedliche „Aufmerksamkeitsgewichte“ erhalten, was letztlich den Kontext bewahrt und die semantische Kohärenz sicherstellt.Für Personen, die bisher wenig Berührungspunkte mit maschinellem Lernen hatten, hilft eine animierte Erklärung dabei, abstrakte Konzepte greifbar zu machen. Die komplexe Mathematik hinter Netzwerken, Vektoren und Matrizen wird durch anschauliches Bildmaterial für das Verständnis übersetzt. So können nicht nur IT-Profis, sondern auch interessierte Laien nachvollziehen, wie aus Daten und Algorithmen ein leistungsfähiges Sprachmodell entsteht.Zudem bietet die Animation einen Blick in die Zukunft der KI-Entwicklung.

Mit wachsender Parameterzahl und neuen Trainingsmethoden sollen LLMs noch präzisere, vielseitigere und kreativere Ergebnisse liefern. Die visuelle Darstellung der Netzwerkparameter und ihrer Anpassung kann veranschaulichen, wie kleine Veränderungen auf parametrischer Ebene zu großen Auswirkungen in der Modellleistung führen. Dies fördert ein Bewusstsein für die Herausforderungen bei der Optimierung und beim Einsatz von KI-Systemen.Abschließend wird klar, dass die Netzwerkparameter nicht nur Zahlwerke hinter der Technologie sind, sondern die eigentliche „DNA“ der LLMs darstellen. Sie formen das Gehirn der Modelle und bestimmen, wie diese Informationen speichern, verarbeiten und kommunizieren.

Eine Animation, die den Entstehungsprozess dieser Parameter lebendig zeigt, ermöglicht ein vertieftes Verständnis der KI-Mechanismen und unterstützt die öffentliche Diskussion über Chancen und Risiken dieser zukunftsweisenden Technologie.Wer sich also intensiver mit der Funktionsweise moderner Sprachmodelle auseinandersetzen möchte, findet in der Animation eine wertvolle Ressource. Sie bietet nicht nur eine Einführung in technische Details, sondern inspiriert auch dazu, die faszinierenden Möglichkeiten der Künstlichen Intelligenz besser zu begreifen und kritisch zu reflektieren. So öffnet sich ein Fenster in die Welt der künstlichen neuronalen Netzwerke und deren beeindruckendem Potenzial, unsere Gesellschaft nachhaltig zu beeinflussen.

![Animation of how LLMs make their network parameters [video]](/images/04799E7D-0916-4F80-9476-E6EE427BC372)