Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren maßgeblich zur Transformation zahlreicher Anwendungen in der künstlichen Intelligenz beigetragen. Diese Modelle, von Chatbots über maschinelle Übersetzungen bis hin zu komplexer Textgenerierung, benötigen jedoch immense Rechenressourcen und Speicherplatz. Dies stellt insbesondere für Forschungsgruppen mit begrenzten Mitteln sowie für Anwendungen auf Edge-Geräten wie Smartphones oder IoT-Systemen eine erhebliche Hürde dar. Hier setzt BackSlash an – ein innovatives Trainingsverfahren, das eine erhebliche Effizienzsteigerung beim Aufbau dieser Modelle ermöglicht. Durch eine neuartige Kombination von Rate-Distortion-Optimierung und Trainingskompression senkt BackSlash den Ressourcenverbrauch drastisch, ohne die Modellqualität zu beeinträchtigen.

Traditionelle Methoden zur Kompression von Sprachmodellen konzentrieren sich hauptsächlich auf nachträgliche Verfahren, die erst nach dem vollständigen Training der Modelle angewandt werden. Dies bedeutet, dass der anfängliche Trainingsprozess noch immer extrem rechenintensiv bleibt. BackSlash geht einen anderen Weg: Es integriert die Kompression direkt in den Trainingsverlauf, um Parameterredundanzen schon während der Modellentwicklung zu minimieren. Dieses Vorgehen wird als Rate-Constrained Training bezeichnet und basiert auf dem Prinzip der Rate-Distortion-Optimierung aus der Informationstheorie. Ziel ist es, eine Balance zwischen Modellgenauigkeit und Komplexität zu finden, indem unnötige Parameter vermieden werden, während die Leistungsfähigkeit erhalten bleibt.

Die Anwendung von BackSlash zeigt beeindruckende Resultate. Experimente mit unterschiedlichen LLM-Architekturen und Aufgabenbereichen belegen, dass der Speicherbedarf um 60 bis 90 Prozent reduziert werden kann, ohne dass es zu Einbußen bei der Genauigkeit kommt. Solche Einsparungen sind revolutionär, denn sie erlauben schnelles, ressourcenschonendes Training und zugleich eine einfache Überführung in kompakte, leistungsstarke Modelle, die auf diversen Hardwareplattformen eingesetzt werden können. Besonders bemerkenswert ist die Vielseitigkeit von BackSlash: Mit kleinen Lagrange-Multiplikatoren wird die Generalisierung der Modelle verbessert, das heißt, die Modelle können auch mit neuen, bisher unbekannten Daten besser umgehen. Außerdem zeigt die Methode eine hohe Robustheit gegenüber Extremfällen wie einem sehr starken Parameterstreich (Pruning), bei dem bis zu 80 Prozent der Parameter entfernt werden, ohne dass die Performance signifikant leidet.

Mit Blick auf praktische Anwendungen eröffnen sich durch BackSlash neue Möglichkeiten. Insbesondere im Bereich der Edge-KI, also der Nutzung von Künstlicher Intelligenz auf kleinen Geräten mit begrenzten Rechenkapazitäten, sind kompakte und zugleich effektive Modelle gefragt. Das optimierte Training durch BackSlash ermöglicht es, die LLMs so zu vereinfachen, dass sie beschleunigte Inferenzzeiten erzielen und gleichzeitig weniger Speicherplatz und Energie verbrauchen. Dies ist entscheidend für die Integration von Sprachmodellen in mobile Geräte, smarte Sensoren, Fahrzeuge oder andere eingebettete Systeme, die oft nur über sehr begrenzte Ressourcen verfügen.Der technische Kern von BackSlash lässt sich durch die Fokussierung auf Rate-Distortion-Optimierung erklären.

Während man üblicherweise versucht, die beste Genauigkeit zu erzielen, ohne die mathematische Komplexität zu berücksichtigen, schlägt dieses Verfahren die Einführung einer zusätzlichen Rate-Beschränkung vor. Diese bewertet, wie viele Bits zur Speicherung oder Repräsentation der Modellparameter benötigt werden, und sucht nach einem optimalen Kompromiss zwischen Reduktion dieser „Rate“ und der resultierenden „Verzerrung“, die durch die Kompression entsteht. Das Training wird so angepasst, dass es nicht nur die Fehlerrate minimiert, sondern auch die Informationsmenge innerhalb des Modells. Dies führt zu kompakteren Modellen, die sich leichter speichern, übertragen und ausführen lassen.Weiterhin bietet BackSlash interessante Perspektiven für die Skalierung zukünftiger Sprachmodelle.

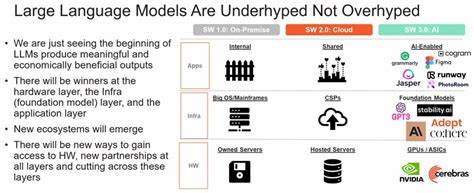

Schon jetzt sind die größten LLMs so komplex, dass sie nur von wenigen, gut ausgestatteten Unternehmen und Forschungszentren trainiert werden können. Die Integration von BackSlash könnte diesen Engpass entschärfen, indem der Trainingsprozess von Anfang an optimiert und ressourceneffizient gestaltet wird. Damit könnten mehr Entwickler und Forschungsteams Zugang zu Hochleistungsmodellen erhalten, was die Innovationsgeschwindigkeit im Bereich KI erheblich steigern würde.Neben der verbesserten Effizienz während des Trainings stellt BackSlash auch im Hinblick auf die Modellwartung und -aktualisierung Vorteile in Aussicht. Kompakte Modelle sind leichter zu aktualisieren, sei es durch Nachtrainieren oder durch die Integration neuer Daten.

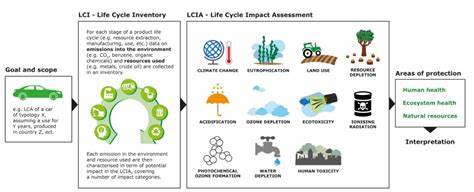

Zudem wird die Robustheit gegenüber Pruning direkt unterstützt, was eine flexible Anpassung an veränderte Anforderungen und Ressourcen erlaubt. So können Modelle dynamisch skaliert oder verschlankt werden, ohne dass eine erneute, komplette Trainingsphase notwendig ist.Schließlich darf nicht außer Acht gelassen werden, dass BackSlash auch eine nachhaltige Entwicklung von KI-Systemen fördert. Durch die signifikante Reduktion des Energie- und Speicherbedarfs während des Trainings leisten diese Verfahren einen Beitrag zu einem umweltfreundlicheren Umgang mit Rechenressourcen. Angesichts der steigenden Bedeutung von Klimaschutz und Energieeffizienz in der Technologiebranche ist dies ein nicht zu unterschätzender Vorteil, der langfristige Auswirkungen auf die Akzeptanz und Verbreitung von KI-Technologien haben kann.