Die rasante Entwicklung moderner Technologien hat die Bedeutung von Grafikprozessoren (GPUs) in der Computerwelt exponentiell wachsen lassen. Ursprünglich für Grafik- und Bildverarbeitung konzipiert, sind GPUs heute Herzstück zahlreicher wissenschaftlicher Simulationen, KI-Modelle und Hochleistungsrechner. Um das enorme Potenzial dieser riesigen Rechenressourcen effektiv zu nutzen, bedarf es spezieller Programmierkenntnisse, die weit über klassische CPU-Programmierung hinausgehen. Das Konzept der Mojo GPU Puzzles bietet einen einzigartigen Zugang zu diesem komplexen Feld und vermittelt verständlich und praxisnah die Kunst der GPU-Programmierung. Mojo, ein modernes Systemprogrammiersprachen-Framework, verbindet dabei die intuitive Eleganz von Python mit der Performanceklasse von Systemsprache, was es Programmierern ermöglicht, GPU-Potenziale besser zu erschließen als jemals zuvor.

Im Kern steht bei der GPU-Programmierung das Prinzip der Parallelisierung. Während traditionelle CPUs meist auf sequenzielle Abläufe ausgelegt sind und Daten Schritt für Schritt verarbeiten, zeichnet sich eine GPU durch Tausende von parallelen Kernen aus, die simultan auf riesige Datenmengen einwirken können. Die grundlegende Denkweise muss daher vom seriellen zum parallelen Paradigma wechseln. Anstelle einer for-Schleife, die Daten eines nach dem anderen abarbeitet, setzt man auf eine Vielzahl von Threads, die alle gleichzeitig rechnen. Ein einzelner Thread ist dabei jeweils für eine Datenposition zuständig, wodurch die gesamte Verarbeitung simultan abläuft und drastische Geschwindigkeitsvorteile realisiert werden.

Die Mojo GPU Puzzles verfolgen einen didaktisch innovativen Ansatz, der Lernen durch tatsächliche Anwendung fördert. Anstatt nur theoretisches Wissen zu vermitteln, fordert die Puzzle-Reihe Programmierer dazu auf, eigene GPU-Kernel zu schreiben, Herausforderungen eigenständig zu meistern und so unmittelbar die Auswirkungen ihres Codes auf die Ausführung zu erleben. Von grundlegenden Konzepten wie Thread-Indexierung und Speicherzugriffsmustern bis hin zu komplexen Algorithmen für Matrixmultiplikation, Convolution oder sogar Warp-Level Programmierung decken die Puzzles ein breites Spektrum ab. Dabei bieten sie sowohl einen tiefgehenden Einblick in Low-Level-Programmierung mittels roher Speicherzugriffe als auch moderne Abstraktionen über das Mojo-spezifische LayoutTensor-Framework. Das Toolkit von Mojo erleichtert dabei den Umstieg und hebt sich durch seine Python-ähnliche Syntax hervor, die vielen Entwicklern aus anderen Bereichen vertraut ist.

Gleichzeitig ermöglicht der starke Typisierungsmix, mögliche Fehlerquellen frühzeitig zu erkennen, was bei der GPU-Programmierung ein entscheidender Faktor für korrekte und effiziente Ergebnisse ist. Dank strategisch implementierter Zero-Cost-Abstraktionen wird sichergestellt, dass der abstrahierende Komfort nicht zu Lasten der Performance geht, was bei vielen High-Level-Frameworks häufig ein Engpass ist. In den ersten Puzzle-Abschnitten wird die essenzielle Struktur einer GPU-Anwendung vermittelt. Man lernt die Organisation des Workloads durch Threads, Blocks und Grids kennen – Konzepte, die entscheidend sind, um die enorme Parallelität richtig zu orchestrieren. Ein tieferes Verständnis der Speicherhierarchie auf der GPU ist ebenso Teil des Curriculums: Globale, geteilte (Shared) und Register-Speicher sind unterschiedliche Ebenen mit variierenden Zugriffsgeschwindigkeiten, deren richtiges Management oft über Erfolg oder Misserfolg eines Programms entscheidet.

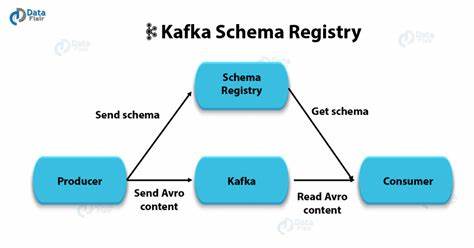

Durch die Arbeit mit direkten Speicheroperationen und gleichzeitig mit LayoutTensor abstrahierten Views erhalten User die Flexibilität, sowohl hardwarenahe Details zu beherrschen als auch moderne, bequemere Programmiermuster zu verwenden. Ein wichtiger Aspekt, der bei GPU-Programmierung oft unterschätzt wird, ist die Datenbewegung. Während klassische Optimierungen oft CPU-Grenzen und Rechenoperationen fokussieren, zeigt sich auf GPUs besonders stark, dass Speicherzugriffe kostenintensiver sind als die eigentliche Berechnung. Effiziente Programme minimieren also nicht nur die Menge der Datenübertragungen zwischen CPU und GPU, sondern optimieren auch die internen Zugriffe auf globale und geteilte Speicherbereiche. In den Mojo GPU Puzzles werden diese Prinzipien systematisch vermittelt, indem beispielsweise Block-Kooperationen durch geteilten Speicher realisiert werden, um Daten mehrfach innerhalb der Threads verfügbar zu machen, ohne wiederholt auf langsame Speicherbereiche zugreifen zu müssen.

Mit zunehmendem Fortschritt führen die Puzzles in komplexere parallele Algorithmen ein. Pooling-Methoden, Prefix-Summen (Scan-Operationen), und Matrixmultiplikationen mit Tiling-Techniken stellen nicht nur eine Herausforderung dar, sondern bilden auch den Kern vieler Anwendungen im Bereich KI und numerische Simulationen. Die Programmierung mit Mojo macht es hier besonders attraktiv, denn durch speziell optimierte Operatoren und ein durchdachtes Speichermanagement lassen sich extrem effiziente Kerne schreiben, die sowohl vorhersagbar als auch wartbar bleiben. Darüber hinaus zeigt die Integration von Mojo mit populären Frameworks wie PyTorch, wie weitreichend und praxisrelevant die GPU-Programmierung heute ist. Nutzer können eigene Hochleistungs-Operationen als Custom Ops implementieren, die nahtlos mit bestehenden Deep-Learning-Modellen zusammenarbeiten.

Dieser Brückenschlag erweitert den Anwendungsbereich enorm und erleichtert beispielsweise das Einbetten eigener Algorithmen oder optimierter Kerne in Trainings- und Inferenzpipelines moderner KI-Anwendungen. Die Aspekte der Funktionsmuster, Warp-Level Programmierung und die Optimierung der Speicherzugriffe mit coalescing, Asynchronous Memory Operations oder Atomics werden in den fortgeschrittenen Teilen der Mojo GPU Puzzles vorbildlich behandelt. Dies befähigt Entwickler, tief in das Architekturverständnis einzutauchen und ihre Programme auf ein ganz neues Performance-Level zu heben, indem sie gezielt hardware-spezifische Features nutzen. Hier werden auch die Grenzen klassischer Paradigmen überwunden, etwa durch das Verwenden von warp.shuffle_xor() zur schnellen inner-warp Kommunikation oder durch Warpprogrammierung als effiziente Alternative zu thread-block-basierten Mustern.

Nicht zuletzt werden auch Aspekte der Performance-Analyse und abschließenden Optimierung mit Tools wie Profiler und Mechanismen der Occupancy-Optimierung vorgestellt. Das Wissen um Blockgrößen, Registerverbrauch, geteilten Speicher und Bankkonflikte ist von grundlegender Bedeutung, um GPU-Anwendung nicht nur korrekt, sondern auch nachhaltig performant zu gestalten. Zusammengefasst bieten die Mojo GPU Puzzles eine visionäre und praxisnahe Lernumgebung für Programmierer, die GPU-Programmierung ernsthaft beherrschen wollen. Das modular aufgebaute Curriculum führt Schritt für Schritt von Einstiegskonzepten bis hin zu komplexen GPU-Algorithmen und zeitgemäßen Integrationstechniken. Dank Mojo wird GPU-Coding zugänglicher, programmierfreundlicher und performanter zugleich – ein bedeutender Schritt für die Demokratisierung von Hochleistungsrechnen.