In der heutigen digitalen Welt nehmen datengetriebene Anwendungen und Echtzeit-Datenverarbeitung immer weiter an Bedeutung zu. Kafka hat sich dabei als eines der führenden Systeme für das Streamen von Daten etabliert und ist für viele Unternehmen unverzichtbar geworden. Die Herausforderung liegt jedoch oft darin, Kafka kosteneffizient zu betreiben und gleichzeitig die Qualität und Integrität der Daten sicherzustellen. Während günstige Kafka-Alternativen zunehmend den Markt erobern, zeichnet sich eine neue Ära ab: Schema-gesteuerte Entwicklung mit Kafka, die weit über reine Kostenersparnis hinausgeht und die Datenverarbeitung grundlegend neu definiert. Der Aufstieg günstiger Kafka-Ersatzlösungen basiert auf der Idee, teure Infrastrukturkomponenten durch innovative Technologien zu ersetzen, ohne dabei an Funktionalität einzubüßen.

Ein zentrales Element ist die Nutzung von objektbasierter Speichertechnologie wie S3-kompatiblem Speicher, um Daten kostengünstig zu speichern und zu replizieren. Dies führt zu erheblichen Einsparungen, insbesondere bei Netzwerk- und Speicherressourcen, die in herkömmlichen Kafka-Umgebungen oft hohe Kosten verursachen. Systeme wie Bufstream setzen genau hier an und bieten eine moderne, leicht skalierbare Kafka-Ersatzlösung, die sich selbstständig an wechselnde Lasten anpasst und durch den Verzicht auf klassische Broker-Architekturen einfacher zu betreiben ist. Die Erwartungen an diese neuen Kafka-Alternativen sind dabei hoch. Neben der Kosteneffizienz müssen sie auch Aspekte wie Sicherheit, Zuverlässigkeit und vor allem die Korrektheit der verarbeiteten Daten gewährleisten.

Bufstream zeigt mit unabhängigen Tests, unter anderem durch Jepsen, dass es möglich ist, ein hochverfügbares und transaktional sicheres Streaming-System auf Basis von Objekt-Storage aufzubauen, das traditionelle Kafka-Deployments ergänzt oder sogar ersetzt. Durch die vollständige Selbst-Hosting-Möglichkeit innerhalb eines eigenen Virtual Private Cloud (VPC) können Unternehmen ihre sensiblen Metadaten besser schützen und erfüllen dadurch moderne Compliance-Anforderungen. Doch die Kosten und technische Umsetzung sind nur die eine Seite der Medaille. In einer Welt, in der Daten voluminöser, komplexer und vernetzter werden, spielt die Qualität der Daten eine wesentliche Rolle. Hier setzt das Prinzip der schema-gesteuerten Entwicklung an.

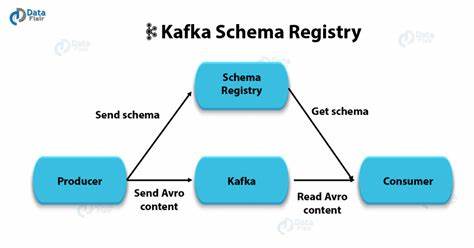

Während Kafka von Haus aus lediglich eine Transportplattform darstellt, verfügen viele Datenquellen schon über Schemata, die die Struktur und Bedeutung der Daten definieren sollten – sie werden aber in klassischen Kafka-Ökosystemen oft ungenügend integriert. Schema-gesteuerte Entwicklung bedeutet, dass Daten nicht mehr frei und semi-strukturiert über das System verteilt werden, sondern dass ein genau definiertes Schema vor dem Senden und Empfangen der Daten durchgesetzt wird. Dies bringt enorme Vorteile, gerade wenn es darum geht, fehlerhafte oder inkonsistente Daten frühzeitig zu erkennen und auszuschließen. Anstatt auf kundenseitige Prüfungen zu vertrauen, die oft optional und unvollständig sind, findet bei schema-gesteuerter Kafka-Entwicklung eine Validierung direkt am Broker statt. Dadurch wird sichergestellt, dass nur valide Daten in Topics landen, was Fehlersuche und Data Governance deutlich vereinfacht.

Ein modernes Schema-System schließt nicht nur die reine Struktur der Daten ein, sondern erlaubt auch die Definition komplexer Validierungsregeln und semantischer Eigenschaften. Zum Beispiel können Bedingungen wie Pflichtfelder, Wertebereiche oder Abhängigkeiten zwischen einzelnen Feldern direkt im Schema hinterlegt werden. Dies unterstützt Entwickler darin, schon bei der Datenproduktion die gewünschten Geschäftsregeln zu erzwingen, wodurch die Belastung downstream deutlich reduziert wird. In der Praxis gestaltet sich eine durchgängige schema-gesteuerte Entwicklung herausfordernd, wenn unterschiedliche Schema-Sprachen und Standards parallel verwendet werden. Häufig kommen in Netzwerkschnittstellen Protobuf oder OpenAPI zum Einsatz, während für Streaming-Daten meist Avro verwendet wird und Datenbanken oder Data Lakes oft eigene SQL-Derivate nutzen.

Dieses Nebeneinander erschwert eine ganzheitliche Datenqualitätssicherung und führt zu erhöhtem Entwicklungsaufwand. Buf verfolgt einen anderen Ansatz und setzt konsequent auf Protobuf als einheitliche Schema-Sprache für das gesamte Daten-Ökosystem. Protobuf bietet eine hohe Performance, breite Sprachunterstützung und ermöglicht sowohl strukturierte Datendefinition als auch umfangreiche Erweiterungen durch Annotationen. So lassen sich alle wichtigen Anwendungsfälle von RPCs über Streaming bis hin zu Data-Lake-Schemata abbilden. Durch diesen einheitlichen Standard lassen sich Daten konsistent validieren, transformieren und beliebig über verschiedene Systeme synchronisieren.

Die eigentliche Grundlage für ein funktionierendes Schema-Ökosystem ist jedoch nicht nur die Wahl einer Sprache, sondern die Verteilung, Verwaltung und Governance der Schemata. Hier bietet die Buf Schema Registry eine zentrale Lösung, die weit über einfache Registrierungs-Dienste hinausgeht. Im Gegensatz zu herkömmlichen Schema-Registern wie Confluent oder Glue, die Schemata oft erst beim Laufzeit-Client akzeptieren, betreibt Buf eine strenge, build-time-orientierte Verteilung von Schemata. Dabei findet eine automatische Prüfung auf Breaking Changes und semantische Konsistenz statt, wodurch unerwartete Inkompatibilitäten vermieden werden. Dieser Ansatz führt zu einer saubereren Entwicklungspipeline, da Schemata wie Quellcode behandelt werden und duspezifische Prüfungen und Genehmigungen durchlaufen, bevor sie produktiv eingesetzt werden.

Das Vertrauen der Verbraucher in die Stabilität der genutzten Daten steigt damit erheblich, was wiederum die Entwicklungszyklen beschleunigt und Betriebsaufwände reduziert. Die Integration der Schema-Validierung direkt in Kafka-ähnliche Brokersysteme führt letztlich zu einer erheblichen Verbesserung der Datenqualität in Echtzeit-Streaming-Architekturen. Fehlgeleitete oder fehlerhafte Datenquellen werden vor Verarbeitung gestoppt, was sowohl den Aufwand für nachträgliche Datenbereinigung als auch das Risiko von falschinterpretierten Geschäftssignalen drastisch senkt. Die zentrale Steuerung von Zugriffsrechten und Datenschutzregelungen auf Schemaebene ermöglicht zudem eine automatisierte Maskierung sensibler Daten, die sich konsequent über RPC-Schnittstellen, Kafka-Topics und Data Lakes hinweg durchsetzt. Dieser holistische Ansatz eröffnet zudem neue Möglichkeiten, wie kafka-kompatible Daten Streams ohne redundante Kopien direkt in Data Lakes wie Iceberg geschrieben werden können.

So entstehen effiziente Anwendungsfälle, bei denen die Daten sowohl für Echtzeitanalysen als auch für historische Auswertungen optimal nutzbar sind, ohne dass zusätzliche ETL-Prozesse nötig sind. Die Zukunft des datengetriebenen Arbeitens wird von solchen integrierten Konzepten geprägt sein, die Kosten, Komplexität und Risiken minimieren und gleichzeitig die Qualität und Governance fest im Blick behalten. Günstige Kafka-Ersatzlösungen wie Bufstream bieten dazu die technische Basis, während die schema-gesteuerte Entwicklung das nötige methodische Gerüst liefert, um Streaming-Daten in Unternehmensprozessen wirklich nutzbar zu machen. Wer heute noch auf frei definierte oder inkonsistente Datenströme setzt, verpasst die Chance, Prozesse effizienter, sicherer und verlässlicher zu gestalten. Die Kombination aus modernen Kafka-Alternativen und schema-basierter Datenentwicklung ist der Schlüssel, um in einer Welt wachsender Datenmengen und steigender Anforderungen an Datenqualität wettbewerbsfähig zu bleiben.

Unternehmen, die frühzeitig auf diesen Zug aufspringen und mit durchdachten Werkzeugen wie Buf und Protobuf arbeiten, sichern sich langfristig einen entscheidenden Wettbewerbsvorteil. Zusammenfassend lässt sich festhalten, dass günstiges Kafka zwar bereits viele Hürden in puncto Kosteneffizienz überwindet, doch echte Innovation erst mit der konsequenten Integration von Schema-gesteuerter Entwicklung im Daten-Streaming entsteht. Dieses neue Paradigma revolutioniert nicht nur, wie Daten strukturiert und verarbeitet werden, sondern ermöglicht ein zuverlässiges, skalierbares und wartbares Datenökosystem, von dem alle Beteiligten profitieren – vom Entwickler bis zum Endanwender.