Das Internet ist aus unserem Alltag nicht mehr wegzudenken und wächst kontinuierlich weiter. Jeder Klick, jeder Inhalt und jede Applikation trägt zum wachsenden Datenvolumen bei. Doch inmitten dieses exponentiellen Wachsens stellt sich eine spannende Frage: Ist ein kleineres Internet eigentlich besser? Diese Frage führt uns in eine tiefgreifende Diskussion über Effizienz, Infrastruktur, Informationsübertragung und die Zukunft der digitalen Vernetzung. In den letzten Jahren hat sich gezeigt, dass viele große Internetdienste und Apps darauf setzen, möglichst viel Code und Inhalte lokal auf den Endgeräten der Nutzer bereitzustellen. Facebook beispielsweise liefert nicht ständig komplette Webseiten aus dem Server, sondern stellt die logischen Bausteine wie UI-Kits und Interaktionslogik auf dem Smartphone oder Computer bereit, während die eigentlichen Inhalte wie Bilder und Texte vom Server geladen werden.

Diese Herangehensweise reduziert die Serverlast und sorgt für einen schnelleren und effizienteren Zugriff auf Inhalte. Durch diese Strategie wird der Datentransfer minimiert und die Infrastruktur entlastet. Daraus ergeben sich erste Erkenntnisse, wie ein kleineres Internet prinzipiell funktionieren könnte. Der Gedanke eines „kleineren“ Internets rührt daher, den Bedarf an großen Serverfarmen und umfangreichen Rechenzentren zu verringern. Stattdessen könnte man sich vorstellen, dass digitale Inhalte nicht auf einem zentralen Server liegen, sondern über kleine Anweisungen verteilt zusammengestellt werden.

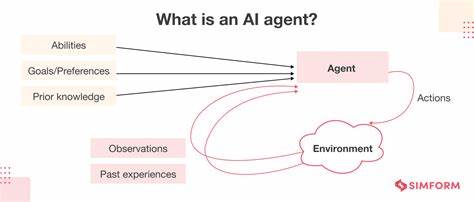

Man spricht in diesem Zusammenhang von einem Konzept, bei dem Webseiten nicht den gesamten Code oder die kompletten Daten hosten, sondern lediglich eine Art Bauplan oder Suchanweisung mitliefern. Der Client, also das Endgerät, holt sich dann die Teile selbstständig aus dem Netz und setzt sie zusammen. Dieses Prinzip wird auch in der sogenannten Serverless-Architektur und im Fediverse verfolgt, wo dezentrale Systeme die zentrale Kontrolle reduzieren. Eine Herausforderung bei dieser Technik ist die Frage der Effizienz und der Kompression von Anweisungen. Ein „kleineres“ Internet benötigt geniale Wege, wie man Anweisungen so effektiv wie möglich kodiert, um etwa mit wenige Bytes komplexe Funktionen auszulösen.

Doch es gibt physikalische und mathematische Grenzen—eine einzige Anweisung kann nicht unendlich viele Variationen abbilden. Hier stößt man schnell an technische Grenzen, wenn man versucht, den Code zu komprimieren, ohne die Funktionalität einzuschränken. Weiterhin wirft das Konzept die Problematik der Suche und Zuverlässigkeit auf. Wenn Webseiten aus vielen kleinen, voneinander unabhängigen Snippets bestehen, muss das Endgerät diesen riesigen Datenbestand in kürzester Zeit durchsuchen. Diese Suche darf nicht zu einer Belastung für das Netzwerk oder für das Gerät werden.

Es braucht smarte Algorithmen, die gezielt und effizient navigieren können, um den richtigen Inhalt schnell zu finden. Ohne solche intelligenten Suchmethoden wäre das System zu langsam oder zu fehleranfällig für Nutzer. Darüber hinaus gibt es eine Überlegung zur Einzigartigkeit von Informationen im weltweiten Netz. Mit Milliarden an Webseiten und Inhalten stellt sich die Frage, wie ein verteiltes System garantieren kann, dass bestimmte Daten eindeutig und nicht redundant verteilt oder mehrfach existierend vorliegen. Die Verwaltung und Katalogisierung von Informationen ist eine Mammutaufgabe, die auf zentralisierten Servern einfacher zu handhaben ist, aber bei einem kleineren und verteilten Internetmodell zu Dauerproblemen werden könnte.

In der Praxis hat sich gezeigt, dass alternative Ansätze wie das Komprimieren ganzer Webseiten in QR-Codes oder kurze Videosequenzen funktionieren können, um Inhalte lokal zugänglich zu machen, ohne eine permanente Online-Verbindung. Solche Methoden sind besonders in ländlichen oder vernetzungsschwachen Regionen interessant, da sie Offline-Zugriff auf Inhalte erlauben. Allerdings zeigen Erfahrungswerte und die Analyse der Infrastruktur, dass ein zu starkes Fokussieren auf Effizienz auch Nachteile mit sich bringen kann. Systeme, die extrem optimiert sind, neigen dazu, weniger robust zu sein und sind schlechter erweiterbar. Die Infrastruktur des Internets unterliegt einem ständigen Wandel, an dem viele unterschiedliche Akteure mit verschiedenen Interessen beteiligt sind.

Neue Protokolle, Standards oder Technologien brechen alte Gewohnheiten auf, führen aber auch zu Kompatibilitätsproblemen und Verzögerungen bei der Implementierung. Diese Komplexität macht eine komplette Umgestaltung hin zu einem kleineren, effizienteren Netz schwierig. Rechtliche, wirtschaftliche und technologische Rahmenbedingungen beeinflussen, wie Netzwerke organisiert sind und wie Informationen verteilt werden. Zwar gibt es theoretische Versuche, komplett neue und optimierte Systeme zu schaffen, doch sie stoßen meist auf praktische Hürden und große Widerstände. In der Tat sehen wir die Herausforderung nicht nur in technischen Fragen, sondern auch in der sozialen Dimension.

Informationen und digitale Kommunikation sind eng mit gesellschaftlichen Prozessen verflochten. Ein kleineres Internet bedeutet auch weniger Daten, weniger Tracking und möglicherweise mehr Datenschutz. Gleichzeitig könnten zentrale Infrastrukturen durch kleinere, dezentrale Netzwerke ersetzt werden, die jedoch schwerer zu kontrollieren und zu regulieren sind. Nicht zuletzt spiegelt sich in der Debatte auch ein nostalgisches Bedürfnis nach Einfachheit und Direktheit wider. Einige Menschen bevorzugen den direkten Austausch, etwa ein persönliches Gespräch, anstatt die komplexen und zunehmend anonymen Konnektivitätsschichten des Internets.

Diese Haltung beeinflusst die Debatte darüber, wie ein „besseres“ Internet aussehen könnte, das nicht nur effizient, sondern auch menschlicher ist. Zusammenfassend lässt sich sagen, dass ein kleineres Internet durchaus attraktive Vorteile bietet: geringerer Datenverbrauch, weniger Serverbelastung und potenziell mehr Privatsphäre. Gleichzeitig ist es technisch anspruchsvoll, effizient zu gestalten, und wirtschaftlich schwer durchzusetzen. Die Zukunft wird wohl in einem hybriden Modell liegen, das sowohl größere strukturierte Netzwerke als auch kleinere, intelligente Clients nutzt. Die Balance zwischen Komplexität und Effizienz wird dabei entscheidend sein, um ein nachhaltiges digitales Ökosystem zu schaffen, das allen Nutzern gerecht wird.

Gleichzeitig können praktische Anwendungen und Innovationen, wie serverlose Architekturen, dezentrale Plattformen und alternative Informationsverbreitung, wichtige Impulse liefern. Sie zeigen Wege auf, wie wir die digitale Vernetzung konzipieren können, um sie ressourcenschonender und benutzerfreundlicher zu gestalten. Dabei bleibt die wichtigste Erkenntnis, dass Informationstransfer niemals völlig kostenlos und unbegrenzt sein wird – weder technisch noch wirtschaftlich. Ein kleineres Internet ist also kein Allheilmittel, sondern eine interessante Alternative innerhalb eines komplexen Systems. Die Frage, ob es besser ist, lässt sich nicht einfach beantworten, sondern variiert je nach Blickwinkel und Anwendungsszenario.

Fest steht aber: Die Diskussion um die Größe und Struktur des Internets ist ein Schlüsselthema für die Digitalisierung der Zukunft und damit für die Art und Weise, wie Menschen weltweit miteinander kommunizieren und Informationen austauschen.