Die Nachfrage nach effizienten, lokal nutzbaren KI-Modellen für Softwareentwicklung wächst stetig. Cloudbasierte Lösungen sind oft mit Kosten verbunden und teilweise abhängig von externen Faktoren wie Internetverbindung und Datenschutzbestimmungen. Wer eine leistungsstarke und dennoch kostenlose Alternative auf dem eigenen Mac suchen möchte, wird mit Qwen3 in Kombination mit der MLX-Plattform eine vielversprechende Lösung finden. Dieses Setup ermöglicht nicht nur die lokale Ausführung eines hochentwickelten Sprachmodells, sondern auch dessen Integration in eine agentengestützte Programmierumgebung, die Code generiert, analysiert und verbessert – komplett frei und unabhängig von Cloud-Services. Dabei lohnt es sich besonders, den Workflow von der Installation bis zur Anwendung genau zu verstehen, um das volle Potenzial auszuschöpfen.

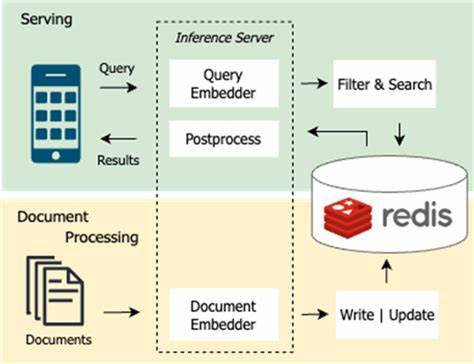

Qwen3 ist ein modernes, großes Sprachmodell, das im Open-Source-Bereich sehr viel Aufmerksamkeit erregt hat. Es wird über Ollama und die MLX-Community zur Verfügung gestellt und zeichnet sich durch seine Leistungsfähigkeit aus – insbesondere dann, wenn es auf einer leistungsstarken Maschine wie einem Mac ausgeführt wird. Während einige Versionen auf Grund ihrer Größe und Rechenintensität eine starke Hardwarebasis erfordern, bieten 8-Bit optimierte Modelle wie Qwen3-30B-A3B-8bit die Möglichkeit, das Modell auch auf MacBooks effizient zu betreiben. Die MLX-Bibliothek unterstützt diese Prozesse, indem sie als Server funktioniert, der das Modell bereitstellt und auf Anfragen reagiert. Der erste Schritt besteht darin, die MLX-Kernbibliothek auf dem Mac zu installieren.

Dies erfolgt bequem über Python-Paketinstallationen mit einfachen Befehlen. Parallel dazu wird die Helper-Bibliothek mlx-lm benötigt, welche praktische Funktionen für den Betrieb des Sprachmodells bereitstellt. Sobald diese Grundvoraussetzungen geschaffen sind, kann die Modellserverinstanz gestartet werden. Dabei lädt der Server automatisch das gewünschte Qwen3-Modell herunter und stellt es lokal für die Anfragen bereit. Besonders wichtig ist es, den Port individuell festzulegen, damit keine Konflikte mit anderen Anwendungen entstehen.

Nach erfolgreichem Start zeigt das System entsprechende Logmeldungen an, die bestätigen, dass das Modell betriebsbereit ist. Parallel zum technischen Backend empfiehlt es sich, ein Frontend für die einfache Nutzung und Verwaltung anzubinden. Hier kommt Localforge ins Spiel – eine open-source Agentenplattform, die auf verschiedenen Betriebssystemen verfügbar ist, darunter macOS. Localforge ermöglicht es, unterschiedliche KI-Provider bequem in einer Oberfläche zusammenzufassen und maßgeschneiderte Agenten zu konfigurieren. In diesem Kontext richtet man einen Provider für Ollama sowie einen weiteren für den lokal laufenden Qwen3-Modellserver ein.

Der Ollama-Provider übernimmt leichtere, kontextbezogene Aufgaben, während der Qwen3-Provider die schwereren, eigentlichen Code-Generierungsfunktionen abdeckt. Die Konfiguration des Qwen3-Providers in Localforge verlangt es, den OpenAI-Providertyp zu wählen, da MLX kompatibel mit der OpenAI API-Struktur ist. Ein echter API-Schlüssel ist hier nicht erforderlich, stattdessen wird das lokale Server-URL samt Port angegeben. Das sogenannte „trust-remote-code“-Flag bei der Serverkonfiguration sorgt dafür, dass der Lokaleinsatz des Modells reibungslos funktioniert, obwohl der Code remote geladen wird. Anschließend kann man in Localforge einen eigenen Agenten anlegen, der die Zusammenarbeit beider Provider regelt und Prioritäten definiert.

Das Resultat ist ein autonomer Agent, der auf dem Mac läuft und direkt mit dem lokalen Qwen3-Modell kommuniziert, unterstützt von den kleineren Modellen von Ollama. Was bedeutet das konkret für Entwickler? Statt Kostengegenleistungen monatlicher Cloud-Abonnements erhält man mit diesem Setup eine leistungsfähige Umgebung, in der Anfragen an das Sprachmodell praktisch verzögerungsfrei bearbeitet werden. Aufgaben wie das Erzeugen von Code-Snippets, die Fehleranalyse oder das Automatisieren wiederkehrender Programmieraufgaben können komplett lokal erledigt werden – und das mit höchster Datensicherheit. Ein Beispiel für die Funktionsweise ist die Aufforderung an den Agenten, eine Dateiliste im aktuellen Arbeitsverzeichnis anzuzeigen. In Sekunden generiert das Agentensystem diese Ausgabe korrekt, gesteuert vom Qwen3-Modell auf dem eigenen Mac.

Darüber hinaus zeigen kreative Anwendungen der Methode die Vielfältigkeit des Modells. Auf Basis von Localforge und Qwen3 wurde zum Beispiel ein vollständiges, selbstspielendes Snake-Game entwickelt. Das verdeutlicht nicht nur die Fähigkeiten zur Interaktion, sondern auch das Potenzial für agiles, autonomes Entwickeln und Experimentieren – frei von externen Abhängigkeiten. Diese Freiheit erlaubt es Programmierern und Tech-Enthusiasten, eigene Konzepte auszuprobieren, Systeme zu verfeinern und KI-basierte Workflows optimal zu gestalten. Natürlich ist das System nicht völlig ohne Herausforderungen.

Die Einrichtung erfordert etwas technisches Grundverständnis und Geduld, insbesondere beim Herunterladen und dem Management eines Modells mit mehreren Dutzend Gigabyte. Auch die Anpassung des Systemprompts und die Steuerung des Agenten müssen mit etwas Feingefühl erfolgen, um die bestmöglichen Ergebnisse zu ermöglichen. Zudem kann es ratsam sein, Tools im Localforge-Agenten zu deaktivieren oder anzupassen, um die Interaktionen auf das Wesentliche zu fokussieren und Ressourcen zu schonen. Für alle, die Wert auf Kosteneffizienz und Unabhängigkeit legen, stellt der lokale Einsatz von Qwen3 via MLX eine überzeugende Alternative zu kommerziellen Cloud-Lösungen dar. Die Kombination aus einem leistungsfähigen, offenen KI-Modell und einer anwenderfreundlichen Agentenplattform wie Localforge öffnet Türen zu mehr Produktivität, Kreativität und Kontrolle über eigene Projektumgebungen.

Wer heute noch auf teure Online-Services setzt, sollte dieses Setup unbedingt ausprobieren. Zusammenfassend bietet der Betrieb von Qwen3 auf einem Mac mit MLX nicht nur einen leistungsstarken lokalen AI-Co-Piloten zur Programmierung, sondern auch eine kostenfreie und datenschutzfreundliche Lösung, die überdies durch Individualisierungsmöglichkeiten besticht. Die laufenden Entwicklungen in der MLX-Community sorgen dabei für regelmäßige Updates und neue Modelle, sodass Nutzer stets am Puls der Zeit bleiben können. Das autonome Code „Vibe“-Erlebnis wird so lebendig und nachhaltig – und das direkt in den eigenen vier digitalen Wänden.