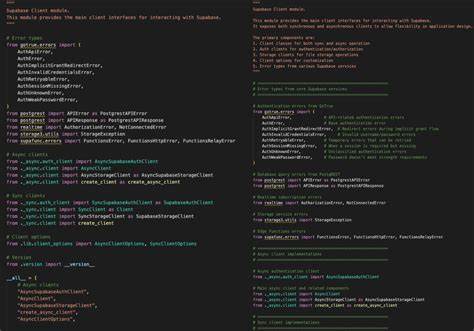

Das Model Context Protocol, kurz MCP, hat in der Welt der künstlichen Intelligenz in den letzten Monaten für erhebliches Aufsehen gesorgt. Es verfolgt das ambitionierte Ziel, Large Language Models (LLMs) als Agenten in die Lage zu versetzen, nicht nur Texte zu generieren, sondern direkt mit der Außenwelt zu interagieren. MCP bildet dabei eine Art standardisierte Schnittstelle, durch die KI-Modelle auf Datenquellen, Werkzeuge und Services zugreifen können. Dieser Standard soll vergleichbar sein mit dem USB-C-Anschluss in der Elektronik, der verschiedene Geräte kompatibel miteinander verbindet. Trotz des enormen Potenzials zeigen sich jedoch erhebliche Mängel und technische Herausforderungen bei der Umsetzung.

Die folgende Analyse betrachtet das Protokoll detailliert, hinterfragt Design-Entscheidungen und bietet einen Ausblick auf mögliche Verbesserungen. Der Hintergrund von MCP ist eng mit den Entwicklungen von Anthropic verbunden, einem Unternehmen, das stark auf die Zukunft von KI-gestütztem Programmieren setzt. Der MCP-Standard spiegelt diesen Fokus auf die Verbindung von LLMs mit Entwicklungstools wider. Er soll vor allem die Kommunikation zwischen Lokalen Integrationen und den Modellen erleichtern, indem er ein einheitliches JSON-RPC-basiertes Protokoll mit definierten Methoden und Endpunkten bereitstellt. Das grundlegende Prinzip ist relativ klar: einheitliche APIs, damit Künstliche Intelligenzen als Agenten direkt mit der Umgebung interagieren, Daten abfragen oder Modifikationen vornehmen können.

Trotz dieser klaren Vision offenbart sich bei genauerem Hinsehen eine Reihe von Schwachstellen, die sich vor allem bei der Transport-Schicht des Protokolls zeigen. Die Entwickler haben zwei wesentliche Transportmethoden vorgesehen: zum einen die Nutzung von Standard Input/Output (stdio) und zum anderen Varianten von HTTP, insbesondere HTTP in Kombination mit Server-Sent Events (SSE) sowie eine sogenannte "Streamable HTTP"-Version, die auf SSE aufbaut und komplexere Mechanismen implementiert. Dabei ist die Wahl von stdio als Transport auf den ersten Blick pragmatisch. Es erlaubt lokale Server und Clients, einfach über die Standard-Ein- und Ausgabe zu kommunizieren, ohne sich um Netzwerk-Sockets kümmern zu müssen. Dies wird insbesondere bei lokalen Entwicklungsumgebungen geschätzt, da stdio plattformübergreifend funktioniert und sehr einfach zu implementieren ist.

Allerdings widerspricht diese Wahl in gewisser Weise dem klassischen Unix/Linux-Paradigma, denn stdio ist eigentlich für unidirektionale oder lineare Kommunikation gedacht, nicht für bidirektionale Nachrichtenströme, wie sie für Agenten-Kommunikation erforderlich sind. Man merkt schnell, dass trotz der praktischen Vorteile stdio weder optimal noch zeitgemäß für diese Aufgabe ist. Noch problematischer gestaltet sich die HTTP-basierte Anbindung. Ursprünglich wählte man hier Server-Sent Events (SSE), ein Web-Technologie-Standard, der es ermöglicht, Echtzeit-Events vom Server zum Client zu streamen. SSE eignet sich allerdings nur für einen unidirektionalen Datenfluss.

Um bidirektionalen Austausch zu realisieren, wurde unter dem Begriff "Streamable HTTP" ein komplexer Mechanismus entwickelt, der verschiedene HTTP-Methoden und Header kombiniert, um Sitzungen zu initiieren, aufrechtzuerhalten und Nachrichten in beide Richtungen zu versenden. Diese Konstruktion wirkt wie der Versuch, WebSocket-ähnliche Funktionalitäten auf eine weniger geeignete Grundlage zu legen und führt zu einer Vielzahl von Verwirrungen und nicht zuletzt zu Sicherheitsrisiken. Auch die Dokumentation des MCP-Protokolls gibt oft Rätsel auf. Für Entwickler, die auf eine solide Grundlage angewiesen sind, um stabile Implementierungen zu schreiben, ist dies keine ideale Ausgangslage. Tutorials und SDKs vermitteln oft nur unvollständig die Komplexität der Protokollabläufe.

Geeignete Beispiele für den tatsächlichen Nachrichtenfluss oder Fehlerszenarien fehlen häufig. Eine Vielzahl der Referenzimplementierungen sind in Python und JavaScript gehalten, die wiederum Abhängigkeiten mit sich bringen, die gerade in produktiven Umgebungen mit Alltagsproblemen wie Versionskonflikten und Paketmanagement frustrierend sein können. Besonders wenn man sich betrachtet, dass andere moderne Sprachen wie Go oder Rust eigentlich besser für portable, unkomplizierte, stabile Server-Implementierungen geeignet wären. Die Konsequenz ist, dass Entwickler gezwungen sind, oft mit halbgaren Hilfsmitteln und Workarounds zu arbeiten, während der Standard selbst in vielen Details unklar ist. Die Probleme mit der HTTP/Streamable-HTTP-Variante schlagen sich auch in mangelhafter Sitzungsverwaltung nieder.

Weil es mehrere Möglichkeiten gibt, Sitzungen zu starten, SSE-Streams zu erzeugen und Nachrichten zurückzugeben, entstehen komplexe Zustandsmaschine, die es Servern erschweren, konsistent und performant zu arbeiten. Skalierbarkeit wird zu einer Herausforderung, da die Verteilung der Last auf mehrere Server eine konsistente Verknüpfung von Anfragen und Antworten erschwert. Hinzu kommt, dass unterschiedliche Serverinstanzen eventuell unterschiedliche Verbindungen bedienen, was eine koordinierte Nachrichtenzustellung erschwert. Besonders kritisch sind diese Probleme im Kontext moderner Cloud-Architekturen, die schnelle Skalierbarkeit und Ausfallsicherheit benötigen. In Bezug auf die Sicherheit bringt das flexible Design weitere Sorgen mit sich.

Die Server müssen Sitzungszustände über verschiedene Verbindungen managen, was Risiken wie Session Hijacking, Replay-Attacken oder DoS (Denial-of-Service) erhöht. Die Vielzahl von Einstiegspunkten für aktive Verbindungen, kombiniert mit nicht klar definierten Session-Enden, öffnet Angriffsflächen, die von Angreifern missbraucht werden könnten. Zudem kann die vielfältige Art der Initiierung und Behandlung von Nachrichten dazu führen, dass bösartiger Traffic schwerer sichtbar wird, da die Kommunikationskanäle obfuskiert sind. Ein weiteres kontroverses Thema im MCP-Ökosystem ist die Art und Weise, wie Autorisierungsmechanismen vorgeschrieben werden. Während bei stdio die Empfehlung besteht, einfach Umgebungsvariablen zu nutzen, definiert die HTTP-Variante eine strikte Bindung an OAuth2-Protokolle, was sowohl ergänzende Sicherheit bietet, aber auch die Implementierung unnötig erschwert.

Gerade in Szenarien, in denen eine einfache API-Key-Lösung ausreichend wäre, wirken die Anforderungen überzogen. Dies schafft nicht nur Barrieren für Entwickler, sondern führt auch zu Inkonsistenzen in der operativen Praxis. Der offene Umgang mit diesen Schwachstellen hat mittlerweile auch eine Diskussion über Alternativen zum MCP ausgelöst. Zwei bedeutende Konkurrenten sind IBM mit dem Agent Communication Protocol (ACP) und Google mit Agent2Agent (A2A). Beide Protokolle verfolgen ebenfalls das Ziel, Agenten und LLMs miteinander kommunizieren zu lassen, setzen jedoch unterschiedliches Gewicht auf die Transport-Schicht und die Agenten-Discovery.

Die Einschätzung vieler Experten ist, dass ACP und A2A viele Funktionen bieten, die sich prinzipiell durch Erweiterungen von MCP hätten abdecken lassen. Insbesondere IBM selbst erkennt an, dass ACP-Agenten als Ressourcen von MCP aufgefasst werden können und somit die Protokolle prinzipiell miteinander kompatibel sind. Im Kern bringen ACP und A2A vor allem robustere Transportmechanismen mit sich. Das Thema Agentenentdeckung, also der effizienten Identifikation und Katalogisierung verfügbarer Agenten, wird hier ebenfalls adressiert – ein Aspekt, der in MCP noch nicht vollumfänglich behandelt ist. In der Entwickler-Community wird zunehmend gefordert, dass MCP auf WebSockets als Transport setzen sollte, anstatt die bestehende komplizierte SSE-basierte Architektur beizubehalten.

WebSockets bieten bidirektionale Kommunikation auf einer stabileren, standardisierten Basis, die sich bewährt hat und die Probleme mit Sitzungszuständen sowie Skalierbarkeit lösen könnte. Die Vorteile liegen dabei nicht nur in der technischen Eleganz, sondern auch in der besseren Dokumentationslage und der großen Verbreitung in Web- und Backend-Technologien. Allerdings gibt es auch Bedenken, dass WebSockets in einigen Netzwerken geblockt werden oder zusätzliche Komplexität bei der Session-Resilienz aufweisen können. Ausgewogen betrachtet scheint eine Fokussierung auf WebSockets dennoch der sinnvollere Weg für die weitere Entwicklung zu sein, insbesondere wenn man die intendierte Nutzung von MCP als universelles Agentenbindeglied in Betracht zieht. In der Praxis bedeutet diese Diskussion, dass Entwickler, die heute mit MCP arbeiten möchten, vor einer schwerfälligen Einstiegshürde stehen: Die Infrastruktur ist zwar grundsätzlich vorhanden, doch die Umsetzung und die technische Stabilität lassen zu wünschen übrig.

Wer also MCP produktiv einsetzen will, muss mit möglichen Stolpersteinen bei Integration, Sicherheit und Skalierung rechnen. Perspektivisch wäre eine Vereinheitlichung des Transports dringend geboten, um die Skalierung und Wartbarkeit der Systeme zu gewährleisten. Aus einer Entwicklungs- und Architekturperspektive ergibt sich daraus außerdem, dass Projekte besser auf Sprachen und Plattformen setzen sollten, die Portabilität und Ressourcen-Effizienz in einer Cloud- und Multi-Server-Welt bieten. Für viele gilt daher, Go oder Rust als Alternativen gegenüber Python und JavaScript, besonders in produktiven Server-Implementierungen. Abschließend stellt sich die Frage, wie sich der Markt und die Anbieter verhalten werden.

MCP ist zwar aus Sicht von Anthropic ein zentraler Baustein für die LLM-gesteuerte Zukunft des Programmierens, doch der offene Standard muss erst noch reifen und branchenweite Akzeptanz und Stabilität erreichen. Die existierenden Parallelentwicklungen wie ACP und A2A legen nahe, dass es noch keine endgültige Konsolidierung der Agenten-Kommunikation im KI-Bereich gibt und dass sich in den nächsten Jahren noch erhebliche Anpassungen und Verbesserungen ergeben werden. Der entscheidende Hebel für den Erfolg von Protokollen wie MCP wird sein, klare, stabile und gut dokumentierte Grundlagen zu schaffen, die Entwickler in die Lage versetzen, robuste Agenten-Ökosysteme zu etablieren, die sowohl lokal als auch skalierbar über das Internet agieren können. Ein weiterer Punkt ist die Benutzerfreundlichkeit und das Vertrauen in die Sicherheit. Sämtliche Designentscheidungen müssen nachvollziehbar und konsistent sein, um das Vertrauen von Unternehmen und Entwicklern zu gewinnen.

Es bleibt spannend zu beobachten, wie die Branche auf die Kritik reagiert und welche Standards und Implementierungen sich letztlich durchsetzen. MCP hat ohne Zweifel das Zeug, eine Schlüsselrolle im Zusammenspiel von LLMs und externen Datenquellen zu spielen. Klarer Kommunikationsstandard, flexible Erweiterbarkeit und breiter Einsatz in Coding-Umgebungen sind immense Vorteile. Doch aktuell ist das Protokoll noch ein Rohdiamant, dessen Politur und Feinschliff der Gemeinschaft und der Industrie noch bevorsteht.