In den letzten Jahren haben große Sprachmodelle, auch bekannt als Large Language Models (LLMs), einen bemerkenswerten technologischen Fortschritt markiert. Seit der Veröffentlichung von ChatGPT hat sich die Welt der Künstlichen Intelligenz fundamental verändert, und LLMs sind mittlerweile in vielen Bereichen allgegenwärtig. Man begegnet ihnen in Produktdemos, in strategischen KI-Planungen und in Diskussionen rund um die Vision einer allgemeinen Künstlichen Intelligenz (AGI). Doch während sie begeistern, zeichnet sich zunehmend ab, dass große Sprachmodelle zwar gewaltige Potenziale haben, jedoch nicht als Allheilmittel für alle Formen von Automatisierung und Intelligenz angesehen werden dürfen – insbesondere nicht, wenn es um strukturierte Abläufe und deterministische Prozesse geht. Die Erwartungen an LLMs wachsen, doch ihre zugrundeliegende Architektur setzt klare Grenzen, die in der Praxis oft übersehen werden.

Diese Diskrepanz stellt Unternehmen und Entwickler vor große Herausforderungen und erfordert ein differenziertes Verständnis der Stärken und Schwächen dieser Technologie. Große Sprachmodelle basieren auf der Vorhersage von Token-Sequenzen, die aus einem gegebenen Kontext resultieren. Diese Art der Architektur eignet sich hervorragend, um mit unstrukturierten Informationen umzugehen: Texte zusammenzufassen, aus großen Datenmengen Zusammenhänge zu erkennen oder sogar informelle logische Verknüpfungen herzustellen. Die Stärke liegt also im Umgang mit Ambiguität, Vieldeutigkeit und kreative Ideenfindung in flexiblen Kontexten. Doch genau diese Flexibilität bringt zugleich eine Schwäche mit sich.

LLMs sind nicht gebaut, um strikt deterministischen Regeln, fest definierten Abläufen oder mehrstufigen, strukturierten Logiken konsequent zu folgen. Sie haben nur ein sehr begrenztes Verständnis für dauerhaften Zustand, Zielverfolgung oder exakte Prozesssteuerung. Das führt zu einem häufigen Missverständnis. Viele spannende und kontrovers diskutierte Anwendungsfälle, die vor allem im unternehmerischen Umfeld beworben werden, setzen genau solche deterministischen und wiederholbaren Abläufe voraus. Das Problem dabei ist, dass LLMs sich nicht wie klassische Prozess-Engines verhalten.

Wenn Menschen selbst Schwierigkeiten haben, komplexe Abläufe ohne Fehler durchzuführen, wie soll ein vorhersagebasiertes Modell diese zuverlässig automatisieren? In der Praxis zeigt sich daher häufig, dass die schönen Demonstrationen aus Produktpräsentationen nicht robust in der echten Produktion funktionieren. Werkzeuge werden falsch eingesetzt, Schnittstellen reagieren unerwartet, und Randfälle bringen die gesamte Automatisierung zum Scheitern. Eine weitere Herausforderung liegt in der unsauberen Vermischung verschiedener KI-Paradigmen. Häufig werden die konkreten technischen Grundlagen von AI-Systemen nicht klar differenziert, was zu überzogenen Erwartungen führt. LLMs auf Basis von Transformer-Architekturen sind exzellent darin, Sprache zu modellieren und flexibel zu reagieren, haben aber Schwierigkeiten mit persistentem Systemzustand und planorientiertem Handeln.

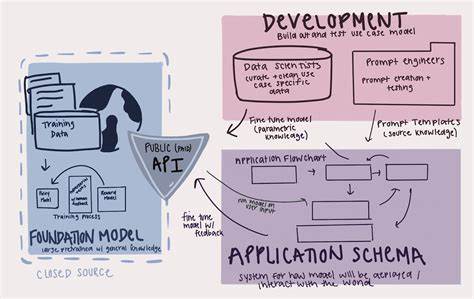

Symbolische KI-Systeme oder Zustandsmaschinen arbeiten streng nach vorgegebenen Regeln, sind präzise und wartbar, aber schlecht darin, mit unstrukturierten oder mehrdeutigen Informationen umzugehen. Reinforcement Learning bietet eine Möglichkeit, Verhalten durch Feedback zu optimieren, ist aber komplex in der Skalierung und erfordert erhebliche Datenmengen sowie Rechenressourcen. Die Kombination und Abwägung dieser Paradigmen ist entscheidend für realistische und effektive KI-Lösungen. Als Reaktion auf die Limitierungen einzelner Sprachmodelle haben sich sogenannte agentische Frameworks etabliert. Die Idee dabei ist, mehrere LLMs in unterschiedlichen Rollen interagieren zu lassen – etwa als Planer, Ausführer oder Überwacher – um komplexe Aufgaben gemeinsam zu meistern.

Theoretisch könnte das Zusammenwirken verschiedener Agenten helfen, die Schattenseiten einzelner Modelle zu kompensieren. In der Praxis zeigt sich aber ein anderes Bild. Die Koordination dieser Agenten und deren Werkzeugnutzung ist oft fragil. Wenn ein einzelner Sprachagent bereits Schwierigkeiten hat, aus fünf Werkzeugen die richtige Auswahl zu treffen, bedeutet die Hinzunahme weiterer Agenten und Werkzeuge oft eine bloße Verschiebung, nicht eine Lösung des zentralen Problems. Ohne gemeinsame Speichermechanismen oder persistierenden Zustand wird das Management mehrerer Agenten exponentiell komplexer.

Solche Systeme wirken dann eher wie Gremien, die sich ohne klare Autorität gegenseitig widersprechen, als wie robuste, belastbare Automatisierungslösungen. Ein weiteres Problem ist die mangelnde Bereitschaft vieler Verantwortlicher in Forschung und Industrie, offen über die Grenzen von LLMs zu sprechen. Gründer von führenden Labors, renommierte Forscher und Geschäftsführungsebenen wissen oft sehr wohl, dass große Sprachmodelle keine universellen Agenten sind und nicht alle Lösungsversprechen erfüllen können. Dennoch herrscht häufig eine Zurückhaltung, diese Gewissheit transparent zu kommunizieren. Stattdessen wird der Hype um AGI weiter befeuert, vorsichtige Einschätzungen werden als Pessimismus abgetan, und pragmatische Planung wird als Wachstumsbremse ausgelegt.

Marktmechanismen, Investoreninteressen und das Streben nach schnellen Erfolgen dominieren die Botschaften, oft zulasten einer nachhaltigen und ethisch verantwortungsbewussten Entwicklung. Dieser Zustand führt zu einem gefährlichen Ungleichgewicht zwischen den Erwartungen und der realistischen Leistungsfähigkeit von LLMs. Auf der Führungsebene und bei Investoren wächst der Druck, bahnbrechende Erfolge und Hollywood-reife Produktvisionen zu liefern. Gleichzeitig kämpfen Entwicklungsteams damit, technologische Grenzen zu überwinden, die sich nicht einfach ignorieren lassen. Fehlgeschlagene Projekte, unerfüllte Versprechen und steigende Kosten zehren an Ressourcen und Vertrauen.

Die Euphorie um die Möglichkeiten der KI steht so im Kontrast zur nüchternen Realität, in der große Sprachmodelle eben keine universellen Prozessmotoren sind. Dennoch ist die Geschichte der LLMs keineswegs eine von gescheiterter Technologie. Im Gegenteil sind sie bedeutende Werkzeuge, die eine Reihe neuer Anwendungen und Einsichten ermöglichen. Wichtig ist aber, sie nicht isoliert zu betrachten, sondern im Kontext eines breiteren Ökosystems an KI-Methoden und Softwarearchitekturen. Eine vielversprechende Entwicklung ist die Integration externer Speicher- und Zustandsmanagementsysteme, die Sprachmodelle mit persistenter, strukturierter Information verbinden.

Durch solche Speicher-APIs können Sprachagenten kontextbewusster agieren, über längere Zeiträume ausreichend Hintergrundwissen bewahren und präzisere Handlungen durchführen. Dieses Zusammenspiel von flexiblem Sprachverständnis und rigoroser Struktur kann viele Schwachstellen von LLMs kompensieren und die Bandbreite möglicher belastbarer Anwendungen deutlich erweitern. Die Kombination von LLMs mit symbolischer KI, Zustandsmaschinen oder Reinforcement Learning kann ebenso eine wichtige Rolle spielen. Durch die Aufteilung von Aufgaben entsprechend ihrer naturell geeigneten Paradigmen lassen sich die individuellen Stärken optimal ausspielen. Sprachmodelle können weiterhin für Kreativität und unstrukturierte Problemlösung genutzt werden, während deterministische Workflows durch bewährte symbolische Komponenten abgesichert werden.

Reinforcement Learning ergänzt adaptive und geplante Verhaltensweisen. Dieser gezielte Mix erhöht die Robustheit von KI-Systemen und vermeidet unrealistische Erwartungshaltungen, die durch das ausschließliche Vertrauen auf LLMs entstehen. Unternehmen und Entwickler sollten sich deshalb von der Idee verabschieden, große Sprachmodelle alleine könnten alle Herausforderungen der Automatisierung, Prozesssteuerung oder intelligenter Assistenten lösen. Stattdessen ist ein reflektierter, architekturorientierter Blick notwendig, der Stärken, Schwächen und Grenzen der einzelnen KI-Paradigmen anerkennt. Nur so lässt sich eine nachhaltige, praktikable KI-Infrastruktur aufbauen, die tatsächlich Mehrwert bringt, ohne auf Basis überzogener Erwartungen zu scheitern.

Die Rollen von Führungskräften und Forschern sind dabei von großer Bedeutung. Ehrlichkeit und Transparenz über den Stand der Technik und offener Umgang mit Grenzen schaffen Vertrauen und ermöglichen realistischere Zielsetzungen. Auch die Förderung von Entwicklungen, die LLMs mit externem Zustand und strukturierten Prozessen koppeln, ist ein Schritt, der weit über kurzfristigen Hype hinausgeht. Nur so kann der Weg geebnet werden für robuste, zuverlässige KI-Lösungen, die der Komplexität realer Anwendungen gerecht werden. Abschließend zeigt sich, dass große Sprachmodelle zwar beeindruckende technologische Errungenschaften sind und einen bedeutenden Platz im KI-Ökosystem einnehmen, sie aber nicht als universelle Lösung betrachtet werden dürfen.

Die Zukunft intelligenter Systeme liegt vielmehr in der integrativen Nutzung verschiedener Paradigmen und der Schaffung robuster, verlässlicher Architekturen, die LLMs dort einsetzen, wo ihre Stärken liegen, und andere Technologien für die Bereiche ergänzen, in denen sie an ihre Grenzen stoßen. Dieser Blick auf die Realität der Technologie ist kein Pessimismus, sondern eine Grundlage für nachhaltigen Fortschritt in der Künstlichen Intelligenz.