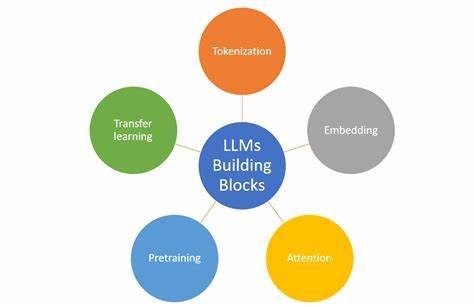

Die Produktion von chinesischen Satzbeispielen für Lernende, Übersetzer oder Entwickler erfordert präzise und zuverlässige Werkzeuge. Kleine Large Language Models (LLMs) sind dabei eine interessante Option, da sie trotz begrenzter Modellgröße eine bemerkenswerte Leistung liefern können. Solche Modelle sind besonders vorteilhaft, wenn Ressourcen begrenzt sind oder schnelle Ergebnisse benötigt werden. Jedoch ist die Auswahl des passenden LLMs zur Generierung chinesischer Beispielssätze eine Herausforderung, gerade wenn diese korrekte Pinyin-Transkriptionen sowie englische Übersetzungen umfassen sollen. Die meisten verfügbaren LLMs sind entweder sehr groß und umfangreich oder kleiner und weniger präzise.

Bei Modellen mit einer Größe von 3 bis 4 Milliarden Parametern zeigt sich häufig, dass die resultierenden Sätze inhaltlich fragwürdig sind und die Pinyin-Ausgaben oftmals fehlerhaft oder inkonsistent sind. Dies beeinträchtigt die Nutzbarkeit für Lernende erheblich, da eine falsche Pinyin-Darstellung zu Missverständnissen führen kann. Ein Beispiel hierfür ist das Gemma3-Modell, das zwar klein ist, aber bei der Satzgenerierung oft unbrauchbare Ergebnisse liefert und bei Pinyin ungenau bleibt. Auf der gegenüberliegenden Seite steht GLM-4-0414 mit etwa 9 Milliarden Parametern. Dieses Modell liefert wesentlich bessere Sätze, sowohl inhaltlich als auch hinsichtlich der Feinausgabe, wie korrekte Pinyin-Anzeige.

Dennoch ist es immer noch nicht fehlerfrei und benötigt gelegentlich Nachbesserungen, was auf die inhärente Komplexität der chinesischen Sprache und die hohe Erwartung an Genauigkeit zurückzuführen ist. Die Größe des Modells und der Rechenaufwand stellen für einige Anwender ebenfalls eine Hürde dar, insbesondere wenn Hardware-Ressourcen limitiert sind. Ein weiteres Modell, das häufig genannt wird, ist Llama 3 mit 8 Milliarden Parametern. Es zeigt jedoch deutliche Schwächen bei der Generierung chinesischer Sätze. Die Qualität der ausgegebenen Beispielsätze wird oft als unzureichend beschrieben, was für professionelle oder akademische Zwecke abschreckend sein kann.

Dies verdeutlicht, dass nicht nur die Modellgröße allein ausschlaggebend ist, sondern auch die Trainingsdaten und der spezifische Fokus auf die chinesische Sprache. Um dennoch eine hohe Qualität bei der Generierung chinesischer Sätze in einem kleineren Modellrahmen zu erreichen, empfehlen Experten alternative Herangehensweisen. Das Qwen-Modell, insbesondere die Version 3, ist eine vielversprechende Option. Obwohl die kleineren Varianten noch nicht ausführlich getestet wurden, zeigte das erheblich größere 32-Milliarden-Parameter-Modell sehr gute Resultate im Bereich Übersetzung und Chinesischgenerierung, was auf eine solide Sprachkompetenz hindeutet. Es ist möglich, durch mehrfaches Prompting mit Qwen die Satzqualität zu steigern.

Eine gängige Methode besteht darin, das Modell zuerst einen Satz generieren zu lassen und es anschließend auffordert, diesen kritisch zu bewerten und zu verbessern. Dieser zweistufige Ansatz basiert auf der Beobachtung, dass LLMs oft besser darin sind, bestehende Texte zu beurteilen und zu korrigieren, als vollständig neue Inhalte ohne Kontext und Kontrolle zu produzieren. Das mehrfache Durchlaufen von Generierungs- und Kritikphasen kann die Satzqualität erheblich verbessern und Fehler in Pinyin sowie in der englischen Übersetzung minimieren. Anwender sollten allerdings beachten, dass diese Technik mehr Zeit erfordert und die Gesamt-Rechenzeit erhöht. Neben Qwen bieten auch einige weniger bekannte, oft experimentelle oder distillierte Modelle eine interessante Perspektive.

Beispielsweise gibt es Varianten auf Basis von Deepseek V3, die zwar stark komprimiert sind („hideous distil“ genannt), aber dennoch eine akzeptable Satzqualität erzielen können. Solche Modelle könnten für Projekte interessant sein, bei denen eine sehr geringe Modellgröße und schnelle Antwortzeiten wichtiger sind als perfekte Textqualität. Bei der Auswahl des geeigneten LLMs für chinesische Satzbeispiele spielt auch die Verfügbarkeit und Zugänglichkeit des Modells eine große Rolle. Manche Modelle sind frei zugänglich und lassen sich lokal betreiben, was für Datenschutz und Anwendungsflexibilität von Vorteil ist. Andere existieren nur als Cloud-Service mit API-Zugang, was zwar Bedienkomfort bietet, aber oft mit Nutzungskosten verbunden ist und die Datenhoheit einschränkt.

Ein weiterer wichtiger Aspekt ist die Art und Qualität der Trainingsdaten, auf denen das Modell beruht. Spezialisierte chinesische Korpusdaten, inklusive annotierter Pinyin-Ausgaben, verbessern die generativen Fähigkeiten erheblich. Große, gemischte multidisziplinäre Datensätze führen oft zu allgemeinen, aber weniger präzisen Ergebnissen. Deshalb ist es sinnvoll, nach Modellen Ausschau zu halten, die speziell für chinesische Sprachverarbeitung trainiert wurden oder feinjustiert sind. Das Generieren von Beispielsätzen sollte auch stets eine Nachbearbeitung und Validierung beinhalten.

Unabhängig von der Modellgröße kann es zu Fehlern kommen, besonders bei kulturell oder kontextuell komplexen Ausdrücken. Sprachspezialisten und Muttersprachler sind wichtige Partner, um die Qualität der generierten Sätze sicherzustellen und gegebenenfalls Korrekturen vorzunehmen. Für Entwickler und Sprachlerner empfiehlt es sich, mehrere Modelle zu testen und ihre Schwächen und Stärken zu evaluieren. Ein gutes Setup könnte darin bestehen, ein kleines Modell zur schnellen, rudimentären Ausgabe zu verwenden und anschließend ein größeres Modell oder spezialisierte Tools für die Verfeinerung und Kontrollprüfung einzusetzen. Die Kombination von mehreren LLMs und menschlicher Expertise führt oft zu den besten Ergebnissen.

Langfristig ist mit weiteren Fortschritten in der LLM-Technologie zu rechnen, die auch kleineren Modellen erlauben werden, hochwertigere Inhalte zu generieren. Fortschritte bei der Modellarchitektur, effizientere Trainingsmethoden und bessere Datensätze werden diese Entwicklung fördern. Für heute gilt es, pragmatisch die beste Balance zwischen Modellgröße, Leistung und Verfügbarkeit zu finden. Wer auf der Suche nach einem kleinen, wirklich guten LLM ist, das chinesische Beispielsätze inklusive Pinyin und englischer Übersetzung generiert, sollte die hier genannten Modelle und Herangehensweisen in Betracht ziehen. Qwen 3 präsentiert sich als besonders vielversprechend, vor allem wenn man mehrere Durchgänge mit besserer Qualitätskontrolle einsetzt.

Modelle wie GLM-4-0414 bieten mehr Qualität auf Kosten größerer Modellgröße. Llama 3 wiederum scheint bei der chinesischen Sprache bis dato weniger geeignet. Kleinere experimentelle Distillate können in bestimmten Szenarien eine Option sein. Für die Praxis bedeutet dies, die eigenen Anforderungen genau zu definieren und gegebenenfalls eine Kombination aus verschiedenen Werkzeugen zu nutzen. Die Qualität der Ausgabe sollte nicht nur automatisiert erfolgen, sondern auch manuell überprüft werden, um die bestmögliche Verlässlichkeit zu gewährleisten.

Letztlich eröffnet die rasante Entwicklung im Bereich Künstlicher Intelligenz und Sprachmodelle viele neue Chancen, den Umgang mit chinesischer Sprache komfortabler und effizienter zu gestalten.