In der Welt moderner Softwareentwicklung steht Java weiterhin als eine der wichtigsten Programmiersprachen hoch im Kurs, vor allem wegen seiner Stabilität, Vielseitigkeit und der enormen Verbreitung im Backend-Bereich. Ingenieure und Entwickler suchen stets nach Wegen, Anwendungen schneller, effizienter und ressourcenschonender zu gestalten. Eine der jüngeren Innovationen im Java-Ökosystem sind die sogenannten Virtual Threads – eine revolutionäre Veränderung im Thread-Management, die verspricht, parallele Verarbeitung in bisher ungeahntem Maße zu ermöglichen. Doch trotz aller Vorteile bringt ihre Anwendung auch neue Herausforderungen mit sich, besonders in Bezug auf den Speicherverbrauch. In diesem Kontext möchte ich anhand eines einfachen Web-Crawlers berichten, wie der Einsatz von Java Virtual Threads ein unerwartetes Speicherproblem verursachte und welche Erkenntnisse sich daraus gewinnen lassen.

Die Geschichte zeigt exemplarisch, dass höhere Geschwindigkeit und verlockende Parallelität auch ihre Tücken haben können – vor allem wenn man die dahinter liegenden Mechanismen und Folgen nicht ausreichend berücksichtigt. Ein Web-Crawler ist ein klassisches Beispiel für eine Aufgabe mit massiv parallelen Operationen: Er durchsucht viele Webseiten, lädt Daten herunter und verarbeitet diese anschließend. Traditionell werden derartige Prozesse in Java mithilfe von Plattform-Threads umgesetzt. Dabei verwendet man einen fixen Thread-Pool, welcher eine begrenzte Anzahl von Threads umfasst, um gleichzeitig mehrere Aufgaben zu bearbeiten. Diese Plattform-Threads haben jedoch relativ hohen Overhead, was ihre Anzahl im Programm limitiert.

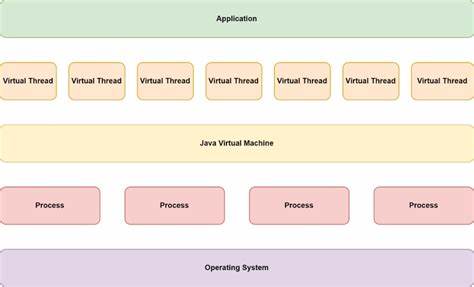

Je mehr Threads aktiv sind, desto höher wird der Verwaltungsaufwand, was irgendwann an die Leistungsgrenzen der Hardware und JVM stößt. Der natürliche Next Step: Virtual Threads Virtual Threads sind ein neues Feature, eingeführt, um genau dieses Problem zu lösen. Sie sind leichter als herkömmliche Plattform-Threads, daher können Tausende oder sogar Millionen von ihnen gleichzeitig existieren, ohne das System zu überlasten. Die JVM stellt Virtual Threads in Zusammenarbeit mit dem zugrunde liegenden Betriebssystem und der Java-Laufzeit so dar, dass sie weniger Systemressourcen beanspruchen, vor allem bei blockierenden Operationen wie Netzwerkzugriffen. Damit sollen Anwendungen mit massiv parallelen Abläufen effizienter arbeiten und eine bessere Skalierbarkeit erreichen.

In einem ersten Versuch tauschte ich bei meinem Web-Crawler die alte Thread-Pool-Struktur gegen den Executors.newVirtualThreadPerTaskExecutor() aus. Die Wirkung war beeindruckend. Die Download- und Verarbeitungsrate der URLs stieg sprunghaft an, Fast schien kein Limit mehr zu existieren. Virtual Threads beseitigten den I/O-Engpass und erlaubten es der JVM, viele parallele Netzwerkrequests sowie deren Verarbeitungen gleichzeitig zu initiieren und zu überwachen.

Nehmen wir an, der Crawler musste 20.000 URLs durchlaufen lassen – mit 200 Plattform-Threads dauerte das einige Zeit, doch mit Virtual Threads geschah es gefühlt in nur einem Bruchteil davon. Doch hatte diese scheinbar unbegrenzte Geschwindigkeit auch einen Haken. Irgendwann kam die Java Virtual Machine (JVM) mit einer OutOfMemoryError-Ausnahme zum Stillstand. Trotz der anfänglichen Euphorie zeigte sich, dass Virtual Threads nicht automatisch alle Ressourcenprobleme lösen, sondern vielmehr neue Dimensionen dieser Herausforderungen eröffnen.

Warum frisst ein virtueller Thread plötzlich so viel Speicher? Plattform-Threads profitieren indirekt von der begrenzten Anzahl an Threads, die vom Betriebssystem verwaltet werden. Diese Begrenzung dient als natürliche Bremse, die verhindert, dass zu viele Aufgaben gleichzeitig gestartet werden. Bei Virtual Threads entfällt diese natürliche Backpressure, denn sie können quasi unbegrenzt erzeugt werden. Im Fall des Web-Crawlers bedeutete das: Das System startete so viele parallele Downloads, wie es die Java Threads zuließen, ohne auf die Verarbeitungsrate der heruntergeladenen Inhalte Rücksicht zu nehmen. Das Ergebnis war eine Flut von gleichzeitig heruntergeladenen Daten, die im Arbeitsspeicher gesammelt wurden, bevor sie verarbeitet wurden.

Weil die Verarbeitungszeit nicht entsprechend zulegte – etwa durch Parsing der Response-Inhalte oder andere CPU-intensive Aktivitäten – wuchsen die wartenden Datenpakete im Speicher exponentiell. Der Heap-Speicher wurde binnen kürzester Zeit überbeansprucht und die JVM musste sich beenden. Die Ressourcenbegrenzungen verlagerten sich von der Thread-Erzeugung auf das Speichermanagement. Ein rein virtuelles Thread-Modell ohne ergänzende Kontrollmechanismen kann somit zu einem sogenannten "Speicher-Bombardement" führen, welches sich in einer OutOfMemoryError-Situation manifestiert. Lösungsstrategien: Mit Virtual Threads kontrolliert arbeiten Um die Vorteile der Virtual Threads weiterhin zu genießen, jedoch deren Speicherhunger zu zähmen, gilt es, zusätzlich zum einfachen Thread-Management weitere Kontrollmechanismen einzubauen.

In meinem Experiment bewährte sich eine klassische Methode aus dem Bereich der Nebenläufigkeit: der Einsatz einer Semaphore als Kontrollinstrument zur Begrenzung der gleichzeitigen Ausführung aktiver Threads. Mit einer Semaphore werden nur eine begrenzte Anzahl an Virtual Threads gleichzeitig eine Ressource beanspruchen dürfen. Im Fall des Crawlers setzte ich den semaphoring Wert auf 500 concurrent tasks. Dadurch konnten zwar immer noch wesentlich mehr Threads als bei den Plattform-Threads gleichzeitig aktiv sein, aber das System wurde vor Überforderung geschützt, da nicht alle Tasks zugleich herunterladen und verarbeiten konnten. Die Implementierung ist denkbar einfach.

Vor dem Start eines asynchronen Downloads wird eine Erlaubnis von der Semaphore eingeholt. Tritt die maximale Anzahl aktiver Tasks ein, so müssen nachfolgende Threads warten, bis wieder ein Slot frei wird. Nach Abschluss des Downloads und der Datenverarbeitung gibt der Thread die Erlaubnis zurück. Diese Struktur schafft die dringend benötigte Rückmeldungsschleife und verhindert, dass die JVM in den Speicherüberlauf rast. Alternativ oder ergänzend kann man auch das Einreichen von Aufgaben in das Thread-Executor-System steuern.

Beispielsweise kann man die Anzahl der gleichzeitig eingereichten Tasks herunterdrosseln. Im realen Umfeld kommen Crawl-Jobs oft auch nicht als Flut, sondern nach und nach herein. Man könnte daher Batch-Processing oder rate limiting implementieren, um die Flut von Requests überschaubar zu gestalten. Die Lehre für Entwickler Die Erfahrung mit Virtual Threads im Web-Crawler-Projekt zeigt anschaulich, dass neue Technologien keinesfalls per se Problemlöser sind, sondern vielmehr neue Anforderungen und Denkweisen mitbringen. Virtual Threads revolutionieren das traditionelle Threading in Java, weil sie Kapazitätsengpässe lösen und den Kontextwechselaufwand minimieren.

Doch diese scheinbare Unbegrenztheit der Anzeigen lenkt leicht davon ab, dass jede Aktion in einer Applikation Ressourcen verbraucht. Das Prinzip der Rückmeldung und Belastungssteuerung bleibt auch bei Virtual Threads unerlässlich. Das Verständnis für den gesamten Ressourcenverbrauch und die Implementierung von Steuerungsmechanismen wie Semaphore oder Rate Limiting sind daher zentrale Bestandteile einer robusten, skalierbaren Anwendung. Die Entwickler-Community sollte Virtual Threads nicht als Allheilmittel begreifen, sondern als mächtiges Werkzeug, das mit Bedacht eingesetzt werden muss. Nur so kann man die Performance-Boosts genießen, ohne in Fallen wie Speicherüberlauf und Systeminstabilität zu tappen.

Ausblick Mit der Etablierung von Virtual Threads steht die Java-Welt vor einem Paradigmenwechsel. Neben den technischen Aspekten werden Programmiermodelle und Architekturstile angepasst werden müssen. Virtual Threads eröffnen zahlreiche Möglichkeiten für reaktive und nebenläufige Programme, die bisher aufwändig umzusetzen waren. Gleichzeitig rückt das Thema Ressourcenmanagement wieder stärker in den Fokus. Für produktive Systeme bedeutet das: Neben dem Upgrade der JVM und Nutzung neuer Funktionen ist eine Überarbeitung der Architektur erforderlich, die dem ungehemmten Parallelismus mit robusten Kontrollmechanismen begegnet.

Nur so entstehen moderne, hochperformante Applikationen, die sowohl Geschwindigkeit als auch Speicherverantwortung im Einklang halten. Abschließend lässt sich sagen, dass Virtual Threads zwar eine attraktive Chance sind, bestehende Limitierungen zu überwinden, jedoch ebenso an die Pflicht erinnern, verantwortungsbewusst und durchdacht mit Ressourcen umzugehen. Der Weg zu leistungsstarken Systemen ist kein Sprint, sondern ein Balanceakt zwischen Geschwindigkeit, Parallelität und Speicherverbrauch – in genau dieser Balance liegt die Kunst der modernen Softwareentwicklung.