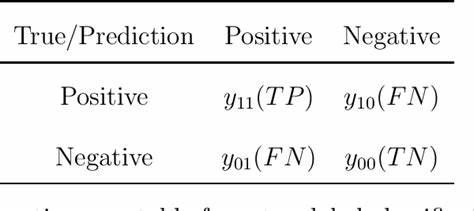

Die zunehmende Verbreitung großer Sprachmodelle (Large Language Models, LLMs) wie GPT oder ähnliche KI-Systeme prägt die Landschaft der künstlichen Intelligenz seit einigen Jahren maßgeblich. Mit steigender Nutzung und immer komplexeren Anwendungsfällen wächst auch der Bedarf an verlässlichen und praxisnahen Evaluationsmethoden, um die Qualität und Leistung dieser Modelle realistisch abzubilden. Klassisch standen dabei oft numerische Metriken wie Genauigkeit, BLEU-Score oder ROUGE im Mittelpunkt, die einzelne Antworten oder Abschnitte bewerten. Doch diese herkömmlichen Zahlenwerte stoßen angesichts anspruchsvollerer Szenarien zunehmend an ihre Grenzen. Genau hier setzt ein moderner Ansatz an, der sich auf End-to-End-(E2E)-Evaluierungen mit Fokus auf binäre Assertions konzentriert.

Dabei geht es darum, ganze Gesprächsabläufe und Komplettinteraktionen von KI-Agenten in ihrem Kontext zu testen und unmittelbar zu überprüfen, ob sie die erwarteten Anforderungen erfüllen. Diese Methode beeinflusst die Art und Weise, wie KI-Systeme beurteilt, verbessert und weiterentwickelt werden, fundamental. Der Begriff End-to-End Evaluation beschreibt eine ganzheitliche Überprüfung, die nicht einzelne isolierte Antwortfragmente sondern vollständige Konversationen oder Interaktionssequenzen betrachtet. So lässt sich ein umfassenderes Bild vom Verhalten eines KI-Agenten zeichnen. Anders als bei traditionellen Metriken, welche numerische Scores zurückgeben und oft interpretativen Spielraum offenlassen, liefern binäre Assertions ein klares Ja- oder Nein-Ergebnis.

Diese Vorgehensweise erlaubt eine direkte Prüfung, ob die KI eine erwartete Eigenschaft erfüllt, zum Beispiel ob sie eine spezifische Rückfrage gestellt, relevante Fakten genannt oder korrekte Toolnutzungen durchgeführt hat. Das trägt wesentlich zu präziseren Aussagen über die Qualität der Modelle bei und erleichtert zugleich die Automatisierung von Testprozessen. Ein praktisches Beispiel aus der Anwendung zeigt, wie ein KI-Agent innerhalb einer simulierten Unterhaltung so evaluiert wird, dass die Software überprüft, ob er tatsächlich eine Rückfrage zu einer unklaren Eingabe stellt. Statt einer Punktzahl wird hier also gebündelt geprüft, ob ein entscheidendes Verhalten auftritt. Dies öffnet Forschern und Entwicklern die Möglichkeit, funktionale Anforderungen an KI-Systeme sauber zu definieren und automatisiert zu verifizieren.

Solche binären Assertions lassen sich flexibel an die jeweilige Domäne anpassen und zum Beispiel die Einhaltung von Compliance-Richtlinien, ethischen Garanten oder spezifischen Nutzerbedürfnissen sicherstellen. Ein weiterer Vorteil dieses Evaluationsparadigmas liegt in der Integration von sogenannten Rich Judging-Modellen, die selbst auf KI-Basis Entscheidungen treffen. Dabei fungieren leistungsfähige Sprachmodelle als Richter, welche anhand von Texten oder Gesprächsverläufen prüfen, ob ein bestimmtes Kriterium erfüllt wurde. Durch diese auf Künstlicher Intelligenz basierenden Beurteilungen können kontextuelle Nuancen mit einfließen, die einfache, regelbasierte Systeme häufig nicht erfassen. So lassen sich versteckte Fehler erkennen und die Güte der Systeme realitätsnäher einschätzen.

Darüber hinaus unterstützen moderne Werkzeuge die nahtlose Einbettung dieser getesteten Agenten in automatisierte Workflows. Entwickler können ihre Agenten in Form von leicht testbaren Modulen oder Funktionen definieren, in denen Nutzeranfragen simuliert werden. Anschließend erfolgt eine Evaluierung, die anhand von Segmenten wie Nutzernachrichten, Agentenantworten und automatisierten Bewertungen abläuft. Dies ermöglicht es, komplette Nutzerpfade mit mehreren Runden abzubilden und gezielt Herausforderungen in Dialogmanagement, Informationsverarbeitung oder Toolintegration aufzudecken. Die Bedeutung von User Simulationen in diesem Kontext darf nicht unterschätzt werden.

Eine realistische Nachbildung von Nutzerschritten macht es möglich, auch komplexe Interaktionen und Mehrfachfragen automatisch durchspielen und bewerten zu lassen. Die KI-gestützte Simulation von Nutzern generiert dabei unterschiedliche Varianten von Gesprächsverläufen, die im Anschluss auf Zielkriterien überprüft werden. Dies hilft Entwicklerteams, ihre Systeme gegen seltene oder schwierige Szenarien zu härten und zeigt gleichzeitig, wie robust ein Modell in der Praxis agiert. In technologischer Hinsicht erlauben modulare Architekturen einen einfachen Wechsel oder die Kombination verschiedener Modellanbieter und Judging-Methoden. Das Framework, das solche E2E-Evaluationen ermöglicht, stellt keine starren Vorgaben an die zugrundeliegende Infrastruktur, sondern lässt neben den populären großen Sprachmodellen auch alternative Anbieter zu.

Auf diese Weise wird maximale Flexibilität geboten und verhindert, dass sich Evaluationsprozesse technologisch einengen. Ein weiterer Aspekt ist die Handhabbarkeit und Type-Safety solcher Systeme. Moderne Implementierungen nutzen Typisierungsmöglichkeiten, um Fehlerquellen frühzeitig zu erkennen und die Entwicklungsqualität zu erhöhen. So können Teams Tests mit minimalem Overhead designen und anpassen, was insbesondere bei der schnellen Iteration und der Zusammenarbeit in größeren Entwicklergruppen von hoher Bedeutung ist. Natürlich ersetzt eine fokusierte Betrachtungsweise auf binäre Assertions nicht vollständig die quantitative Bewertung mittels Metriken.

Diese bleiben weiterhin wichtig, um Trends zu erkennen, Modellvergleiche durchzuführen oder statistische Analysen vorzunehmen. Doch die Kombination beider Ansätze führt zu einem deutlich aussagekräftigeren Gesamtbild. Während Metriken grobe Orientierungshilfen bieten, erlauben die Assertion-basierten End-to-End-Tests tiefe Einblicke in das Verhalten und ermöglichen eine systematische Qualitätskontrolle. Die Zukunft der LLM-Evaluation wird daher stark von diesen hybriden und ganzheitlichen Methoden geprägt sein. Die Verlagerung hin zu weniger anonymen Zahlen und mehr konkret überprüfbaren Anforderungen hilft dabei, die Entwicklungen von KI verantwortungsvoller und nachvollziehbarer zu gestalten.

Unternehmen und Forschungseinrichtungen profitieren dadurch nicht nur bei der Absicherung der Modellgüte, sondern auch beim Aufbau von vertrauenswürdigen KI-Systemen, die im Alltag und kritischen Anwendungsgebieten zuverlässig funktionieren. Zudem fördern offene Tools und Frameworks, die diese Konzepte abbilden, den Austausch in der Community und treiben die standardisierte Nutzung voran. Diese Transparenz und Wiederverwendbarkeit sind Schlüsselfaktoren für eine nachhaltige und erfolgreiche Entwicklung von KI-Technologien. Abschließend lässt sich sagen, dass end-to-end-basierte Evaluationen mit Schwerpunkt auf binären Assertions einen bedeutenden Paradigmenwechsel in der Beurteilung großer Sprachmodelle darstellen. Sie bieten präzisere Kontrollmöglichkeiten, unterstützten automatisierte Qualitätssicherung und ermöglichen einen praxisnäheren Dialog mit KI-Agenten.

Wer heute sein KI-System wirklich belastbar prüfen und verbessern will, kommt an diesen modernen Evaluationsstrategien kaum vorbei.