In der heutigen Zeit nimmt die Nutzung von Künstlicher Intelligenz (KI) in der Forschung rapide zu. Dennoch bringt diese technologische Entwicklung auch neue Herausforderungen mit sich, insbesondere wenn es um Transparenz, Originalität und die Qualität wissenschaftlicher Veröffentlichungen geht. Ein aktueller Fall eines Google-Ingenieurs, der seinen Preprint zurückzog, nachdem er für die Verwendung von KI kritisiert wurde, verdeutlicht diese Problematik eindrücklich. Der Fall dreht sich um Anurag Awasthi, einen leitenden Ingenieur bei Google im Bereich KI-Infrastruktur. Anfang des Jahres 2025 veröffentlichte er auf der Plattform arXiv.

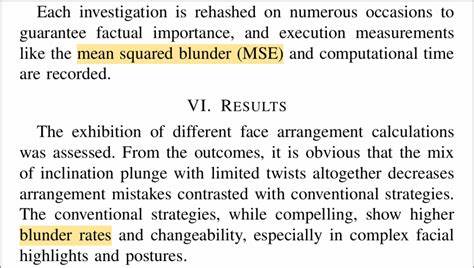

org einen Preprint mit dem Titel „Leveraging GANs For Active Appearance Models Optimized Model Fitting“. Der Beitrag sollte offenbar neue Ideen im Bereich der Generativen Adversarialen Netzwerke (GANs) und deren Anwendung bei Optimierungsmodellen darstellen. Doch bereits kurz nach der Veröffentlichung stießen aufmerksame Leser auf Mängel in der sprachlichen Gestaltung des Manuskripts. Einige Phrasen wirkten merkwürdig und deuten eindeutig auf den Einsatz von KI-generierten Texten hin. Diese als „tortured phrases“ bezeichneten Wendungen, wie zum Beispiel „squared blunder“ statt „error rate“ oder „straight relapse“ anstelle von „linear regression“, wurden von Experten auf der Plattform PubPeer analysiert.

Solche Formulierungen sind typisch für Fälle, in denen KI-basierte Textgeneratoren, insbesondere solche mit synonymbasierten Umschreibungen, eingesetzt werden, ohne den Output ausreichend zu überprüfen. Sie spiegeln eine nicht angemessene Anpassung der Fachterminologie wider und führen zu Verwirrung, da insbesondere in der Wissenschaft Präzision bei Begrifflichkeiten entscheidend ist. Die Debatte um den Preprint entflammte, als zusätzlich Parallelen zu einem bereits 2016 veröffentlichten wissenschaftlichen Artikel festgestellt wurden. Die Struktur und Teilen der Formulierungen ähnelten stark dem früheren Werk, was bei der wissenschaftlichen Gemeinschaft Zweifel an der Eigenständigkeit und Originalität des Preprints aufkommen ließ. In seinen Reaktionen gab Awasthi an, dass Teile des Manuskripts mithilfe von KI-basierten Werkzeugen zur Textumformulierung entstanden seien, mit der Intention, Variationen in der Ausdrucksweise zu erzeugen.

Gleichzeitig betonte er, dass das gesamte Unterfangen ursprünglich als persönliches Lernprojekt gedacht war. Nichtsdestotrotz führte diese Erklärung nicht zur Befriedigung der kritischen Leser, da der Einsatz von KI in der wissenschaftlichen Texterstellung nicht offengelegt worden war. Auch die Tatsache, dass sprachliche Fehler und eine zu enge Anlehnung an frühere Werke unentdeckt blieben, offenbarten Schwachstellen in der Qualitätskontrolle. Awasthi gab schließlich zu, die Konsequenzen und die Ernsthaftigkeit der Veröffentlichung eines Preprints unterschätzt zu haben und entschied sich, das Manuskript zurückzuziehen. Der Fall von Awasthi zeigt ein Spannungsfeld, in dem sich die Wissenschaft heute befindet.

Der Einsatz von KI-Werkzeugen bei der Erstellung wissenschaftlicher Texte kann einerseits die Effizienz erhöhen und Forscher unterstützen. Andererseits birgt dieser Ansatz Risiken, wenn die erzeugten Inhalte nicht sorgfältig überprüft und der Einsatz solcher Technologien nicht transparent gemacht wird. Die Wissenschaft lebt von Vertrauen, Reproduzierbarkeit und Klarheit, und jeder Umstand, der diese Grundsätze gefährdet, stößt auf berechtigte Kritik. Insbesondere bei der Verwendung von KI-Modellen zur Texterstellung ist zu beachten, dass die Programme – so fortschrittlich sie auch sein mögen – oft Fehler produzieren können, sogenannte „Halluzinationen“. Dabei entstehen Informationen oder Formulierungen, die zwar plausibel klingen, aber fachlich falsch oder unsinnig sind.

Derartige Fehler sind besonders fatal, wenn sie in wissenschaftlichen Arbeiten auftreten, da sie Fehlinformationen verbreiten und die Glaubwürdigkeit der Forschung insgesamt beeinträchtigen können. Das Phänomen der „tortured phrases“ wurde bereits in anderen Untersuchungen beschrieben. Es handelt sich um unnatürliche, oft eigentümliche Umschreibungen geläufiger Fachbegriffe, entstanden häufig durch automatisierte Synonymersetzungen oder unzureichend trainierte KI-Systeme. Dieses Problem wurde nicht nur bei einzelnen Preprints und Veröffentlichungen festgestellt, sondern auch als Indikator für mögliche Textmanipulation oder eine unkritische Nutzung von Textgeneratoren wahrgenommen. Die wissenschaftliche Gemeinschaft hat daher verstärkt Diskussionen darüber angestoßen, wie der Einsatz von KI bei der Forschung und Publikation verantwortungsvoll gehandhabt werden sollte.

Transparenz ist dabei ein entscheidendes Thema: Autoren müssen klar kennzeichnen, wenn und in welchem Umfang KI-Werkzeuge zum Einsatz kommen, um Missverständnissen vorzubeugen und die Qualität der wissenschaftlichen Kommunikation zu sichern. Zudem bedarf es einer stärkeren Sensibilisierung für die Risiken automatisierter Textgeneratoren. Forschende sollten verpflichtet sein, den von KI generierten Text kritisch zu hinterfragen, auf Korrektheit zu prüfen und nicht blind zu übernehmen. Verlage und Preprint-Plattformen könnten zudem durch den Einsatz von Detektionstechnologien helfen, potenziell problematische Manuskripte frühzeitig zu identifizieren und Nachbesserungen anzufordern. Der Vorfall bei Google ist auch ein Spiegelbild der aktuellen Debatte um die Rolle der Künstlichen Intelligenz in der Wissenschaft.

Wer darf verantwortlich sein für die Qualitätssicherung, wenn immer mehr Arbeitsschritte durch KI erledigt werden? Wie schützt man die Forschung vor einer Verwässerung durch „nonsensical“ Texte und Informationsverzerrung? Dies sind wesentliche Fragestellungen, die künftig sowohl ethisch als auch organisatorisch geklärt werden müssen. Der Fall von Anurag Awasthi zeigt, dass selbst Experten im Bereich KI nicht vor den Fallstricken einer unbedachten Verwendung automatisierter Texthilfen gefeit sind. Die Konsequenz der Preprint-Rücknahme ist ein wichtiger Präzedenzfall, der als Warnung an die wissenschaftliche Gemeinschaft zu verstehen ist: Der Einsatz von KI bedarf sorgfältiger Kontrolle, Offenlegung und Verantwortung. Die Wissenschaft durchlebt in Zeiten von KI eine Umwälzung. Potenziale zur Effizienzsteigerung sind groß, doch der Umgang mit Fehleranfälligkeiten und ethischen Fragen muss eindeutig geregelt sein.

Die Integrität wissenschaftlicher Veröffentlichungen bleibt das höchste Gut, das es zu schützen gilt – unabhängig davon, ob Texte von Menschen oder Maschinen verfasst werden. Abschließend unterstreicht der Fall die Notwendigkeit, dass sowohl Entwickler von KI-Technologien als auch die Nutzer aus Wissenschaft und Forschung zusammenarbeiten müssen, um Standards für den verantwortungsvollen KI-Einsatz zu etablieren. Nur durch einen solchen gemeinsamen Ansatz kann sichergestellt werden, dass Innovationen das Wissen bereichern, statt es zu verwässern oder Vertrauen zu untergraben. So zeigt der Rückzug des Preprints, dass Transparenz und Sorgfalt bei der Nutzung von KI im wissenschaftlichen Kontext unerlässlich sind – eine wertvolle Lehre für die gesamte Forschungsgemeinschaft.