Am 9. März 2025 wurde der Hosting- und Domainanbieter Gandi von einem bedeutenden technischen Zwischenfall erschüttert, der wesentliche Teile seiner Plattform betraf und zahlreiche Dienste, insbesondere die E-Mail-Postfächer, massiv beeinträchtigte. Dieses Ereignis war ein Weckruf für die gesamte Branche, da es deutlich machte, wie sensibel und verwundbar große Cloud-Infrastrukturen gegenüber Hardware-Ausfällen sein können. Im Folgenden soll eine umfassende Betrachtung des Vorfalls, seiner Ursachen, Auswirkungen und der nachhaltig eingeleiteten Maßnahmen erfolgen, um ein besseres Verständnis und wichtige Erkenntnisse für Betreiber und Nutzer von ähnlichen Plattformen zu vermitteln. Der Ausfall begann in den frühen Morgenstunden am Sonntag, dem 9.

März 2025, um exakt 0:31:10 UTC, als ein wesentlicher Speicher-SSD-Filer unerwartet ausfiel. Diese Speicherkomponente diente als zentrales Element für zahlreiche IT-Dienste bei Gandi, darunter auch das Mail-System, welches etwa 39 Prozent aller Benutzerpostfächer nachhaltig betraf. Durch den Defekt kam es zu einer massiven Störung, die bis zum Abend um 16:49:15 UTC andauerte. Während danach einige Postfächer zügig wieder erreichbar waren, blieben etwa 15 Prozent der Mailboxen bis zum darauffolgenden Montagvormittag um 10:29 Uhr offline. Die vollständige Wiederherstellung des E-Mail-Inhalts aller Nutzer konnte bis Mittwoch, den 12.

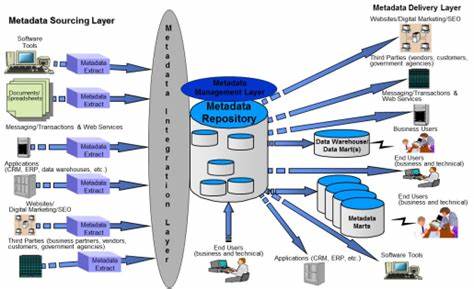

März um 17:00 Uhr, erfolgreich abgeschlossen werden. Zentral hervorzuheben ist, dass trotz der Schwere des Vorfalls weder Datenverlust noch Datenkorruption auftraten. Dies stellt einen wichtigen Erfolgsfaktor im Krisenmanagement dar und zeigt die Effektivität der Backups und Datenintegritätsmaßnahmen von Gandi. Dennoch offenbarte der Vorfall signifikante Schwachstellen in der Systemarchitektur und den Redundanzmechanismen, die letztlich den zeitlichen Umfang und die Schwere der Störung erklärten. Die Ursachenermittlung stellte sich als komplex heraus, weil sie nicht auf einen einzelnen Fehler zurückzuführen war.

Zwar war der unmittelbare Auslöser der Ausfall des SSD-Speicherfilers, doch trugen mehrere weitere strukturelle Probleme dazu bei, dass die Auswirkungen so schwerwiegend waren. Zum einen fehlte bei einigen kritischen Systemen, wie etwa dem internen Monitoring, eine effektive Redundanz, sodass sie nicht in der Lage waren, das Versagen des Speichers abzufangen. Zum anderen waren VMs, die eigentlich redundant ausgelegt waren, falsch konzipiert, da sämtliche Instanzen auf den gleichen ausgefallenen Speicher zurückgegriffen haben. Außerdem zeigte sich, dass bei Systemen mit redundanter VM- und Speicherarchitektur die Kapazitäten nicht ausreichend dimensioniert waren, um den erhöhten Lastanforderungen im Fehlerfall gerecht zu werden. Die Chronologie des Vorfalls illustriert eindrücklich die Herausforderungen im Incident Management eines solchen Ausmaßes.

Bereits kurz nach Auftreten des Problems wurden über 1500 Alerts generiert, die die On-Call-Teams sofort alarmierten. Die Problematik wurde durch den Ausfall des Monitoring-Bots zusätzlich erschwert, was die Identifikation der Fehlerquelle verlangsamte. Erst eine Stunde nach Beginn des Vorfalls wurde der Vorfall eskaliert und der CTO direkt eingebunden. Um 01:21 UTC erfolgte erstmals eine öffentliche Bekanntmachung der Situation mit Informationen zu den betroffenen Diensten. Mehrere Versuche, den ausgefallenen Speicher per Neustart zu reaktivieren, scheiterten zunächst.

Vor Ort mussten Techniker den Filer teilweise stromlos schalten, um ihn manuell wieder hochzufahren. Doch auch solche Maßnahmen wirkten sich nicht unmittelbar positiv aus. Die Probleme zogen sich mit Firmware-Updates und der Entfernung von potenziell fehlerhaften PCI-Komponenten bis in den Vormittag hinein. Erst am frühen Nachmittag konnten die meisten Dienste bis auf die Mailboxen wiederhergestellt werden. Das eigentliche Recovery der E-Mail-Postfächer dauerte noch bis zum nächsten Tag, während bis zum 12.

März sämtliche E-Mails vollständig rekonstruiert wurden. Ergänzend erschwert wurden die Arbeiten durch eine VPN-Störung, die den Zugriff von Support-Mitarbeitern auf wichtige interne Tools verhinderte. Zudem kam es zu Nachwirkungen wie Replikationsproblemen in der Quota-Datenbank, die für die Speicherplatzverwaltung bei Mailboxen verantwortlich ist. Diese führte wiederum zu teils unerwarteten Dienstunterbrechungen später in der Woche, wurde aber letztlich mit neuen Datenbankstrukturen und verbesserten Prozessen behoben. Die Analyse des Vorfalls machte klar, dass auch hochverfügbare Systeme ihre Schwachstellen haben können, wenn mehrere Sicherheitsmechanismen gleichzeitig versagen oder nicht optimal aufeinander abgestimmt sind.

Insbesondere zeigte sich, dass automatische Umschaltverfahren bei der Authentifizierung durch die spezielle Situation nicht wirkten, da die betreffenden Dienste zwar weiterhin erreichbar waren, aber nur in gefährdetem, aber nicht komplett ausgefallenem Zustand. Dies führte zu Verzögerungen und erschwerte die Koordination der Reaktionsprozesse. Als Reaktion auf den Vorfall ergriff Gandi umfangreiche Maßnahmen, um die Zuverlässigkeit und Belastbarkeit ihrer Infrastruktur erheblich zu verbessern. Unter anderem wurden alle Monitoring-Systeme mit zusätzlichen Redundanzen ausgestattet, um in Zukunft eine lückenlose Überwachung zu garantieren und frühzeitige Warnungen zu ermöglichen. Die Architektur der virtuellen Maschinen wurde überarbeitet, sodass automatische Abschaltungen bei Problemen auf bestimmten Speichersystemen implementiert wurden, um eine Verteilung der Last auf funktionierende Systeme sicherzustellen.

Um der Gefahr von Single Points of Failure entgegenzuwirken, werden Ressourcenzuweisungen nun auf mehrere Speicherfilers verteilt. Außerdem wurde der Wechsel des verwendeten Dateisystems von ZFS zu Ceph beschlossen, da letzteres bekanntlich robuster and skalierbarer im Umgang mit Hardware-Ausfällen ist. Neben diesen technischen Anpassungen wurden auch organisatorische Prozesse und Dokumentationen überarbeitet. Die Teams unterziehen sich nun regelmäßigen Übungen, die auch den Umgang mit kritischen Ausfällen der Authentifizierungs- und Netzwerksysteme einbeziehen. Zudem wurde das Personal im Bereich Incident Response speziell geschult und zusätzliche Kapazitäten geschaffen, um auch an Wochenenden und außerhalb der regulären Arbeitszeiten schnell einsatzbereit zu sein.

Der Vorfall vom 9. März 2025 hebt die Bedeutung einer durchdachten IT-Infrastruktur hervor, die nicht nur auf den ersten Blick hochverfügbar wirkt, sondern auch komplexe Ausnahmesituationen bewältigen kann. Die Kombination aus Hardwareschäden mit unzureichenden Redundanzen und einem Mangel an resilienten Prozessen führte bei Gandi zu einem weitreichenden Ausfall, der auch wichtige Backup- und Recovery-Prozesse herausforderte. Für Kunden von Gandi sowie andere Anbieter zeigt sich, wie wichtig es ist, nicht nur auf technische Maßnahmen zu vertrauen, sondern auch auf eine umfassende Strategie für den Notfall vorbereitet zu sein. Die proaktive Reaktion und schnelle Wiederherstellung der Dienste durch Gandi, verbunden mit den angekündigten Verbesserungen, bieten ein positives Beispiel, wie Unternehmen aus Rückschlägen lernen und ihre Systeme langfristig sicherer und stabiler gestalten können.

Abschließend verdeutlicht der Zwischenfall, dass auch Leader im Bereich Cloud Services und Hosting nicht vor unerwarteten Zwischenfällen geschützt sind. Die kontinuierliche Investition in Infrastrukturinnovationen, Mitarbeiterqualifikation und robuste Sicherheitsarchitekturen sind unerlässlich, um den steigenden Anforderungen an Verfügbarkeit und Datenschutz gerecht zu werden und das Vertrauen der Kunden zu erhalten. Die Erfahrungen aus dem März 2025 bleiben daher eine wichtige Lehre für die gesamte Branche und stellen einen wertvollen Impuls zur Weiterentwicklung moderner IT-Dienstleistungen dar.