In den letzten Jahren hat sich das Feld der Zeitreihenprognose grundlegend verändert. Weg von traditionellen statistischen Methoden wie ARIMA oder Prophet, hin zu sogenannten Foundation Models, die aus dem Bereich der großen Sprachmodelle (LLMs) inspiriert sind und komplexe, vielfältige Zeitreihendaten adaptiv und skalierbar vorhersagen können. Besonders in der Observability (O11Y), wo enorme Mengen an Telemetriedaten in Echtzeit verarbeitet werden, ist die Wahl des richtigen Modells essenziell, um präzise, verlässliche Prognosen ohne ständiges Nachtrainieren zu liefern. Zero-Shot Forecasting, also die Fähigkeit, Vorhersagen auf völlig neuen Datensätzen ohne zusätzliche Anpassung zu generieren, verspricht eine Revolution im Umgang mit Betriebsdaten. Der traditionelle Ansatz in der Zeitreihenanalyse verlangt die Entwicklung und Pflege vieler spezifischer Modelle für jede Datenquelle oder Metrik.

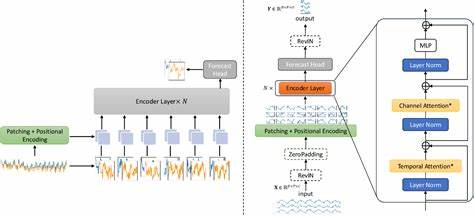

Bei einer Vielzahl von Microservices, Infrastrukturkomponenten oder unterschiedlichen Betriebskennzahlen kann das schnell unübersichtlich und ressourcenintensiv werden. Jede Änderung an der Datenquelle oder am Workload erfordert ein erneutes Feintuning oder sogar komplette Neutrainings, was nicht nur Zeit, sondern auch umfangreiche Expertise bindet. Foundation Models setzen hier an: Ein einziger großer, universell vortrainierter Algorithmus, der zeitliche Zusammenhänge und saisonale Muster über verschiedenste Domänen hinweg erlernt hat, kann neue Datenquellen quasi „on the fly“ interpretieren und realistische Vorhersagen liefern. In der Praxis stellen sich dabei zentrale Fragen: Wie robust sind diese Modelle bei plötzlichen Lastspitzen oder bei Fällen mit fehlenden Daten? Können sie Qualität, Genauigkeit und Performance klassischer Modelle nicht nur erreichen, sondern übertreffen? Und welche Kompromisse ergeben sich hinsichtlich Rechenleistung und Betriebskosten? Moderne Foundation Models wie Amazon Chronos, Google TimesFM, IBM Tiny Time-Mixers oder Datadog Toto verfolgen unterschiedliche technische Ansätze. Chronos basiert beispielsweise auf Transformern und ist für univariate sowie multivariate Daten optimiert, was besonders für komplexe Zielgrößen sinnvoll ist.

Google TimesFM hingegen lehnt sich stark an den Architekturen großer Sprachmodelle an, konzentriert sich aber hauptsächlich auf univariate Prognosen und bringt damit immense Rechenkraft mit Milliarden von Parametern ins Spiel. IBM fokussiert sich mit den Tiny Time-Mixers auf Effizienz und geringe Modellgrößen, ideal für Edge-Computing oder ressourcenschwache Umgebungen. Datadog hingegen hat mit Toto ein praxisorientiertes, multivariates Framework entwickelt, das speziell auf die Bedürfnisse moderner Infrastrukturüberwachung zielt und neben Genauigkeit auch Skalierbarkeit sicherstellt. Ein entscheidendes Kriterium für den erfolgreichen Vergleich dieser Modelle ist die Auswahl geeigneter Metriken. Für die Praxis in Observability-Setups hat sich die Mean Absolute Percentage Error (MAPE) als besonders aussagekräftig erwiesen.

MAPE ist intuitiv verständlich und erlaubt einen vergleichbaren Maßstab ineffiziente Vorhersagen, unabhängig von der Datenmagnitude oder Einheit. Beispielsweise bedeutet ein MAPE von 5 %, dass die Prognose im Durchschnitt bis auf fünf Prozent der tatsächlichen Werte genau ist. Diese Nachvollziehbarkeit ist gerade für SREs und Plattformingenieure wichtig, die Vorhersagen operationalisieren und erklären müssen. Natürlich sind auch weitere Werte wie RMSE oder sMAPE relevant, doch MAPE vereinfacht die Kommunikation der Vorhersagegüte wesentlich. Die zugrundeliegenden Datensätze beeinflussen die Evaluation stark.

In der Praxis wurden komplexe, multivariate Kubernetes-Podmetriken genutzt, die CPU-Auslastung, Speicherverbrauch und Antwortlatenzen umfassen. Solche Daten spiegeln realistische Herausforderungen wider: Schwankende Lasten, Ausfälle, fehlende Messwerte und verschiedene Zeitauflösungen fordern Modelle wirklich heraus. Vorverarbeitungsschritte wie Downsampling zur Reduzierung von Rauschen, Imputation von kurzen Lücken und Normalisierung durch Z-Score Verfahren gewährleisten faire Bedingungen und realistisches Handling der Messwerte. In den Benchmarks zeigten sich interessante Erkenntnisse. Datadog Toto glänzte durch herausragende Performance bei multivariaten Aufgaben und konnte klassische Verfahren wie Vector-ARIMA oft übertreffen – besonders in Szenarien, in denen Metriken stabil korreliert sind.

Amazon Chronos erwies sich als verlässlicher Generalist, der eine breite Palette von Anwendungen abdeckt, während IBM Tiny Time-Mixers durch bemerkenswerte Ressourcen-Effizienz bestachen. Hier zeigt sich, dass neben reiner Genauigkeit auch Betriebskosten und Hardwareanforderungen eine große Rolle spielen. Grundsätzlich zeigen Foundation Models eine beeindruckende Fähigkeit, kurze Ausreißer zu glätten und mit unvorhergesehenen Ereignissen besser umzugehen als klassische Varianten. Allerdings sind sie nicht unfehlbar: Gerade bei rasant wechselnden oder komplett neuen Betriebszuständen können klassische Modelle mit rechtzeitiger Anpassung manchmal noch punkten. Dennoch bietet die Kombination aus Zero-Shot-Fähigkeiten und Transferlernen eine neue Perspektive, die das Modellmanagement in Observability-Stacks radikal vereinfachen kann.

Praktisch bedeutet dies, dass Teams, die viele wechselnde Datenquellen mit komplexen Abhängigkeiten überwachen, erheblich von Foundation Models profitieren können. Die Vielzahl an manuell zu trainierenden Einzelmodellen schrumpft zusammen, Wartungsaufwand und Betriebskosten lassen sich senken, und Einblick in unterschiedliche Metriken entfaltet sich viel schneller. Neben der reinen Modellleistung ist auch die Verfügbarkeit offener Lizenzen wie Apache 2.0 ein wichtiger Faktor, um Foundation Models in der operativen Realität zu verankern. In Summe sind Foundation Models kein Allheilmittel, aber eine klare technologische Weiterentwicklung im Bereich der Zeitreihenprognose für Observability.

Sie ergänzen klassische Werkzeuge sinnvoll und bieten insbesondere für dynamische, komplexe und große Umgebungen neue Chancen. Die Beobachtung der Entwicklung und weitere praktische Tests in produktionsnahen Umgebungen werden zeigen, wie sich diese Modelle langfristig etablieren. Für alle SREs, Plattformentwickler und Data Engineers empfiehlt es sich, die Potenziale von Zero-Shot Forecasting jetzt aktiv auszuloten und in eigenen Projekten zu evaluieren. Die Zukunft der Observability ist also nicht nur automatisiert, sondern auch intelligenter und adaptiver. Foundation Models verheißen eine neue Zeit, in der das Management von Telemetriedaten nicht mehr an den zahllosen Einzelheiten der Modellpflege scheitert, sondern durch vereinheitlichte, skalierbare und robuste Systeme verlässlich unterstützt wird.

Wer heute in die Erprobung der besten Foundation Models investiert, sichert sich einen Innovationsvorsprung in der effizienten Betriebsüberwachung von morgen.