Der Bereich der Datenbanksysteme durchläuft kontinuierliche Innovationen, die besonders im analytischen Datenbanksektor (OLAP) sichtbar sind. Die Carnegie Mellon University setzt mit ihrem Kurs 15-721 Advanced Database Systems Maßstäbe darin, wie Studierende und Fachleute tiefgehendes Wissen über modernste Techniken und Systeme erwerben können. Der zweite Teil des Kurses im Jahr 2024 fokussiert sich hauptsächlich auf reale OLAP-Systeme, die aktuell die Industrie prägen und die Entwicklung großer Dateninfrastrukturen vorantreiben. Ein spezieller Schwerpunkt liegt auf den Technologien von Firmen wie Databricks, Snowflake, DuckDB, Yellowbrick und AWS Redshift. Diese Unternehmen gestalten den Datenbankmarkt maßgeblich und bieten spannende Einblicke in die moderne Datenverwaltung und -analyse.

Databricks hat seinen Ursprung als Cloud-Service, der auf Apache Spark basiert. Spark selbst ist eine in Java geschriebene Analysesoftware, die jedoch aufgrund der Java Virtual Machine (JVM) Einschränkungen bei der Speicherverwaltung hat. Diese Limitierungen führten bei Databricks zur Entwicklung von „Photon“, einer nativen C++-Engine, die darauf ausgelegt ist, Abfragen auf Rohdaten in Data Lakes effizienter zu verarbeiten. Die Architektur von Photon beinhaltet wesentliche Merkmale wie Shared-Disk-Design oder disaggregierten Speicher, vektorbasierte Abfrageverarbeitung mit Pull-Mechanismen, vorkompilierte Operator-Kerne und sogenannte Expression Fusion, bei der häufig gemeinsam vorkommende Operatoren zu effizienteren Einheiten zusammengefasst werden. Ein Vorteil dieses Ansatzes ist die Vermeidung komplexer Codegenerierung, was die Wartbarkeit und das Debugging des Systems erleichtert, ohne dabei wesentliche Einbußen bei der Performance hinzunehmen.

Insgesamt zeigt Photon, wie fortschrittliche Abfrageoptimierung neu gedacht werden kann, um Skalierbarkeit und Effizienz in Data Lakes zu verbessern. Snowflake steht als weiterer Branchenführer für innovatives Data Warehousing. Das System überzeugt mit ausgefeilten Abfrageoptimierungstechniken, die ebenfalls auf vorkompilierte Operatoren setzen. Charakteristisch ist die klare Trennung von Metadaten und Daten: Metadaten werden in FoundationDB verwaltet, wodurch hohe Konsistenz und Performance gewährleistet werden können. Auffällig ist auch der Verzicht auf einen klassischen Buffer-Pool und die Verwendung des PAX-Formats (Partition Attributes Across) für die Spaltenorientierung, was auch für ihre Unterstützung von Apache Iceberg relevant ist.

Snowflake kombiniert Sortier- und Hash-Join-Strategien in einer einheitlichen, adaptiven Abfrageoptimierung. Die Verarbeitung erfolgt durch eine push-basierte, vektorisierte Pipeline, die moderne Hardware bestmöglich ausnutzt. Neben rein technischer Exzellenz hebt sich Snowflake durch Zusatzdienste wie Snowpark und Snowpipe hervor, die Entwicklern und Data-Engineer-Teams flexible und skalierbare Werkzeuge für Datenpipelines und Integration bieten. Die Vergleichbarkeit der reinen Abfrageperformance mit anderen Anbietern zeigt, dass der Wettbewerb zunehmend auf Benutzerfreundlichkeit, Entwicklererfahrung und Sicherheitsfunktionen verschoben wird. DuckDB verfolgt einen anderen Ansatz als die bislang genannten cloud-nativen Plattformen.

Es handelt sich um eine eingebettete analytische Datenbank, die besonders bei Data Scientists und Dateningenieuren aufgrund ihrer Leichtgewichtigkeit und Benutzerfreundlichkeit beliebt ist. Seit seiner Gründung im Jahr 2017 wurde DuckDB in C++ entwickelt und bietet eine push-basierte, vektorisierte Abfrageausführung, die sehr performant und ressourcenschonend ist. Neben vorkompilierten Operatoren setzt DuckDB auf Morsel-Parallelismus, wodurch parallele Verarbeitungseinheiten flexibel geplant und ausgeführt werden können. Das Speichermodell basiert ebenfalls auf PAX, was schnelle analytische Abfragen ermöglicht. Besonders hervorzuheben ist der stratifizierte Abfrageoptimierer, der komplexe Subqueries und unnesting effizient behandelt – ein Merkmal, das nur wenige andere Systeme, wie zum Beispiel Umbra, auf diesem Level beherrschen.

Mit einem modularen Design, das lokale und ferngesteuerte DuckDB-Instanzen über Bridge-Operatoren koppelt, adressiert das Projekt Motherduck zukünftig auch skalierbare Cloud-Nutzungsszenarien. Während Yellowbrick und AWS Redshift im Überblick weniger detailliert behandelt wurden, sind beide Systeme in der Branche als etablierte Cloud-Datawarehouses bekannt, die ebenfalls moderne Prinzipien der verteilten, spaltenorientierten und vektorbasierten Verarbeitung integrieren. Redshift profitiert zudem von der starken Integration mit anderen AWS-Diensten und einem hohen Automatisierungsgrad in der Speicher- und Ausführungsverwaltung. Ein entscheidender Trend, der sich schon in früheren Vorlesungsteilen und auch im aktuellen Kursabschnitt immer deutlicher abzeichnet, ist die zunehmende Commodityisierung von Kerntechnologien der OLAP-Datenbanken. Viele der heute eingesetzten Performance- und Optimierungsmethoden befinden sich mittlerweile auf einem ähnlich hohen und vergleichbaren Niveau – beispielsweise vektororientierte Verarbeitung, adaptive Abfrageoptimierung und hybride Join-Verfahren sind inzwischen Standard in den meisten großen Systemen.

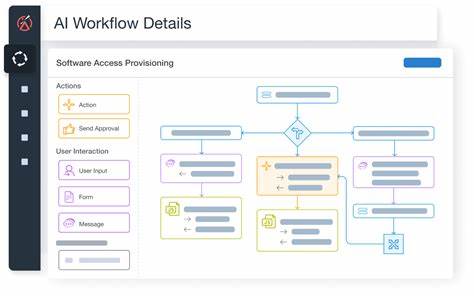

Die technische Leistung der Query-Engines wird dabei zunehmend austauschbar. Infolgedessen verlagert sich der Wettbewerb in der Datenbanklandschaft immer mehr auf andere Bereiche. Die Nutzererfahrung (User Experience, UX), die Entwicklerfreundlichkeit (Developer Experience, DevEx), sowie Sicherheitsmerkmale, Preisgestaltung und funktionale Erweiterungen wie Workflow-Engines und ingest Pipeline Management werden zu Differenzierungsmerkmalen. Dies spiegelt eine Reifephase des Marktes wider, in der reine technische Innovation ergänzt wird durch eine Fokussierung auf betriebliche Effizienz, Skalierbarkeit und Anwenderorientierung. Ein weiterer technischer Aspekt, der im Kurs rege diskutiert wurde und in Zukunft wohl von großer Bedeutung sein wird, ist die Rolle von offenen Datenformaten wie Apache Iceberg.

Diese ermöglichen flexible, verteilte Datenhaltung mit starken Konsistenzgarantien und werden zunehmend bei führenden OLAP- und Data-Lake-Systemen eingesetzt. Die Integration solcher Standards trägt maßgeblich zu plattformübergreifender Kompatibilität und interoperablen Datenökosystemen bei. Der CMU 15-721 Advanced Database Systems Kurs bietet mit dieser Ausrichtung auf realweltliche Systeme wertvolle Einblicke in die aktuelle Datenbankforschung und angewandte Ingenieurskunst. Die Vermittlung erfolgt unter anderem durch Andy Pavlo, einen etablierten Experten auf diesem Gebiet, der mit unterhaltsamem Vortragsstil und hoher fachlicher Tiefe überzeugt. Teilnehmer profitieren nicht nur von theoretischem Wissen, sondern erhalten auch praxisnahe Einschätzungen zu den Architekturen und Designentscheidungen, die weltweit eingesetzten Datenbanksystemen zugrunde liegen.

Abschließend lässt sich festhalten, dass fortschrittliche Datenbanksysteme heute keine reine Frage der Rohleistung mehr sind. Vielmehr entsteht ein ganzheitlicher Wettbewerb, der technologische Exzellenz mit vertrauenswürdigen Cloud-Diensten, benutzerfreundlichen Entwicklungswerkzeugen und umfassenden Sicherheitskonzepten verbindet. Für Fachleute und Unternehmen bleibt es unerlässlich, diese Entwicklungen genau zu verfolgen, um datengetriebene Entscheidungen und Anwendungen effizient zu gestalten. Das Wissen aus Kursen wie CMU 15-721 liefert dafür eine hervorragende Basis und zeigt zugleich, wohin die Reise in der Welt der Datenbanktechnologien gehen wird.