In der digitalen Welt von heute spielt künstliche Intelligenz (KI) eine immer größere Rolle. Vom Content-Erstellen über Wettbewerbsanalysen bis hin zur Marktforschung – KI-basierte Werkzeuge setzen auf das Crawlen und Sammeln großer Mengen an Webinhalten, um relevante Daten zu generieren. Doch dieser Trend bringt nicht nur Chancen, sondern auch erhebliche Herausforderungen mit sich. Gary Illyes, ein bekannter Google-Ingenieur im Bereich Search Relations, hat kürzlich eindringlich davor gewarnt, dass die zunehmende Flut von KI-Agenten und automatisierten Bots eine Überlastung des Webs verursachen wird. Die damit einhergehende Web-Kongestion stellt einen bedeutenden Entwicklungspunkt dar, der die Art und Weise, wie Webseiten betrieben und optimiert werden, grundlegend verändern könnte.

Illyes erklärt, dass die Web-Infrastruktur technisch zwar für sehr hohen Traffic ausgelegt ist und das Web selbst mit erheblichen Datenvolumen umgehen kann. Dennoch sind die steigenden Anforderungen seitens zahlreicher KI-Anwendungen und Tools ein neuer Belastungsfaktor. Immer mehr Unternehmen und Entwickler setzen auf KI-gesteuerte Crawler, die automatisiert Websites durchsuchen, um Inhalte zu analysieren, extrahieren und weiterzuverarbeiten. „Everyone and my grandmother is launching a crawler“, so Illyes auf einem Podcast-Interview mit seinem Kollegen Martin Splitt. Die Präsenz dieser Vielzahl automatisierter Zugriffe führt unweigerlich zu einem Wachstum des Datenverkehrs, der bei vielen Servern zu Engpässen und Performance-Einbußen führen kann.

Dabei stellt Illyes klar, dass das Crawlen selbst nicht die Hauptursache für Ressourcenbelastungen auf Webseiten ist. Im Gegensatz zur verbreiteten SEO-Meinung verursachen die reinen HTTP-Anfragen zum Abrufen von Inhalten verhältnismäßig wenig Aufwand. Der eigentliche Ressourcenverbrauch liegt laut Illyes im Bereich der Datenverarbeitung und Speicherung. Wenn tausende oder gar millionenfache Zugriffe erfolgen, entsteht ein hoher Aufwand beim Indexieren, Verarbeiten und Abspeichern der Informationen. Gleichzeitig steigen die Anforderungen an Datenbanken und Serverkapazitäten, wodurch die Infrastruktur stark beansprucht wird.

Die Konsequenz daraus ist klar: Webseitenbetreiber müssen sich jetzt auf die kommenden Herausforderungen vorbereiten. Zentrale Säulen dieser Vorbereitung sind die Optimierung der Serverinfrastruktur, die Anpassung der Zugriffsregeln und die Verbesserung der Datenbank-Performance. Im Bereich Hosting gilt es, die Serverkapazitäten kritisch zu überprüfen. Die Erhöhung der Bandbreite und die Nutzung von Content Delivery Networks (CDNs) können helfen, den ansteigenden Traffic besser zu bewältigen und Latenzen zu minimieren. Gerade bei hohem Datenaufkommen sorgen CDNs für eine Verteilung der Last, indem Inhalte über ein globales Netzwerk lokaler Server ausgeliefert werden.

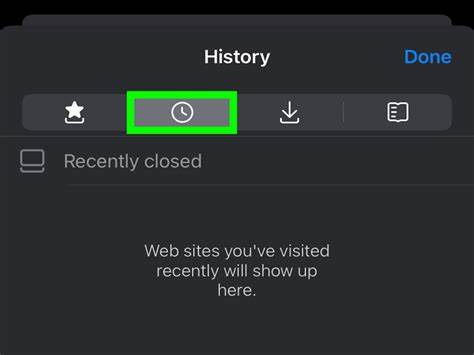

Zusätzlich helfen moderne Protokolle wie HTTP/2 und in Zukunft HTTP/3 dabei, Verbindungen effizienter zu gestalten und die Serverkommunikation zu beschleunigen, was insbesondere bei vielen gleichzeitigen Zugriffen von Vorteil ist. Ein weiterer wichtiger Punkt betrifft die robots.txt-Datei, mit der Webseitenbetreiber steuern können, welche Crawler Zugriff auf welche Bereiche ihrer Website erhalten. Mit einer gezielten Konfiguration lassen sich unnötige Zugriffe, vor allem von unerwünschten oder schädlichen Bots, vermeiden. Auf diese Weise können Ressourcen geschont und der Server entlastet werden.

Bei der wachsenden Zahl von KI-Agenten ist eine klare Strategie wichtig, um legitime Bots zuzulassen und gleichzeitig potenzielle Störer auszusperren. Die Datenbank-Optimierung spielt eine ebenso zentrale Rolle. Illyes hebt insbesondere „teure Datenbankabfragen“ als häufigen Engpass hervor, der bei intensiven Crawl-Aktivitäten zu Leistungseinbußen führt. Webseitenbetreiber sollten ihre Datenbankabfragen analysieren und diese wenn möglich vereinfachen. Das Implementieren von Caching-Mechanismen verhindert, dass wiederholt dieselben Daten berechnet oder geladen werden müssen, und erhöht die Effizienz spürbar.

Gerade bei besonders großen Websites mit umfangreichen Inhalten kann eine optimale Datenbankstruktur zusammen mit effizienten Abfragen den Unterschied zwischen einem reibungslos laufenden Service und einer überlasteten Website ausmachen. Zur Überwachung des Verkehrs empfiehlt sich zudem eine differenzierte Analyse der Zugriffe. Hier gilt es, legitime Google-Crawler von KI-Agenten und möglicherweise bösartigen Bots zu unterscheiden. Präzise Log-Analysen und Monitoring-Werkzeuge helfen, Verkehrsmuster zu erkennen, Auffälligkeiten frühzeitig zu entdecken und die eigene Webseite proaktiv zu schützen. Google setzt selbst auf eine einheitliche Crawler-Infrastruktur, die für verschiedene Produkte – etwa Google Search, AdSense oder Gmail – genutzt wird.

Diese gemeinsame Infrastruktur arbeitet mit unterschiedlichen User-Agent-Strings, hält jedoch eine strikte Einhaltung der robots.txt-Richtlinien und eine Rücksichtnahme auf die Servergesundheit ein. So versucht Google, den Crawl-Traffic effizient zu organisieren und die Belastung für Webserver zu minimieren. Doch im Gegensatz dazu verzeichnen Websites mittlerweile eine Vielzahl von isolierten, häufig ineffizient arbeitenden KI-Crawlern, die oft die gleichen Inhalte mehrfach abrufen. Dies führt zu redundanten Datenzugriffen und erhöht den Druck auf Server.

Interessanterweise verweist Illyes auf das Projekt Common Crawl als potenzielles Modell für die Zukunft. Common Crawl aggregiert und verarbeitet Webdaten einmalig und stellt diese umfangreichen Datensätze öffentlich zur Verfügung. Solche kollaborativen Ansätze reduzieren redundante Crawlvorgänge, weil mehrere KI-Projekte auf dieselben Datensätze zurückgreifen können. Für das Ökosystem wäre eine verstärkte Zusammenarbeit und Datenfreigabe ein potenzielles Mittel, der weiteren Webüberlastung entgegenzuwirken. Die digitale Landschaft wächst ungeheuer schnell.

In den 90er Jahren waren Websites mit wenigen tausend Seiten eine Seltenheit. Heute zählt es zur Normalität, dass einzelne Webseiten Millionen von Unterseiten umfassen. Datenmengen und Anforderungen steigen mit dieser Entwicklung kontinuierlich. Illyes betont, dass Verbesserungen in Protokollen, Infrastruktur und Webtechnik zwar für mehr Geschwindigkeit und Effizienz sorgen, die neue Dimension an KI-Einsatz aber gleichzeitig zusätzliche Belastungen mit sich bringt. Die ständige Balance zwischen Effizienzgewinnen und neuen Anforderungen gleicht einem Wettlauf, der nie endet.

Für Website-Betreiber bedeutet das, dass das Ignorieren dieser Veränderungen keine Option ist. Das frühzeitige Anpassen und Erweitern von Hosting-Leistungen, das saubere Steuern des Zugriffs über robots.txt, die Optimierung von Datenbankabfragen und ein kontinuierliches Monitoring sind unverzichtbar. Wer hier jetzt investiert, spart sich später große Probleme und stellt sicher, dass die eigene Website auch bei stark steigenden automatisierten Zugriffen stabil bleibt. Letztlich unterstreicht Gary Illyes in seiner Warnung, dass die anstehende Welle von KI-Agenten keineswegs den Untergang des Webs bedeutet.

Vielmehr handelt es sich um einen evolutionären Schritt, der neue Herausforderungen, aber auch Chancen bringt. Die Zukunft gehört Websites, die ihre Infrastruktur strategisch optimieren und sich proaktiv auf die neue Realität vorbereiten. So können sie den wachsenden Anforderungen erfolgreich begegnen und von der zunehmenden Bedeutung KI-gestützter Technologien profitieren – ohne im Datenverkehr unterzugehen.

![OAuth 2.0: A Big Messy Standard and How OAuth 2.1 Aims to Fix It [video]](/images/0848E379-6B83-4D25-A2A5-51D2A3543C69)