Die rasante Entwicklung großer Sprachmodelle (LLMs) wie GPT, BERT oder PaLM hat die Forschung im Bereich der Künstlichen Intelligenz maßgeblich beeinflusst. Um diese fortschrittlichen Modelle effektiv zu bewerten, sind präzise und aussagekräftige Benchmark-Methoden unverzichtbar. Ein innovativer Ansatz in diesem Kontext ist die Nutzung psychometrisch abgeleiteter Benchmarks, die eine neue Dimension der Validierung und Effizienzmessung bieten. Dabei geht es nicht nur um die reine Leistungsfähigkeit in Aufgaben der natürlichen Sprachverarbeitung, sondern auch um den Vergleich der künstlichen Intelligenz mit menschlichen Kompetenzen. Diese Herangehensweise eröffnet tiefere Einblicke in die Stärken und Schwächen heutiger Sprachmodelle und fördert die Entwicklung intelligenter Systeme, die menschliches Denken besser nachvollziehen können.

Psychometrie als Wissenschaft beschäftigt sich mit der Messung psychologischer Merkmale, Fähigkeiten und Leistungsniveaus. Ihre Methoden sind seit Jahrzehnten in der Pädagogik, Psychologie und Personaldiagnostik etabliert, um beispielsweise IQ, kognitive Fähigkeiten und Wissen strukturiert zu erfassen und vergleichbar zu machen. Die Übertragung dieser Methodik in die KI-Forschung hat den Vorteil, dass Benchmarks nicht nur auf rein technische Parameter wie Genauigkeit oder Rechenzeit reduziert werden, sondern auf tiefere, menschlich relevante Leistungsdimensionen abzielen. Dadurch lassen sich große Sprachmodelle anhand ihrer Fähigkeit bewerten, komplexe sprachliche und kognitive Anforderungen zu erfüllen – ähnlich dem, wie man menschliche Intelligenz misst. Psychometrisch abgeleitete Benchmarks im Bereich der LLMs gehen über traditionelle Testverfahren hinaus.

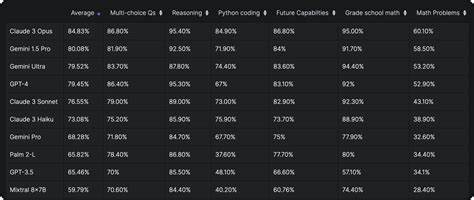

Sie basieren nicht nur auf standardisierten Datensätzen mit klassischer Aufgabenlösung, sondern erfassen beispielsweise auch den Schwierigkeitsgrad einzelner Aufgaben, die Antworttrennschärfe und andere klassische psychometrische Kennwerte. Dies führt zu einer präziseren Einschätzung, wie gut ein Modell bestimmte kognitive Anforderungen erfüllt. Zum Beispiel kann ein Benchmark so gestaltet sein, dass er differenziert beurteilt, ob ein Sprachmodell nicht nur simple Fakten wiedergeben kann, sondern auch komplexe Schlussfolgerungen zieht, ironische oder metaphorische Sprache versteht oder Mehrdeutigkeiten auflöst – alles Aspekte, die psychometrisch erfasst werden können. Die Effizienz von LLMs in diesen Benchmark-Umgebungen wird dabei nicht nur in Bezug auf die Antwortqualität bewertet, sondern auch hinsichtlich der erforderlichen Rechenressourcen und der Verarbeitungsgeschwindigkeit. Psychometrisch fundierte Benchmarks erlauben es somit, das Verhältnis von Leistung zu eingesetztem Aufwand zu messen und helfen Forschenden bei der Identifikation effizienter Modelle, die trotz geringerer Ressourcen komplexe Aufgaben lösen.

Dies spielt insbesondere in Bereichen mit begrenzten Hardware-Ressourcen oder hohem Energieverbrauch eine entscheidende Rolle. Eine weitere spannende Anwendung dieser Benchmarks besteht im direkten Vergleich der KI-Leistung mit menschlicher kognitiver Performance. Hierbei können psychometrische Tests genutzt werden, um beispielsweise Intelligenzquotienten oder Problemlösefähigkeiten auf beiden Seiten – Mensch und Maschine – zu erfassen. Solche Vergleiche sind wertvoll, um zu verstehen, in welchen Bereichen KI möglicherweise übertrifft, wo sie noch Defizite hat und wie das menschliche Denken differenziert und flexibel bleibt. Gleichzeitig bieten sie Orientierungspunkte für die Weiterentwicklung von LLMs, insbesondere in Bezug auf Generalisierungsfähigkeit und semantisches Verständnis.

Im Rückblick zeigen erste Studien zu psychometrisch abgeleiteten Benchmarks, dass Sprachmodelle auf bestimmten Aufgaben menschliches Niveau erreichen oder sogar übertreffen können, etwa bei rein faktischem Wissen oder der Mustererkennung in Textströmen. In anderen Domänen wie kritischem Denken, emotionalem Verstehen oder tiefgreifender Textinterpretation sind die Modelle jedoch noch limitiert. Diese Erkenntnisse helfen nicht nur dabei, Forschung und Entwicklung gezielter auszurichten, sondern auch ethische Fragen zu adressieren, etwa den Umgang mit KI-Entscheidungen in sensiblen Kontexten. Auch die Dynamik zwischen Effizienz und Leistung bleibt ein zentrales Thema. Hochkomplexe Modelle erzielen oft bessere Ergebnisse, benötigen aber enorme Rechenleistung und Datenmengen.

Psychometrische Benchmarks ermöglichen es, hier eine optimierte Balance zu finden, die das Ziel verfolgt, mit möglichst geringem Aufwand möglichst hohe kognitive Leistungen zu erzielen. Dies führt zu zwei wichtigen Tendenzen: Zum einen zur Entwicklung spezialisierter Modelle, die auf bestimmte Aufgaben zugeschnitten sind und dort maximale Effizienz abrufen, zum anderen zum Trend hin zu multimodalen, generalisierten Modellen, die breiter aufgestellt sind, aber ressourceneffizient bleiben müssen. Zukunftsorientiert stellen psychometrisch abgeleitete LLM-Benchmarks einen wichtigen Baustein dar, um Fortschritte in der KI-Forschung systematisch zu messen und verantwortungsvoll zu steuern. Sie tragen zu einem besseren Verständnis darüber bei, wie künstliche Intelligenz menschliche Denkprozesse ergänzt, simuliert oder in manchen Bereichen sogar herausfordert. Darüber hinaus bieten sie substanzielle Grundlagen für die Praxis, sei es in der Softwareentwicklung, im Bildungsbereich, bei der Automatisierung komplexer Prozesse oder im Bereich der gesellschaftlichen Akzeptanz von KI-Systemen.

Insgesamt lässt sich festhalten, dass die Integration psychometrischer Methoden in die Benchmarkings von großen Sprachmodellen ein vielversprechender Ansatz ist, um die Kluft zwischen technischer Leistung und menschlicher kognitiver Fähigkeit zu überwinden. Die gewonnenen Erkenntnisse führen zu effizienteren, adaptiveren und verständlicheren KI-Systemen, die besser auf die realen Anforderungen menschlicher Kommunikation und Problemlösung reagieren können. So gestaltet sich die Zukunft der KI-Forschung als eine kohärente Verbindung von technischem Fortschritt und psychologisch fundierter Evaluation – zum Nutzen von Wissenschaft, Wirtschaft und Gesellschaft.