Die rasante Entwicklung der Künstlichen Intelligenz und großer Sprachmodelle (Large Language Models, LLMs) verändert die Welt der Softwareentwicklung grundlegend. Unternehmen stehen vor der Herausforderung, ihre APIs für diese neuen AI-nativen Nutzer zugänglich und effizient nutzbar zu machen. Dabei rückt das Model Context Protocol (MCP) zunehmend in den Fokus als moderner Standard für strukturierte Eingaben und Interaktionen mit LLMs. Besonders spannend für Entwickler und Firmen, die bereits stark auf gRPC setzen: Es gibt jetzt praktische Möglichkeiten, jeden bestehenden gRPC-Dienst schnell und unkompliziert in einen vollwertigen MCP-Server umzuwandeln. Dies bedeutet, dass die bestehende Infrastruktur und das API-Design nicht komplett neu gedacht werden müssen.

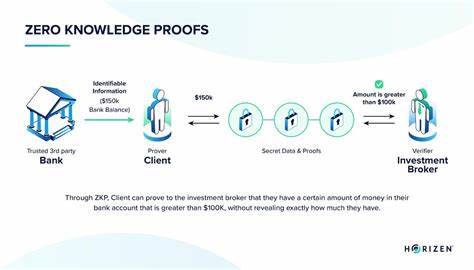

Stattdessen erlaubt eine clevere Verbindung von Protobuf-Codegenerierung und Open-Source-Tools eine nahtlose Brücke zwischen gRPC und MCP. Doch was genau steckt hinter dem Begriff MCP und warum gewinnt diese Technologie so schnell an Bedeutung? MCP wurde von Anthropic im November 2024 ins Leben gerufen. Es handelt sich dabei um ein Protokoll, das speziell entwickelt wurde, um große Sprachmodelle mit gut strukturierten, klar definierten Eingaben zu versorgen. MCP teilt sich in eine Client- und eine Server-Komponente. Der Client ist dabei die Anwendung oder das Tool, mit dem Nutzer interagieren, etwa ein AI-Agent oder ein Desktop-Programm wie Claude.

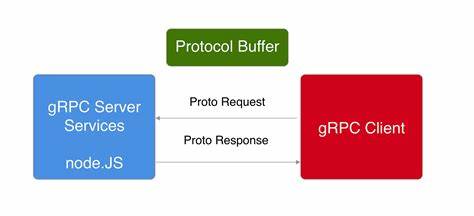

Der Server stellt die eigentlichen Funktionen und Datenquellen bereit, die der Client für verschiedenste Zwecke ansprechen kann – vom Zugriff auf eine Datenbank bis hin zur komplexen Verwaltung von Cloud-Infrastrukturen. Für moderne SaaS-Unternehmen wird MCP so zum entscheidenden Schlüssel, um APIs intelligent und AI-freundlich zugänglich zu machen. Dass gRPC als robustes, stark typisiertes Framework mit Protobuf-Unterstützung heute schon ein Standard für viele API-Designs ist, macht die Kombination mit MCP besonders attraktiv. gRPC beeindruckt mit seinem Bottom-up-Ansatz bei der API-Definition, umfangreicher Code-Generierung und Mehrsprachigkeit der Clients und Server. Redpanda Cloud, ein führendes Unternehmen im Bereich Daten-Streaming, nutzt intensiv gRPC und ConnectRPC für seine API-Implementierungen.

Um mit der Entwicklung im Bereich AI und LLMs Schritt zu halten, hat Redpanda ein innovatives Tool entwickelt, das mit minimalem Aufwand jeden gRPC-Service automatisch in einen MCP-Server verwandelt. Dieses Tool heißt protoc-gen-go-mcp und ist ein Protobuf-Compiler-Plugin, das Go-Code generiert. Mit diesem Code wird die Kommunikation übersetzt und ermöglicht so, dass MCP-Clients direkt mit gRPC-Diensten kommunizieren können. Die Vorteile liegen auf der Hand: API-Anbieter müssen keinen umfangreichen, manuell programmierten Übersetzungscode schreiben, der MCP-Anfragen verarbeitet. Stattdessen erzeugt der neueste Protobuf-Compiler automatisch passende MCP-Handler für alle definierten Services.

Zusätzlich generiert das Tool JSON-Schemata für die Eingabedaten jener Methoden, was die Validierung stark vereinfacht und die Entwicklung von AI-Agenten erleichtert. Ein weiterer Pluspunkt ist die volle Kompatibilität mit ConnectRPC, einem modernen Ableger von gRPC, der sich besonders durch eine einfache Web-Integration auszeichnet. Die Integration von protoc-gen-go-mcp in bestehende Entwicklungszyklen ist dank Buf, einem Framework zur Verwaltung und Validierung von Protobuf-APIs, ebenfalls sehr einfach. Dies ermöglicht es Teams, die aktuell mit gRPC arbeiten, ihre Dienste Schritt für Schritt MCP-fähig zu machen, ohne ihre Infrastruktur zu überholen oder komplett neue Technologien einzuführen. Wie sieht der praktische Ablauf aus? Angefangen wird mit der bestehenden .

proto-Datei, in der die API-Schnittstellen definiert sind. Läuft protoc-gen-go-mcp darüber, werden neue Dateien mit der Endung .pb.mcp.go generiert.

Diese enthalten die automatisch erstellten Funktionen, die eine Verbindung zwischen MCP-Anfragen und gRPC-Client-Stubs herstellen. Im Code sieht das so aus, dass ein zentraler Struct, beispielsweise CloudClientSet, verschiedene gRPC-Clients für unterschiedliche Servicebereiche wie Cluster, Netzwerk, Organisationen und mehr bündelt. Die generierte MCP-Bibliothek liefert dann Funktionen wie ForwardToConnectXYZServiceClient, die die Anfragen vom MCP-Server an die richtigen gRPC-Methoden weiterleiten. Das spart enorm viel Entwicklungszeit und reduziert Fehlerquellen, die bei manuellem Mapping häufig auftreten. Redpanda Cloud geht sogar noch einen Schritt weiter und macht das Ganze für den Endnutzer erlebbar: Über die Integration mit Claude Desktop, einem beliebten MCP-Client für LLM-Interaktionen, lässt sich der MCP-Server via stdio (Standard Input/Output) starten und direkt nutzen.

So können Anwender mit natürlicher Sprache komplexe Operationen an der Cloud durchführen – von der Erstellung serverloser Cluster bis zur Änderung von Netzwerkkonfigurationen – ohne dabei mit der darunterliegenden API in Berührung zu kommen. Claude zeigt den Nutzern dabei sogar, wie viele Tools bzw. API-Endpunkte verfügbar sind, und verwaltet Zugriffsrechte, um Missbrauch vorzubeugen. Die Implementierung über stdio ist momentan die verbreitetste Methode zur Kommunikation zwischen MCP-Client und -Server, da sie leicht und effektiv ist. Andere Kommunikationsmodi wie HTTP mit Server-Sent Events existieren zwar, setzen sich aber bisher kaum durch.

Die Kombination aus protoc-gen-go-mcp und dem CLI-Tool rpk von Redpanda macht diese moderne API-Erfahrung für Entwickler und Nutzer besonders einfach. Während rpk die Authentifizierung und Konfiguration verwaltet, erledigt das Compiler-Plugin die harte Arbeit der Codegenerierung für die MCP-Integration. Entwickler können so mit minimalem Aufwand ihre API ökosystemfreundlich und AI-fähig gestalten und gleichzeitig bestehende Investitionen in gRPC nutzen. Für SaaS-Anbieter eröffnet sich dadurch ein spannender Weg, ihre Plattformen zukunftssicher und kompatibel mit der wachsenden Anzahl von AI-Agenten zu machen. Gerade wer in der AI- und Streaming-Datenwelt mitspielen möchte, profitiert von der automatisierten Transformation der API-Schnittstellen.

Das offene Lizenzmodell von protoc-gen-go-mcp (Apache 2.0) und die aktive Einbindung in die Entwicklungs-Community schaffen Raum für schnellen Fortschritt und breite Akzeptanz. Die Entwickler-Community profitiert zudem vom regelmäßigen Erfahrungsaustausch, vor allem im Redpanda Slack, wo Fachleute aus Daten-Streaming und AI direktes Feedback geben und Lösungen diskutieren. Dieses Zusammenspiel zeigt exemplarisch, wie sich moderne Softwarearchitektur dynamisch an technologische Neuerungen anpassen kann. Die Zukunft der API-Entwicklung liegt dabei in Protokollen wie MCP, die klar strukturierte und gut typisierte Kommunikation erlauben und somit die Brücke zwischen klassischen Backend-Diensten und fortschrittlicher AI bilden.