Kubernetes hat sich in den letzten Jahren klar als der De-facto-Standard im Bereich der Container-Orchestrierung etabliert. Dabei ist das Ökosystem rund um Kubernetes äußerst umfangreich und bietet vielfältige Möglichkeiten, Anwendungen skalierbar und zuverlässig zu betreiben. Dennoch ist Kubernetes oft komplex und ressourcenintensiv, was viele Entwickler dazu veranlasst, nach einfacheren oder spezielleren Alternativen zu suchen. Gerade kleine Teams oder Projekte, die keine komplexe Infrastruktur benötigen, finden Kubernetes schnell überdimensioniert. Die Frage, die sich immer wieder stellt, lautet: Wenn nicht Kubernetes, welche Tools und Strategien nutzen Entwickler dann, um ihre Apps zu betreiben? Im Folgenden soll ein umfassender Überblick über verschiedene Ansätze gegeben werden – vom einfachen Single-Server-Betrieb bis hin zu kleinen oder mittelgroßen Multi-Node-Umgebungen außerhalb des Kubernetes-Ökosystems.

Einsteiger und Profis gleichermaßen können daraus wertvolle Hinweise mitnehmen. Für den Betrieb von Anwendungen auf einem einzelnen Server setzen viele Entwickler auf klassische Lösungen, die weniger Overhead mitbringen als Kubernetes. In diesem Bereich spielen einfache Automatisierungstools wie Ansible eine wichtige Rolle. Durch die Verwendung von Ansible lassen sich Deployments und Konfigurationsmanagement zuverlässig gestalten, ohne sich in die Komplexität von Kubernetes einarbeiten zu müssen. Insbesondere in Verbindung mit systemd-Units auf Linux-Distributionen wie Debian entsteht so eine einfache, aber effektive Möglichkeit, Anwendungen zu starten, zu stoppen und bei Ausfällen automatisch neu zu starten.

Gerade für kleine Webprojekte, individuelle Services oder interne Werkzeuge ist dieser Ansatz häufig völlig ausreichend. Darüber hinaus finden sich Tools wie Hatchbox, die speziell für das Deployment von Webanwendungen auf einem einzelnen Server entwickelt wurden. Hatchbox bietet eine Nutzerfreundlichkeit, die es ermöglicht, ohne großen Aufwand Anwendungen auf einem dedizierten Server – beispielsweise bei Cloud-Anbietern wie Hetzner – zu verwalten. Es richtet sich an Entwickler, die die Komplexität großer Orchestrierungs-Frameworks vermeiden wollen, ohne komplett auf Automatisierung verzichten zu müssen. Mit solchen Tools lassen sich zuverlässig Umgebungen für Rails-Apps oder andere Web-Frameworks aufsetzen und betreiben.

Eine weitere beliebte und oft genutzte Lösung im Single-Server-Kontext ist der Einsatz von Docker-Compose. Docker-Compose erlaubt es, Multi-Container-Anwendungen lokal oder auf einzelnen Servern einfach zu definieren, zu starten und zu verwalten. Die klar strukturierte YAML-Syntax macht das Setup transparent und reproduzierbar. Entwickler können so alle Komponenten einer Anwendung als Container orchestrieren, ohne die vollständige Komplexität von Kubernetes zu benötigen. In vielen Fällen reicht der Einsatz von Docker-Compose vollkommen aus, um mehrere Anwendungen in isolierten Containern sauber nebeneinander zu betreiben.

Wenn es um kleine Cluster oder Multi-Node-Setups geht, die nicht vollständig auf Kubernetes setzen wollen, gibt es weiterhin interessante Alternativen. Docker Swarm war lange Zeit die naheliegende Choice, da es eine einfache Erweiterung von Docker ist und weniger Komplexität als Kubernetes mitbringt. Swarm bietet Funktionen wie Service Discovery, Load-Balancing und einfache Skalierung, allerdings fehlt ihm das breite Ökosystem und die Erweiterungsfähigkeit von Kubernetes. Trotz dieser Stärken hat Kubernetes den Container-Orchestrierungs-Wettbewerb grundsätzlich für sich entschieden, weshalb Swarm nach und nach in den Hintergrund gerät. Nomad von HashiCorp ist eine weitere spannende Alternative, die speziell für verteilte Umgebungen konzipiert ist.

Im Gegensatz zu Kubernetes ist Nomad ein schlankes und vielseitiges Scheduler-System, das Container, aber auch andere Workloads orchestriert. Es bietet hohe Flexibilität und ist einfacher zu konfigurieren, was viele Nutzer gerade bei heterogenen Umgebungen als Vorteil sehen. Nomad überzeugt durch sein geringeres Ressourcenprofil, Weiterentwicklung und nahtlose Integration in das HashiCorp-Ökosystem mit Consul und Vault, was für bestimmte Anforderungen ideal sein kann. Die Community wächst stetig, auch wenn Nomad nicht in gleichem Maße populär wie Kubernetes ist. Des Weiteren gibt es im Bereich der selbstgehosteten Plattformen Projekte wie CapRover.

CapRover setzt auf Docker Swarm im Hintergrund, verpackt die Komplexität aber in eine benutzerfreundliche Weboberfläche. Es ist eine beliebte Lösung für Entwickler, die einen Heroku-ähnlichen Workflow selbst betreiben möchten. Auf günstigen VPS-Instanzen können damit mehrere Apps komfortabel deployed und verwaltet werden. Dabei stehen einfache Skalierungsmöglichkeiten und automatisches SSL-Management zur Verfügung, was die Wartung deutlich erleichtert. Cloud-native Dienste wie Amazon ECS (Elastic Container Service) bieten eine verwaltete Alternative, die viele Entwickler in Betracht ziehen, wenn Kubernetes zu komplex oder kostenintensiv erscheint.

ECS ist vergleichsweise einfach zu bedienen, da es nahtlos in das AWS-Ökosystem eingebunden ist. Für Unternehmen oder Entwickler, die bereits AWS nutzen, kann dies eine attraktive Wahl sein. Ergänzend gibt es Tools wie Flightcontrol, die das Deployment auf ECS-Clustern vereinfachen. Der Vorteil ist, dass die Entwickler sich nicht um komplexe Verwaltungsaufgaben von Clustern kümmern müssen, während gleichzeitig die Skalierbarkeit gewährleistet wird. Eine weitere interessante Entwicklung im Bereich einfacher Orchestrierung ist das Open-Source-Projekt Canine.

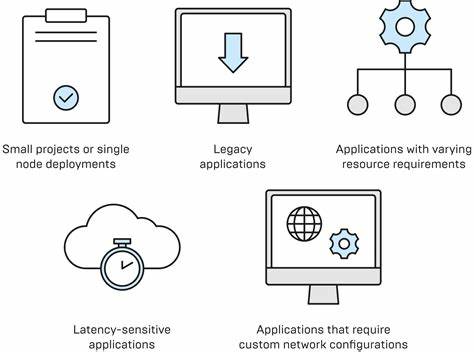

Es versucht die Kernvorteile von Kubernetes wie Service-Definitionen und die Containerisierung zu erhalten, dabei aber die bekannten Komplexitätsfallen zu umgehen. Canine ist für Nutzer interessant, die sich den Heroku-ähnlichen Workflow wünschen, ohne auf kostspielige etablierte Plattformen angewiesen zu sein. Die Entwicklung solcher Tools zeigt, dass der Markt nach einfacheren Alternativen zu Kubernetes sucht, die dennoch moderne Anforderungen an Automatisierung und Skalierbarkeit bedienen. Abschließend stellt sich die Frage, wann für Projekte wirklich Kubernetes notwendig oder sinnvoll ist. Experten empfehlen Kubernetes vor allem dann, wenn verteilte Systeme entstehen, die hohe Verfügbarkeit, dynamische Skalierung und Ausfallsicherheit erfordern.

Wird eine Anwendung allerdings auf einem einzigen Server betrieben und besitzt wenige Komponenten, ist Kubernetes in der Regel Overkill. Die Komplexität und der Aufwand für Wartung und Betrieb übersteigen die Vorteile. In solchen Fällen können auch einfache Deployment-Skripte oder kleine Container-Orchestrierungslösungen den Bedarf voll abdecken. Für Multi-Node-Setups, die hohe Performance und Verlässlichkeit brauchen, aber erst am Anfang stehen, kann ein Zwischenschritt in Form von Cloud-Instanzen erfolgen. Diese lassen sich meist einfach erweitern und bieten durch live Migration und verteilt arbeitende Systeme bereits eine gewisse Ausfallsicherheit.

Sobald ein Projekt wächst und die Anforderungen an Skalierung steigen, lohnt sich ein Wechsel zu Kubernetes oder einer entsprechenden Managed-Lösung. Zusammenfassend lässt sich festhalten, dass Kubernetes zwar die branchenweite Referenz im Container-Orchestrierungsbereich ist, jedoch keineswegs die einzige oder immer beste Option darstellt. Für Einsteiger, kleine Projekte und Teams, die Einfachheit und Schnelligkeit bevorzugen, gibt es zahlreiche Alternativen. Von klassischen Automatisierungstools wie Ansible über Docker Compose für Single-Server-Szenarien bis hin zu Nomad oder CapRover für Multi-Node-Setups bieten die verschiedenen Ansätze eine gewichtige Auswahl. Der Schlüssel liegt darin, die individuellen Anforderungen zu analysieren, das passende Tool in Bezug auf Skalierung, Zuverlässigkeit und Bedienbarkeit zu finden und so langfristig sowohl Aufwand als auch Kosten zu optimieren.

Die Entscheidung für oder gegen Kubernetes sollte am tatsächlichen Einsatzszenario ausgerichtet sein und nicht allein auf Trends oder Popularität basieren.

![Do It – Your AI Study Coach [video]](/images/7D7D90ED-800D-41A9-8E67-936FABBB6DC7)