Seit dem Durchbruch von OpenAI mit ChatGPT im Jahr 2022 erleben wir eine rasante Entwicklung im Bereich der künstlichen Intelligenz (KI). Lange Zeit stand der Wettlauf um immer größere Modelle im Vordergrund. Die Prognose war klar: Je größer das Modell, desto besser seine Leistungen. Doch diese Denkweise stößt mittlerweile an ihre Grenzen. Trotz gewaltiger Investitionen in riesige Datenzentren kommt die Leistungssteigerung bei der neuesten Generation von KI-Modellen, wie GPT-4.

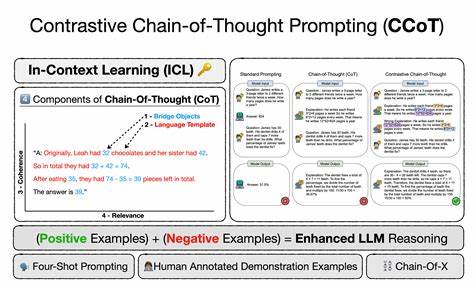

5, nicht mehr mit der Skalierung mit. Damit eröffnen sich für Forscher und Entwickler neue Wege, die es erlauben sollen, KI näher an menschliches Denken heranzuführen – eine Entwicklung, die weit über das „Chain-of-Thought“-Prompting hinausgeht. Das Chain-of-Thought (CoT) Prompting ist eine Technik, bei der KIs dazu angeleitet werden, komplexe Probleme Schritt für Schritt zu durchdenken, anstatt direkt eine Antwort zu liefern. Diese Methode hat eine neue Generation von Modellen ermöglicht, die deutlich bessere Leistungen in Bereichen wie Mathematik, Logik und Problemlösung erbringen. Beispiele hierfür sind OpenAIs o3, Googles Gemini 2.

5, Anthropic’s Claude 3.7 und DeepSeek’s R1. CoT machte sichtbar, dass das Zeigen von Zwischenschritten bei der Problemlösung die Leistung von KI erheblich verbessern kann. Doch die Forschung bleibt nicht stehen. Schon bald entstand ein ganzes Arsenal an kognitiv inspirierten Techniken – mit Bezeichnungen wie „Tree of Thought“, „Diagram of Thought“, „Logic of Thought“ und „Iteration of Thought“.

Ziel ist es, die natürlichen Denk- und Problemlösungsfähigkeiten von Menschen besser zu imitieren. Forscher sprechen zunehmend von „Denken“, „Reflexion“ und „Kognition“ im Kontext von KI und heben hervor, dass reine Größenzunahme von Modellen oft wenig bringt, wenn die kognitive Verarbeitung nicht optimiert wird. Die Wende vom reinen Skalieren der Modelle hin zur Entwicklung intelligenterer Denkstrategien steht auch im Zusammenhang mit den Grenzen, die rein statistische Modelle mit sich bringen. Grundsätzlich sagt ein Language Model (LLM) sozusagen voraus, welches Wort oder Textstück als nächstes am wahrscheinlichsten ist, basierend auf riesigen Textdatensätzen. Doch hinter der Wortvorhersage verbirgt sich keine echte „Intelligenz“ im menschlichen Sinne.

Die Chain-of-Thought-Technik hilft KIs, indem sie künstlich dazu gebracht werden, Zwischenschritte zu formulieren, die dann zu besseren Ergebnissen führen. Die weiteren Erweiterungen dieser Methode ermöglichen es Modellen, komplexe Aufgaben in kleinere Teilaufgaben zu zerlegen und sogar Fehler in früheren Schritten zu erkennen und zu korrigieren. Das erinnert stark an menschliches Denken und Problemlösen. Gleichzeitig führen diese kognitiv inspirierten Trainingsmethoden dazu, dass Modelle besser auf unterschiedliche Situationen reagieren und ihren Denkprozess anpassen können. Trotz aller Fortschritte gibt es bedeutende Herausforderungen.

Ein großes Problem ist, dass viele dieser Denkmodelle mit reinforcement learning, also verstärkendem Lernen, trainiert werden. Dabei werden richtige Zwischenschritte und Lösungen belohnt. Doch diese Belohnungen basieren häufig auf klar verifizierbaren Ergebnissen wie korrekten Rechenschritten oder logischen Aussagen. In solchen klaren Domänen kann die KI gut lernen. Probleme ergeben sich aber, wenn KI auf einfache Fragen trifft, die keine komplizierten Zwischenschritte erfordern.

Hier neigen die KI-Modelle zum sogenannten „Overthinking“ – sie produzieren mehr Tokens oder Zwischenschritte, als nötig sind. Das verringert nicht nur die Effizienz, sondern kann die Antwortqualität sogar mindern. Ein interessantes Experiment zeigte, dass Modelle, die überthinking zeigen, sich durch eine Art „Metakognition“ steuern lassen können. Metakognition bedeutet in der Psychologie das Reflektieren über das eigene Denken. In einer Studie ließ man die KI abschätzen, wie viele Zwischenschritte sie für eine Lösung benötigt und gab ihr während des Denkprozesses Rückmeldungen über den verbleibenden „Token-Budget“.

Diese Methode führte zu effizienterer und präziserer Problemlösung. Das Vorgehen ähnelt dem Umgang mit Menschen, die sich manchmal in zu komplizierten Überlegungen verlieren. Weitere Schwachstellen zeigen sich im Bereich der Analogie- und Kreativitätsfähigkeit der KI. Während KI-Modelle bei standardisierten Analogietests solide Leistungen erbringen, bricht ihre Leistung bei unbekannten Varianten ein. Das deutet darauf hin, dass viele Modelle noch immer auf oberflächliche Mustererkennung setzen und nicht wirklich tiefgehendes Verständnis oder abstraktes Denken beherrschen.

Diese Erkenntnisse mahnen zur Zurückhaltung, wenn man der KI Zuspruch für echtes „Denken“ geben möchte. Ebenfalls problematisch ist das sogenannte „Theory of Mind“ – die Fähigkeit, sich in die Gedankenwelt anderer hineinzuversetzen und deren Verhalten zu verstehen oder vorherzusagen. Zwar können viele KI-Systeme psychologische Testaufgaben lösen, doch liegt das oft daran, dass entsprechende Aufgaben in den Trainingsdaten enthalten sind. Forscher des Allen Institute for AI haben deshalb realitätsnahere Tests entwickelt, die das tatsächliche Erfassen mentaler Zustände sowie deren Einfluss auf Verhalten und Handlungsbeurteilung messen. Die Ergebnisse zeigen, dass KI zwar mentalen Zustand erkennen kann, aber oft versagt, das Verhalten davon abgeleitet korrekt vorherzusagen oder zu bewerten.

Dies liegt daran, dass die Modelle eher auf statistische Wahrscheinlichkeiten als auf echte kausale Zusammenhänge setzen. Interessanterweise verbesserte sich die Leistung der Modelle signifikant, wenn sie explizit daran erinnert wurden, den mentalen Zustand bei ihrer Entscheidung mit einzubeziehen, etwa durch gezielte Chain-of-Thought-Prompts. Das zeigt, dass das richtige „Denkmuster“ entscheidend ist und für zukünftige Modelle tief integriert werden muss. Ein entscheidender Schritt in Richtung menschähnlicher KI ist die Entwicklung von Metakognition – also der Fähigkeit der Modelle, über den eigenen Denkprozess nachzudenken, Unsicherheiten zu erkennen und sich an verschiedene Kontexte anzupassen. Ein Team aus Psychologen und KI-Forschern sieht hierin die fundamentale nächste Revolution.

Modelle, die sich selbst einschätzen und ihre Denkstrategien flexibel anpassen können, sind nicht nur leistungsfähiger, sondern auch für Menschen besser nachvollziehbar. Das stärkt das Vertrauen in KI-Systeme und deren Anwendbarkeit in kritischen Bereichen. Die Umsetzung solcher Metakognition stellt jedoch enorme Herausforderungen an Trainingsdaten, Architektur und Rechenressourcen. Das Training dieser Systeme erfordert enormen Aufwand und könnte vor allem kleinere Unternehmen überfordern oder den ökologischen Fußabdruck der Technologie weiter erhöhen. Dennoch ist das Nachahmen menschlicher geistiger Prozesse aus Forschungssicht die vielversprechendste Route für die Zukunft.

Ein weiteres Spannungsfeld besteht darin, dass viele fortgeschrittene Denkansätze zwar konzeptionell überzeugend sind, aber in der Praxis bisher oft nur sehr rudimentär umgesetzt wurden. Die Vielfalt menschlicher Kognition ist komplex und vielschichtig – über reines logisches Denken hinaus spielen Emotionen, Intuition, Kreativität und soziale Intelligenz eine Rolle. Die Herausforderung besteht darin, diese Elemente in KI-Systeme zu integrieren, ohne die Modelle unüberschaubar oder ineffizient werden zu lassen. Die Entwicklung von KI-Systemen, die über reine Token-Vorhersage hinausgehen, betrifft nicht nur die KI-Forschung selbst, sondern hat weitreichende Auswirkungen auf Wirtschaft, Gesellschaft und Ethik. Fortschrittlichere Denkfähigkeiten können KI in Bereichen wie Gesundheit, Bildung und Forschung effektiver einsetzen, aber auch neue Risiken bergen, wenn Modelle falsche Schlussfolgerungen oder unerwartetes Verhalten zeigen.

Transparenz im Denkprozess und die Fähigkeit, Unsicherheiten zu kommunizieren, werden deshalb immer wichtiger. Zusammenfassend lässt sich sagen, dass die Zukunft der KI nicht mehr allein in größeren Modellen liegt, sondern viel mehr in der Qualität und Flexibilität des Denkens. Die nächste Generation von Modellen wird durch kognitive Techniken wie Chain of Thought und seine Weiterentwicklungen, gepaart mit Metakognition, bessere, menschlichere und effizientere Denker sein. Die Forschung ist lebendig, voller Herausforderungen und bietet faszinierende Potenziale, die sowohl technische als auch gesellschaftliche Veränderungen bewirken werden. KI-Entwickler und Forscher bewegen sich auf einem spannenden Pfad, der Maschinen nicht nur mit riesigen Datenmengen, sondern mit einem echten Verständnis und reflektierten Denkprozessen ausstattet.

Dieser Wandel lässt hoffen, dass Computer und Menschen sich in der Zukunft nicht nur verständigen, sondern gemeinsam neue Denkwelten erschaffen können.