Die Diskussion um Künstliche Intelligenz (KI) ist gegenwärtig so lebendig wie selten zuvor. Große Tech-Konzerne, Investoren und die breite Öffentlichkeit scheinen sich gleichermaßen von den Möglichkeiten fasziniert zu zeigen, die KI verspricht – von autonom fahrenden Autos bis hin zu virtuellen Assistenten, die in natürlicher Sprache kommunizieren können. Doch inmitten der Euphorie stellt sich die Frage, ob wir uns am Beginn einer neuen Ära oder möglicherweise erneut im Schatten eines sogenannten „KI-Winters“ befinden. Dieser Begriff bezeichnet Phasen, in denen die Begeisterung für KI-Technologien stark abnimmt, weil die Erwartungen die tatsächlichen Fähigkeiten übersteigen und Fortschritte stagnieren. Ein Rückblick auf die Historie und eine realistische Bewertung der heutigen KI-Situation sind daher unabdingbar.

Bereits in den 1960er Jahren wurde die künstliche Intelligenz mit großen Erwartungen eingeleitet. Ein berühmtes Beispiel ist das Projekt der maschinellen Übersetzung von Russisch ins Englische, welches damals erwartete, binnen kurzer Zeit bemerkenswerte Ergebnisse zu erzielen. Die Wirklichkeit sah ganz anders aus. Die Systeme konnten den Kontext oft nicht erfassen, Fehler häuften sich und der Fortschritt kam kaum voran. Diese und ähnliche Rückschläge führten in den folgenden Jahrzehnten zu einem starken Rückgang der Investitionen und dem vorübergehenden Verschwinden von KI vom öffentlichen Radar.

Der erste große KI-Winter war geboren – ein Gleichnis für den Niedergang einer Technologie, die eigentlich das Potenzial besaß, die Welt zu verändern. Der aktuelle Hype rund um große Sprachmodelle (Large Language Models, LLMs) wie OpenAI’s ChatGPT ist das Ergebnis einer Kombination aus technologischem Fortschritt, exponentiell gestiegenen Rechenkapazitäten und gigantischen Datenmengen. LLMs können Texte generieren, Fragen beantworten und sogar teilweise komplexe Aufgaben wie Programmiercode erstellen. Dennoch stehen diese Systeme weiterhin vor enormen Herausforderungen. Ein zentrales Problem ist das Phänomen der sogenannten „Halluzinationen“: Hierbei präsentieren die Modelle falsche oder erfundene Informationen mit großer Sicherheit als Fakten.

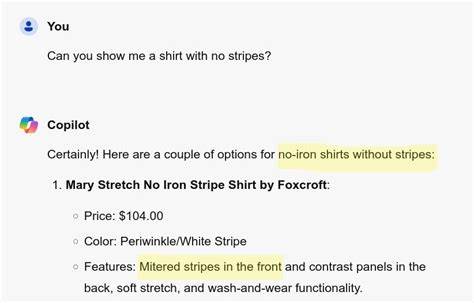

Dieses Verhalten offenbart die fundamentale Beschränkung der KI, die darin besteht, Muster in Daten zu erkennen und zu replizieren, ohne grundsätzlich „zu verstehen“. Das sorgt bei Nutzern für Frustration und gefährliche Fehlinterpretationen in sensiblen Bereichen wie Recht, Medizin oder Bildung. Prompt Engineering, also die Kunst, eine KI in der Eingabeaufforderung gezielt zu steuern, zeigt dabei eine weitere paradoxe Entwicklung auf. Während die Werbebotschaften der KI-Industrie suggerieren, dass Maschinen immer menschlicher agieren und reagieren, bedeutet der tatsächliche Einsatz von KI oft das Gegenteil: Menschen müssen lernen, wie die Maschine „denkt“, um Ergebnisse zu erzielen. Das erinnert stark an frühere Technikzeiten, als Nutzer tiefes technisches Verständnis brauchten, um Systeme überhaupt benutzbar zu machen.

Eine perfekte Mensch-Maschine-Interaktion ist damit weiterhin fern. Obwohl diese Einschränkungen existieren, sind praktische Anwendungen der KI längst Realität. In der Medizin etwa unterstützt Bildverarbeitungssysteme Ärzte bei der schnellen Identifikation von Krankheiten, was Leben retten kann. Autofahrer profitieren von Assistenzsystemen, die das Unfallrisiko senken. Diese Anwendungen sind jedoch spezialisierte Lösungen, die innerhalb eines klar definierten Rahmens funktionieren.

Sie bewegen sich nicht an der Grenze menschlichen Denkens und bieten keine allgemeine Intelligenz, sondern sind auf einzelne Aufgaben beschränkt. Im Umfeld autonomer Fahrzeuge zeigt sich das Dilemma besonders deutlich: Systeme, die in kontrollierten Umgebungen wie Metros zuverlässig funktionieren, stoßen im komplexen Straßenverkehr an ihre Grenzen. Die Fähigkeit zu improvisieren und unerwartete Situationen eigenständig zu meistern, bleibt für KI unerreichbar. Das führt zu einer Diskrepanz zwischen der öffentlichen Wahrnehmung und der tatsächlichen Leistungsfähigkeit moderner KI-Technologien. Medien und Marketing erzeugen oft ein Bild von KI als Alleskönner mit nahezu unbegrenztem Potenzial.

Tatsächlich sind heutige KI-Modelle häufig lediglich „einfache“ Werkzeuge mit beeindruckender Oberfläche, aber beschränkter Tiefe. Dies erschwert es, Vertrauen zu schaffen, insbesondere wenn Fehlleistungen gravierende Konsequenzen haben, etwa im juristischen Bereich. Anwälte, die sich auf KI-generierte Informationen verlassen, müssen aktuell noch viel Nacharbeit investieren, um fehlerhafte oder erfundene Quellen zu korrigieren. Dies unterstreicht den hohen manuellen Aufwand, der mit dem Einsatz von KI verbunden ist. Auf der anderen Seite bieten LLMs und andere KI-Systeme auch Chancen, die allmählich erkannt werden.

Programmierer können mit KI-gestützter Code-Generierung Routinearbeiten beschleunigen. In der Kundenbetreuung finden Chatbots verstärkt Einsatz, um einfache Anfragen zu bewältigen und Wartezeiten zu reduzieren. Dennoch zeigt sich auch hier, dass Menschen oft unverzichtbar bleiben, gerade wenn es um komplexe oder unerwartete Problemstellungen geht. Dabei stellen sich auch fundamentale Fragen rund um Verantwortung, Haftung und Ethik. Wer haftet, wenn eine KI eine falsche Entscheidung trifft oder eine Fehlinformation verbreitet? Die rechtlichen Rahmenbedingungen sind in vielen Ländern noch unzureichend ausgearbeitet, was Unsicherheiten für Unternehmen und Nutzer schafft.

Zudem kämpfen Unternehmen mit Fragen der Datennutzung, Urheberrechten und Datenschutz – Probleme, die oft unterschätzt oder ausgeblendet werden. Es wäre jedoch zu pessimistisch, nur den kommenden KI-Winter zu prognostizieren. Vielmehr findet derzeit eine Konsolidierung der Technologie statt. Fortschritte sind zwar nicht mehr so spektakulär wie in den ersten Phasen des Hype-Zyklus, aber stetig. Vielversprechende Forschungsansätze – etwa im Bereich der fehlerresistenteren Modelle oder Hybridlösungen, die durch menschliche Korrekturen ergänzt werden – zeigen, dass KI langfristig ihr Potenzial entfalten kann.

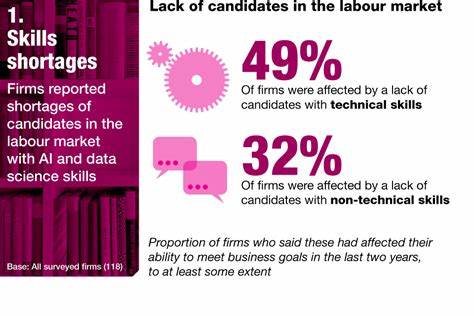

Auch die Wirtschaft muss sich anpassen. Die Zeiten, in denen mit risikoreichen Investitionen ohne klaren Mehrwert Geld verdient werden konnte, neigen sich dem Ende zu. Nachhaltige Geschäftsmodelle sind gefragt, die echte Probleme adressieren und bei denen der Nutzen gegenüber dem Aufwand im Vordergrund steht. Dabei könnte KI dann endlich ihre wahre Rolle einnehmen: als Werkzeug, das menschliche Fähigkeiten ergänzt, nicht ersetzt. Zum jetzigen Zeitpunkt stehen wir also an einem kritischen Punkt.

Die großen Versprechungen sind auf den Prüfstand gestellt, unvermeidliche Kinderkrankheiten der Technologie werden sichtbar. Gleichzeitig steigt das Verständnis dafür, wie KI sinnvoll und verantwortungsvoll eingesetzt werden kann. Ob sich das Wachstumstempo wieder beschleunigt oder sich der nächste Winter anbahnt, hängt von mehreren Faktoren ab: der technologischen Weiterentwicklung, der gesellschaftlichen Akzeptanz, der regulatorischen Rahmenbedingungen und nicht zuletzt auch von wirtschaftlichen Rahmenbedingungen. Interessanterweise zeigen Beispiele aus dem Alltag, wie weit KI inzwischen gekommen ist und wo die Hürden noch liegen. Smartphones, die Bilder erkennen und sortieren, tun dies meist anhand großer Datensätze und mathematischer Mustererkennung.

Doch wenn eine scheinbar naheliegende Suche wie „Peanuts“ nicht funktioniert, sondern nur über Umwege wie „Pebbles“ Ergebnisse liefert, wird klar, wie unscharf die KI-Welt manchmal noch ist. Ein Mensch nutzt Erfahrungen, Analogien und Kontextwissen, um komplexe Situationen zu erfassen – Fähigkeiten, über die KI derzeit nicht verfügt. Die Grenzen des Machbaren und der Nutzen von KI mögen also klarer definiert sein, als der allgemeine Hype vermuten lässt. Trotzdem sollte das Potenzial nicht unterschätzt werden. Effizientere Algorithmen, bessere Datenqualität und engere Kooperationen zwischen Mensch und Maschine könnten den nächsten Entwicklungssprung bringen.