Die rasante Entwicklung künstlicher Intelligenz hat in den letzten Jahren viele Hoffnungen geweckt, insbesondere im Bereich der sogenannten KI-Agenten, die komplexe Aufgaben autonom ausführen sollen. Ihre Fähigkeiten werden von Experten und Medien vielfach gefeiert, und es wird prognostiziert, dass KI-Agenten noch in naher Zukunft viele menschliche Tätigkeiten ersetzen könnten. Doch jenseits des Hypes gibt es berechtigte Zweifel und ernstzunehmende Bedenken, warum KI-Agenten in ihrer derzeitigen Form eher eine potenzielle Gefahr als eine uneingeschränkte Bereicherung darstellen. Diese Bedenken basieren auf vielfältigen Aspekten, die von technischer Machbarkeit und Genauigkeit bis hin zu ethischen und gesellschaftlichen Fragestellungen reichen. Ein entscheidender Punkt ist die begrenzte Präzision, mit der KI-Agenten derzeit arbeiten.

Obwohl moderne Modelle beeindruckende Leistungen bei bestimmten Aufgaben zeigen, sind sie noch lange nicht fehlerfrei und können in realen komplexen Umgebungen oft nicht die gewünschte Zuverlässigkeit gewährleisten. Die sogenannten Benchmark-Tests, die häufig als Referenz für die Leistungsfähigkeit dienen, spiegeln nicht die wirklichen Herausforderungen wider, mit denen KI-Agenten im Alltag konfrontiert werden. Im Gesundheitswesen oder bei rechtlichen Angelegenheiten kann bereits ein kleiner Fehler gravierende Auswirkungen haben und im schlimmsten Fall Leben oder Existenzen gefährden. Daraus folgt, dass ein Vertrauen in eine hundertprozentige Genauigkeit der KI-Agenten unrealistisch ist und die vollständige Automatisierung ohne menschliche Kontrolle riskant erscheint. Ein weiteres Hindernis liegt in der begrenzten Fähigkeit der KI-Agenten, eigenständig den richtigen Umgang mit Werkzeugen und Ressourcen zu wählen.

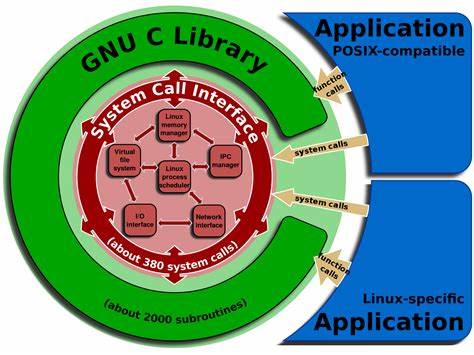

In der Praxis zeigt sich, dass KI-Agenten Schwierigkeiten haben, situativ angemessene Entscheidungen zu treffen, wann sie auf externe Hilfsmittel zurückgreifen sollten und wann interne Daten ausreichen. Besonders bei komplexen Arbeitsabläufen, in denen unterschiedliche Tools ineinandergreifen müssen, stoßen sie an ihre Grenzen. Diese Unfähigkeit zur optimalen Koordination kann zu Ineffizienzen und Fehlern führen, die den Arbeitsfluss behindern und potenziell zu Missverständnissen oder Fehlinterpretationen führen. Menschen verfügen hingegen über eine intuitive Wissensbasis und Erfahrung, die ihnen ermöglicht, den richtigen Werkzeugmix auszuwählen und situativ zu reagieren. Vertrauen ist ein Kernelement in der Mensch-Maschine-Interaktion und gerade hierin bestehen bei KI-Agenten erhebliche Defizite.

Menschen sind von Natur aus vorsichtig bei der Übergabe wichtiger Entscheidungen an Systeme, die als Blackboxen wahrgenommen werden und deren Fehlermöglichkeiten sich nicht vollständig überblicken lassen. In besonders sensiblen Bereichen wie Finanzen, Gesundheit oder juristischen Empfehlungen stellt sich die Frage, ob Nutzer bereit sind, Risiken einzugehen und eine verantwortliche Entscheidung einer Maschine anzuvertrauen. Bisherige Beispiele zeigen, dass Vertrauen schnell erschüttert wird, sobald Fehler in AI-Systemen publik werden. Ohne eine vertrauenswürdige Basis können KI-Agenten ihre Potentiale nicht entfalten und werden entweder misstrauisch beäugt oder nur sehr eingeschränkt eingesetzt. Darüber hinaus ist die Rolle des Menschen trotz aller Fortschritte bei KI-Agenten unverzichtbar geblieben.

Die menschliche Urteilskraft, Empathie und moralische Verantwortung können aktuelle Technologien nicht ersetzen. Gerade in Bereichen, in denen zwischenmenschliche Kommunikation, ethische Abwägungen und kreative Lösungsfindung gefragt sind, bleiben menschliche Fähigkeiten weiterhin unerlässlich. KI-Agenten sind höchstens dazu geeignet, repetitive oder standardisierte Aufgaben zu übernehmen und den Menschen dadurch zu entlasten. Eine vollständige Ersetzung würde wichtige soziale und emotionale Faktoren vernachlässigen, die für ein funktionierendes gesellschaftliches Miteinander entscheidend sind. Ein oft unterschätztes Risiko besteht in den in KI-Systemen verankerten Vorurteilen und Verzerrungen, die auf den Trainingsdaten basieren.

Da KI-Agenten aus Daten lernen, die aus der realen Welt stammen – häufig aus dem Internet –, enthalten sie zwangsläufig auch die gesellschaftlichen Biases, sei es in Bezug auf Geschlecht, Ethnie oder sozioökonomischen Status. Dies führt dazu, dass Entscheidungen von KI-Agenten unbewusst diskriminierend oder unfair ausfallen können. Gerade in Bereichen wie Personalwesen, Rechtspflege oder sozialen Diensten kann dies zu ernsthaften Benachteiligungen und einer Verschärfung gesellschaftlicher Ungleichheiten führen. Die Erkennung und Korrektur solcher Verzerrungen gestaltet sich als äußerst schwierig und bleibt eine zentrale Herausforderung bei der Entwicklung präziser und gerechter KI-Agenten. Neben technischen und gesellschaftlichen Herausforderungen stellen sich auch komplexe ethische und rechtliche Fragen hinsichtlich der Verantwortlichkeit für die Handlungen von KI-Agenten.

Wenn eine KI falsche Entscheidungen trifft, ist unklar, wer zur Rechenschaft gezogen werden kann – der Entwickler, der Betreiber oder vielleicht gar die KI selbst? Ebenso problematisch ist die Möglichkeit des Missbrauchs von KI-Agenten etwa zur Manipulation von Meinungen, für Betrugszwecke oder zur Verletzung von Privatsphäre. Die derzeit bestehenden gesetzlichen Rahmenbedingungen sind noch nicht ausreichend, um diese Risiken abzudecken und eine adäquate Regulierung sicherzustellen. Ohne klare Richtlinien könnte die ungezügelte Verbreitung von KI-Agenten zu schwerwiegenden negativen Folgen führen und neue Formen der Ungerechtigkeit und Kontrolle schaffen. Ein weiteres bedenkliches Phänomen ist die Gefahr der Überabhängigkeit vom Einsatz künstlicher Intelligenz. Mit zunehmender Verlagerung von Entscheidungskompetenzen und Tätigkeiten auf KI-Agenten droht die menschliche Problemlösungsfähigkeit, Kreativität und das kritische Denken zu verkümmern.

Ein Verlust dieser essenziellen Fähigkeiten kann Nutzer nicht nur in ihrer Entwicklung einschränken, sondern sie auch verletzlich gegenüber Systemausfällen oder Manipulation machen. Der Vergleich mit der zunehmenden Abhängigkeit von Navigationssystemen ist treffend: Viele Menschen verlieren die Fähigkeit zur Orientierung, wenn Technik nicht zugänglich ist. In futuristischen Szenarien könnte eine starke Abhängigkeit von KI-Agenten zu fehlender Selbständigkeit und einem Rückgang an Eigenverantwortung führen. Abschließend zeigt sich, dass die aktuellen KI-Agenten trotz beeindruckender technischer Fortschritte mit erheblichen Schwächen und Risiken verbunden sind. Ihre Limitierungen in Genauigkeit, der Fähigkeit zur sinnvollen Werkzeugwahl, der Vertrauenswürdigkeit sowie die ethischen und rechtlichen Unsicherheiten machen eine vollumfängliche Automatisierung menschlicher Tätigkeiten nicht nur fragwürdig, sondern potenziell gefährlich.