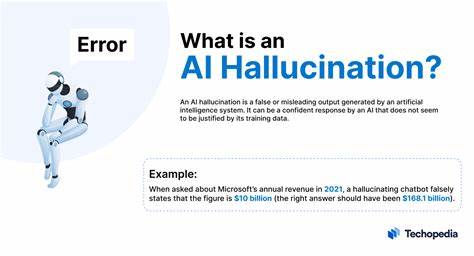

Die fortschreitende Integration von Künstlicher Intelligenz (KI) in verschiedene Lebensbereiche wirft immer wieder bedeutende Fragen auf, vor allem im Hinblick auf die Qualität und Verlässlichkeit der erzeugten Informationen. Ein besonders brisantes Beispiel ist die Verwendung von KI-Systemen wie großen Sprachmodellen (Large Language Models, LLMs) im juristischen Sektor. Neben den enormen Chancen, die diese Technologien bieten, treten kritische Probleme zutage – insbesondere das Phänomen der sogenannten Halluzinationen. Diese beschreiben die Neigung von KI-Systemen, falsche oder erfundene Informationen zu generieren, was in einem Kontext wie dem Recht schwerwiegende Konsequenzen haben kann. Die Diskussion um KI-Kompetenz, also die Fähigkeit, mit den Fähigkeiten und Grenzen der KI angemessen umzugehen, wird vor diesem Hintergrund immer dringlicher.

Seit den frühen 2000er-Jahren thematisiert unter anderem der renommierte Forscher Gary Marcus die Problematik der Halluzinationen bei generativen KI-Systemen. Trotz jahrelanger Warnungen scheint das Bewusstsein für dieses Phänomen gerade in den letzten Jahren, in denen KI-Systeme verstärkt in der Öffentlichkeit präsent sind, kaum in dem Maße gewachsen zu sein, wie es nötig wäre. Die öffentliche Darstellung und Medienberichterstattung neigen häufig dazu, die Fähigkeiten moderner KI zu überschätzen und die anhaltenden Schwächen zu verharmlosen. Die Folge ist, dass auch hochqualifizierte Anwender, beispielsweise Juristen, sich oftmals zu sehr auf KI-gestützte Werkzeuge verlassen, ohne ausreichend auf die Gefahr von erfundenen oder falsch dargestellten Fällen und Fakten zu achten. Ein aktueller Fall, der große Aufmerksamkeit erregte, illustriert diese Problematik eindrücklich: Ein Anwalt nutzte KI-Systeme zur Vorbereitung seiner Schriftsätze und berief sich dabei auf von der KI generierte, jedoch nicht existente Gerichtsurteile.

Dieser Vorfall, der in renommierten Medien wie The Guardian publik wurde, steht exemplarisch für eine Vielzahl ähnlicher Fälle, die nur an die Öffentlichkeit gelangen, wenn sie entdeckt werden. In Wirklichkeit dürften diese Fehlleistungen und die daraus entstehenden Folgen wesentlich häufiger auftreten, ohne dass sie unmittelbar auffallen oder öffentlich diskutiert werden. Die Konsequenzen für die Rechtspflege sind erheblich. Wenn LLMs fiktive Urteile oder falsche Rechtsquellen als Fakten präsentieren, kann das nicht nur die Verteidigungsstrategien beeinträchtigen, sondern potenziell auch Gerichtsentscheidungen beeinflussen. Dies unterminiert das Vertrauen in das Rechtssystem, das auf Verlässlichkeit, Nachprüfbarkeit und Sachlichkeit angewiesen ist.

Der juristische Bereich ist damit ein besonders sensibler Indikator für die Breite und Tiefe des Problems von KI-Halluzinationen. Zudem zeigt es, wie wichtig es ist, KI-Kompetenz nicht nur vereinzelt bei Experten, sondern möglichst breit in der Gesellschaft verankert zu wissen. Ein zentrales Problem bei den aktuellen KI-Architekturen liegt in ihrem methodischen Fundament. Die Systeme basieren vornehmlich auf statistischen Wahrscheinlichkeiten, die aus riesigen Textkorpora gewonnen werden. Sie sind aber nicht in der Lage, Wissen ontologisch zu strukturieren oder die Metaphysik von Informationen zu verstehen – also das, was hinter den Daten liegt und Bedeutung strukturiert.

Damit fehlt eine tiefergehende Erkenntnis über Zusammenhänge und Ursache-Wirkungs-Beziehungen. Diese fehlende epistemologische Tiefe begünstigt die Halluzinationen immens, da die KI versucht, auf Basis semantischer Assoziationen Zusammenhänge herzustellen, die in Wirklichkeit nicht existieren. Die Einbettung von KI in formalisierte Wissensmodelle, die etwa Kausalität, physikalische Gesetze oder ethische Normen berücksichtigen, könnte zukünftig einen Schritt in Richtung Reduktion der Halluzinationen bedeuten. Allerdings ist dieser Weg technisch anspruchsvoll und bisher nur ansatzweise verfolgt worden. Bis zu einer solchen Entwicklung bleibt das Risiko von Fehlern und Falschinformationsverbreitung hoch, zumal auch die zahlreichen Datenzentren und Rechenkapazitäten, die für den Betrieb solcher Systeme erforderlich sind, zu großen ökologischen und politischen Herausforderungen führen.

Im juristischen Kontext ist zudem ein wichtiges Element die rechtliche Haftung und die Verantwortung beim Einsatz von KI-Systemen. Wenn Anwälte KI-Tools nutzen, müssen sie verstehen, dass die Technologie weder unfehlbar noch eine eigenständige Quelle von Wahrheiten ist. Fachliche Prüfung und kritisches Hinterfragen sind unerlässlich, vor allem weil Fehler strafrechtliche und berufliche Sanktionen nach sich ziehen können. Die Tatsache, dass dennoch immer wieder Fälle auftauchen, in denen KI-unterstützte Prozesse zu falschen Angaben führen, deutet auf eine Lücke in der Ausbildung und Sensibilisierung hin. Die öffentliche Kommunikation spielt an dieser Stelle eine entscheidende Rolle.

Medienberichte sollten verstärkt auf die Schwächen und Risiken von KI hinweisen, statt allein die Fortschritte und Potenziale zu feiern. Ein ausgewogenes Bild hilft dabei, Fehlanwendungen zu minimieren und die Gesellschaft aufzuklären. Zudem sind politische und regulatorische Maßnahmen nötig, um den Umgang mit KI in sensiblen Bereichen wie dem Recht rechtlich abzusichern und klare Standards zu etablieren. Solche Regulierungen könnten etwa Transparenzpflichten beinhalten, die Anbieter von KI-gestützten Systemen zur Offenlegung ihrer Techniken und möglichen Fehlerquellen verpflichten. Neben technischen und rechtlichen Lösungen ist auch die Ausbildung von KI-Kompetenz auf breiter Ebene ein wesentliches Element, um den Herausforderungen professionell zu begegnen.

Juristische Fachkräfte sollten sowohl über die technischen Grundlagen von KI informiert sein als auch über die typischen Fehlerquellen und das korrekte Vorgehen bei der Nutzung von digitalen Werkzeugen. Nur so kann der verantwortungsvolle Umgang mit KI gewährleisten werden, ohne dass das Vertrauen in Rechtssystem und Justiz gefährdet wird. Abschließend lässt sich festhalten, dass die Herausforderungen durch KI-Halluzinationen nicht trivial sind und weit über den juristischen Bereich hinausgehen. Sie betreffen Gesellschaft, Wirtschaft und Politik gleichermaßen. Eine kritische Auseinandersetzung mit den Grenzen aktueller KI-Technologien, kombiniert mit einem breiten Aufbau von KI-Kompetenz, ist der Schlüssel, um die Potenziale der Künstlichen Intelligenz sinnvoll und sicher zu nutzen.

Dies erfordert ein koordiniertes Zusammenspiel von Forschung, Bildung, Medien und Gesetzgebung – nur so können Fehlentwicklungen eingedämmt und Innovationen auf einem soliden Fundament gefördert werden.

![How Speedrunners Broke My Rage Game (Get to Work) [video]](/images/3E033144-F3CC-40D8-A8D2-6B754EF6FAAA)