In der Welt der Softwareentwicklung ist eine effiziente und performante Programmierung unerlässlich. Insbesondere bei Low-Level-Programmierung wie in Assembly-Code, wo eine feinkörnige Kontrolle über die Ausführung möglich ist, können selbst geringfügige Optimierungen enorme Auswirkungen auf die Geschwindigkeit und Ressourcennutzung haben. Traditionell verlassen sich Entwickler auf Compiler wie gcc mit seinen bekannten Optimierungsstufen, beispielsweise -O3, um bestmögliche Performance zu erzielen. Doch wie weit lässt sich die Leistungsfähigkeit von Assembly-Code tatsächlich noch steigern? Eine innovative Herangehensweise kombiniert die Leistungsfähigkeit großer Sprachmodelle (LLMs) mit Reinforcement Learning (RL) und eröffnet damit bisher ungeahnte Optimierungspotenziale.Große Sprachmodelle, ursprünglich für Textgenerierung und natürliche Sprachverarbeitung entwickelt, haben in den letzten Jahren bemerkenswerte Fortschritte in der Programmierunterstützung gezeigt.

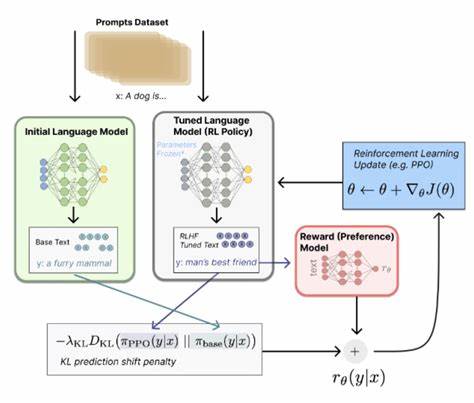

Sie können Code verstehen, vervollständigen und sogar neuen Code generieren. Allerdings bleibt ihr Potenzial zur tatsächlichen Codeoptimierung bislang weitgehend unerforscht, insbesondere auf der Ebene von Assembly-Code, der kaum Fehlertoleranz erlaubt und bei dem jede Änderung Funktionalität sowie Performance direkt beeinflussen kann.Hier setzt das Konzept an, LLMs durch Reinforcement Learning gezielt dazu zu trainieren, Assembly-Code für höhere Performance zu optimieren, ohne dabei funktional korrekt zu bleiben. Das Grundprinzip basiert auf der Definition eines Belohnungssystems, bei dem das Modell ermutigt wird, Veränderungen am Code vorzunehmen, die nicht nur die Resultate der Testfälle bestehen bleiben lassen, sondern auch die Ausführungszeit im Vergleich zu einem bekannten Compiler-Benchmark verbessern. Als Benchmark dient häufig der gcc-Compiler mit der optimierten Stufe -O3, der als Industriestandard für hohe Performance gilt.

Die Herausforderung liegt darin, den LLMs unter Einsatz von Reinforcement Learning beizubringen, effizientere Instruktionsmuster zu entdecken und dabei eventuelle Redundanzen oder suboptimale Speicherzugriffe zu minimieren. Das Trainingsverfahren verwendet die Methode des Proximal Policy Optimization (PPO), ein moderner RL-Algorithmus, der stabile und graduelle Verbesserungen innerhalb sicherer Grenzen ermöglicht, um übermäßige oder kontraproduktive Änderungen zu vermeiden. So lernt das Modell, schrittweise bessere Lösungen zu generieren, welche die Latenz verringern oder den Durchsatz erhöhen.Zur Evaluation und Weiterentwicklung haben Forscher eine umfangreiche Sammlung von über 8.000 realen Assembly-Programmen aufgebaut, welche als Testfeld und Vergleichsgrundlage dienen.

Intensive Tests zeigen, dass ein fein abgestimmtes Modell wie Qwen2.5-Coder-7B-PPO nicht nur eine hohe funktionale Korrektheit von 96% bei Testdurchläufen erreicht, sondern gleichzeitig durchschnittliche Geschwindigkeitssteigerungen von 1,47-fach gegenüber gcc -O3 erzielt. Diese Leistung schlägt damit etablierte Modelle wie Claude-3.7-sonnet deutlich und beweist, dass die Kombination aus großem Sprachmodell und Reinforcement Learning eine vielversprechende Zukunft für Codeoptimierung bereithält.Die Auswirkungen dieses Fortschritts sind vielseitig.

Für Entwickler bedeutet dies, in Zukunft weniger Zeit für manuelle Low-Level-Optimierung aufwenden zu müssen, da KI-basierte Systeme bereits beim Schreiben oder nachträglich bei der Analyse und Verbesserung des Assembly-Codes entscheidende Performancevorteile liefern können. Gerade in Bereichen mit hohen Anforderungen an Echtzeitfähigkeit, Energieeffizienz oder begrenzte Hardware-Ressourcen wie eingebettete Systeme, Robotik oder mobile Endgeräte kann so signifikant Energie und Rechenleistung eingespart werden.Darüber hinaus öffnet die Methode spannende Perspektiven für die Softwareindustrie insgesamt. Automatisierte Optimierung kann zur Beschleunigung von Entwicklungszyklen beitragen, indem Fehlerquellen durch ineffiziente Programmierung reduziert und Entwicklungsaufwände minimiert werden. Gleichzeitig steigt die Codequalität und somit auch die Wartbarkeit und Erweiterbarkeit der Softwareprodukte.

Innovatoren auf dem Gebiet der Compilertechnik und Programmanalyse erhalten neue Werkzeuge, um bisher unerreichte Optimierungsgrade zu erreichen.Trotz dieser Erfolge steht die Integration solcher KI-gesteuerten Optimierungsverfahren noch am Anfang. Zu berücksichtigen sind Herausforderungen wie Erklärbarkeit der Entscheidungsschritte, Sicherheit und Vertrauenswürdigkeit des generierten Codes sowie Kompatibilität mit bestehenden Entwicklungsprozessen. Auch die Rechenleistung, die für das Training umfangreicher Reinforcement Learning Modelle notwendig ist, stellt eine technische und wirtschaftliche Hürde dar, die im laufenden Fortschritt der Hardware-Technologie jedoch zunehmend lösbar erscheint.Langfristig gesehen könnte die Kombination großer Sprachmodelle mit intelligenten Lernverfahren die Art und Weise revolutionieren, wie Software geschrieben und optimiert wird.

![GitHub Helping Users Work Together (2013) [video]](/images/606033DB-4397-4F1A-B8B9-F94CA1699256)