Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat die Grenzen künstlicher Intelligenz in sprachverstehenden und generativen Aufgaben neu definiert. Doch trotz ihrer beeindruckenden Fähigkeiten stoßen LLMs bei der eigenständigen Informationssuche oft an Grenzen. In vielen Anwendungen ist die Fähigkeit, relevante Informationen aus externen Quellen zu suchen und effektiv in die Modelle zu integrieren, entscheidend für die Qualität der Ergebnisse. Die direkte Nutzung von realen Suchmaschinen in der Trainingsphase hat bisher vielversprechende Ergebnisse erzielt, leidet jedoch unter Herausforderungen wie der unvorhersehbaren Qualität der zurückgelieferten Dokumente und hohen Kosten durch API-Nutzung. Genau an diesen Punkten setzt ZeroSearch an – ein neuartiges Framework, das die Suchkompetenz von LLMs gezielt fördert, ohne dass sie tatsächlich online suchen müssen.

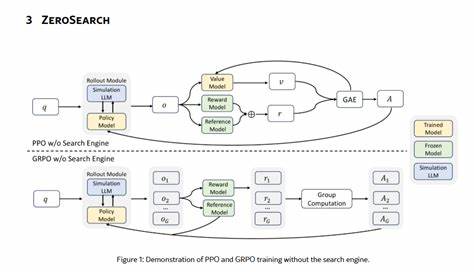

Stattdessen werden Suchvorgänge simuliert, wodurch Kosten reduziert und die Trainingsqualität stabilisiert werden können. ZeroSearch basiert auf der Idee, dass es möglich ist, Suchprozesse durch KI-generierte Informationen nachzubilden, welche sowohl nützliche als auch absichtlich weniger hilfreiche Dokumente enthalten. Diese Simulation dient dazu, das Modell schrittweise an immer anspruchsvollere Suchsituationen anzupassen. Zu Beginn erfolgt ein leichtgewichtiges überwachtens Fein-Tuning, das das Sprachmodell dazu befähigt, Dokumente zu erzeugen, die inhaltlich auf die Suchanfrage abgestimmt sind. Anschließend wird im Rahmen eines auf Reinforcement Learning (RL) basierenden Trainings eine Curriculum-basierte Rollout-Strategie eingesetzt, die systematisch die Qualität der generierten Dokumente verschlechtert.

Dadurch wird das Modell herausgefordert, komplexere Schlussfolgerungen und Zuordnungen zu treffen, um relevante Informationen trotz schwieriger Rahmenbedingungen zuverlässig zu filtern. Die Notwendigkeit eines solchen Vorgehens ergibt sich aus zwei Hauptproblemen beim Einsatz realer Suchmaschinen in der LLM-Trainingsphase. Zum einen sind externe Suchdienste nicht darauf ausgelegt, konstant dokumentenqualität zu liefern. Die Ergebnisse können durch Spam, veraltete Inhalte oder irrelevante Treffer verfälscht werden, was den Trainingsprozess instabil macht. Zum anderen verursachen massive Abfragen bei Suchmaschinen schnell enorme Kosten, die den kommerziellen Einsatz und die Skalierung von RL-basierten Trainingsmethoden stark einschränken.

ZeroSearch umgeht diese Schwierigkeiten clever durch eine interne Simulationsumgebung, die Suchprozesse nachvollziehbar und kontrollierbar macht. Besonders bemerkenswert ist, dass ZeroSearch nicht etwa nur bei kleinen Modellen funktioniert. Experimente zeigen, dass ein mittelgroßes 7-Milliarden-Parameter-Modell im ZeroSearch-Framework vergleichbare Ergebnisse wie eine echte Suchmaschine erzielt. Ein 14-Milliarden-Parameter-Modell kann diese sogar übertreffen. Diese Resultate belegen die Effizienz der Methode und legen nahe, dass Onlinedienste für viele Anwendungen bald durch interne Suchsimulationen ergänzt oder ersetzt werden könnten.

Ein weiterer Vorteil von ZeroSearch ist die breite Kompatibilität mit unterschiedlichen Modellen. Die Methodik lässt sich sowohl auf Basismodelle als auch auf bereits auf spezielle Aufgaben abgestimmte, sogenannte instruction-tuned Modelle anwenden. Zudem ist ZeroSearch flexibel in Bezug auf die eingesetzten RL-Algorithmen und kann in verschiedene Trainingsparadigmen integriert werden. Diese Vielseitigkeit macht es zu einer vielversprechenden Alternative für Entwickler und Forscher, die die Suchkompetenz von LLMs verbessern möchten, ohne die hohen Kosten und Risiken realer Suchanfragen in Kauf nehmen zu müssen. Darüber hinaus fördert ZeroSearch indirekt die Entwicklung von Modellen, die auch mit fehlerhaften, unvollständigen oder widersprüchlichen Informationen besser umgehen können.

Durch die sukzessive Verschlechterung der Simulationsqualität werden LLMs darauf trainiert, Robustheit zu entwickeln und sich nicht ausschließlich auf perfekt abgestimmte Dokumente zu verlassen. Diese Eigenschaft ist in der Praxis von unschätzbarem Wert, denn echte Informationsumgebungen sind selten ideal und verlangen stets eine gewisse Fehlertoleranz. Die technische Ausgestaltung des ZeroSearch-Frameworks beruht auf der Kombination von überwachten Lerntechniken mit RL-Mechanismen. Anfangs wird das Modell mit Beispielfragen und relevanten Dokumentantworten trainiert, um eine Grundfähigkeit in der Generierung passender Informationen zu erlangen. In der darauffolgenden RL-Phase erfolgt eine dynamische Anpassung, in deren Verlauf die Modellantworten anhand unterschiedlicher Kriterien bewertet und optimiert werden.

Die Curriculum-Strategie stellt sicher, dass die Schwierigkeit kontrolliert ansteigt – ähnlich dem Prozess des menschlichen Lernens, bei dem man erst Grundlagen beherrscht, bevor komplexere Fragestellungen gemeistert werden. Insgesamt adressiert ZeroSearch zwei zentrale Herausforderungen der Integration von Suchfunktionalität in große Sprachmodelle und stellt dabei eine innovative Lösung dar, die sowohl die Qualität als auch die Wirtschaftlichkeit im Blick behält. Die Möglichkeit, Suchfähigkeiten ohne Live-Suchaufrufe anzureizen, könnte die Zukunft der KI-gestützten Informationsverarbeitung maßgeblich verändern. Die zukunftsweisenden Ergebnisse, die mit ZeroSearch bereits erzielt wurden, regen auch dazu an, weiterführende Forschung in verwandten Bereichen zu intensivieren. Beispielsweise könnte die Kombination von ZeroSearch mit multimodalen Datenquellen, wie Bild- oder Videoinhalten, die Breite und Tiefe der LLMs weiter steigern.

Ebenso ist die Integration in interaktive Systeme denkbar, in denen der KI-Assistent eigenständig nach Informationen „imitiert“ und darauf basierend komplexe Aufgaben löst. ZeroSearch stellt damit einen bedeutenden Schritt dar, um die Barrieren zwischen groß angelegter Informationssuche und effizienter Modellanpassung zu überwinden. Während herkömmliche Methoden teuer und fehleranfällig sind, eröffnet diese neue Technik eine nachhaltige Perspektive. Für Unternehmen und Forschungseinrichtungen ergeben sich so Chancen, leistungsfähige, suchfähige LLMs zu entwickeln, die schneller, kostengünstiger und robuster arbeiten. Zukünftige Entwicklungen könnten ZeroSearch weiter verbessern, indem noch realistischere Simulationen entwickelt und der Curriculum-Ansatz verfeinert werden.