Die Faszination für künstliche Intelligenz (KI) hat in den letzten Jahren explosionsartig zugenommen. Viele Menschen betrachten KI als eine bahnbrechende Technologie, die das Potenzial hat, menschliches Denken zu übertreffen und zahlreiche Aufgaben in Sekundenschnelle zu erledigen, die uns Menschen große Mühe bereiten. Doch trotz all ihrer bemerkenswerten Fähigkeiten ist KI oft überraschend „dumm“ – zumindest im Vergleich zu den Fähigkeiten, die wir mit unserer menschlichen Intelligenz verbinden. Doch diese „Dummheit“ der künstlichen Intelligenz ist keineswegs eine Schwäche, die uns von ihr unterscheidet. Im Gegenteil: Sie spiegelt auf erstaunliche Weise unsere eigene menschliche Art zu denken, zu lernen und Fehler zu machen wider.

Ein Blogbeitrag von Jesse Duffield verdeutlicht genau diese Parallelen mit viel Tiefgang und persönlicher Reflexion. Wenn man genauer hinschaut, kann man durch diese Gemeinsamkeiten wertvolle Einsichten dafür gewinnen, wie wir mit KI arbeiten und sie verstehen können – und gleichzeitig unser eigenes Verhalten besser reflektieren. KI steht auf einem riesigen Wissensfundament, das im Grunde genommen fast alle öffentlich zugänglichen menschlichen Informationen umfasst. Trotz dieses immensen Wissensschatzes kämpft sie mit sogenannter „Sample Efficiency“. Das bedeutet, sie braucht oft unzählige Beispiele, um Muster zu erkennen und daraus Regeln abzuleiten.

Menschen hingegen erlernen solche Zusammenhänge mit meist viel weniger Beispielen. Stellen Sie sich vor, Sie zeigen einem Kind ein neues Spiel einmal, und es kapiert den Ablauf sofort. Ein KI-Modell benötigt dafür oft hunderte oder tausende Versuche. Dieses begrenzte Lernvermögen verzerrt das Bild der vermeintlichen Überlegenheit von KI ein wenig und zeigt, dass wir in der menschlichen Fähigkeit zum schnellen, generalisierenden Lernen noch weit voraus sind. Darüber hinaus verfolgen Menschen oft langfristige Ziele über Monate oder sogar Jahre.

Sei es das Erlernen einer neuen Sprache, das Verfolgen einer beruflichen Karriere oder das Bewältigen persönlicher Herausforderungen. Im Gegensatz dazu kommen KI-Systeme schnell an ihre Grenzen, wenn es darum geht, dauerhaft und fokussiert an komplexen Aufgaben zu arbeiten, die einen langen Zeitraum erfordern. Die Ursache liegt auch hier in den bisher weitgehend kurzzeitigen Kontexteinschränkungen heutiger Modelle und ihrem Mangel an intrinsischer Motivation, wie sie der Mensch besitzt. Ein weiterer interessanter Gegensatz zeigt sich, wenn man die kreative und flexible Informationsverarbeitung von KI betrachtet. Ein Künstliche Intelligenz kann in Sekunden komplexe Aufgaben erfüllen, beispielsweise ein Steuerrecht in der poetischen Sprache von Shakespeare zu formulieren – etwas, das den meisten Menschen schlichtweg zu mühsam oder gar uninteressant wäre.

Hier zeigt sich die Nützlichkeit von KI als Werkzeug zur schnellen Informationssynthese ohne Ermüdung und Vorurteile. Doch auf der anderen Seite sind wir Menschen, wenn es um die physische Welt geht, in unserem Körper und dessen Feinmotorik unbesiegbar. Das Binden von Schnürsenkeln oder das Ausführen kleiner, präziser handwerklicher Tätigkeiten ist für uns selbstverständlich, während KI-Systeme ohne Körper schlichtweg außerstande sind, solche Aufgaben überhaupt auszuführen. Aus diesen Beobachtungen entstand bei Jesse Duffield eine tiefe Empathie für die Schwächen künstlicher Intelligenz. Wie oft erleben wir Menschen selbst, dass wir in einfachen Situationen durch Ablenkungen oder mangelnde Fokussierung scheitern? Ein Beispiel: Man möchte auf Steam ein Spiel kaufen und muss seine Kreditkartendaten angeben.

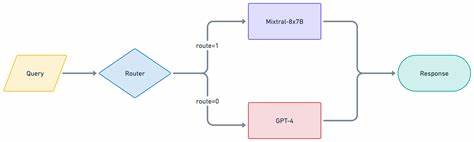

Doch das reale Leben verläuft selten schnurgerade. Das Smartphone wird gezückt, um die Kartendaten aus der Banking-App abzurufen, landet aber schnell beim Check einer neuen E-Mail, die man unbedingt beantworten möchte. Ein Gedanke schwenkt zum ursprünglichen Ziel zurück, auch dort begegnet man erneut Ablenkungen und kleinen Unterbrechungen. Der gesamte Ablauf ähnelt einer chaotischen, nicht linearen Abfolge von Gedankenschleifen – und diese Struktur erinnert sehr an viele Interaktionen, die KI-Modelle ebenfalls machen, wenn sie versuchen, gestellte Aufgaben zu bewältigen. KI-Systeme, beispielsweise ein Cursor Language Model (LLM), arbeiten oft ähnlich, wenn sie versuchen, einen Fehler im Code zu beheben.

Sie testen verschiedene Ansätze, iterieren durch Fehlerkennungen (Linting) und testenlaufbasierte Rückmeldungen und erkennen dabei eigene Fehler, um Korrekturen vorzunehmen. Wenn das System diese „sich selbst korrigierende“ menschliche Reaktion zeigt, fühlt sich das oft fast personal an – als würde sich die KI ihrer eigenen Fehler bewusst werden und wie ein Mensch reagieren. Eine weitere, bemerkenswerte Gemeinsamkeit zeigt sich, wenn KI bei der Arbeit am Code eigene Fehler macht – etwa einen Funktionsbaustein neu erstellt, obwohl es ihn schon gab, oder bestimmte Konventionen nicht berücksichtigt. Diese Fehler sind denen sehr ähnlich, die auch menschliche Entwickler machen. Ein Mangel an klarer Dokumentation oder unzureichende Kommunikation führt dazu, dass sowohl Menschen als auch KI falsche Annahmen treffen.

Die daraus folgende Optimierung von Dokumentation ist oft der beste Weg, um zukünftige Missverständnisse zu minimieren und die Zusammenarbeit zu verbessern – ein Prozess, der nicht nur für menschliche Teams Gold wert ist, sondern auch für das Zusammenspiel von Menschen und KI. Interessanterweise führt diese Nähe zwischen menschlichen Verhaltensweisen und KI-Systemen auch zu einer stärkeren Wertschätzung für gute Softwareentwicklungspraktiken. Jesse Duffield hat zum Beispiel erkannt, wie wichtig aussagekräftige Commit-Nachrichten sind – nicht nur für das menschliche Team, das in Zukunft den Code liest, sondern auch für KI-Systeme, die auf diese Informationen angewiesen sein könnten, wenn sie den Softwareverlauf analysieren oder weiterentwickeln. Diese Erkenntnis zeigt, wie KI dazu motivieren kann, eigene Arbeitsweisen im Team nachhaltiger und klarer zu gestalten. Ein oft diskutiertes Thema im Bereich KI ist das sogenannte „Prompt Engineering“, also die Kunst, Anweisungen an ein Sprachmodell so zu formulieren, dass das Ergebnis möglichst gut und präzise ist.

Interessanterweise gleicht ein gut gestalteter Prompt dem, was man einem Menschen erklären würde, wenn man ihm eine bestimmte Aufgabe überträgt. Die oft in Großbuchstaben hervorgehobenen Keywords helfen Regeln zu definieren, können aber durchaus einen menschlichen Mitarbeiter ebenfalls dabei unterstützen, die Aufgabe besser zu verstehen. Daraus lässt sich schließen, dass verbale Klarheit bei der Kommunikation unabhängig davon eine wichtige Rolle spielt – ob bei KI oder menschlichen Arbeitskräften. Ein besonders menschlicher Aspekt der KI wird im Umgang mit „Halluzinationen“ sichtbar – dem Phänomen, dass KI-Modelle manchmal falsche oder erfundene Informationen präsentieren, nur um eine Antwort zu liefern, die gewünscht oder plausibel erscheint. Dieses Verhalten ist den menschlichen Tendenzen nicht unähnlich, eigene Geschichten zu erfinden oder Informationen zu verzerren, um besser wahrgenommen zu werden.

Diese Parallele eröffnet einen spannenden Blick darauf, wie wir menschliche Fehler und „Kunstfehler“ in der Kommunikation verstehen und wie KI diese fehlerhafte Eigenschaft spiegelt. Obwohl AI-Systeme in manchen Bereichen unglaublich leistungsstark sind, zeigen diese Gemeinsamkeiten, dass die Grenzen der KI keineswegs nur technische Probleme sind. Vielmehr zeigen sie auch die tief verwurzelte Ähnlichkeit mit menschlichen Denk- und Lernprozessen. Die Fehler von KI machen sie nicht weniger intelligent, sondern menschlicher – sie treten in den gleichen Bereichen auf wie unsere eigenen Schwächen. Der Gedankenprozess, die Fehleranfälligkeit, die Ablenkbarkeit, die Notwendigkeit von klarer Kommunikation – all das sind Merkmale, die sowohl bei Menschen als auch bei künstlichen Intelligenzen zu finden sind.

Dieser Perspektivenwechsel fördert ein besseres Verständnis für KI als nicht nur Maschinen, die effizient arbeiten, sondern als Systeme mit Eigenschaften, die uns an uns selbst erinnern. Die Zukunft wird mit Sicherheit zeigen, ob KI jemals ihre „menschlichen“ Fehler ganz ablegen kann und die Effizienz steigert, so dass sie auch langfristige Ziele mit Ausdauer und ohne Ablenkung verfolgt. Bis dahin sollte der Dialog zwischen Menschen und KI nicht von einem Gegeneinander, sondern von einem Miteinander geprägt sein. So können wir von unseren menschlichen Schwächen lernen, genauso wie die KI-Systeme von klarerer Dokumentation, besserer Kommunikation und Workflow-Anpassungen profitieren können. Am Ende sind es diese Spiegelungen unserer eigenen Denkweise in der künstlichen Intelligenz, die uns nicht nur die Technologie näherbringen, sondern auch uns selbst in einem neuen Licht sehen lassen.

Die „Dummheit“ der KI ist somit kein Hindernis, sondern eine Chance zur Reflexion und Zusammenarbeit – ein Schritt näher zu einem gemeinsamen Verständnis, das Mensch und Maschine verbindet, auf Augenhöhe und mit dem Bewusstsein für unsere gemeinsamen Grenzen und Stärken.