Die Migration von einer verteilten Datenbank wie CockroachDB zu PostgreSQL stellt viele Unternehmen vor große Herausforderungen, bietet jedoch gleichzeitig zahlreiche Vorteile. Insbesondere wenn sich das Geschäftsmodell und die Datenanforderungen verändern, ist der Wechsel zu einer bewährten, leistungsstarken relationalen Datenbanklösung ein sinnvoller Schritt. In den letzten Jahren zeigte sich, dass CockroachDB besonders durch horizontale Skalierung und Multi-Region-Unterstützung punktet. Dennoch steigen mit wachsender Nutzung sowohl die Kosten als auch die Komplexität der Wartung, was zu Engpässen und ineffizientem Arbeiten führen kann. Die Entscheidung zur Migration ist häufig eine Folge zunehmender Kosten bei gleichzeitigen Performance-Einbußen.

Kostenfaktoren können insbesondere bei CockroachDB deutlich ansteigen, da die Infrastruktur für verteilte Systeme aufwendiger ist und eine optimale Hardware- und Netzwerkumgebung benötigt. Für Unternehmen, die bislang keine Multi-Region-Datenhaltung benötigen und vor allem in einer einzelnen Region und mit einfachen transaktionalen Abfragen arbeiten, ist der Nutzen einer solchen komplexen Systemarchitektur begrenzt. Somit stellt der Umstieg auf PostgreSQL eine attraktive Alternative dar, um Kosten zu senken und gleichzeitig die Performance zu steigern. Einer der zentralen Aspekte bei der Migration ist das Datenbankschema. Zwischen verteilten Datenbanken und traditionellen relationalen Systemen bestehen auch wenn beide SQL-kompatibel sind, oft komplexe Unterschiede in der Datenstruktur, der Byte-Codierung und der Ausführung von Abfragen.

Dies erfordert präzise Vorbereitung und Tests, damit Funktionen und Datenintegrität erhalten bleiben. Der Einsatz eines ORM-Tools wie Prisma erleichtert hierbei das Handling von Migrationen, da sich die Datenbank logische Schichten abstrahieren lassen und Operationen vergleichbar ablaufen können. Eine große Herausforderung bei der Migration waren die zeitlichen Limits während der Anwendung von Datenbankschemamigrationen in CockroachDB. Insbesondere bei wachsenden Datenmengen kam es wiederkehrend zu Timeouts, welche wiederum unnötige manuelle Arbeit und einen blockierten Deployment-Prozess nach sich zogen. Diese Probleme hatten nicht nur Auswirkungen auf Entwicklerunabhängige Entwicklungszeiten, sondern sorgten auch für betriebliche Risiken, weil Zugriffe ins System durch Migrationssperren beeinträchtigt wurden.

Diese Limitierungen führten sogar dazu, dass Updates beziehungsweise Versions-Upgrades der CockroachDB aus Support- und Kompatibilitätsgründen blockiert blieben, was langfristig die Wartbarkeit der Datenbank erschwerte. Neben der reinen Datenzugriffsperformance litten auch andere Komponenten wie ETL-Prozesse unter den Limitierungen der verteilten CockroachDB-Umgebung. Die Integration von Daten-Extraktions- und Ladeprozessen, die für Analysen oder Backups essentiell sind, wurde durch Timeouts und instabile Verbindungen erschwert. Die Unterstützung durch ETL-Tools für CockroachDB war begrenzt: Airbyte war einer der wenigen verfügbaren Connectoren, allerdings noch im Alpha-Stadium und mit bekannten Problemen wie Memory Leaks, die die Stabilität beeinträchtigten. Beim direkten Vergleich der Abfragegeschwindigkeiten zwischen den Systemen zeigten sich differenzierte Ergebnisse.

Während einige Abfragen durch CockroachDBs effizienten Abfrageoptimierer schneller ausgeführt wurden, war das Gegenteil bei komplexeren, von ORM generierten Abfragen der Fall. Insbesondere durch konvolutiven SQL-Code, der neben zahlreicher Spalten auch diverse geschachtelte Joins und Aggregationen enthielt, führte CockroachDB zu vollständigen Tabellenscans mit hohen Latenzzeiten. PostgreSQL war in vielen Fällen deutlich schneller, vor allem durch seine Optimierungsmöglichkeiten und den Einsatz moderner Werkzeuge wie PGAnalyze, die eine zielgerichtete Performanceverbesserung ermöglichen. Darüber hinaus beeinflussten typische Probleme der CockroachDB-Installation den Arbeitsalltag negativ. Ein Beispiel ist die nicht immer intuitive Verwaltung von ungenutzten Indizes, die für Entwickler häufig Verwirrung stiftete.

Zudem war das Abbrechen laufender Abfragen bei CockroachDB deutlich komplizierter: Während klassische SQL-Clients wie TablePlus in PostgreSQL einfaches Abbrechen erlauben, war bei CockroachDB teilweise ein manueller Eingriff über die Admin-Konsole nötig, was den Administrationsaufwand erheblich erhöhte. Auch die durchgängige Integration des Supports bei Ausfällen war problematisch, da sich CockroachDBs Supportportal und die Hauptplattform separat bedienen ließen und Reaktionszeiten im kritischen Moment lang waren. Netzwerkintegration und VPC-Konfigurationen zeigten sich als weiterer Stolperstein: Die Anbindung an Tailscale als VPN-Lösung führte zu intermittent auftretenden DNS-Auflösungsschwierigkeiten und Verbindungsabbrüchen in verschiedenen Umgebungen, von der CI bis zu lokalen Clients. Solche Probleme ließen sich trotz ausführlicher Analyse nicht nachhaltig beheben und traten permanent auf. Nach der Migration zu PostgreSQL waren derartige Probleme nicht mehr vorhanden, was die Stabilität und Entwicklereffizienz steigerte.

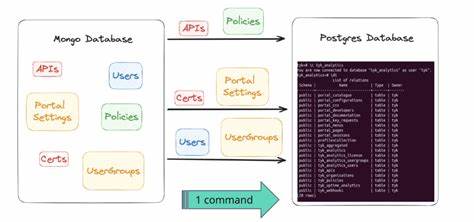

Die tatsächliche Durchführung der Migration erforderte kreatives Engineering. Aufgrund der fehlenden stabilen ETL-Tools wurde intern ein maßgeschneiderter Migrationsprozess entwickelt, der auf dem vielversprechenden Laufzeitumfeld Bun basierte. Dieses Setup ermöglichte es, Daten tabellenweise aus CockroachDB heraus in CSV-Dateien zu exportieren und anschließend über parallelisierte Prozesse in PostgreSQL einzuspielen. Die Komplexität ergab sich aus unterschiedlichen Datentypencodierungen bei JSON- und Array-Spalten, die von CockroachDB anders gehandhabt wurden als von PostgreSQL. Mit einer eigens entwickelten Pipeline zur CSV-Transformation konnten diese Unterschiede automatisiert ausgeglichen werden, sodass Datenkonsistenz und Benutzererfahrung erhalten blieben.

Während der produktiven Migration wurden Wartungsfenster genutzt, um bei minimaler Downtime die Datenbank auf den neuen PostgreSQL-Cluster umzuschichten. Die Performance der Migration war dabei überraschend gut: Das komplette Einspielen von rund 100 Millionen Zeilen großer Tabellen dauerte lediglich etwa 15 Minuten und führte zu keinen Datenverlusten. Nach der Migration wurde die Systemperformance messbar besser, etwa mit einem sofortigen Rückgang der aggregierten Anfrageverzögerungen um ein Drittel. Langfristig zeigte sich der Wechsel zu PostgreSQL für das Unternehmen als erhebliche Kostenersparnis mit einem Jahresbudget, das um über 100.000 US-Dollar sank.

Die verbesserte Effizienz ermöglichte zudem schnelle Anpassungen und Optimierungen der Abfragen, wodurch sich der technologische Vorsprung im Produkt weiterhin ausbauen lässt. Die großen Open-Source- und kommerziellen Tools rund um PostgreSQL bieten im Vergleich zu CockroachDB eine größere Tiefe und Vielfalt, was Wartung, Monitoring und Weiterentwicklung erleichtert. Insgesamt verdeutlicht die Migration von CockroachDB zu PostgreSQL, wie wichtig es ist, nicht nur technische Innovationen, sondern auch konkrete betriebliche Anforderungen und Kosten im Blick zu behalten. Für Unternehmen mit wachsendem Datenvolumen, begrenzten Multi-Region-Anforderungen und Fokus auf transaktionale Abläufe kann ein gut geplanter Umstieg auf PostgreSQL zu deutlichen Verbesserungen führen. Gleichzeitig empfiehlt sich eine enge Abstimmung zwischen Entwicklern, Datenbankadministratoren und Betriebsteams, um Migrationen risikoarm und erfolgreich zu gestalten.