Change Data Capture (CDC) ist seit Jahren ein essenzielles Verfahren zur Datenintegration und Synchronisation zwischen Datenbanken, Data Warehouses und weiteren Systemen. Dennoch stehen viele Unternehmen vor bedeutenden Herausforderungen, wenn es darum geht, CDC-Systeme zuverlässig, kosteneffizient und mit ausreichender Auditierbarkeit zu betreiben. Die steigenden Anforderungen durch den modernen Daten-Stack machen eine grundlegende Neubewertung der bisherigen CDC-Architekturen erforderlich. Eine neue Referenzarchitektur antwortet auf diese Anforderungen mit einem Ansatz, der Skalierbarkeit, Datenkonsistenz und betriebliche Effizienz in den Mittelpunkt stellt.Die Bedeutung von Change Data Capture liegt auf der Hand: Unternehmen müssen Daten in Echtzeit oder nahezu Echtzeit verarbeiten, um aktuelle Geschäftsentscheidungen treffen zu können, Anwendungen mit frischen Daten zu versorgen und Insights aus Data Lakes und Data Warehouses verfügbar zu machen.

Vor allem werden dank CDC aufwändige Batch-Prozesse ersetzt, die mit hohen Latenzen und großem Verwaltungsaufwand verbunden sind. CDC schafft eine Brücke, die Datenquellen und -senken nahtlos miteinander verbindet, indem Änderungen an Daten kontinuierlich erfasst und übertragen werden.Doch mit zunehmender Verbreitung und wachsender Datenmenge treten Schwachstellen und Risiken herkömmlicher CDC-Architekturen zutage. Ein zentrales Problem ist der Umgang mit Transaktionslogs, zum Beispiel dem Write-Ahead Log (WAL) von PostgreSQL. Diese Logs wachsen oft unkontrolliert, wenn nicht rechtzeitig bestätigt wird, dass eine Änderung erfolgreich verarbeitet wurde.

Besonders kritisch wird es, wenn kleine, selten aktualisierte Tabellen eingebunden sind oder die Zielsysteme zeitweise nicht erreichbar sind. Das kann zu einer Überlastung des Speicherplatzes führen und letztendlich die Verfügbarkeit der Produktionsumgebung gefährden.Zusätzlich erschweren manuelle Backfills den Betrieb, wenn neue Datenziele hinzukommen und historische Daten repliziert werden müssen. Ohne eine intelligente Nutzung bereits vorhandener Logbestände müssen aufwändige Datenbankabfragen erfolgen, die nicht nur Ressourcen binden, sondern auch die Systemperformance beeinträchtigen können. Ebenso stellen Schemaänderungen einen wiederkehrenden Stolperstein dar.

Veränderungen an Tabellenstrukturen – etwa neue Spalten oder veränderte Datentypen – führen häufig zu Pipeline-Ausfällen oder erfordern manuellen Aufwand zur Fehlerbehebung.Um diese Herausforderungen zu meistern, bedarf es einer CDC-Architektur, die mehrere zentrale Anforderungen erfüllt: Transaktionsbestätigungen müssen zeitnah erfolgen, sodass die Loggröße kontrolliert bleibt. Die Datenübertragung soll in Echtzeit erfolgen, unterstützt durch Heartbeat-Signale, die die Systemgesundheit überwachen. Fortschrittsmarkierungen, sogenannte Watermarks, helfen bei der Wiederherstellung und gewährleisten Datenkonsistenz. Wesentlich ist zudem die dauerhafte und sichere Speicherung der Transaktionslogs in einer vom Quellsystem unabhängigen und ausfallsicheren Umgebung, die flexible Datenwiederholungen und zeitliche Analysen erlaubt.

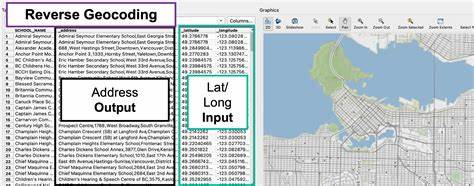

Die neue Referenzarchitektur setzt an diesen Punkten an und sieht vor, dass Echtzeit-CDC-Erfassungen direkt in langlebigen, externen Objekt-Storage-Lösungen abgelegt werden. Dienste wie AWS S3, Google Cloud Storage oder Azure Blob Storage bieten dafür eine optimale Basis. Durch die Nutzung cloud-nativer Objektspeicher wird nicht nur ein skalierbares und kosteneffizientes Log-Management realisiert, sondern zugleich die Resilienz gegenüber Datenverlust erhöht. Die Architektur trennt konsequent die Verarbeitung und Speicherung von der Materialisierung. So können Prozesstransaktionslogs unabhängig vom Quellsystem erneut abgespielt oder an neue Konsumenten ausgeliefert werden, ohne den Produktionsbetrieb zu beeinträchtigen.

Diese Entkopplung bringt massive Vorteile für Unternehmen jeder Größe. Die Skalierbarkeit befreit von den Begrenzungen klassischer Transaktionslog-Systeme, die oftmals nicht für große Datenvolumen oder selten aktualisierte Tabellen ausgelegt sind. Die dauerhafte Speicherung im Objekt-Storage erlaubt eine flexible Zeitreise-Funktion (Time Travel), die zum Beispiel bei Compliance-Anforderungen, Audits oder Fehleranalysen unerlässlich ist. Zudem wird die Betriebsführung vereinfacht, da komplexe manuelle Backfills automatisiert ablaufen können und Schemaänderungen intelligent gehandhabt werden.Ein prominentes Beispiel für eine solche neuartige Lösung ist Estuary Flow.

Die Plattform kombiniert Echtzeit-CDC mit einer robusten Cloud-Objekt-Speicherung und setzt auf Automatisierung bei Backfills und Schema-Evolutionen. Nutzer können ihre bevorzugten Speicherlösungen selbst wählen und profitieren von der vollständigen Verwaltung und Orchestrierung der CDC-Pipelines ohne großen eigenen Engineering-Aufwand. Für Unternehmen mit hohen Compliance-Anforderungen ist die Wahl des Speicherorts und damit die Datenhoheit ein weiterer Vorteil. Gleichzeitig reduziert sich durch die cloud-native Architektur der Gesamtaufwand und die Kosten für den Datentransport, da Cross-Availability-Zone (AZ) Netzwerkverkehr minimiert wird.Traditionelle Alternativen wie das Zusammenspiel von Debezium und Kafka bieten zwar größere Flexibilität und Self-Hosting-Möglichkeiten, bringen aber signifikanten organisatorischen und technischen Verwaltungsaufwand mit sich.

Die Wiedergabe von Logs erfordert häufig die Nutzung produktiver Kafka-Broker, was die Systemkapazität einschränkt. Zudem fehlt oft eine native Unterstützung für automatisierte Backfills und die Handhabung von Schema-Dynamiken ist eher manuell und fehleranfällig. Tiered Storage in Kafka gilt zudem als problematisch, da Kompaktierungsprozesse oft nicht optimal ablaufen und damit Speicherressourcen ineffizient genutzt werden.Angesichts der wachsenden Datenmengen, der steigenden Anforderungen an Systemstabilität und die Notwendigkeit zur Auditierbarkeit rückt eine moderne CDC-Architektur mit Fokus auf Echtzeit, Langlebigkeit und Flexibilität in den Vordergrund. Unternehmen müssen die Balance finden zwischen technischem Aufwand, Kosten und der Sicherstellung von Datenintegrität.

Die Möglichkeit, Daten historisch abrufen zu können, ohne dabei die Produktionssysteme zusätzlich zu belasten, ist ein entscheidender Wettbewerbsvorteil.Zudem sorgt die Integration automatischer Backfills und der Unterstützung für Schemaänderungen dafür, dass Datenintegrationsprozesse leichter zu warten sind und weniger anfällig für Ausfälle und Fehler. Das entlastet Data Engineering Teams, die so mehr Kapazitäten dafür gewinnen, geschäftlichen Mehrwert aus den Daten zu generieren.Das neue Architekturmodell trägt dem Trend Rechnung, Datenpipelines cloud-nativ, skalierbar und wartbar zu gestalten. Best Practices setzen auf die Entkopplung von Datenaufnahme und -verarbeitung sowie auf die Nutzung bewährter Cloud-Infrastrukturen für Speicher und Sicherheit.

Transparente und auditierbare Datenflüsse schaffen Vertrauen in die Digitalisierungsprozesse und erfüllen regulatorische Anforderungen.Insgesamt zeigt sich, dass moderne CDC-Architekturen nicht nur Technologie-Innovationen sind, sondern strategische Enabler für datengetriebene Organisationen. Firmen können dadurch effizienter, agiler und resilienter werden – ein entscheidender Faktor im Wettbewerb von heute und morgen. Die Zukunft der Change Data Capture liegt klar in skalierbaren, automatisierten Lösungen wie Estuary Flow, die traditionelles CDC neu denken und damit eine breite Akzeptanz im modernen Daten-Ökosystem ermöglichen.