In der Welt der Künstlichen Intelligenz nehmen große Sprachmodelle (Large Language Models, kurz LLMs) eine zentrale Rolle ein. Insbesondere für Anwendungen wie natürlichsprachliche Interaktion, Textgenerierung oder datengestützte Automatisierung sind diese Modelle unverzichtbar. Doch die Herausforderung bei der Nutzung großer Sprachmodelle liegt vor allem in ihrer Rechenintensität und der damit verbundenen langsamen Inferenzgeschwindigkeit. Hier setzt Fastgen an – eine innovative Bibliothek, die Hochdurchsatz-LLM-Inferenz einfach, effizient und skalierbar gestaltet. Fastgen wurde entwickelt, um die Barrieren der Leistung bei der Nutzung von dichten Transformer-basierten Modellen zu überwinden.

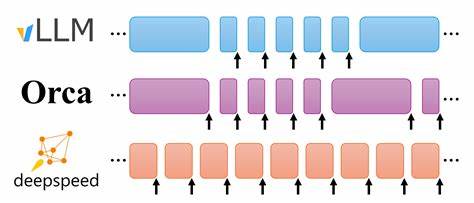

Durch die Implementierung moderner Methoden wie batched inference (stapelweise Verarbeitung mehrerer Anfragen gleichzeitig), der Nutzung von CUDA-Graphs zur Optimierung von GPU-Operationen, paged attention, Chunked Prefills sowie Host-seitigem Key-Value Cache wird eine außergewöhnliche Effizienz erreicht. Besonders beeindruckend ist, dass Fastgen diese Funktionen in einer verhältnismäßig kompakten Codebasis von nur etwa 3000 Zeilen umsetzt, was sie zu einer leicht integrierbaren Lösung für verschiedenste Systeme macht – etwa in Reinforcement Learning (RL) Loops oder bei der automatisierten Erzeugung synthetischer Daten. Konkret unterstützt Fastgen eine Reihe populärer HuggingFace-Modelle, darunter Llama 3.1 8B, Mistral 7B und 8B, R1-Llama in verschiedenen Größen bis zu 70 Milliarden Parametern sowie die Qwen-Modelle in Varianten von 7B bis 14B. Diese breite Auswahl zeigt, wie flexibel die Bibliothek für unterschiedliche Anforderungen ist und sowohl kleinere als auch extrem große Modelle effizient bedienen kann.

Die Benchmark-Daten sprechen für sich: Auf einer Nvidia H100 GPU erreicht Fastgen beeindruckende Token-Durchsätze, die mit anderen führenden Systemen wie vLLM konkurrieren können. Beispielsweise erzielt Fastgen mit dem Mistral 7B Modell eine Verarbeitungsgeschwindigkeit von 3430 Tokens pro Sekunde, was leicht über den 3390 Tokens pro Sekunde von vLLM liegt. Mit dem Qwen2.5 14B Modell auf einer H100 wird mit 1700 Tokens pro Sekunde ein Spitzenwert erreicht, der ebenso mit vLLM vergleichbar ist. Besonders bei Modellen wie Llama 70B mit multi-GPU-Konfigurationen zeigt Fastgen seine Skalierungsmöglichkeiten, indem es ebenfalls auf sehr hohem Niveau mit 2260 Tokens pro Sekunde performt.

Ein Grund für die hohe Leistungsfähigkeit ist die clevere Nutzung von CUDA Graphs. Diese Technologie erlaubt es, meist wiederkehrende GPU-Berechnungen als vordefinierte Abläufe abzubilden, wodurch der Overhead für die Steuerung der GPUs reduziert wird. Dies führt zu einer effizienten und schnellen Abarbeitung von Anfragen ohne unnötige Verzögerungen. Ergänzt wird dies durch das Konzept der paged attention, das die Speicherverwaltung während des Attention-Mechanismus optimiert und so auch bei sehr langen Eingaben eine stabile Performance liefert. Darüber hinaus trägt die auf Host-Seite geführte Key-Value Cache (kv-cache) dazu bei, dass bereits berechnete Zwischenergebnisse für zukünftige Inferenzschritte gespeichert werden.

Durch diese clevere Zwischenablage wird der Rechenaufwand minimiert, da nicht jeder Schritt neu berechnet werden muss. Besonders in Anwendungen, in denen Konversationen oder sequenzielle Abfragen verarbeitet werden, reduziert dies maßgeblich die Latenzzeit und beschleunigt die Ausgabe. Der praktische Nutzen von Fastgen wird auch durch die mitgelieferten Hilfstools verdeutlicht. Mit fgchat erhält man eine einfache Kommandozeilen-Chatanwendung, die den unmittelbaren Einstieg in die Interaktion mit unterstützten Modellen ermöglicht. Dies demonstriert nicht nur die Alltagstauglichkeit der Software, sondern auch die leichte Skalierbarkeit und Erweiterbarkeit in realen Umgebungen.

Mit fgserve steht zudem ein minimales OpenAI-kompatibles Chat-API-Serving-Tool bereit, das als Basis für die Integration in eigene Systeme oder zur Entwicklung von Prototypen dient. Die Entwickler von Fastgen ziehen Inspiration aus dem vLLM-Projekt, übernehmen und verfeinern dort erprobte Innovationen wie gepagte Aufmerksamkeit und Chunked Prefills. Dabei lag viel Augenmerk auf einer balancierten Kombination von Performance-Optimierungen und einfacher Nutzbarkeit. Die Dokumentation weist auch auf einen wichtigen Hinweis hin: Bei kurzen Prompts kann die Performance aufgrund des HTTP-Serving-Threads reduziert sein, was durch process-basiertes Parallelisieren eliminiert wird. Somit ist Fastgen speziell für produktive Großanlagen konzipiert, bei denen hohe Auslastung und optimierte Batchgrößen gewährleistet sind.

Ein weiterer Vorteil des Fastgen-Ökosystems ist die Offenheit der Software. Mit einer BSD-3-Clause-Lizenz ist der Code frei verwendbar und anpassbar, was gerade in Forschungs- und Entwicklungskreisen sehr willkommen ist. Dies erlaubt Unternehmen und Entwicklerteams, Fastgen flexibel in ihre Lösungen zu integrieren, individuelle Anpassungen vorzunehmen und das Maximum aus der eigenen Hardware herauszuholen. Zusammenfassend bietet Fastgen eine moderne und wegweisende Lösung zur Hochdurchsatzinferenz von großen Sprachmodellen. Die Kombination aus innovativen Softwaretechniken, Benchmark-Spitzenleistungen und praktischem Nutzen macht die Bibliothek zu einer optimalen Wahl für alle, die effiziente, skalierbare und zugleich einfach zu nutzende LLM-Inferenz benötigen.

Als Bindeglied zwischen state-of-the-art KI-Technologien und realen Anwendungen vereinfacht Fastgen die Implementierung und beschleunigt die Entwicklung von intelligenten Systemen. In einer Zeit, in der Sprachmodelle immer größer und komplexer werden, kann die richtige Infrastruktur einen entscheidenden Wettbewerbsvorteil darstellen. Fastgen zeigt, wie durch tiefgreifende Optimierungen ein Höchstmaß an Leistung erzielt werden kann, ohne dass die Entwicklungszeit unnötig verlängert wird. Somit ist Fastgen nicht nur ein Werkzeug für Experten – es ist der Schlüssel zur schnellen, robusten und produktiven Nutzung von LLMs in zahlreichen Zukunftsindustrien, vom Kundenservice über Machine Learning bis hin zu komplexer Datenanalyse und Automatisierung. Angesichts der ständigen Weiterentwicklung von KI-Modellen gewinnt die effiziente und skalierbare Inferenzsoftware mehr und mehr an Bedeutung.

Fastgen ist ein beeindruckendes Beispiel dafür, wie durch präzise technische Innovationen die vermeintlichen Grenzen der aktuellen Hardware- und Softwarelandschaft überwunden werden können. Es lohnt sich daher, diese Bibliothek von facebookresearch genau im Auge zu behalten und auszuprobieren, um von den Vorteilen moderner Hochdurchsatz-LLM-Inferenz zu profitieren.