In den letzten Jahren haben viele Unternehmen mit dynamischem Wachstum und stetig steigenden Anforderungen an ihre Dateninfrastruktur die Vorteile verteilbarer Datenbanksysteme wie CockroachDB erkannt. Diese Systeme bieten faszinierende Funktionen wie horizontale Skalierbarkeit, Mehrregionen-Deployments und hohe Ausfallsicherheit. Doch die Praxis zeigt, dass trotz dieser technischen Vorzüge die Kosten- und Performanceaspekte bei CockroachDB in manchen Fällen die erhofften Vorteile überschreiten können. Im Folgenden wird detailliert erläutert, welche Erkenntnisse und Erfahrungen eine Firma bei der Migration von CockroachDB zu PostgreSQL gesammelt hat, und welche Erkenntnisse daraus abgeleitet werden können. Ein besonderer Fokus liegt auf strategischen Migrationsschritten, Abwägungen zur Performance sowie den operativen Herausforderungen, die der Prozess mit sich bringt.

Ein zentraler Ausgangspunkt war das rasante Wachstum des Datenvolumens und die damit verbundenen Kosten sowie Performanceprobleme bei CockroachDB. Anfangs wurde die verteilte Architektur als perfekte Lösung für ein multiregionales Set-up gesehen. Insbesondere in Kontexten, in denen durch Regularien wie die Datenschutz-Grundverordnung (DSGVO) eine Datenlokalisation vorgeschrieben wird, bietet CockroachDB theoretisch ideale Voraussetzungen. Allerdings zeigte sich bald, dass viele dieser Anforderungen noch nicht akut waren und das gesamte Datenvolumen zudem in einer einzigen Region verarbeitet wurde. Dadurch entstand die Frage, ob die hohen Kosten und die Komplexität eines verteilten Systems gegenüber einer robusten Monoregionallösung wie PostgreSQL gerechtfertigt sind.

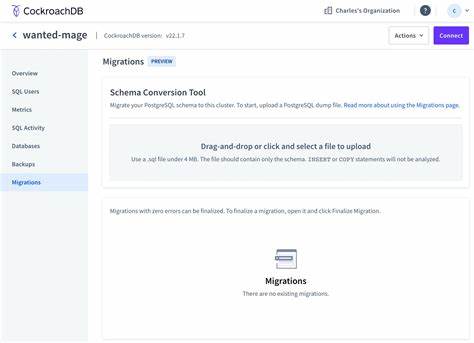

Die tägliche Realität offenbarte signifikante Probleme mit CockroachDB besonders im Bereich der Datenmigrationen. Das von Motion eingesetzte Object-Relational-Mapping-Framework (ORM) Prisma stieß zunehmend an Timeouts beim Anwenden von Datenbankmigrationen. Dies blockierte produktive Deployments für mehrere Stunden, da man gezwungen war, Migrationen manuell direkt über die CockroachDB-Konsole Schritt für Schritt auszuführen. Solche operativen Engpässe führten dazu, dass Entwicklungsteams stark eingeschränkt wurden. Sogar notwendige Software-Updates der Datenbank selbst mussten infolge dieser Blockaden hinausgezögert werden.

Die Folge war ein Stillstand bei der Weiterentwicklung der Datenbankversion, was wiederum zu erschwertem Support führte, da die genutzte Version bereits veraltet war. Neben Migrationsproblemen zeigte sich der ETL-Bereich (Extract, Transform, Load) als weiterer Engpass. Die Einschränkungen bei der Verfügbarkeit und Stabilität von ETL-Tools für CockroachDB – namentlich die noch sehr frühe Alpha-Version eines Airbyte-Connectors mit dokumentiertem Speicherleck – verhinderten eine standardisierte und zuverlässige Datenverarbeitungspipeline. Die Performance der Verarbeitung blieb bei CockroachDB hinter den Erwartungen zurück, und wiederholte Timeout-Fehler im Data-Transfer sorgten für wiederkehrende Ausfälle und Verzögerungen in der Datenaktualisierung. Die Analyse von Einzelfall-Queries offenbarte Unterschiede in der Abfragegeschwindigkeit zwischen den beiden Datenbanksystemen.

Während CockroachDB in Einzelfällen mit seinem Optimierer Vorteile bot und manche komplexe Aggregationen in kürzerer Zeit als PostgreSQL verarbeitete, zeigten viele Alltagsabfragen paradoxerweise bessere Resultate mit PostgreSQL. Die Nutzung von ORM-Generiertem SQL, das häufig besonders komplexe und in Teilen überflüssige SQL-Abfragen erzeugt, führte in CockroachDB durch dessen Query-Planer zumeist zu hohen Latenzen. Zum Teil waren Abfragen in PostgreSQL zwanzig Mal schneller. Die unterschiedliche Leistung hing eng mit der Art der Query-Planer-Optimierungen zusammen. Die im CockroachDB-Query-Planer „magisch“ erscheinenden Anpassungen konnten in der Praxis auch zu vollständigen Tabellen-Scans führen, während PostgreSQL effizientere Ausführungspläne ausarbeitete.

Ein häufiges Problem waren weiterhin UI- und Bedienungsprobleme. So zeigte etwa das UI-Tool von CockroachDB bezüglich nicht genutzter Indizes unklare Empfehlungen an, welche teilweise sogar genutzte Indizes zur Löschung vorschlug. Dies führte zu Unsicherheiten im Entwicklerteam und erschwerten die Wartung. Das Handling von langlaufenden und ressourcenintensiven Abfragen stellte sich als sehr mühselig dar. Während man bei PostgreSQL in vielen SQL-Clients einfach mit einem Klick laufende Abfragen abbrechen kann, erforderte CockroachDB den Fall-Back auf eine komplexere Controller-Oberfläche, welche nicht immer alle Abfragen zuverlässig beendete und teilweise gar zu Ausfällen im Cluster führte.

Auch die Qualität und Reaktionszeit des technischen Supports waren mitunter ein Ärgernis, da die Kommunikationskanäle voneinander getrennt waren und Antwortzeiten mehrere Tage betrugen. Ein weiterer Schmerzpunkt waren die wiederkehrenden Netzwerk- und Zugriffsprobleme innerhalb der verteilten CockroachDB-Architektur. Insbesondere bei der Nutzung von VPN-Lösungen wie Tailscale kam es periodisch zu Fehlermeldungen und kurzzeitigen Ausfällen, die nicht abschließend diagnostiziert werden konnten. Solche Instabilitäten traten sowohl in Produktions- als auch in Entwicklungsumgebungen auf und blieben beim Wechsel auf PostgreSQL vollständig aus. Die tatsächliche Migration wurde im Kontext eines stark angewachsenen Datenbestands von circa 100 Millionen Zeilen auf der größten Tabelle durchgeführt, somit eine nicht triviale Aufgabe.

Da kommerzielle ETL-Lösungen kaum unterstützend verfügbar waren, entwickelte der verantwortliche Entwickler eine maßgeschneiderte Lösung basierend auf Javascript-Umgebung Bun. Diese orchestrierte das vollständige Auslesen der Datenbankstruktur, exportierte Daten als CSV-Dateien und implementierte parallelisierte Streaming-Importprozesse für PostgreSQL. Lediglich bei der Kompatibilität von JSON- und Array-Datentypen mussten individuelle Transformationsmechanismen implementiert werden, da Unterschiede in der Byte-Codierung bestanden. Trotz dieser Herausforderungen wurde die Produktionsmigration innerhalb von nur etwa 15 Minuten auf einem leistungsstarken VM-Cluster durchgeführt, was die Effektivität der eigenen Lösung unterstrich. Die Nachmigration zeigte unmittelbare Vorteile.

So sanken die gemessenen durchschnittlichen Antwortzeiten für Datenbankabfragen um ein Drittel. Durch die Nutzung etablierter PostgreSQL-Werkzeuge wie PGAnalyze konnten zudem mehrere ineffiziente Abfragen schnell identifiziert und optimiert werden. Trotz einer großzügigen Ressourcenallokation für den PostgreSQL-Cluster führten die Verbesserungen zu einer jährlichen Kosteneinsparung von über 110.000 US-Dollar im Vergleich zu den vorherigen CockroachDB-Ausgaben – bei gleichzeitig reduziertem operativen Aufwand und erhöhter Stabilität. Insgesamt unterstreicht dieser Erfahrungsbericht die wichtige Erkenntnis, dass moderne verteilte Datenbanksysteme nicht in jedem Anwendungsfall die beste Wahl sind.