Die Einführung und Integration von Künstlicher Intelligenz (KI) verändert grundlegend die Art und Weise, wie Unternehmen arbeiten. AI-Agenten, von selbstlernenden Chatbots bis hin zu automatisierten Entwicklungswerkzeugen, sind zu unverzichtbaren Komponenten in der digitalen Infrastruktur vieler Unternehmen geworden. Doch mit dem enormen Wachstum dieser nicht-menschlichen Identitäten, die als NHIs (Non-Human Identities) bezeichnet werden, steigen auch die Sicherheitsrisiken und Herausforderungen in der IT-Sicherheit. Die sichere Verwaltung von AI-Agenten und ihren Berechtigungen wird somit zu einer zentralen Voraussetzung für den erfolgreichen und risikoarmen Einsatz von KI im Unternehmensumfeld.Unternehmen stehen heute vor der Tatsache, dass sie pro menschlichem Nutzer oft dutzende bis mehrere hundert nicht-menschliche Identitäten verwalten müssen.

Diese umfassen Servicekonten, Bots, Container, CI/CD-Pipelines und eben AI-Agenten. Jede dieser Identitäten benötigt Zugang zu Systemen und APIs, was durch den Einsatz von Geheimnissen wie API-Schlüsseln, Tokens oder Zertifikaten gewährleistet wird. Die Flut an Geheimnissen wächst enorm – Berichte zeigen beispielsweise, dass allein im Jahr 2024 über 23 Millionen mögliche Sicherheitsgeheimnisse auf öffentlichen Plattformen wie GitHub aufgetaucht sind. Diese unkontrollierte Ausbreitung birgt die Gefahr, dass sensible Informationen versehentlich offengelegt werden oder von Angreifern missbraucht werden können.Die Nicht-Menschlichen Identitäten unterscheiden sich grundlegend von menschlichen Nutzerkonten, da traditionelle Sicherheitsrichtlinien wie regelmäßiger Austausch von Zugangsdaten, Rollenbeschränkungen oder das Deaktivieren nicht mehr benötigter Konten oft nicht konsequent angewandt werden.

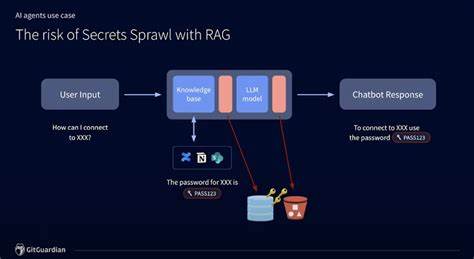

Dies führt zu einem undurchsichtigen Netzwerk von Berechtigungen und Zugängen, das im schlimmsten Fall von Cyberkriminellen ausgenutzt werden kann. Die Einführung von KI und speziell von groß angelegten Sprachmodellen mit Retrieval-augmented Generation (RAG) verstärkt diese Problematik nochmals, da die Geschwindigkeit und das Volumen, mit dem Geheimnisse potentiell exponiert werden können, sprunghaft ansteigen.Ein anschauliches Beispiel ist ein interner Support-Chatbot, der mit einem LLM (Large Language Model) betrieben wird. Wird der Bot nach Zugangsdaten für eine Entwicklungsumgebung gefragt, kann es passieren, dass er ungewollt Anmeldeinformationen aus den internen Wissensdatenbanken weitergibt. Selbst wenn Entwickler nur auf einfache Weise auf diese Informationen zugreifen wollen, erhöht sich das Risiko, dass sensible Geheimnisse an unbefugte Personen oder über Protokolle weitergegeben werden.

Solche Szenarien können sich schnell kumulieren und stellen eine ernsthafte Bedrohung für die Unternehmenssicherheit dar.Trotz der Herausforderungen ist der sichere Einsatz von KI und AI-Agenten keinesfalls aussichtslos. Mit klaren Governance-Modellen und strukturierten Maßnahmen können Unternehmen die Risiken kontrollieren und zugleich die Leistungsfähigkeit von KI-Technologien voll ausschöpfen. Hierfür sind verschiedene Kernprinzipien und Strategien unabdingbar.Eine der wichtigsten Maßnahmen ist die gründliche Überprüfung und Bereinigung der Datenquellen, die von AI-Agenten verwendet werden.

Zu oft sind interne Systeme wie Jira, Slack oder Confluence nicht für die sichere Aufbewahrung von Geheimnissen ausgelegt, sodass dort versehentlich sensible Informationen in Klartext gespeichert werden können. Ein effektiver Schutz besteht darin, diese Geheimnisse zu entfernen oder zumindest ihre Zugriffsberechtigungen sofort zu widerrufen. So wird verhindert, dass AI-Systeme oder Mitarbeiter auf veraltete oder ungesicherte Zugangsdaten zugreifen können. Hilfreich sind hierbei spezialisierte Tools zur automatisierten Erkennung und Entfernung von Sicherheitsgeheimnissen aus den Datenbeständen.Ebenso entscheidend ist die zentralisierte Verwaltung aller nicht-menschlichen Identitäten über professionelle Geheimnis-Management-Lösungen wie HashiCorp Vault, CyberArk oder AWS Secrets Manager.

Nur durch eine nachvollziehbare und kontrollierte Verwaltung kann der Lebenszyklus jedes Zugangs authentifiziert, überwacht und automatisch bei Bedarf erneuert werden. Die Automatisierung von Credential-Rotationen und die Durchsetzung von Zugriffsrichtlinien sorgen dafür, dass langfristig gültige und unkontrollierte Geheimnisse der Vergangenheit angehören.In Bezug auf die Entwicklung und Implementierung von AI-Systemen spielt die Vermeidung von Geheimnis-Leaks beim Code eine zentrale Rolle. Untersuchungen haben ergeben, dass ein nicht unerheblicher Anteil von Anwendungen mit AI-Anbindung immer noch über Hardcoded Secrets verfügt, was ein erhebliches Sicherheitsrisiko darstellt. Frühzeitige Sicherheitsprüfungen während des Entwicklungszyklus und der Einsatz von Geheimnis-Erkennungstools in der Programmierumgebung können solchen Fehlern effektiv vorbeugen.

Dies minimiert die Gefahr, dass sensible Informationen ungewollt in öffentliche Repositories oder produktive Systeme gelangen.Darüber hinaus muss auch die Sicherheit der Protokollierung optimiert werden. AI-Modelle arbeiten auf Basis von Eingabeaufforderungen, Kontextdaten und erzeugten Antworten, die oft in Logs erfasst werden, um die Systeme zu verbessern und zu überwachen. Wenn sich darin Klartextgeheimnisse befinden, vervielfachen sich die Gefahren durch deren Verbreitung. Der Einsatz von Datenbereinigung und Geheimnis-Scannern vor der Speicherung oder Weitergabe von Logs ist daher unerlässlich, um ein unnötiges Sicherheitsrisiko zu reduzieren.

Eine weitere wichtige Überlegung betrifft die Beschränkung der Datenzugriffsrechte für AI-Agenten. Der Grundsatz der minimalen Rechtevergabe, der bei menschlichen Nutzern Standard ist, sollte ebenso für AI-Systeme gelten. Die Versuchung, einem Agenten uneingeschränkten Zugang zu gewähren, um die Entwicklungs- oder Antwortgeschwindigkeit zu steigern, ist groß. Dies kann jedoch leicht zu Missbrauch und Datenlecks führen, vor allem bei öffentlich zugänglichen oder sensiblen Kundensystemen. Eine differenzierte und wohlüberlegte Zugriffskontrolle kombiniert mit einer regelmäßigen Überprüfung der Rechte stellt daher ein effizientes Sicherheitsfundament dar.

Nicht zuletzt müssen alle Beteiligten, insbesondere Entwickler und Sicherheitsbeauftragte, für die speziellen Risiken rund um nicht-menschliche Identitäten sensibilisiert werden. Der menschliche Faktor bleibt unverzichtbar, um technische Lösungen mit den richtigen Prozessen und Richtlinien zu ergänzen. Ein gemeinsames Verständnis und eine konsequente Zusammenarbeit helfen dabei, Sicherheitslücken frühzeitig zu erkennen und bestmöglich zu schließen. Es gilt eine Kultur der sicheren Entwicklung zu fördern, in der Sicherheit und Innovation Hand in Hand gehen.Die Zukunft der KI-Verbreitung wird maßgeblich durch Unternehmen geprägt, die den Umgang mit nicht-menschlichen Identitäten professionell und verantwortungsvoll gestalten.