In der heutigen Zeit gewinnen Künstliche Intelligenz und insbesondere Large Language Models (LLMs) immer mehr an Bedeutung. Diese Modelle bilden die Grundlage für viele Anwendungen, die natürliche Sprache verstehen und generieren, von virtuellen Assistenten bis hin zu komplexen Chatbots. Während die meisten LLMs traditionell in der Cloud betrieben werden, wächst der Bedarf, solche Modelle direkt auf Endgeräten wie Smartphones und Computern auszuführen. Hier setzt ANEMLL an, ein richtungsweisendes Open-Source-Projekt, das die Ausführung und Optimierung von LLMs auf dem Apple Neural Engine (ANE) ermöglicht. Das Projekt verspricht nicht nur eine effizientere Nutzung der Hardware von Apple-Geräten, sondern auch eine erhöhte Datensicherheit und geringere Abhängigkeit von einer Internetverbindung.

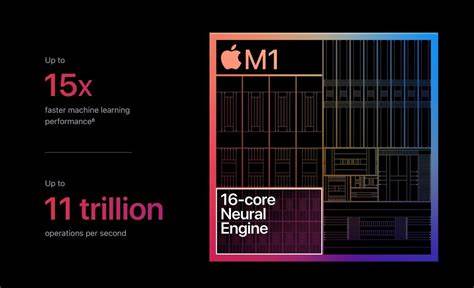

ANEMLL, ausgesprochen wie „animal“, steht für Artificial Neural Engine Machine Learning Library und hebt sich dadurch hervor, dass es eine vollständige, offene Pipeline bereitstellt, die von der Konvertierung der Modelle bis hin zur Ausführung und Integration stets auf Apples innovative Architektur ausgerichtet ist. Apples Neural Engine ist ein spezialisierter Tensorprozessor, der für Machine Learning Aufgaben optimiert ist und bereits in vielen neueren iPhones, iPads und Macs verbaut ist. Durch die gezielte Nutzung des ANE können Entwickler die Leistungsfähigkeit ihrer KI-Modelle entscheidend steigern, während der Energieverbrauch zugleich minimiert wird – ein Aspekt, der gerade bei mobilen Geräten von zentraler Bedeutung ist. ANEMLL konzentriert sich auf die Vereinfachung des gesamten Prozesses, damit Entwickler LLMs direkt von bekannten Plattformen wie Hugging Face übernehmen und für Apple-Geräte bereitstellen können. Im Zentrum des Projekts stehen flexible Tools und Frameworks, die eine einfache Portierung ermöglichen und dabei helfen, Applikationen auf Edge-Geräten mit maximaler Privatsphäre zu erstellen.

Besonders relevant ist dies für autonome Anwendungen, bei denen Modelle vollständig auf dem Gerät laufen, ohne auf eine Internetverbindung angewiesen zu sein. Diese Herangehensweise garantiert, dass sensible Daten nicht das Gerät verlassen, was für viele Anwendungsfälle, etwa in der Medizin oder im Finanzwesen, unerlässlich ist. Die technische Grundlage von ANEMLL liegt in mehreren Kernkomponenten. Die Konvertierung von Modellen wird automatisiert und optimiert durchgeführt, wobei aktuell insbesondere LLAMA-Modelle sowie DeepSeek Distilled Varianten unterstützt werden. Die Umwandlung erfolgt direkt von Hugging Face in das CoreML-Format, das für den Apple Neural Engine maßgeschneidert ist.

Dieser Schritt ist entscheidend, da die nahtlose Integration innerhalb des Apple-Ökosystems eine ausgezeichnete Performance und Kompatibilität sicherstellt. Ein weiterer wesentlicher Bestandteil ist die ANE-Optimierung selbst. ANEMLL implementiert spezialisierte Techniken, um die Modelle für die unterschiedlichen Speicherkapazitäten von iOS- und macOS-Geräten anzupassen. Die Grenze liegt dabei bei etwa 1 GB Speicher für mobile Geräte und 2 GB für Macs. Durch eine intelligente Aufteilung der Modelleinheiten, wie Embeddings, Feed Forward Netzwerke und LM Heads, gelingt es, die Modelle effizient und ressourcenschonend auf dem Apple Neural Engine auszuführen.

Das Projekt bietet zudem werkzeugbasierte Inferenzlösungen, darunter chatbasierte Interfaces, die es Entwicklern erlauben, die Modelle unmittelbar zu testen und einzusetzen. Diese Interfaces verfügen über Funktionen wie Gesprächsverlaufmanagement, Kontextfenstersteuerung und Performanceüberwachung. Solche Features sind essenziell, um eine nutzerfreundliche und performante Erfahrung sicherzustellen und um die besondere Leistungsfähigkeit des ANE auch in Interaktionsszenarien auszunutzen. Für die Nutzung von ANEMLL werden entsprechende Systemvoraussetzungen genannt. Ein Gerät mit macOS Sequoia und aktiviertem Apple Neural Engine ist unabdingbar.

Hinzu kommen mindestens 16 GB Arbeitsspeicher sowie eine Python-Version ab 3.9, die als Basis für die Modellkonvertierung und das Training dienen. Die jüngste Alpha-Version 0.1.1 bringt bereits zahlreiche Verbesserungen mit sich, darunter eine vereinfachte Modellkonfiguration, eine automatisierte Vorbereitung für die Verteilung über Hugging Face und verbesserte Chat-Interfaces mit optimiertem Fehlerhandling.

Die kontinuierliche Weiterentwicklung zeigt das lebendige Engagement hinter dem Open-Source-Projekt und macht ANEMLL zu einer zukunftsträchtigen Technologie im Bereich On-Device-KI. Das Interesse an Edge-Computing nimmt stetig zu, da immer mehr Nutzer und Unternehmen die Vorteile lokaler Verarbeitung erkennen: schnellere Reaktionszeiten, erhöhter Datenschutz und die Vermeidung von Bandbreitenengpässen. Gerade in Zeiten, in denen die Datenmenge exponentiell wächst, sind Plattformen wie ANEMLL, die die leistungsstarken Apple Neural Engines zugänglich machen, von enormem Wert. Entwickler, die Anwendungen für iPhones, iPads oder Macs entwickeln möchten, erhalten mit ANEMLL ein mächtiges Werkzeug, um die gesamte KI-Pipeline auf ein völlig neues Niveau zu heben. Auch die Möglichkeit, Modelle direkt aus dem umfangreichen Ökosystem von Hugging Face zu nutzen, eröffnet zahlreiche Chancen, bestehende KI-Modelle individuell anzupassen und in den eigenen Projekten einzusetzen.

Zusammenfassend lässt sich ANEMLL als ein bedeutender Schritt in Richtung performanter und privater KI auf Endgeräten sehen. Das Projekt demonstriert, wie durch gezielte Hardwarespezialisierung und durch offene Tools der Einstieg in die Nutzung von LLMs auf mobilen Geräten erleichtert werden kann. Es vereint Hardware-Optimierung, einfache Handhabung und datenschutzbewusste Edge-Implementierung in einem Paket, das Entwicklern und Endanwendern gleichermaßen zugutekommt. Mit ANEMLL sind LLMs auf Apple-Geräten nicht nur machbar, sondern auch praktisch und effizient, was die Zukunft der On-Device-KI maßgeblich prägen wird.