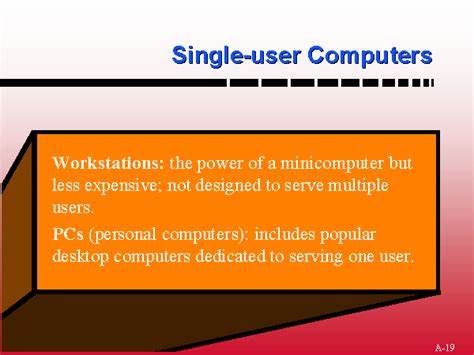

In der frühen Ära der Personalcomputer und spezialisierten Arbeitsplatzrechner wie Lisp-Maschinen oder Smalltalk-Workstations wurden sogenannte Single-User-Computer als ideal betrachtet. Sie versprachen dem einzelnen Nutzer vollständige Kontrolle über das gesamte System – von der Bootsequenz bis zur höchsten Anwendungsebene. Der offene Zugriff auf die Softwareumgebung, oft auch Betriebssystem genannt, erlaubte es, das System im Detail zu modifizieren und anzupassen. Dieses Konzept galt lange Zeit als ein Leuchtfeuer technologischer Freiheit. Doch bei genauer Betrachtung zeigt sich, dass die klassische Idee des Single-User-Computers in vielerlei Hinsicht begrenzt und fehleranfällig war.

Die Schattenseiten dieser einst gefeierten Konzepte erklären, warum moderne Computersysteme zunehmend auf Modularität, Schutzmechanismen und Mehrbenutzerfähigkeit setzen, um den steigenden Anforderungen an Sicherheit, Stabilität und Skalierbarkeit gerecht zu werden. Das Grundprinzip eines klassischen Single-User-Computers lag darin, dass der Nutzer alleiniger Anwender des Systems war und direkten Zugriff auf fast alle Ebenen der Software hatte. Bei frühen Personalcomputern bedeutete dies, dass eine einzige Aufgabe zu einer Zeit ausgeführt wurde. Die Systeme waren häufig so konzipiert, dass sie sehr simpel wirkten, aber in Wirklichkeit fehlte es an Schutz- oder Isolationsmaßnahmen. Fehlerhafte Programme konnten das gesamte System lahmlegen.

Die Konsequenz war eine geringe Fehlertoleranz: Programmierfehler eines Nutzers konnten fatale Auswirkungen auf das gesamte System haben. Schon kleine Ungenauigkeiten oder Bugs führten zu Abstürzen oder Datenverlust. Dies stellte ein großes Hindernis für den Alltagseinsatz dar, denn Nutzer sind menschlich und Fehler gehören zum Prozess dazu. Interessant ist, dass auch Arbeitsstationen wie die berühmten Lisp-Maschinen oder Smalltalk-Systeme ähnliche Probleme hatten– trotz des fortgeschritteneren Designs. Dort war das Betriebssystem eher als eine Laufzeitumgebung zu verstehen, die tief miteinander vernetzt war.

Das System erschien als eine einheitliche Welt, in der alle Objekte und Prozesse miteinander verbunden waren. Diese enge Verknüpfung machte es möglich, das System bis ins kleinste Detail zu verändern. Doch diese Offenheit führte auch dazu, dass eine einzelne Änderung ungewollte Seiteneffekte auslösen konnte. Eine falsche Modifikation im System „ganzen Welt“ führte dazu, dass Fehler schnell eskalierten oder ein inkonsistenter Zustand entstand. Die fehlende Modularisierung und die mangelnde Isolierung der Systemkomponenten erschwerten eine stabile und skalierbare Nutzung erheblich.

Aus der Geschichte der Informatik lernen wir heute, dass Prinzipien wie Trennung, Isolation und Abstraktion essenziell sind, um komplexe Systeme handhabbar und robust zu machen. Menschen sind nun einmal begrenzt in der Menge an Informationen, die sie gleichzeitig überblicken können. Modulare Systeme ermöglichen es, den Fokus auf einzelne Teile zu richten, ohne sofort das gesamte System verstehen zu müssen. Das erhöht nicht nur die Übersichtlichkeit, sondern auch die Fehlerresistenz. Hier setzt die Weiterentwicklung moderner Computer an, bei denen Mehrprozessorsysteme, Benutzerrechte, Speicher- und Prozessisolierung die Norm sind.

Solche Schutzmechanismen verhindern, dass Fehler in einem Teilbereich das gesamte System kompromittieren. Besonders wichtig ist die Abgrenzung und der Schutz von einzelnen Programmen gegenüber dem Gesamtsystem. Wo früher ein Programm, das fehlerhaft lief, das gesamte Benutzererlebnis zerstören konnte, sorgen moderne Betriebssysteme mit Speicherschutz und Prozessisolation dafür, dass Fehler auf einzelne Programme beschränkt bleiben. Dies trägt entscheidend zur Stabilität im Alltag bei. Die Fähigkeit, mehrere Prozesse gleichzeitig und unabhängig voneinander auszuführen, macht Mehrbenutzersysteme effizient und sicher.

Es erlaubt zudem vielfältige Einsatzszenarien: vom Serverbetrieb über das Teilen von Ressourcen bis hin zum parallelen Arbeiten mehrerer Nutzer oder Dienste. Nicht zu vergessen ist auch der Vorteil von Objektorientierung und modularer Datenverwaltung. Hier können Anwender gezielt einzelne Objekte manipulieren, verschieben oder wiederherstellen, ohne Gefahr zu laufen, das ganze System zu destabilisieren. Das ist ein großer Fortschritt gegenüber der „einzigen Welt“, in der jede Änderung weitreichende Auswirkungen hatte. Die moderne Programmierung und Systemgestaltung verfolgt das Ziel, einzelne Funktionsbausteine in sich abgeschlossen, klar definiert und kontrollierbar zu halten.

Aus Sicht heutiger Nutzer und Entwickler ist ein System, das vollständig transparent und von einer Person komplett steuerbar ist, zwar nach wie vor ein verlockender Gedanke. Doch realistisch betrachtet ist es kaum möglich, ein modernes Computersystem im vollen Umfang zu überblicken, zu verstehen und selbst zu kontrollieren – es sei denn, man beschränkt sich auf sehr einfache Aufgaben oder spezielle Domänen. Die Komplexität, die moderne Hardware und Software heute mit sich bringen, macht es unumgänglich, klare Grenzen zu ziehen. Nur so bleibt es möglich, einzelne Komponenten zu optimieren, Fehler zu isolieren oder Sicherheitsmechanismen einzubauen. Klassische Single-User-Computer sind daher nicht mehr zeitgemäß, wenn es darum geht, aktuellen Anforderungen an Datenschutz, Sicherheit und Zuverlässigkeit gerecht zu werden.

Die Weiterentwicklung der IT-Landschaft verlangt eine neue Balance zwischen Kontrolle und Abstraktion. Die Erfahrung zeigt, dass ein Rechner, der von einer einzelnen Person vollständig verstanden und kontrolliert wird, nur in eng begrenzten Anwendungsfällen funktionieren kann. Um große Systeme zuverlässig und sicher zu betreiben, benötigen wir Konzepte, die Komplexität beherrschbar machen, etwa durch klare Schnittstellen, Engineered Boundaries und Prozessisolation. Zusammengefasst lässt sich sagen, dass die nostalgische Sehnsucht nach den ehrlichen, überschaubaren „Single-User-Computern“ der Vergangenheit mit der Realität moderner komplexer Systeme kaum vereinbar ist. Die Idee eines Computers, der eine einzige Person komplett kontrolliert, ist nicht prinzipiell falsch – vielmehr müssen wir neue Wege finden, wie diese Idee umgesetzt werden kann.

Lösungsmöglichkeiten liegen in modularem Design, in der konsequenten Abstraktion und im Schutz zwischen den Systembestandteilen. Indem wir lernen, Komplexität nicht mit Offenlegung zu bekämpfen, sondern mit Strukturierung und Separation, können moderne Rechnerumgebungen nutzerfreundlich, stabil und sicher gestaltet werden. Die Zukunft der Computertechnik wird daher nicht im Zurückkehren zu klassischen Single-User-Konzepten liegen, sondern in einer differenzierten Balance aus Kontrolle und Schutz – einem Umfeld, in dem Nutzer zwar weitreichenden Einfluss haben, gleichzeitig aber von der Komplexität geschützt werden, die heutige Technologie unvermeidlich mit sich bringt. Ein System, das Anwender respektiert, indem es sowohl Freiheit als auch Sicherheit gleichermaßen ermöglicht, wird der Schlüssel zu einer produktiven und zuverlässigen Computernutzung der nächsten Jahrzehnte sein.

![We're faster than a Mac (Microsoft Ad) [video]](/images/4958F7EC-B9F9-4DA8-8555-BF2D84A7F5AB)

![Guide to Avoiding PFAS Chemicals [pdf]](/images/B6FCD850-4073-4AB7-AC81-6D951D5245AB)