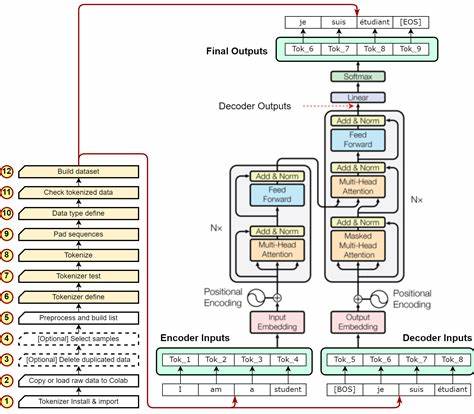

In der schnell wachsenden Welt der künstlichen Intelligenz gewinnen multimodale Modelle immer mehr an Bedeutung. Diese Modelle, die unterschiedliche Datenformen wie Text, Bild und Ton verarbeiten können, sind entscheidend für vielfältige Anwendungen von Bildgenerierung über visuelle Erkennung bis hin zu komplexen Aufgaben wie visuellem Frage-Antwort-Systemen. Bei der Entwicklung solcher Modelle spielt die Tokenisierung visueller Daten eine zentrale Rolle – die Umwandlung von Bildern in eine für KI-Modelle verständliche Darstellungsform. Hier setzt das Konzept des End-to-End Vision Tokenizer Tuning (ETT) an und markiert einen bedeutenden Fortschritt gegenüber traditionellen Ansätzen der Bildtokenisierung.Die herkömmliche Methode der visuellen Tokenisierung basiert darauf, Tokenizer unabhängig vom eigentlichen Zieltask zu trainieren.

Dabei wird der Tokenizer oft auf Aufgaben der niedrigen Ebene, wie der Rekonstruktion von Bildern, optimiert. Diese Strategie hat eine entscheidende Einschränkung: Die erzeugten visuellen Token sind nicht unbedingt ideal für verschiedene nachgelagerte Anwendungen, die unterschiedliche Repräsentationen und semantische Interpretationen erfordern. Ein häufiges Problem ergibt sich beispielsweise bei der Erkennung von Texten in Bildern – wenn der Tokenizer in seiner Optimierung keine Berücksichtigung für solche speziellen Anforderungen findet, führt dies zu Fehlern und schlechteren Ergebnissen.ETT verlässt diese getrennte Optimierungsstrategie und nutzt stattdessen eine ganzheitliche Herangehensweise. Das zugrundeliegende Prinzip ist die gemeinsame Optimierung sowohl der Tokenisierung als auch der Zielaufgaben, etwa autoregressive Modelle für Bildbeschreibungen oder visuelle Generierung.

Dies gelingt, indem nicht nur die diskreten Token-Indizes des Tokenizers verwendet werden, sondern auch die visuellen Einbettungen aus dem sogenannten Codebuch in den Trainingsprozess eingebunden werden. Dadurch wird eine End-to-End-Trainierbarkeit möglich, was zu einer weit besseren Anpassung der Tokenisierung an die spezifischen Anforderungen der downstream Aufgaben führt.Ein großer Vorteil von ETT ist seine einfache Integration in bestehende Trainingspipelines. Es erfordert keine aufwändigen Umbauten der vorhandenen Architektur oder Änderungen an den großen Sprachmodellen, die häufig mit den Vision-Modulen gekoppelt sind. ETT nutzt die bereits etablierten Codebücher und passt die Einbettungen durch zusätzliche Rekonstruktions- und Beschreibungsaufgaben an.

Diese Kombination sorgt dafür, dass die ursprünglichen Stärken der Tokenizer, etwa bei der Bildrekonstruktion, erhalten bleiben, während gleichzeitig die semantische Relevanz und Flexibilität für verschiedenste Anwendungen erhöht wird.Die praktischen Auswirkungen von ETT sind beeindruckend. Experimente zeigen eine signifikante Leistungssteigerung, die bei multimodalen Verständnisaufgaben und visuell gestützten Generierungsprozessen zwischen zwei und sechs Prozent im Vergleich zu klassischen, fixierten Tokenizer-Methoden liegt. Insbesondere in Bereichen, in denen komplexe Bild-Text-Beziehungen analysiert oder erzeugt werden müssen, sorgt der optimierte Tokenisierungsprozess für spürbar präzisere Ergebnisse. Das schließt Aufgaben wie Bildunterschriften, visuelle Dialogsysteme oder generative Bildmodelle mit ein.

Die Bedeutung von ETT reicht über reine Leistungsverbesserungen hinaus. Es eröffnet neue Perspektiven für die Entwicklung von multimodalen Foundation Models, die zunehmend die Basis für zahlreiche KI-Anwendungen bilden. Das Konzept fördert die Idee, dass visuelle und sprachliche Repräsentationen eng miteinander verflochten sein sollten, um effektiv zusammenarbeiten zu können. Durch die dynamische Abstimmung der Tokenizer-Einbettungen auf konkrete Aufgaben wird die Synergie zwischen verschiedenen Modalitäten nachhaltig gestärkt.Ein weiterer Aspekt von ETT ist die Skalierbarkeit.

Da das Verfahren ohne aufwändige architektonische Änderungen funktioniert, ist es für diverse KI-Systeme und Frameworks adaptierbar. Unternehmen und Forschungsgruppen, die bereits große multimodale Modelle im Einsatz haben, können die Vorteile von ETT nutzen, ohne ihre bestehenden Infrastrukturen grundlegend überarbeiten zu müssen. Diese Zugänglichkeit fördert die Verbreitung und damit auch die Innovationsgeschwindigkeit im Bereich der multimodalen KI.Neben der technischen Effizienz bietet ETT auch eine Antwort auf das Problem der Übertragbarkeit von visuellen Tokenizern. In bisherigen Systemen wurden Tokenizer oft isoliert trainiert und waren daher auf bestimmte Anwendungen spezialisiert.

Versucht man, diese auf ganz andere Aufgaben anzuwenden, treten Schwierigkeiten auf, da die visuelle Tokenisierung nicht universell genug gestaltet war. ETT löst dieses Dilemma durch die zweigleisige Optimierung, die gleichermaßen Rekonstruktion und semantische Zielarbeit berücksichtigt. Dadurch entstehen universeller einsetzbare visuelle Darstellungen.Der Forschungsstand im Bereich der Vision Tokenizer zeigt, dass die Bedeutung einer end-to-end trainierbaren Pipeline immer weiter steigt. Während frühe Modelle hauptsächlich auf pixelbasierten Methoden oder festen, vortrainierten Tokens setzten, zielt ETT auf die vollständige Anpassungsfähigkeit ab.

Das ermöglicht es den Modellen, visuelle Informationen mit einem tiefgehenden Verständnis und kontextbezogen zu verarbeiten – ein entscheidender Schritt für künftige Anwendungen wie autonome Systeme, Augmented Reality oder interaktive Assistenzsysteme. Schließlich wird ETT als ein Baustein für die nächste Generation intelligenter Anwendungen gesehen. Im Zusammenspiel mit großen Sprachmodellen und multimodalen Architekturen kann die Methode die Brücke von der reinen Datenrepräsentation hin zu komplexem, semantisch reichhaltigem Verständnis schlagen. Insbesondere im Hinblick auf die immer größer werdende Bedeutung von KI-gestützter Bildbeschreibung, visuellem Dialog und adaptiver Bildgenerierung bietet End-to-End Vision Tokenizer Tuning einen vielversprechenden Weg für Innovation und Leistungssteigerung.Damit steht fest, dass die Entwicklung des End-to-End Vision Tokenizer Tuning ein entscheidender Meilenstein ist, der die Art und Weise, wie multimodale Modelle visuelle Informationen verarbeiten und anwendungsgerecht darstellen, grundlegend verändert.

Die Kombination aus Effizienz, Einfachheit der Integration und deutlicher Leistungsverbesserung macht das Verfahren für die Forschung und Praxis gleichermaßen attraktiv. In einer Welt, die zunehmend auf multimodale Kommunikation angewiesen ist, liefert ETT ein wichtiges Werkzeug, um KI-Modelle nicht nur leistungsfähiger, sondern auch flexibler und universeller einsetzbar zu machen.