Die rasant fortschreitenden Entwicklungen im Bereich der Künstlichen Intelligenz (KI) stellen moderne Gesellschaften und Industrien vor zahlreiche Herausforderungen – nicht zuletzt hinsichtlich der Transparenz und Rückverfolgbarkeit erzeugter Algorithmen-Ausgaben. Ein zentrales Problem besteht darin, nachvollziehen zu können, wann, wo und auf welcher Hardware eine KI-Ausgabe entstanden ist, ohne dabei inneren Code oder die genaue Funktionsweise des Modells offenlegen zu müssen. Dies ist insbesondere für regulierte Branchen wie Finanzwesen, Gesundheitswesen oder staatliche Stellen von enormer Bedeutung. Die Antwort auf dieses Thema offenbart sich in innovativen Konzepten wie der sogenannten „Sealed Computation“ oder versiegelter Berechnung, die es ermöglichen, die Herkunft von KI-Ausgaben präzise an eindeutige Chip-Identitäten zu binden und dadurch eine sichere, beweiskräftige Dokumentation zu gewährleisten. In diesem Artikel beleuchten wir das Grundprinzip hinter dieser Technologie, stellen die Architektur der beteiligten Systeme vor und erläutern, welche Technologien und Sicherheitsmechanismen dazu beitragen, eine vertrauenswürdige KI-Inferenz sicherzustellen.

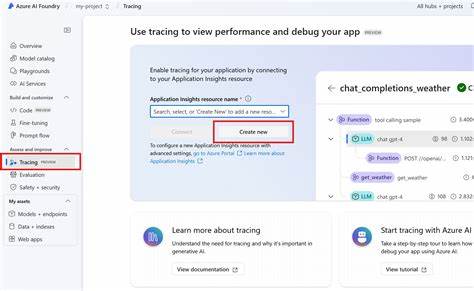

Das Grundproblem der Rückverfolgbarkeit von KI-Ausgaben besteht darin, eine belastbare Aussage darüber treffen zu können, wann und wo ein bestimmtes KI-Ergebnis entstanden ist – idealerweise gekoppelt an eine einzelne Hardwareeinheit wie eine bestimmte GPU. Diese Hardwareidentifikation bietet die Grundlage, um Vertrauen aufzubauen und eventuelle Missbrauchsszenarien zu erkennen. Allerdings stellen die vielfältigen Ausführungsumgebungen, der proprietäre Charakter mancher KI-Modelle und -Architekturen sowie der Bedarf an Datenschutz erhebliche Hürden dar. Um diese zu überwinden, wurde ein Protokoll entwickelt, das auf einem vertrauenswürdigen Dritten, genannt „Embassy“, basiert – einer Art sicherer Unterschlusseinrichtung, welche die Laufzeitumgebung für Inferenz-Workloads kontrolliert. Die Rolle des Embassy ist hierbei maßgeblich, da es den Workload – zumeist umgesetzt als Docker-Container oder ein ähnliches isoliertes Ausführungsformat – temporär von der Außenwelt abschotten kann.

Dies geschieht auf Anforderung und sorgt dafür, dass während des „Versiegelns“ keinerlei unautorisierter Datenverkehr in den Container hinein oder heraus gelangen kann. Dort, innerhalb eines sogenannten Enklaven-ähnlichen sicheren Bereichs, werden dann die KI-Eingaben entschlüsselt, verarbeitet und die resultierenden Ausgaben produziert. Eine digitale Signatur, welche den Zeitpunkt und den Ort des Versiegelns sowie bestimmte Systemparameter dokumentiert, begleitet diesen Prozess und gewährleistet damit eine beglaubigte Nachverfolgbarkeit. Dieses technische Zusammenspiel übernimmt eine kritische Schlüsselfunktion: Ohne die Beteiligung und Autorisierung durch das Embassy kann der Workload die verschlüsselten Eingaben nicht einsehen oder verarbeiten. Ebenso lässt sich der Container erst dann wieder „freischalten“, wenn der Prozess abgeschlossen und der Ausgangswert verbindlich über ein Hashverfahren festgeschrieben wurde.

Auf diese Weise wird eine manipulationssichere Kette etabliert, die die Integrität des KI-Ausführungsvorgangs verifiziert und sicherstellt, dass keine externen Rechner dazwischen geschaltet wurden oder die Verarbeitung verfälschen konnten. Neben der Kontrolle der Kommunikationswege und Ver- bzw. Entschlüsselung spielt auch die beständige Überwachung von physikalischen Parametern eine wichtige Rolle. Das Embassy misst unter anderem den Standort über netzwerkbasierte Delay-Messungen, um geografische Grenzen der Verarbeitung festzuhalten, sowie den Zeitpunkt mittels manipulationssicherer Uhren. Zudem lassen sich eindeutige Hardwarekennungen auslesen, etwa die Seriennummer einer Nvidia H100 GPU, die bereits während der Fabrikation eingebrannt werden.

Diese eindeutigen Identifikatoren sind essenziell, um nachzuweisen, dass genau diese spezifische Einheit an der KI-Ausgabe beteiligt war. Die Verifikation der Signaturen und Systemmessungen durch den Anwender ist demgegenüber unkompliziert gestaltet. Eingaben enthalten eine eindeutige Zufallszahl als Nonce, wodurch jede Anfrage unverwechselbar bleibt und Replay-Angriffe verhindert werden. Nach Abschluss kann der Nutzer die Signaturen des Embassy sowie die Integrität des Outputs anhand des zuvor übermittelten Hashwertes prüfen und so Vertrauen in die Herkunft und Echtheit der Antwort aufbauen. Dieses Verfahren bietet nicht nur transparente Nachweise für eine einzelne KI-Inferenz, sondern besitzt darüber hinaus enorme regulatorische Potenziale.

Beispielsweise lassen sich so geografisch kontrollierte Nutzungsbeschränkungen umsetzen, welche dafür sorgen, dass sensible Daten nicht außerhalb zuvor festgelegter Ländergrenzen verarbeitet werden. Somit eröffnet sich die Möglichkeit, lokale Datenschutzgesetze und Sicherheitsvorschriften auch im Bereich KI-Inferenz wirkungsvoll durchzusetzen. Ebenso interessant ist die Möglichkeit, Ressourcenverbrauch und Fähigkeiten des Modells während der versiegelten Ausführung zu analysieren. Hierbei helfen tiefgehende Speicheranalysen und Überwachungen neuronaler Aktivierungen, die mit minimalem Aufwand zusätzliche Zertifikate zu generieren, die der Nutzer autorisiert abrufen kann. Dies ermöglicht eine noch granularere Kontrolle und Governance, bei der gemessen wird, wie viele und welche KI-Fähigkeiten in welcher Weise genutzt wurden.

Trotz aller technologischen Fortschritte basiert dieses System nicht auf einem absoluten Vertrauen in die Unfehlbarkeit aller Komponenten. So ist das Embassy selbst Open Source und auditierbar, um maliziösen Code zuverlässig auszuschließen. Allerdings bleiben Hard- und Softwarekomponenten, insbesondere Trusted Execution Environments (TEE), weiterhin Ziele für hochentwickelte Angriffe, etwa durch staatlich unterstützte Akteure. Die Forschung zeigt jedoch, dass durch beständige Weiterentwicklung der Sicherheitsstandards sowie transparentes Design die Vertrauensbasis zunehmend gestärkt werden kann. Ein weiterer kritischer Punkt betrifft den Host, also die Betreiberin der Hardwareinfrastruktur, die theoretisch versuchen könnte, die Betriebsumgebung zu manipulieren.

Moderne TPM-Ketten zur Messung der Bootsequenz sowie hardwaregestützte Abschottungstechnologien können diese Risiken minimieren. Langfristig könnten zudem Lieferketten-Sicherheitskonzepte sicherstellen, dass die verwendeten Chips frei von Manipulationen sind und eindeutig identifizierbar bleiben. Im Fazit zeigt sich, dass die Rückverfolgbarkeit von KI-Ausgaben bis hin zur eindeutigen Hardwarezuordnung nicht nur machbar, sondern mit absehbarem Aufwand implementierbar ist. Dies schafft neue Wege in der vertrauenswürdigen Nutzung von KI-Modellen, erhöht die Kontrollierbarkeit in sensiblen Anwendungen und unterstützt die Einhaltung von Gesetzgebungen und ethischen Standards. Die Kombination aus verschlüsselter Kommunikation, Trusted Execution Environments und kryptographischen Signaturen bietet dabei ein robustes Fundament, auf dem künftig auch komplexe Governance-Strukturen aufsetzen können.

Die Zukunft der KI-Verifikation wird zweifellos von solchen innovativen Ansätzen geprägt sein. Organisationen, die sich frühzeitig in diese Technologien einarbeiten und sie implementieren, können nicht nur regulatorische Anforderungen besser erfüllen, sondern auch das Vertrauen ihrer Nutzer nachhaltig stärken. Gleichzeitig bleibt es wichtig, sowohl die technologische Entwicklung als auch die zugrundeliegenden rechtlichen Rahmenbedingungen aufmerksam zu verfolgen und aktiv mitzugestalten. Ausblickend eröffnet die versiegelte Berechnung nicht nur für die KI-Inferenz, sondern allgemein für datenschutzsensible und sicherheitskritische Anwendungen ein vielversprechendes Paradigma. Es wird spannend sein zu beobachten, wie sich die Konzepte der vertrauenswürdigen Rechenumgebungen weiterentwickeln, um den steigenden Anforderungen an Transparenz, Sicherheit und Compliance gerecht zu werden.

Dabei bleibt klar: Die eindeutige Rückverfolgbarkeit von KI-Ausgaben bis hin zu ihren physikalischen Erstellungsorten und -zeiten bildet eine fundamentale Säule für die verantwortungsvolle Nutzung künstlicher Intelligenz im digitalen Zeitalter.