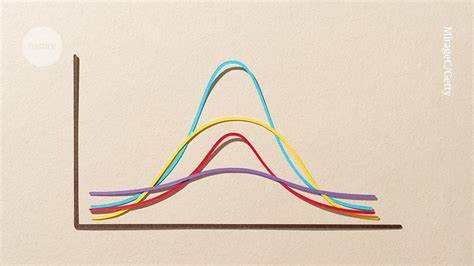

In der heutigen Wissenschaftswelt ist die Suche nach signifikanten Ergebnissen allgegenwärtig. Forscher stehen unter immensem Druck, bahnbrechende Studien vorzulegen, die ihre Karriere vorantreiben und ihre Reputation stärken. Dabei spielt der P-Wert, ein statistisches Maß für die Signifikanz von Ergebnissen, eine entscheidende Rolle. Gerade der Schwellenwert von 0,05 gilt oft als Grenze, ab der ein Ergebnis als „statistisch signifikant“ gilt. Doch genau hier verbirgt sich eine Gefahr: Das sogenannte P-Hacking.

Es beschreibt eine Reihe von Datenpraktiken, mit denen Wissenschaftler unbeabsichtigt oder bewusst die Wahrscheinlichkeit erhöhen, ein signifikantes Ergebnis zu erzielen – wodurch die wissenschaftliche Integrität gefährdet wird. P-Hacking ist kein Randphänomen. Gerade in der schnellen Welt der akademischen Forschung, wo Veröffentlichungen als Maß für Erfolg zählen, entstehen Anreize, Daten immer wieder anders zu analysieren, solange bis sich das ersehnte Ergebnis einstellt. Dabei kann es passieren, dass Forscher Daten vorzeitig nachsignalisierenden Mustern durchsuchen, anstatt strikt festgelegten Analyseplänen zu folgen. Diese Flexibilität bei der Datenanalyse führt zu verzerrten Resultaten, die in der Realität oft nicht reproduzierbar sind.

Ein häufiges Beispiel für P-Hacking ist das sogenannte „Daten-Dredging“. Dabei werden Rohdaten wiederholt untersucht, um zufällige Korrelationen zu finden, die ohne vorherige Hypothese entstanden sind. Diese Vorgehensweise ist wissenschaftlich fragwürdig, da sie die Wahrscheinlichkeit falsch-positiver Ergebnisse drastisch erhöht. Ein signifikanter P-Wert liegt dann möglicherweise nur vor, weil zahlreiche Tests zur Auswahl standen, was die Aussagekraft der Studie erheblich schmälert. Ein weiterer Weg, auf dem P-Hacking stattfinden kann, betrifft das Selektieren zwischen mehreren Analysemodellen.

Forscher probieren verschiedene statistische Methoden und Variablenkombinationen aus, bis eine Analyse gefunden ist, die den gewünschten signifikanten Effekt zeigt. Auf den ersten Blick mag dies wie gründliche Datenaufbereitung wirken, doch versteckt sich dahinter oft die bewusste oder unbewusste Manipulation der Ergebnisse. Das Problem ist nicht die Vielfalt der Methoden an sich, sondern die mangelnde Transparenz und die fehlende Vorklarung der Analysewege vor Beginn der Studie. Auch das „Nachträgliche Exkludieren von Datenpunkten“ ist eine häufige Strategie, die unter den Begriff P-Hacking fällt. Hierbei werden bestimmte Probanden oder Messwerte aus der Analyse entfernt, wenn sie das Ergebnis verwässern würden.

Ohne klare und transparente Kriterien für solche Ausgrenzungen verzerrt das die statistischen Resultate erheblich und erhöht das Risiko falscher Schlussfolgerungen. Die Versuchung, bei mehrmaligem Datenblick frühzeitig auf signifikante Ergebnisse zu reagieren, ist ebenfalls eine Ursache des P-Hackings. Statt auf fertiggestellte Datensätze zu warten, schauen Forscher oft schon während des Sammelns und Auswertens immer wieder auf Zwischenergebnisse. Fällt der P-Wert knapp über 0,05 liegt die Versuchung nahe, weitere Daten zu erheben oder auszuschließen, bis die magische Grenze unterschritten wird. Dieses Vorgehen nennt man auch „optional stopping“ und führt zu verzerrten Ergebnissen, da die Wahrscheinlichkeit eines Fehlers durch statistische Anpassungen nicht berücksichtigt wird.

Nicht zuletzt kann auch die nicht-präregistrierte Forschung als Basis für P-Hacking dienen. Die Präregistrierung von Hypothesen und Analyseplänen setzt einen klaren Rahmen, der alle Beteiligten an die ursprünglich geplanten Schritte bindet. Fehlt diese Vorklärung, können Forscher im Nachhinein die Datenmodelle anpassen oder Post-hoc-Hypothesen entwickeln, um möglichst attraktive Ergebnisse zu präsentieren. Dies untergräbt das Vertrauen in die Aussagekraft der Forschung und verhindert einen echten Fortschritt. Die Konsequenzen von P-Hacking sind weitreichend.

In der Wissenschaft führt es zu einem Vertrauensverlust, da nicht reproduzierbare Studien veröffentlicht werden, die sich später als falsch oder übertrieben erweisen. Der sogenannte Reproduzierbarkeitskrise ist ein bekanntes Problem, das durch P-Hacking verstärkt wird. Darüber hinaus werden Ressourcen verschwendet, wenn falsche Erkenntnisse als Basis für weitere Forschungsarbeiten dienen. Für Forschungsinstitutionen, Publikationsorgane und einzelne Wissenschaftler ist es daher essenziell, Strategien zum Umgang mit P-Hacking zu entwickeln. Die Förderung von Open Science Praktiken und Transparenz bei der Datenanalyse sind hierbei wichtige Schritte.

Präregistrierung von Studienprotokollen, Veröffentlichung von Rohdaten und vollständige Dokumentation der Analyseprozesse erhöhen die Nachvollziehbarkeit der Ergebnisse und minimieren P-Hacking. Auch automatisierte Tools und Softwarelösungen, die statistische Analysen überwachen und Warnhinweise bei erhöhtem Risiko für P-Hacking geben, gewinnen an Bedeutung. Diese Technologien unterstützen Forscher bei der Einhaltung statistischer Standards und können Fehlinterpretationen verhindern. Für alle, die sich mit Forschungsergebnissen auseinandersetzen – sei es in der Wissenschaft, der Medienberichterstattung oder der Politik – ist es wichtig, die Risiken von P-Hacking zu kennen. Kritisches Hinterfragen von Studienmethoden, das Studieren von Analyseplänen und der Verzicht auf Überinterpretationen von Einzelstudien sind essenziell für eine fundierte Einschätzung wissenschaftlicher Erkenntnisse.

Insgesamt steht die Forschung vor der Herausforderung, Ergebnisse mit größtmöglicher Objektivität und Integrität zu gewinnen. P-Hacking ist eine Versuchung, der man widerstehen muss, um den Fortschritt im Wissen nicht zu gefährden. Dies erfordert Disziplin, Transparenz und die Bereitschaft, auch nicht-signifikante Befunde offen zu kommunizieren. Nur so ist echte wissenschaftliche Qualität und Vertrauen in Publikationen langfristig gewährleistet.