Die räumliche und zeitliche Planung komplexer Aufgaben stellt für künstliche Intelligenzsysteme eine der großen Herausforderungen dar. Insbesondere bei großen Sprachmodellen (Large Language Models, LLMs) wird oft über deren Fähigkeit zu reflektierendem Denken und systematischem Planen diskutiert. Ein prominenter Ansatz, um die vermeintlichen Planungsfähigkeiten von LLMs zu fördern, ist das sogenannte ReAct-Style Prompting. Dabei wird dem Modell ein interleaved reasoning trace, also eine verzahnte Denkspur zwischen Nachdenken und Handlungsausführung, vorgegeben. Doch stellt sich zunehmend die Frage, ob diese „Think Tags“ wirklich dazu beitragen, die Problemlösungs- und Planungsfähigkeiten der Modelle zu verbessern.

Die kritische Studie von Siddhant Bhambri, Mudit Verma und Subbarao Kambhampati zeigt eindrucksvoll, dass der Mehrwert dieser Technik alles andere als gesichert ist. ReAct-Style Prompting avancierte in den letzten Jahren zu einem vielversprechenden Ansatz, um LLMs zum „Denken“ zu bewegen. Das Modell wird angeleitet, seine Denkprozesse und Handlungsschritte schrittweise in einer Art Gedankenprotokoll zu dokumentieren, das eng mit den ausgeführten Aktionen verknüpft ist. Die Idee dahinter ist, dass LLMs nicht nur passiv Antworten generieren, sondern aktiv über Zwischenschritte reflektieren und so komplexere, mehrstufige Aufgaben bewältigen könnten. Die Wissenschaftler Bhambri und Kollegen haben jedoch genau untersucht, welchen tatsächlichen Einfluss diese interleaved reasoning traces auf die Leistung bei Planungs- und Entscheidungsproblemen haben.

Dazu führten sie eine umfangreiche Sensitivitätsanalyse durch und variieren die Eingabepromptsystematisch – vor allem im Kontext von etablierten Benchmark-Domains wie AlfWorld und WebShop, welche auch im ursprünglichen ReAct-Ansatz verwendet wurden. Ihre Befunde werfen ein ganz neues Licht auf die vermeintlichen Stärken dieses Prompts. Ein zentraler Befund ist, dass die Leistung der LLMs kaum durch die Einbindung der interleaved Denkspuren beeinflusst wird. Vielmehr hängt der Erfolg stark von der Ähnlichkeit zwischen den wenigen Beispielaufgaben (Exemplaren) und den zu lösenden Abfragen ab. Anders ausgedrückt: Das Modell zeigt vor allem dann gute Resultate, wenn die neue Aufgabe sehr ähnlich zu den im Prompt gezeigten Beispielfällen ist.

Diese Abhängigkeit offenbart eine fundamentale Schwäche: Die wahrgenommene Fähigkeit, komplexe Planungsprobleme zu lösen, rührt eher von einem Approximate-Retrieval-Effekt her – also der Tendenz, bekannte Beispielaufgaben und deren Lösungen für neue, ähnliche Aufgaben wiederzuverwenden – als von echtem, abstraktem reasoning und generalisierter Problemlösungsfähigkeit. Die Folgen dieses Befundes sind weitreichend. Zum einen bedeutet es, dass das vermeintliche „Nachdenken“ durch Think Tags eher kosmetischer Natur sein könnte und nicht auf einer echten kognitiven Reflexion basiert. Modelle generieren offenbar reasoning traces, die inhaltlich wenig Einfluss auf die Qualität der Entscheidungen haben. Zum anderen erhöht dies die kognitive Belastung für Prompt-Designer erheblich, weil diese gezwungen sind, sehr instanzspezifische und sowohl qualitativ als auch quantitativ aufwendige Beispiele im Prompt zu hinterlegen, um akzeptable Leistungen zu erzielen.

Dieser Umstand wirkt der Skalierbarkeit und Nutzerfreundlichkeit solcher Methoden entgegen und widerspricht dem Ideal, LLMs allgemeinverständliche, robuste Denkstrategien beizubringen, die zuverlässig und flexibel auf verschiedene Problemstellungen anwendbar sind. Die mangelnde Generalisierung jenseits der Beispielsmenge zeigt, dass die Modelle ohne entsprechendes Beispielwissen kaum zu selbstständigem Planen fähig sind. Weiterhin wirft diese Analyse auch fundamentalere Fragen zur Leistungsfähigkeit und den Grenzen von LLMs auf. Sind diese Systeme wirklich in der Lage, eigenständiges Planen und logisches Schlussfolgern zu leisten, oder handelt es sich bei vielen Erfolgsberichten um eine optische Täuschung, hervorgerufen durch die geschickte Auswahl von Beispielaufgaben und Prompts? Die Studie von Bhambri et al. spricht klar für Letzteres.

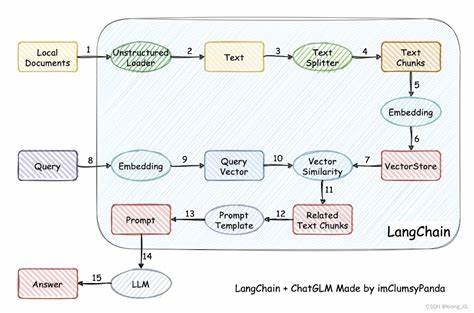

Aus technischer Sicht sind die Ergebnisse interessant, weil sie die Notwendigkeit für zukünftige Forschungen aufzeigen, die über das reine Engineering von Prompts hinausgehen und sich mit intrinsischen Modellarchitekturen, Gedächtniskomponenten oder anderen Mechanismen zur Unterstützung echten reasoning beschäftigen. Zudem regen diese Ergebnisse dazu an, die Entwicklung von Bewertungsmetrics für Planungsfähigkeiten kritisch zu überprüfen und zu hinterfragen, ob derzeitige Benchmarks die Qualität von Denkprozessen ausreichend abbilden. Trotz dieser kritischen Perspektive bleibt ReAct-Style Prompting aber nicht ohne Wert. Die erzwungene Gedankengang-Explizierung kann weiterhin als Werkzeug zum besseren Nachvollziehen von Modellaussagen dienen und hilft Forschern, die internen Prozesse großer Sprachmodelle transparenter zu machen. Außerdem bietet das Framework eine praktische Schnittstelle für den Menschen, um Eingriffe in symbolische oder externe Aktionsschritte zu garantieren.

Abschließend zeigt die aktuelle Studie auf überzeugende Weise, dass Think Tags und ReAct-Style Prompting in ihrer heutigen Form keine verlässliche Methode darstellen, um echte Planungsfähigkeit in großen Sprachmodellen hervorzurufen. Die Fähigkeiten dieser Modelle sind vielmehr eng an ihre exemplarische Vorgaben im Prompt gebunden, was die Erwartung an ihre autarke Problemlösungskompetenz stark einschränkt. Wissenschaft und Industrie stehen vor der spannenden Herausforderung, Wege zu finden, die diese Limitierungen überwinden und LLMs ermöglichen, über einfaches Nachahmen hinaus selbstständiges, robustes Planen zu erlernen. Bis dahin sollte man die berichteten Erfolge von Think Tags mit der gebotenen Zurückhaltung betrachten und den Fokus auf ganzheitlichere Ansätze im KI-Reasoning legen.