Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren bedeutende Fortschritte in der Verarbeitung natürlicher Sprache ermöglicht. Ursprünglich konzipiert, um Texte zu generieren oder zu vervollständigen, eröffnen diese Modelle zunehmend neue Horizonte in spezialisierten Fachgebieten – darunter auch die Chemie. Ein spannendes Forschungsfeld beschäftigt sich mit der Frage, wie gut diese KI-Modelle in der Lage sind, chemisches Fachwissen zu verstehen, anzuwenden und sogar chemisches Denken zu simulieren, im Vergleich zu menschlichen Experten. Diese Entwicklung wirft nicht nur technologische, sondern auch pädagogische und ethische Fragen auf, die für die Zukunft der chemischen Wissenschaft von großer Bedeutung sind. Große Sprachmodelle und ihre Rolle in der Chemie Große Sprachmodelle wie GPT-4, Claude oder LLaMA basieren auf tiefen neuronalen Netzwerken und werden auf riesigen Mengen an Textdaten trainiert.

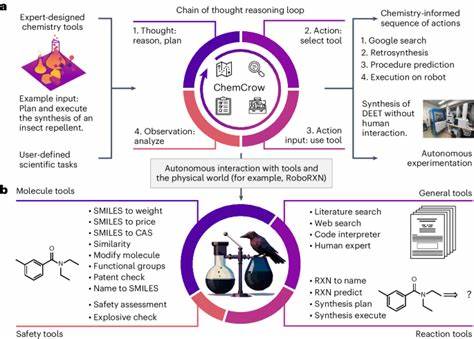

Durch diese Trainingsverfahren entwickeln sie die Fähigkeit, in komplexen Kontexten sinnvolle Antworten zu liefern, selbst für Aufgaben, auf die sie nicht explizit trainiert wurden. In der Chemie können LLMs beispielsweise bei der Interpretation wissenschaftlicher Texte, der Vorhersage molekularer Eigenschaften oder der Unterstützung bei der Planung von Experimenten eingesetzt werden. Die Verknüpfung von natürlicher Sprache mit domänenspezifischem Wissen macht sie zu potenziellen Copiloten für Forschende, die Zugang zu Informationen viel schneller aufbereiten können als traditionelle Nachschlagewerke. Eine aktuelle und umfassende Studie, veröffentlicht in Nature Chemistry im Jahr 2025, beleuchtet die Leistungsfähigkeit LLM-basierter Systeme im Vergleich zu menschlichen Chemikern. Mit dem Framework „ChemBench“ wurde ein Benchmark geschaffen, der über 2700 Frage-Antwort-Paare aus diversen Bereichen der Chemie umfasst.

Sowohl allgemeine Grundlagenfächer als auch Spezialgebiete wie analytische oder technische Chemie sind darin vertreten. Die Fragen reichen von einfachen Wissensabfragen über komplexe Berechnungen bis hin zu Aufgaben, die chemisches Urteilsvermögen und Intuition voraussetzen. Dies erlaubt eine differenzierte Sicht auf die Leistungsfähigkeit der LLMs. Performance großer Sprachmodelle vs. Chemiker Die Ergebnisse der Evaluierung überraschen in mehrfacher Hinsicht.

Das beste getestete Modell, bezeichnet als o1-preview, übertraf bei der Gesamtbewertung sogar den besten menschlichen Chemiker im Studiensetting – und das bei einer empfindlichen Auswertung, die Teilerfolge nicht anrechnet. Dies zeigt, dass LLMs auf vielen Gebieten der Chemie mit menschlichen Experten mithalten und diese in manchen Fällen sogar übertreffen können. Auch offene Modelle wie LLaMA 3.1 sind erstaunlich konkurrenzfähig gegenüber proprietären Lösungen. Allerdings sind die Modelle nicht frei von Schwächen.

Gerade bei wissensintensiven Fragen, die das reine Auswendiglernen komplexer Fakten erfordern, zeigen die LLMs teilweise Defizite. Dies erklärt sich zum Teil dadurch, dass das Wissen oft nicht im Modell „gespeichert“ ist, sondern für korrekte Antworten spezialisierte Datenbanken – etwa PubChem oder Gestis – konsultiert werden müssten. Menschen im Studiensetting nutzten diese ergänzenden Quellen ebenfalls, was die Limitationen der Modelle ohne Retrieval- oder Tool-Augmentation unterstreicht. Vor allem in Teilgebieten wie der analytischen Chemie oder bei Sicherheits- und Toxizitätsfragen schnitten einige Modelle überraschend schwach ab. Die Interpretation komplexer Molekülstrukturen anhand simplifizierter SMILES-Codes gelingt den Modellen nicht immer zuverlässig.

Während Chemiker die Struktur visuell erfassen und daraus physikalische Eigenschaften herleiten können, fehlt es den LLMs oft an echter Strukturvorstellung und räumlicher Intuition. Diese Beobachtung legt nahe, dass Textdaten allein für eine umfassende chemische Kompetenz nicht ausreichen. Die Bedeutung von ChemBench für das Verständnis chemischer KI-Fähigkeiten ChemBench stellt einen bedeutenden Fortschritt im Vergleich zu früheren Benchmark-Systemen dar, die meist nur auf Multiple-Choice-Fragen oder auf eng begrenzten Eigenschaftsvorhersagen basierten. Durch die Kombination von offenen und geschlossenen Fragen sowie einer Klassifikation der benötigten Fähigkeiten (Wissen, Berechnung, Schlussfolgerung, Intuition) werden die Modelle auf eine umfassendere und realitätsnähere Probe gestellt. Die Erstellung dieser Datenbank erfolgte mit größter Sorgfalt, wobei mehrfach wissenschaftliche Qualitätskontrollen und Kriterien zur Schwierigkeitsgraduierung angewendet wurden.

Ein besonderes Merkmal des Frameworks besteht in der Berücksichtigung von „Open-ended“-Fragen und der Integration spezieller Kennzeichnungen für chemische Notationen, wie etwa SMILES-Codes oder chemische Gleichungen, um sowohl textbasierte als auch wissenschaftliche Informationen besser zu verarbeiten. Dies ermöglicht sowohl den Einsatz reiner Text-LLMs als auch von Tools, die beispielsweise Molekülstrukturen analysieren können, wodurch der Sprung in Richtung chemischer Copiloten erleichtert wird. Potenzial und Grenzen bei der chemischen Intuition Ein besonders interessanter, aber herausfordernder Bereich ist die Fähigkeit der Modelle, chemische Präferenzen oder Intuition zu entwickeln. In der Chemie, speziell in der Medikamentenentwicklung, ist das Abschätzen, welches Molekül in einem frühen Screening weiterverfolgt werden sollte, ein zentrales Element. Untersuchungen zeigten, dass die LLMs hier im Wesentlichen keine Übereinstimmung mit den Präferenzen menschlicher Chemiker erreichen und häufig nicht besser als Zufall abschneiden.

Dies eröffnet ein großes Feld für vertiefte Forschung, da ein Alignment zwischen maschineller Intuition und menschlicher Erfahrung für den Einsatz in Industrie und Forschung essenziell sein könnte. Darüber hinaus wird die Fähigkeit der Modelle, die eigene Antwortsicherheit korrekt einzuschätzen, als kritisch beurteilt. Fehlende oder falsch kalibrierte Unsicherheitsabschätzungen bergen Risiken, wenn Fehlinformationen von Anwendern als verlässlich eingestuft werden. Gerade im sicherheitsrelevanten Umfeld der Chemie ist dies eine Herausforderung für die Integration von KI-Systemen, die noch gut adressiert werden muss. Auswirkungen auf Chemie-Ausbildung und Forschung Die Leistungsfähigkeit moderner LLMs stellt die Lehr- und Lernmethoden in der Chemie vor neue Herausforderungen.

Die Studie weist darauf hin, dass reine Wissensabfrage und Auswendiglernen an Bedeutung verlieren könnten, da diese Aufgaben von KI-Systemen immer besser übernommen werden. Stattdessen rückt kritisches Denken, kreative Problemlösung und tieferes Verständnis in den Fokus der Ausbildung. Zudem kann die Einbindung solcher Modelle in Forschungsprozesse die Geschwindigkeit der Wissensaufnahme erhöhen und die Hypothesengenerierung unterstützen. Chemiker könnten so bei der Planung von Experimenten und Bewertung von Literatur wesentlich effizienter unterstützt werden. Gleichzeitig bleibt jedoch die Notwendigkeit der Kontrolle der Ergebnisse sowie des interdisziplinären Austauschs bestehen – eine Überforderung durch Überinformation oder falsche Verlässlichkeit muss vermieden werden.

Ethik und Sicherheit im Umgang mit KI in der Chemie Ein weiterer nicht zu unterschätzender Aspekt ist die Sicherheit und ethische Verantwortung im Umgang mit LLMs im chemischen Kontext. Die Potentiale zur Dual-Use-Problematik, beispielsweise in der Design-Entwicklung von toxischen Stoffen oder chemischen Waffen, sind alarmierend. Obwohl die praktische Synthese solcher Moleküle immer noch besondere Ressourcen erfordert, kann die Verfügbarkeit von KI-generierten Designdaten den Zugang zu gefährlichem Wissen erleichtern. Es ist deshalb entscheidend, dass Entwickler von LLMs und Chemiker gemeinsam an Kontrollmechanismen, Filtertechnologien und verantwortungsvollen Nutzungsrichtlinien arbeiten. Auch eine bewusste Schulung der Neulinge und der breiten Öffentlichkeit zum sicheren und kritischen Umgang mit KI-generierten Informationen ist unerlässlich.

Zukunftsaussichten und Weiterentwicklung der Chemie-LLMs Die Erforschung und Entwicklung spezialisierter LLMs für die Chemie steht erst am Anfang. Die Ergebnisse der neuesten Studie legen nahe, dass durch eine stärkere Einbindung strukturierter, fachlicher Datenbanken, multimodaler Trainingsmethoden (etwa Kombination von Text und Molekülgraphen) und Toolintegration die Leistung eines Chemie-LLMs weiter gesteigert werden kann. Gleichzeitig ist die Skalierbarkeit dieser Modelle, die in anderen Domänen signifikant war, auch hier eine wichtige Einflussgröße. Größere Modelle zeigen generell bessere Leistungen, was jedoch mit höheren Kosten und rechentechnischem Aufwand verbunden ist. Open-Source-Projekte spielen eine wichtige Rolle, um diese Technologien zugänglicher zu machen und unabhängige Validierungen zu ermöglichen.

Zusammenfassung Große Sprachmodelle haben in der Chemie ein erhebliches Potenzial, komplexe Wissensfelder zu durchdringen und sogar menschliche Experten in bestimmten Fragestellungen zu übertreffen. Die neue Benchmark ChemBench bietet eine robuste Grundlage, um diese Fähigkeiten systematisch zu messen und zu verbessern. Dennoch bestehen klare Grenzen, insbesondere in der chemischen Intuition, im Umgang mit molekularen Strukturen und bei der Einschätzung eigener Unsicherheiten. Die Ergebnisse deuten darauf hin, dass KI-gestützte Systeme künftig als wertvolle Unterstützer in Forschung und Lehre dienen können. Gleichzeitig erfordern die Limitationen und Risiken eine kritische Begleitung durch Experten und die Schaffung ethischer Leitlinien.

In diesem Zusammenspiel von Mensch und Maschine könnten die nächsten Jahrzehnte innovative Fortschritte für die chemische Wissenschaft ermöglichen und das Verständnis von Chemie noch tiefgreifender gestalten.