In der Welt der künstlichen Intelligenz und des maschinellen Lernens erleben wir gegenwärtig einen bemerkenswerten Fortschritt. Modelle werden immer leistungsfähiger, doch dieser Fortschritt bringt auch eine Schattenseite mit sich: die zunehmende Überladung, auch als Bloat bezeichnet, in Machine-Learning-Systemen. Untersuchungen zeigen, dass mehr als 70% der in solchen Systemen verwendeten Ressourcen auf Bloat entfallen. Diese versteckte Überlastung wirkt sich negativ auf die Effizienz von Systemen, ihre Skalierbarkeit und schließlich auf die Umweltbelastung aus. Es lohnt sich daher, genauer zu betrachten, was unter Bloat verstanden wird, wie dieser entsteht und welche Maßnahmen zur Reduzierung ergriffen werden können.

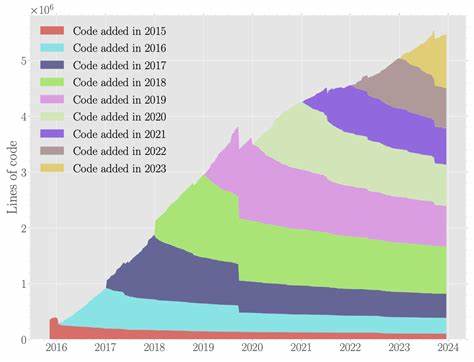

Unter Bloat versteht man in Machine-Learning-Systemen unnötige Komplexität, Überdimensionierung und ineffiziente Nutzung von Rechenressourcen. Dies zeigt sich beispielsweise in übermäßig großen Modellen mit redundanten Parametern, unnötig hohen Speicherverbrauch oder langwierigen Trainingszeiten. Während zunehmend komplexe Modelle für immer schwierigere Aufgaben notwendig erscheinen, führt ein übermäßiger Bloat zu einem Dilemma: das System wird langsam, teuer und weniger wartbar, ohne proportional bessere Ergebnisse zu liefern. Die Ursachen für Bloat sind vielfältig. Einerseits ermöglichen moderne Frameworks und Hardwarearchitekturen, enorme Modelle zu erstellen, was Entwickler oft dazu verleitet, Kapazitäten aufzublähen, ohne die Effizienz zu hinterfragen.

Andererseits werden häufig bestehende Modelle einfach erweitert oder kombiniert, ohne unnötige Parameter zu entfernen oder zu optimieren. Die Entwicklung von Feature Sets und vorverarbeiteten Daten trägt ebenfalls zum Bloat bei, wenn redundante oder irrelevante Informationen verarbeitet werden. Darüber hinaus entstehen im gesamten Lebenszyklus eines Machine-Learning-Systems ineffiziente Strukturen. Vom Training über die Validierung bis hin zum Deployment kann jede Phase durch überflüssige Operationen, suboptimale Algorithmen oder nicht abgestimmte Hardwareauswahl zusätzlich Belastung verursachen. Die Folge sind nicht nur längere Rechenzeiten, sondern auch ein größerer Energieverbrauch und eine erhöhte CO2-Bilanz – Aspekte, die im Zuge der Diskussionen um nachhaltige IT zunehmend an Bedeutung gewinnen.

Der wachsende Bloat hat unmittelbar negative Auswirkungen auf die Wirtschaftlichkeit und Leistungsfähigkeit von Unternehmen, die Machine-Learning-Lösungen implementieren wollen. Große Modelle mit hohem Ressourcenbedarf steigern die Kosten für Infrastruktur, Wartung und Betrieb erheblich. Zudem ist die Iteration neuer Modelle erschwert, da längere Trainingszeiten Entwicklungszyklen verlängern und Innovationen bremsen. Gerade für Start-ups und mittelständische Unternehmen stellen diese Hindernisse oft eine Hürde dar, um KI-Technologien erfolgreich einzusetzen. Ein weiterer wichtiger Aspekt ist die Skalierbarkeit von Systemen.

In dynamischen Umgebungen, in denen Modelle regelmäßig aktualisiert oder an neue Daten angepasst werden müssen, ist ein hoher Bloat kontraproduktiv. Systeme werden schwerfällig, Skalierungskosten steigen exponentiell, und die Reaktionszeit auf veränderte Anforderungen verlängert sich. Dies behindert die Flexibilität und Agilität von Unternehmen in einem zunehmend wettbewerbsintensiven Umfeld. Um dem entgegenzuwirken, sind verschiedene Strategien zur Minimierung von Bloat nötig. Ein vielversprechender Ansatz ist die Modell-Komprimierung, bei der überflüssige Parameter entfernt oder zusammengefasst werden, ohne die Leistung signifikant zu beeinträchtigen.

Methoden wie Pruning, Quantisierung und Distillation helfen, Modelle schlanker und effizienter zu machen. Pruning etwa reduziert die Anzahl der Verbindungen und Gewichte in neuronalen Netzen, indem nur die wichtigsten Komponenten erhalten bleiben. Dadurch verringert sich der Speicher- und Rechenbedarf deutlich. Quantisierung wandelt Daten mit hoher Genauigkeit in Formate mit geringerer Bitbreite um, was ebenfalls Speicher spart und die Geschwindigkeit erhöht. Distillation überträgt das Wissen eines großen „Lehrermodells“ auf ein kleines „Schülermodell“, das leichter zu deployen ist.

Neben technischen Verfahren ist es entscheidend, bereits im Datenvorbereitungsprozess auf Qualität und Relevanz der Eingangsdaten zu achten. Unnötige Features oder verrauschte Daten erhöhen die Modellkomplexität unnötig. Effektives Feature Engineering und Datenbereinigung tragen dazu bei, den Bloat an seiner Wurzel zu reduzieren. Auch eine kritische Betrachtung von Entwicklungs- und Deploymentprozessen ist wichtig. Automatisierte Werkzeuge und Monitoring-Systeme können bei der Erkennung ineffizienter Komponenten helfen.

Wenn Entwickler frühzeitig über Ressourcenverbrauch und Performance informiert werden, können sie gezielter gegensteuern. Darüber hinaus spielt die Hardware-Auswahl eine Rolle. Spezialisiertes Equipment wie TPUs oder optimierte CPUs mit besseren Energieprofilen können helfen, Ressourcen effektiver zu nutzen. Dennoch darf die Hardware nur einen Teil der Lösung darstellen; ohne effiziente Software-Architektur oder optimierte Modelle bleibt der Bloat bestehen. Die Forschung in diesem Bereich gewinnt zunehmend an Fahrt und zieht internationale Aufmerksamkeit auf sich.

Fachkonferenzen wie MLSys, auf denen ausgezeichnete Arbeiten zur Bloat-Reduktion präsentiert werden, fördern den Austausch zwischen Wissenschaft und Industrie. Neue Algorithmen und Werkzeuge werden entwickelt, um sowohl Leistung als auch Effizienz zu verbessern. Für Unternehmen ist es wichtig, das Problem ernst zu nehmen und proaktiv zu handeln. Ein bewusster Umgang mit Bloat führt nicht nur zu Kosteneinsparungen, sondern auch zu nachhaltigeren IT-Strategien. Zudem erhöht sich die Wettbewerbsfähigkeit durch schnellere Modellzyklen und verbesserte Produktqualität.

Blickt man in die Zukunft, so ist zu erwarten, dass die Reduktion von Bloat zu einem entscheidenden Faktor im Machine-Learning-Bereich wird. Mit wachsender Verbreitung von KI in sämtlichen Lebensbereichen steigt der Bedarf an effizienten und skalierbaren Systemen, die ressourcenschonend arbeiten. Unternehmen, Forschungseinrichtungen und Entwickler sind gleichermaßen gefordert, innovative und praxisnahe Lösungen zu finden. Letztlich steht hinter der Diskussion um Bloat mehr als nur technische Optimierung: Es geht um eine verantwortungsvolle Nutzung von Ressourcen, die den Herausforderungen des digitalen Zeitalters gerecht wird. Entsprechend ist das Bewusstsein für diese Problematik ein zentraler Erfolgsfaktor bei der Entwicklung zukünftiger Machine-Learning-Systeme.

Effizienz, Nachhaltigkeit und Leistung müssen Hand in Hand gehen, um das volle Potential der künstlichen Intelligenz auszuschöpfen.