Die menschliche Fähigkeit zum logischen Denken fasziniert Philosophen, Wissenschaftler und Technologen seit Jahrhunderten. In der heutigen Zeit, in der Künstliche Intelligenz (KI) immer weiter voranschreitet, wird die Frage, wie Denken tatsächlich funktioniert, neu und mit einer anderen Perspektive betrachtet. Eine interessante These, die dabei immer wieder aufkommt, lautet: Ist logisches oder vernünftiges Denken schlichtweg eine iterative Verfeinerung des Kontextes? Oder anders ausgedrückt, basiert jeder Denkvorgang darauf, den vorhandenen Kontext schrittweise zu überarbeiten und zu erweitern? Diese Fragestellung berührt tiefgehende Aspekte über das Wesen des Denkens sowohl in biologischen als auch in künstlichen Systemen und verdient eine genauere Betrachtung. Das Konzept der Kontextverfeinerung im Denken beruht auf der Idee, dass unser Verstand stets mit einem Informationsfundament beginnt – dem Kontext. Zum Beispiel beim Problemlösen startet man mit einer Ausgangslage, nutzbaren Fakten, Erfahrung und eventuell auch Hypothesen.

Im weiteren Verlauf wird diese Kontextbasis nach und nach durch neue Erkenntnisse oder Schlussfolgerungen angepasst, ergänzt und präzisiert. Dies kann man sich als eine Art Schleife vorstellen, in der in jedem Schritt gedankliche Überprüfungen stattfinden und das bestehende Verständnis verbessert wird. Auf programmiertechnischer Ebene wird genau dieses Prinzip bei modernen KI-Modellen verwendet, welche auf sogenannten Transformern basieren und schrittweise Kontextinformationen verarbeiten, um relevante Antworten oder Vorhersagen zu generieren. Eine wichtige Frage ist, ob dieser Prozess der Kontextverfeinerung wirklich die Essenz von „echtem“ Denken oder logischem Schlussfolgern beschreibt, oder ob damit lediglich ein Teilaspekt adressiert wird. Einige Experten argumentieren, dass eine Iteration über Textpassagen oder Gedankenfragmente nur das Zusammensetzen vorgegebener Informationen bedeutet und somit keine neue Kreativität oder echtes Verständnis liefert.

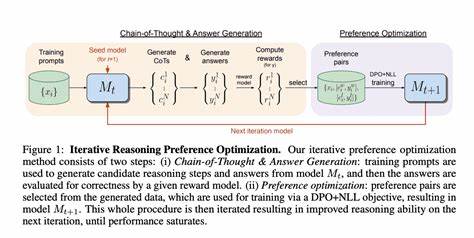

Aus dieser Sicht stellt das Modellieren von den Gedanken als reine Kontextbearbeitung eine Vereinfachung dar, die der Komplexität des menschlichen Denkprozesses nicht gerecht wird. Schließlich sind Menschen in der Lage, über das Offensichtliche hinaus neue Ideen zu generieren, Widersprüche zu tolerieren und intuitiv Verbindungen zu schaffen, die in rein datengetriebenen Schleifen nicht offensichtlich sind. Gleichzeitig sprechen viele KI-Forscher von einer Art „iterativer Kontextverfeinerung“ als Grundlage für das, was man als maschinelles logisches Denken bezeichnen kann. Dabei wird ein Ausgangstext oder eine Fragestellung in den Kontext eingebettet und dann wiederholt von einem Sprachmodell analysiert, bewertet, neu bewertet und angepasst. Das Modell bildet somit in jedem Schritt eine verbesserte Einschätzung oder Antwort ab, wodurch es genauere oder komplexere Schlussfolgerungen ziehen kann.

Dies ist eine technische Umsetzung der Idee, dass Denken eine Abfolge von sich verfeinernden geistigen Zuständen ist. In Chatbots und anderen sprachbasierten Anwendungen wird diese Technik oft unter dem Begriff „Chain of Thought“ beziehungsweise „Gedankenkette“ genutzt, um die KI dazu zu bringen, Zwischenschritte zu formulieren und die Beantwortung komplexer Probleme zu verbessern. Ein weiterer Aspekt ist die menschliche Selbstreflexion beim Denken. Menschen tendieren dazu, ihre Überlegungen kritisch zu hinterfragen, Hypothesen zu überprüfen und Fehler zu korrigieren. Dieser Prozess ähnelt stark einem Evaluationsschritt im Kontext-Iterieren, bei dem das Ergebnis des vorherigen Denkprozesses überprüft und gegebenenfalls überarbeitet wird.

In neuronaler Hinsicht werden beim menschlichen Gehirn jedoch nicht nur sequenzielle Veränderungen an einem vorhandenen Informationskontext vollzogen, sondern komplexe Interaktionen zwischen unterschiedlichen Hirnregionen ermöglichen eine simultane Wahrnehmung und Integration vielseitiger Informationen. Philosophisch gesehen eröffnet die Frage nach dem Iterationsprinzip des Denkens die Diskussion darüber, ob unser Denken wirklich aus einzelnen Verfeinerungsschritten besteht oder ob es vielmehr ein holistisches, emergentes Phänomen ist, das nicht auf einfache Mechanismen zurückführbar ist. Der Begriff emergent beschreibt hier Erscheinungen, die durch die Zusammenarbeit vieler Einzelteile entstehen, ohne dass sie auf jede einzelne Komponente reduzierbar sind. Damit werden Denkprozesse als komplexe Dynamiken verstanden, die sich nicht vollständig mit einem starren Modell von iterativer Kontextüberarbeitung abbilden lassen. Trotzdem bleibt das iterative Vorgehen ein pragmatisches Modell, um bestimmte kognitive Prozesse zu beschreiben oder für funktionale Nachbildungen im Maschinenlernen zu verwenden.

In der Praxis erlebt man die Anwendung dieses iterativen Ansatzes besonders in der Forschung rund um Sprachmodelle und Machine Learning. Die Kombination aus großen Textdaten, leistungsfähigen Algorithmen und der Idee, kleinere, gut strukturierte Schritte bei der Verarbeitung von Aufgaben durchzuführen, führt zu immer besseren Ergebnissen. Es ist auffällig, dass Modelle, die Zwischenschritte nutzen und die Aufgabe in mehrere Phasen unterteilen – quasi eine Art fortlaufende Kontextverfeinerung – für komplexere Fragestellungen besser geeignet sind als solche, die versuchen, direkte Antworten ohne Zwischenschritte zu generieren. Dies lässt sich durch ausführliche Experimente und Evaluationen nachweisen. Ein oft diskutiertes Gegenargument ist jedoch, ob eine solche technische Abfolge von Kontextanpassungen wirklich etwas mit menschlichem Denken zu tun hat oder nur eine genial konstruierte Nachahmung darstellt.

Kritiker weisen darauf hin, dass klassische KI-Modelle keine subjektive Erfahrung besitzen, keinen Sinn für Bedeutung oder eigenständige Erkenntnis. Somit könne man zwar beschreiben, wie ein Modell iterativ kontextuelle Eingaben verarbeitet und daraus eine Antwort generiert, der eigentliche Kern von „Verstehen“ bleibe dabei unberührt. Dennoch ist es möglich, dass mit zunehmender Komplexität dieser Prozesse und verbesserten Architekturen künftige Systeme näher an menschliche Denkweisen heranrücken. Eine weitere Facette des Themas ist die Rolle des Gedächtnisses. Iterative Kontextverfeinerung setzt voraus, dass frühere Gedanken, Informationen oder auch Fehlannahmen im Speicher gehalten und bei jedem neuen Schritt berücksichtigt werden.

Beim menschlichen Denken geschieht dies durch Arbeitsgedächtnis und Langzeitgedächtnis, die eng verzahnt sind. Künstliche Modelle arbeiten hingegen mit Token- oder Datenfenstern, deren Länge begrenzt ist. Die Herausforderung besteht darin, wie man diese Speicherfähigkeit so gestaltet oder erweitert, dass komplexe, langfristige Iterationen über viele Schritte hinweg möglich bleiben. Hier spielen innovative Methoden der Gedächtnissimulation und Kontextverwaltung eine wichtige Rolle. Letztendlich lässt sich sagen, dass die Vorstellung vom Denken als iterative Kontextverfeinerung ein wertvolles Modell ist, um sowohl menschliches als auch maschinelles Denken näher zu begreifen und zu beschreiben.

Es ist ein Ansatz, der technische Entwicklungen beflügelt und zugleich philosophische Fragen über die Struktur des Denkens aufwirft. Die Erweiterung dieses Modells um Aspekte wie Kreativität, Intuition, subjektives Bewusstsein und emotionale Intelligenz bleiben spannende Forschungsthemen für die Zukunft. Die Verschmelzung von iterativer Kontextverarbeitung mit anderen Denkmechanismen könnte langfristig zu einem tieferen Verständnis menschlicher Vernunft und ihren künstlichen Nachbildungen führen.