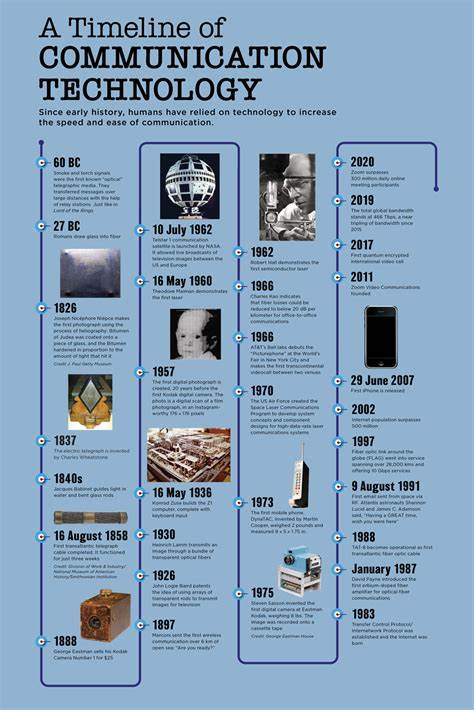

Die Welt der Technologie entwickelt sich mit atemberaubender Geschwindigkeit. Was heute als Standard gilt, war oftmals vor wenigen Jahrzehnten kaum vorstellbar – oder ist längst in Vergessenheit geraten. Ein Blick zurück in die Geschichte der Informations- und Kommunikationstechnologie offenbart viele spannende Kapitel, in denen bahnbrechende Innovationen entstanden, aber auch Konzepte scheiterten und daraus wertvolle Erfahrungen gezogen wurden. Von verteilten Systemen über Betriebssysteme bis hin zu Netzwerktechnologien lassen sich wichtige Lektionen ableiten, die auch für heutige Entwicklungen relevant sind. Verteilte Systeme haben seit den 1980er Jahren eine wechselvolle Geschichte hinter sich.

Ein Beispiel dafür ist die Distributed Computing Environment, kurz DCE. Dieses Remote Procedure Call-Framework wurde entwickelt, um verteilte Anwendungen zu ermöglichen. Es genoss in der Industrie insbesondere beim Transaktionssystem Encina Aufmerksamkeit. Trotz fortschrittlicher Konzepte konnte sich DCE jedoch nie als Mainstream-Technologie etablieren. Diese Tatsache illustriert, wie technischer Fortschritt allein nicht genügt, wenn Praxis und Marktanforderungen nicht übereinstimmen.

Ebenfalls spannend ist die Geschichte von CORBA, dem Common Object Request Broker Architecture. Anfang der 1990er Jahre gestartet, erlebte CORBA in Verbindung mit Java eine gewisse Popularitätswelle, da Java mit seinem „Write once, run anywhere“-Ansatz gut mit den Zielen von CORBA harmonierte. Viele Entwickler experimentierten mit CORBA, doch die Komplexität bei Implementierung und der Herausforderung, verschiedene Hersteller zu koordinieren, stellte eine große Hürde dar. Auch der Widerstand großer Player wie Microsoft trug zum Scheitern eines einheitlichen Durchbruchs bei. Kurz darauf rückte Enterprise Java Beans (EJB) in den Fokus, ein Java-basiertes Muster zur Unterstützung verteilter Anwendungen.

Die frühe Nutzung von CORBA in den ersten EJB-Versionen verdeutlichte die anhaltende Bedeutung solcher Frameworks. Doch wie zuvor stellte sich heraus, dass der Entwicklungs- und Bereitstellungsaufwand in keinem Verhältnis zu den technischen Vorteilen stand, was die breite Akzeptanz behinderte. EJB blieb zwar erhalten, vor allem aus Kompatibilitätsgründen, doch neue Entwicklungen nahmen nur noch selten Bezug darauf. Microsofts Antwort auf diese Entwicklungen war DCOM, der Distributed Component Object Model, ursprünglich bekannt als Network OLE. DCOM spiegelte Microsofts Philosophie wider, verteilte Anwendungen vor allem im Windows-Ökosystem zu ermöglichen und setzte damit auf eine enge Plattformbindung statt „run anywhere“.

Auch wenn DCOM heute eher eine Nische bedient, zeigt es die Bedeutung plattformspezifischer Strategien in der Softwareentwicklung der 1990er Jahre. Mit der Entwicklung des Simple Object Access Protocol, kurz SOAP, begann gegen Ende der 1990er Jahre ein weiterer Wandel. SOAP galt als vielversprechende XML-basierte Architektur für Webservices und wurde 2003 als offizieller Standard vom World Wide Web Consortium übernommen. Diese Technologie weckte große Erwartungen in der verteilten Datenverarbeitung. Dennoch verlor SOAP in den folgenden Jahren zunehmend an Boden zugunsten leichterer und flexiblerer Ansätze wie REST und die Nutzung von JSON.

Die Geschichte von SOAP verdeutlicht, wie technologische Trends gekommen und gegangen sind und wie sich die Softwarearchitektur hin zu einfacheren und wartungsfreundlichen Konzepten bewegt. Auch bei Betriebssystemen lohnt ein Rückblick auf prägende Entwicklungen und deren Auswirkungen. Unix, geschaffen Anfang der 1970er Jahre bei Bell Labs, ist bis heute eine prägende Plattform. Es war das erste portable Betriebssystem mit modularer Struktur, das in der Programmiersprache C entwickelt wurde – einer Innovation, die die Softwareentwicklung revolutionierte. Bemerkenswert ist, dass Unix durch eine besondere monopolitische Situation der Bell System/AT&T die Verbreitung fand.

AT&T durfte aufgrund eines Kartellverfahrens nicht in den Computerhandel einsteigen und stellte daher Unix gegen Lizenz an Interessenten zur Verfügung. Dadurch florierte die Nutzung in Universitäten und Forschungseinrichtungen. Das führte in den 1980er und 1990er Jahren zu einer Vielzahl von Unix-Varianten wie Solaris, AIX, HP-UX oder BSD, die alle auf dem gleichen Kern basierten, sich jedoch oft wenig miteinander kompatibel zeigten. Die Fragmentierung des Unix-Ökosystems wurde von Linux als Open-Source-Projekt seit den frühen 1990er Jahren adressiert. Linux verfolgte das Ziel, eine gemeinschaftliche und transparentere Plattform zu schaffen, was in der Praxis teilweise gelang.

Dennoch existieren weiterhin viele verschiedene Distributionen wie Ubuntu, Debian oder Red Hat mit unterschiedlichen Schwerpunkten. Unix und seine Nachfolger sind heute noch allgegenwärtig, besonders in Serverumgebungen, aber Linux übernimmt mit wachsendem Abstand die Rolle des dominierenden Systems. Ein weiteres Kapitel der Betriebssystemgeschichte erzählt die Erfolgs- und Misserfolgsgeschichte von OS/2. Gemeinsame Anstrengungen von IBM und Microsoft sollten ein modernes Betriebssystem schaffen, das vor allem in der PC-Welt Fuß fasst. Der anfängliche Erfolg wurde von strategischen Differenzen, insbesondere mit dem damaligen Partner Microsoft, und internen Konflikten beeinträchtigt.

Als Microsoft sich auf Windows konzentrierte, verlor OS/2 zunehmend an Bedeutung, trotz technischer Vorzüge. Dieser Fall zeigt, wie enge Partnerschaften und Marktkräfte auch technische Innovationen überschreiben können. Parallel zu OS/2 entstand Taligent, eine Zusammenarbeit von Apple und IBM Anfang der 1990er Jahre mit dem Ziel, ein neues Betriebssystem namens TalOS zu entwickeln. Trotz ambitionierter Pläne führte die Komplexität des Projekts, wechselnde Prioritäten und fehlende Marktdurchdringung letztlich zur Auflösung des Projekts 1998. Taligent hinterließ jedoch die Anwendungstechnologie CommonPoint, die noch einige Jahre Einfluss hatte.

Diese Episode illustriert die Herausforderungen großer Konsortien im Bereich komplexer Softwareentwicklung. Eine weitere interessante Perspektive bietet BeOS, das 1990 von Apple-Veteranen gegründet wurde. Entwickelt mit Blick auf Multimedia-Anwendungen und moderne Hardware, erschien BeOS 1995 als innovatives Betriebssystem. Apple zeigte Interesse, entschied sich jedoch 1996 für die Übernahme von NeXT, was letztlich zur Integration von NeXTSTEP-Technologie und zur Rückkehr von Steve Jobs führte. BeOS wurde 2000 zuletzt aktualisiert und 2002 eingestellt.

Die Geschichte von BeOS verdeutlicht, wie technischer Vorsprung allein nicht zwangsläufig Markterfolg garantiert. Im Bereich Netzwerke waren die 1990er Jahre geprägt von Technologien wie Token Ring, einem Netzwerkprotokoll, das aufgrund seiner deterministischen Verbindungssteuerung als verlässlich galt. Token Ring Netzwerkkarten waren damals noch groß und mussten vorsichtig gehandhabt werden. Trotz technischer Vorzüge konnten sie wegen Kosten und wachsenden Ethernet-Vorteilen nicht bestehen. Ethernet wurde aufgrund seiner Einfachheit, Kosteneffizienz und Skalierbarkeit zum dominierenden LAN-Standard.

Die Einführung von LANs, den Local Area Networks, veränderte grundlegend die Art und Weise, wie Unternehmen und Organisationen Daten teilten. Ein LAN war weit mehr als nur ein Netzwerk – es bedeutete Zusammenarbeit und neue Produktivitätsdimensionen. Allerdings brachten LANs auch organisatorische Herausforderungen mit sich: unklare Datenablagen, verschiedene Laufwerksbuchstaben und fehlende zentrale Steuerung führten oft zu Chaos und Datenverlust. Erst mit modernen, cloudbasierten Diensten konnten viele dieser Probleme gemildert werden. Cloud-Technologien erlauben heute eine einfachere Zusammenarbeit mit Funktionen wie Versionskontrolle und direkter gemeinsamer Bearbeitung, was den Umgang mit Daten grundlegend verbessert hat.

In der Rückschau zeigt sich, dass viele technische Projekte und Standards ihre Höhen und Tiefen hatten, oft abhängig von geschäftlichen Entscheidungen, Partnerschaften und der Akzeptanz der Entwickler-Community. Das Zusammenspiel von Technik und Marktgeschehen ist komplex. Auch die Entstehung von Standards in Industrieverbänden und Konsortien bringt weitere Herausforderungen in der Koordination und Realisierung mit sich. Umwelt, in der Softwareentwicklung und IT-Sicherheit, wo heute neue Methoden und Systeme etabliert werden, profitieren ebenfalls von den Erfahrungen aus der Vergangenheit. Nicht zuletzt verdeutlicht auch die Evolution der Programmiersprachen und Architekturmodelle, wie schnell sich das Feld wandelt und wie wichtig es ist, flexibel auf neue Anforderungen zu reagieren.

Greenfield-Projekte sind heute die Innovationsquelle, doch morgen können sie schon Legacy-Systeme sein, mit denen sich Entwickler erneut auseinandersetzen müssen. Die Geschichte verdeutlicht, dass technologische Lösungen nie endgültig sind und stetige Anpassung, Lernen und Weiterentwicklung zu den entscheidenden Erfolgsfaktoren gehören. Die Betrachtung der Geschichte von verteilten Systemen, Betriebssystemen und Netzwerken ist daher nicht nur ein nostalgischer Rückblick, sondern eine wertvolle Grundlage für zukünftige Innovationen und nachhaltigen Erfolg in der IT-Branche.

![I do wish people would stop doing this – The absolute state of modern journalism [video]](/images/C0B44980-8E0C-4D6B-ABAB-5B7F7FE0756F)