In der heutigen digitalen Landschaft sind komplexe B2B SaaS-Lösungen unverzichtbare Werkzeuge für Unternehmen, die auf Datenintegration und -modellierung angewiesen sind. Gerade bei solchen Systemen ist die Qualität der Daten von zentraler Bedeutung, insbesondere wenn es um Analyse-Stacks geht, die hohe Genauigkeit erfordern. Dabei stellt sich eine immer drängendere Frage: Wie lässt sich Testdaten-Generierung so gestalten, dass sie den Anforderungen an Datenschutz, Skalierbarkeit und Realitätsnähe gerecht wird? Die Herausforderung bei der Testdaten-Erstellung für komplexe B2B SaaS-Plattformen ergibt sich oft durch mehrere Faktoren. Zum einen bestehen diese Systeme aus zahlreichen Datenquellen – im beschriebenen Fall beispielsweise 15 verschiedene Datenquellen mit insgesamt 50 bis 60 Tabellen. Diese Vielfalt und Komplexität erschwert eine einfache Duplizierung von Produktionsdaten, was durch Datenschutzbestimmungen wie die europäische DSGVO zusätzlich stark eingeschränkt wird.

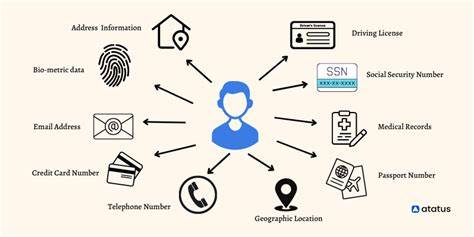

Die Verwendung echter Kundendaten außerhalb produktiver Umgebungen ist häufig nicht zulässig, womit die Notwendigkeit einer synthetischen und zugleich realistischen Testdatenbasis entsteht. Um zuverlässige Dummy-Daten in maßgeblicher Qualität zu erzeugen, ist es wichtig, den Entstehungsprozess strategisch anzugehen. Hierbei ist es sinnvoll, zunächst die Datenstruktur und die Beziehungen zwischen den Tabellen detailliert zu verstehen. Dies betrifft sowohl Primärschlüssel, Fremdbeziehungen als auch spezielle Constraints oder Abhängigkeiten innerhalb der Datenmodelle. Das Ziel besteht darin, dass generierte Testdaten nicht nur syntaktisch korrekt sind, sondern auch die Komplexität der realen Datenlandschaft im Modell widerspiegeln.

Ein weiterer zentraler Aspekt ist die Wiederholbarkeit und Automatisierung der Testdaten-Erzeugung. Gerade in agilen und schnell iterierenden Entwicklungsprozessen ist es essentiell, dass Testdaten mit minimalem manuellem Aufwand immer wieder aktuell und konsistent generiert werden können. Dabei helfen Werkzeuge und Frameworks, die deklarativ oder programmatisch konfiguriert werden und beispielsweise auf Templates oder Regeln basieren, um realitätsnahe Werte zu erzeugen. Einige moderne Tools bieten zudem die Möglichkeit, statistische Verteilungsmuster aus anonymisierten Quelltabellen zu extrahieren und auf Testdatensätze zu übertragen, ohne dabei sensible Informationen preiszugeben. Die Datenschutzkonformität darf selbstverständlich nicht vernachlässigt werden.

Im Zuge von GDPR oder vergleichbaren Regelwerken ist es wichtig, keine personenbezogenen Daten aus Produktsystemen direkt zu verwenden oder gar auf Testumgebungen zu übertragen. Deshalb ist Anonymisierung eine wichtige Methode, bei der sensible Informationen so verändert werden, dass die Beziehung zum Individuum nicht mehr nachvollziehbar ist. Allerdings reicht Anonymisierung manchmal nicht aus, vor allem wenn die Testdaten für umfangreiche Modellierungen und Analysen genutzt werden sollen, die eine realistische Datenvielfalt benötigen. In diesem Fall bietet sich die Generierung vollständig synthetischer Daten an, die auf realen Datenstrukturen basieren, aber keine Rückschlüsse auf echte Kundeninformationen zulassen. Die Wahl geeigneter Technologien spielt eine bedeutende Rolle.

Es gibt spezialisierte Tools, die sich auf die Generierung synthetischer Daten konzentrieren und umfangreiche Konfigurationsmöglichkeiten bieten. Diese Lösungen ermöglichen es, unterschiedlichste Datentypen – wie numerische, kategorische, zeitliche oder geografische Daten – inklusive komplexer Abhängigkeiten und Verteilungen abzubilden. Zusätzlich sind Open-Source-Frameworks verfügbar, mit denen Entwickler eigene Testdaten-Generatoren programmieren und flexibel in bestehende Pipelines integrieren können. Cloud-basierte Services stellen eine weitere Option dar, indem sie skalierbare und sichere Datenumgebungen bieten, die den Compliance-Anforderungen entsprechen. Ein wichtiger Erfolgsfaktor liegt in der Validierung der generierten Testdaten.

Hierzu gehört, dass die erzeugten Datensätze systematisch auf Plausibilität, Vollständigkeit und Konsistenz geprüft werden. Automatisierte Tests können ihre Struktur, Wertebereiche und Beziehungen kontrollieren und so sicherstellen, dass Modelle und Analysen auf einer belastbaren Datenbasis aufbauen. Entwickler und Data Scientists können zudem durch Vergleiche von Schlüsselmetriken zwischen Test- und Produktionsdaten erkennen, ob die synthetischen Daten die wesentlichen Eigenschaften der realen Daten hinreichend gut reflektieren. Die Integration der Testdaten-Generierung in den DevOps- oder CI/CD-Prozess stellt ein Best Practice dar, um Datenqualität und Nachvollziehbarkeit dauerhaft zu gewährleisten. Automatisierte Pipelines können mit jedem Build oder Deployment aktualisierte Testdaten bereitstellen, sodass Teams stets mit aktuellen und konsistenten Daten arbeiten.

So werden Fehler frühzeitig entdeckt und aufwendige manuelle Nacharbeiten vermieden. Zusammenfassend lässt sich sagen, dass die Herausforderung der Testdaten-Generierung in komplexen B2B SaaS-Umgebungen mit einem systematischen, datenschutzorientierten Ansatz bewältigt werden kann. Ein tiefes Verständnis der Datenstruktur und des Anwendungsfalls, kombiniert mit passenden Technologien und Automatisierungsprozessen, bildet die Grundlage für einen effektiven und skalierbaren Workflow. Dabei hilft eine klare Strategie zur Wahrung der Compliance und zur Sicherstellung von Genauigkeit, um langfristig erfolgreiche Analysen und modulare Entwicklungen auf verlässlicher Datenbasis umzusetzen.

![Aston Martin x Apple CarPlay Ultra – Next generation of automotive connectivity [video]](/images/08377B12-8A6E-4D36-9447-F332810DE362)