Die rasante Entwicklung von großen Sprachmodellen (Large Language Models, LLMs) hat die Art und Weise, wie Entwickler mit KI in Entwicklungsumgebungen arbeiten, grundlegend verändert. JetBrains AI Assistant ist eine der innovativsten Plattformen, die Künstliche Intelligenz tief in den Entwicklungsprozess integriert. Doch trotz der leistungsstarken Funktionen stoßen Nutzer oft auf Limitierungen, insbesondere was verfügbare Ressourcen und Kostenkontingente angeht. Genau hier setzt ein spannendes Projekt an, das Drittanbieter-LLM-APIs als lokale Modelle in JetBrains AI Assistant verfügbar macht. Diese Lösung eröffnet völlig neue Möglichkeiten für Entwickler, die maßgeschneiderte KI-Modelle nutzen möchten, ohne an die Standardangebote gebunden zu sein.

Der Kern dieser Innovation ist eine Proxy-Anwendung namens ProxyAsLocalModel, die als Bindeglied fungiert. Sie macht externe LLM-APIs für den JetBrains AI Assistant so zugänglich, als handelte es sich um lokal installierte Modelle. So können Nutzer mit Anbietern wie OpenAI, Gemini, Deepseek, Mistral oder Alibaba Qwen nahtlos zusammenarbeiten, obwohl die internen Mechanismen weiterhin auf lokale Modelle ausgerichtet sind. Der Treiber hinter ProxyAsLocalModel ist der Wunsch, die eigene Entwicklungskomfortzone zu erweitern und zugleich Limitierungen zu überwinden. JetBrains AI Assistant bietet im Grundsatz eine kostenlose Einstiegslösung, doch die zur Verfügung stehenden Credits sind begrenzt.

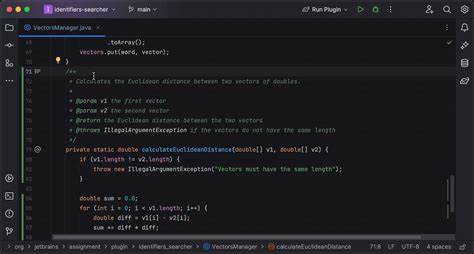

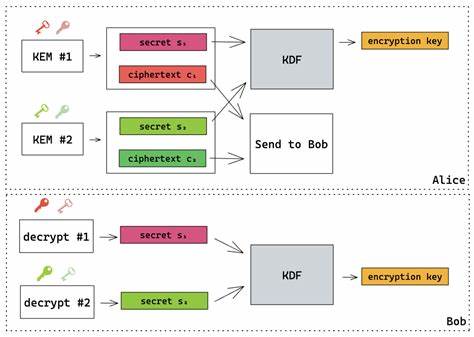

Wer auf leistungsfähigere oder spezialisierte LLMs zugreifen möchte, greift daher häufig auf kostenpflichtige oder umfangreichere APIs zurück. Die Hürde: JetBrains unterstützt offiziell zum Zeitpunkt der Entwicklung nur lokale Modelle von LM Studio oder Ollama. ProxyAsLocalModel schließt diese Lücke, indem es einen serverseitigen Proxy bereitstellt, der die API-Aufrufe an externe Anbieter entgegennimmt und in einem Format zurückliefert, das der AI Assistant als lokale Modellantwort erkennen kann. Diese Herangehensweise ist technisch anspruchsvoll, vor allem wegen der Dynamik und Reflexion, die viele offizielle SDKs mitbringen und die eine effiziente und nativen plattformübergreifende Umsetzung erschweren. Um diesen Herausforderungen zu begegnen, setzte der Entwickler auf Kotlin in Kombination mit Ktor für den HTTP-Server und kotlinx.

serialization für die Datenverarbeitung - beides Technologien, die ohne Reflexion auskommen und sich dadurch ideal für schnelle Startzeiten und geringe Speicherbelastung eignen. Diese technische Basis erlaubt es, den Proxy als eine sogenannte „fat runnable jar“ oder sogar als GraalVM-native Image bereitzustellen, wodurch die Lösung plattformunabhängig und ressourcenschonend ausgeführt werden kann. Ein großer Vorteil dieser Struktur liegt in der Flexibilität der Konfiguration. Der Proxy lädt seine Einstellungen aus einer YAML-Konfigurationsdatei, die zur Laufzeit automatisch überwacht und bei Änderungen live angepasst wird. So gelingt ein unkomplizierter Wechsel zwischen verschiedenen API-Anbietern oder Modellen, ohne dass der Server neu gestartet werden muss.

Entwicklern wird somit die Möglichkeit geboten, präzise auf ihre individuellen Anforderungen zu reagieren und unterschiedliche KI-Modelle parallel im Einsatz zu haben. Die unterstützten Anbieter sind breit gefächert und umfassen neben OpenAI und Claude auch die chinesische DashScope-Lösung Qwen von Alibaba, das aufstrebende Gemini-Modell, spezialisierte Modelle von Deepseek und Mistral sowie SiliconFlow. Damit kann die Community aus einem vielfältigen Pool an LLMs schöpfen, um für spezielle Tasks und Projekte stets das ideale Werkzeug zur Verfügung zu haben. Auch technisch legt ProxyAsLocalModel den Fokus auf Streaming-Chat-Completion-APIs. Diese ermöglichen eine interaktive Verarbeitung von Textanfragen, bei denen die Nutzer nahezu in Echtzeit die Generation der Antwort verfolgen können.

Dieses Feature ist essenziell für viele Anwendungsfälle im Coding-Kontext, wo schnelles Feedback und adaptives Verhalten der KI entscheidend sind. Der praktische Einsatz erfordert lediglich das Starten des Proxyservers, der standardmäßig sowohl einen LM Studio als auch einen Ollama-kompatiblen Endpunkt zur Verfügung stellt. Nach dem ersten Start erstellt die Anwendung automatisch eine Beispielkonfigurationsdatei, die mit Schema-Annotations angereichert ist. Diese Annotations helfen beim Editieren im favorisierten Editor durch Auto-Vervollständigung und Validierungsfunktionalitäten. So lassen sich die API-Schlüssel und Modellbezeichnungen komfortabel hinterlegen.

Die Verbindung erfolgt dann zwischen JetBrains AI Assistant und dem Proxy, der transparent die entsprechenden Drittanbieter-APIs abfragt. Für Entwickler bedeutet das eine enorme Erleichterung, denn sie können ihre bekannten IDE-Workflows mit der Intelligenz von Drittanbieter-LLMs erweitern, ohne aufwändige Anpassungen vornehmen zu müssen oder die Limitierungen des kostenlosen Plans von JetBrains direkt zu spüren. Darüber hinaus eröffnet die Proxy-Lösung neue Perspektiven für das Entwickeln von KI-Funktionen mit eigener Infrastruktur. Unternehmen oder fortgeschrittene Anwender können so ihre bevorzugten oder selbst gehosteten Modelle anbinden und für alle Nutzer innerhalb ihrer Arbeitsumgebungen verfügbar machen. Die Kombination aus Offenheit, einfacher Bedienung und technischer Robustheit macht ProxyAsLocalModel zu einem bemerkenswerten Werkzeug im modernen Softwareentwicklungszyklus.

Die Erstellung dieser Lösung zeigt zudem, dass Kotlin und dessen Ökosystem sich hervorragend für anspruchsvolle Serveranwendungen eignen, die effizienten Ressourcenverbrauch und schnelle Startzeiten benötigen. Gerade die Einschränkungen, die bei der Erstellung von nativen Images für GraalVM durch Reflexion entstehen können, werden dank der bewussten Wahl von Ktor und kotlinx.serialization elegant umgangen. Dieses Beispiel verdeutlicht, wie moderne Programmiersprachen und Frameworks aktuelle Herausforderungen adressieren können, um praktische Mehrwerte für Entwickler bereitzustellen. Für alle Entwicklerteams, die mit JetBrains-Produkten arbeiten und ihre KI-Assistenz auf ein neues Level heben möchten, ist die Möglichkeit, Drittanbieter-LLMs nahtlos einzubinden, ein großer Fortschritt.

Sie profitieren von einem persönlicheren Zugriff auf leistungsfähige Modelle, können Kosten besser kalkulieren und Nutzungsbeschränkungen aus dem Weg gehen. Zudem unterstützt die Anwendung mehrere Modelle parallel – ein wichtiger Vorteil für Projekte mit multifunktionalen Anforderungen und variierenden KI-Bedürfnissen. Insgesamt zeigt das Projekt eindrucksvoll, wie die Integration externer Anbieter in bestehende KI-Plattformen realisiert werden kann, ohne Kompromisse bei Bedienkomfort oder Performance einzugehen. Die offene Verfügbarkeit auf GitHub fördert zudem die Weiterentwicklung durch die Community und ermöglicht Anpassungen an zukünftige Anforderungen oder neue LLM-Angebote. Abschließend lässt sich sagen, dass die Nutzung von Drittanbieter-LLM-APIs in JetBrains AI Assistant ein kraftvolles Werkzeug für Entwickler ist, die das Potenzial der KI optimal ausschöpfen wollen.

Mit ProxyAsLocalModel trifft technische Innovation auf pragmatische Nutzerfreundlichkeit und unterstützt damit einen modernen, flexiblen und kosteneffizienten Entwicklungsprozess im KI-Zeitalter.

![Earth Is Rapidly Approaching Dangerous, Irreversible,Cascading Climate Tipping [video]](/images/AA32E486-0F2E-42EA-BA66-27A03218EC58)