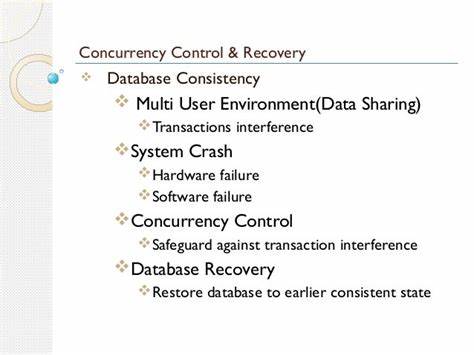

Die Verwaltung gleichzeitiger Zugriffe und die Sicherstellung der Datenintegrität trotz möglicher Systemfehler stellen seit jeher zentrale Herausforderungen in der Welt der Datenbanksysteme dar. Das Buch „Concurrency Control and Recovery in Database Systems“ von Bernstein, Hadzilacos und Goodman aus dem Jahr 1987 bildet hier einen Meilenstein, indem es erstmals umfassend auf die komplexen Problematiken beider Themenkomplexe eingeht. Insbesondere das Vorwort und das erste Kapitel geben einen fundierten Einstieg in das Verständnis der wesentlichen Probleme und Lösungsansätze und bieten damit einen wertvollen Blick auf den Stand der Technik in den späten 1980er-Jahren, der zugleich zahlreiche Grundlagen für die weitere Entwicklung legte. Im Zentrum der Betrachtung steht die Frage, wie Datenbanksysteme mit mehreren parallel laufenden Transaktionen umgehen, ohne dass dabei Inkonsistenzen entstehen oder die Korrektheit der gespeicherten Daten verloren geht. Nutzer einer Datenbank erwarten von ihren Transaktionen ein einfach zu verstehendes, einheitliches Verhalten: Entweder werden alle Operationen einer Transaktion erfolgreich abgeschlossen (Commit), oder sie werden im Falle eines Fehlers vollständig zurückgenommen (Abort).

Diese Forderung nach atomarem Verhalten ist zentral für die Verarbeitung von Daten und stellt gleichzeitig die Herausforderung an die interne Koordination der einzelnen Operationen innerhalb des Systems dar. Das Problem der Konkurrenzsteuerung (Concurrency Control) entsteht dabei durch die gleichzeitige Ausführung von Transaktionen, die auf die gleichen Datenobjekte zugreifen wollen. Ohne geeignete Mechanismen könnten sich die Schreib- und Leseoperationen überschneiden und zu Fehlern wie verlorenen Aktualisierungen, inkonsistenten Datenständen oder sogar zu Deadlocks führen. Das erste Kapitel des Buches beleuchtet diese Problematik ausführlich und stellt mit Hilfe von anschaulichen Beispielen dar, wie Transaktionen sich gegenseitig beeinflussen können, und welche Konsequenzen dies für den Zustand der Daten hat. Ein weiterer wesentlicher Aspekt ist die Wiederherstellung (Recovery) nach einem Systemausfall.

Unabhängig von den Maßnahmen zur Vermeidung von Konflikten können Softwarefehler, Hardwareausfälle oder unerwartete Stromunterbrechungen zu einem plötzlichen Abbruch eines laufenden Transaktionsprozesses führen. Hier kommt die Fähigkeit des Datenbanksystems zum Tragen, den konsistenten Zustand möglichst schnell und sicher wiederherzustellen, ohne dass dabei Daten verloren gehen oder unvollständige Transaktionen in der Datenbank verbleiben. Im Buch wird der Stellenwert der Wiederherstellung bereits im Titel hervorgehoben, was zu jener Zeit ungewöhnlich war, da eine definitive Lösung noch nicht etabliert war. Das bedeutende ARIES-Protokoll, welches später als Standard gelten sollte, erschien erst 1992. Interessant ist die Beschreibung des Modells einer Datenbankumgebung, das im ersten Kapitel entwickelt wird.

Es besteht aus vier Kernkomponenten: dem Transaktionsmanager, der sämtliche Transaktionen verwaltet und steuert; dem Scheduler, der für die korrekte Reihenfolge und Durchführung der Operationen unter Berücksichtigung der Konkurrenzsteuerung verantwortlich ist; dem Wiederherstellungsmanager, der Atomizität und Dauerhaftigkeit sicherstellt; und schließlich dem Cache-Manager, der den Datenfluss zwischen flüchtigem Speicher und persistentem Speicher steuert. Diese Aufteilung verdeutlicht die klare Trennung der Verantwortlichkeiten, die selbst in modernen Systemen grundlegende Bedeutung besitzt, auch wenn heutige Implementierungen wesentlich komplexer und vernetzter sind. Die Interaktion zwischen diesen Komponenten basiert auf einem einfachen, aber effektiven Handshake-Verfahren. Wenn beispielsweise der Scheduler eine bestimmte Reihenfolge von Operationen durchsetzen will, etwa dass ein Schreibvorgang vor dem Schreiben auf das Speichermedium abgeschlossen sein muss, wartet er auf eine Bestätigung, bevor die nächste Operation gestartet wird. Dieses Prinzip der Koordination führt zu einem klar verständlichen Zusammenspiel der Module und bildet die Basis für strikte Serialisierbarkeit, die sicherstellt, dass das Endergebnis von Transaktionen dem eines seriellen Ablaufes entspricht – also so, als wären die Transaktionen nacheinander abgelaufen, obwohl sie tatsächlich parallel ausgeführt wurden.

Das Buch geht zudem detailliert auf wichtige theoretische Grundlagen ein. Hierzu zählt die Serialisierbarkeitstheorie, die formale Kriterien definiert, wann die Ausführung mehrerer gleichzeitiger Transaktionen als korrekt angesehen werden kann. Ebenso werden zwei Phasen Sperrprotokoll (Two-Phase Locking) und alternative Protokolle, etwa Multiversion Concurrency Control (MVCC), vorgestellt. Während MVCC heutzutage weit verbreitet ist, war es zur Zeit der Veröffentlichung des Buches noch nicht praktikabel, da die Speicher- und Rechenressourcen in den 1980er-Jahren stark limitiert waren. Stattdessen setzte man vorwiegend auf strikte Locking-Verfahren, um die Integrität der Daten sicherzustellen.

Ebenfalls berücksichtigt wurde die Problematik sogenannter Kaskadierender Abbrüche, bei denen die Rücknahme einer Transaktion wiederum andere Transaktionen zum Abbruch zwingt, was unerwünschte Nebeneffekte und Leistungseinbußen mit sich bringt. Diese Szenarien werden im ersten Kapitel unter dem Begriff der Wiederherstellbarkeit behandelt und mit Fallbeispielen versehen, um die Dringlichkeit einer sauberen Gestaltung der Steuermechanismen zu verdeutlichen. Im historischen Kontext überrascht die Tatsache, dass bereits vor über drei Jahrzehnten ein so umfassendes Bild der Probleme vorhanden war, das sämtliche heute noch gültigen Prinzipien abdeckt. Gleichzeitig wird aber auch klar, wie sehr die damalige technische Realität – begrenzte Ressourcen, fehlende Netzwerkeinbindung und mangelnde Unterstützung für verteilte Systeme – die Lösungsansätze prägte. Kapitel 8 des Buches widmet sich deshalb auch schon der Zukunft und beleuchtet Replikation in verteilten Umgebungen, wobei offen eingeräumt wird, dass zu diesem Zeitpunkt noch keine Datenbanksysteme allgemein unterstützte Zugriffsmöglichkeiten auf replizierte verteilte Daten zuließen.

Aus heutiger Sicht kann man das Buch als ein Meilenstein betrachten, der sowohl den Stand der Wissenschaft im Jahr 1987 dokumentiert als auch die Basis für die nachfolgenden Entwicklungen im Bereich der Transaktionsverarbeitung bildet. Die klare Abgrenzung der Komponenten, die präzise Definition von Transaktionsverhalten aus Nutzersicht sowie die strukturierte Vorstellung von konkurrierenden Abläufen sind selbst heutzutage wertvolle Lehrinhalte. Für jeden, der sich mit Datenbanksystemen, der Transaktionsverarbeitung oder verteilten Systemen beschäftigt, ist das Verständnis der hier eingeführten Konzepte fundamental. Darüber hinaus vermittelt das Werk Einblicke in die technische Entwicklungsgeschichte und zeigt, wie sich theoretische Konzepte im Laufe der Zeit in praktikable Technologien und Protokolle übersetzen ließen. Die Trennung von Konkurrenzsteuerung und Wiederherstellung als eigenständige, wenn auch eng miteinander verknüpfte Problemfelder bleibt bis heute relevant und wird in modernen Systemen mit unterschiedlichen Prioritäten und Ressourcen umgesetzt.

Zusammenfassend lässt sich festhalten, dass die Herausforderungen der Konkurrenzsteuerung und Datenwiederherstellung wie im Buch dargestellt nach wie vor aktuell sind, auch wenn sich Details und Umsetzungsformen geändert haben. Das Verständnis der grundlegenden Prinzipien aus dem Vorwort und Kapitel 1 liefert wertvolle Orientierung, um heutige Systeme besser zu verstehen und weiterzuentwickeln. Die bewusst einfache Modellierung der Systemkomponenten sowie die klaren Definitionen erlauben es, auch komplexe Abläufe zu durchschauen und die Grundlage für robuste, effiziente und konsistente Datenbanksysteme zu legen.

![The Lego Island decompilation is now 100% complete [video]](/images/C54AB8F3-B840-49FD-A682-48BE2C634FC8)