Am 12. Juni 2025 wurde die digitale Welt Zeuge einer beeindruckenden Kettenreaktion, ausgelöst durch einen Fehler bei einem zentralen Google Cloud-Dienst. Was zunächst wie ein gewöhnliches technisches Problem bei Google Cloud erschien, entpuppte sich schnell als weitreichende Störung, die zahlreiche Dienste und Milliarden von Nutzern rund um den Globus betraf. Die Störung, die das Identity and Access Management (IAM) von Google Cloud betraf, legte praktisch viele der wichtigsten GCP-Produkte lahm und wirkte sich drastisch auf Cloudflare und den KI-Startup Anthropic aus. Dieser Vorfall zeigt auf drastische Weise, wie eng unsere moderne digitale Infrastruktur verknüpft und damit auch anfällig für Kaskadeneffekte ist – wenn Google niest, friert die ganze digitale Welt ein.

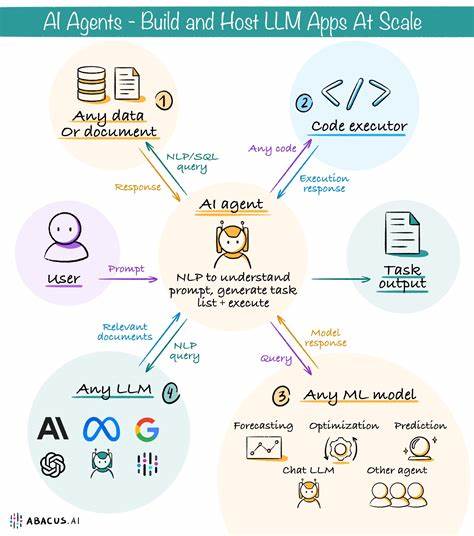

Das Herzstück der Störung war der Google Cloud IAM-Dienst, der für die Authentifizierung und Autorisierung aller API-Anfragen in der Google Cloud verantwortlich ist. IAM fungiert als digitale Schlüsselstelle, die sicherstellt, dass nur autorisierte Nutzer und Systeme Zugriff auf Ressourcen erhalten. Sobald diese Schlüsselstelle versagt, bricht das gesamte System zusammen, da keine Dienste mehr korrekt authentifiziert werden können. Genau dies geschah am Morgen des 12. Juni 2025 gegen 10:50 Uhr Pazifischer Zeit, als eine fehlerhafte Softwareeinspielung zu massiven 5xx-Fehlern in den IAM-Endpunkten führte.

Innerhalb Minuten, nachdem die internen Alarme bei Google Cloud ausschlugen, berichteten Nutzer über Ausfälle und Fehlermeldungen in einer Vielzahl von Google-Diensten, darunter Gmail, Google Drive und Meet. Die Störung breitete sich rasch aus und traf nicht nur Google-eigene Angebote, sondern auch Drittanbieter, die auf Google Cloud-Infrastrukturen aufbauen. Besonders deutlich wurde die Verwundbarkeit dieser Infrastruktur durch die Auswirkungen auf Cloudflare, einen der größten Anbieter von Web-Infrastruktur- und Sicherheitsdiensten weltweit. Cloudflare betreibt Workers KV, ein key-value Speicher-System, das Milliarden von Einträgen global über mehr als 270 Edge-Standorte repliziert. Obwohl der sogenannte Hot Path des Speichers in den Rechenzentren von Cloudflare selbst liegt, nutzte Cloudflare eine persistente Backend-Datenbank, die auf Google Cloud gehostet wurde.

Als durch den IAM-Ausfall keine gültigen Token mehr ausgestellt wurden, kam es zu massiven Zeitüberschreitungen bei Lese- und Schreiboperationen in diesem Backend. Dies führte dazu, dass essenzielle Cloudflare-Dienste wie Access, WARP und Zero Trust Features nicht mehr funktionierten. Nutzer erlebten Login-Schleifen, Verbindungsabbrüche und funktionale Einschränkungen. Noch stärker tangiert wurde der KI-Startup Anthropic, der auf Google Cloud als Hostingplattform für seine KI Claude setzt. Insbesondere Uploads von Dateien und Bildern, welche die Cloud Storage Dienste beanspruchen, waren betroffen.

Zwar blieben einfache Textabfragen durch zwischengespeicherte Token teilweise möglich, doch erhöhte Fehlerquoten und eingeschränkte Funktionalität führten dazu, dass Anthropic Uploads vorsorglich deaktivieren musste, um die Belastung zu reduzieren. Nach mehreren Stunden konnten die Dienste jedoch sukzessive wieder vollständig hergestellt werden. Die Wiederherstellung gestaltete sich komplex und zeitintensiv. Google musste die problematische Softwareeinspielung zurückrollen, fehlerhafte Konfigurationen beseitigen und eine globale Token-Cache-Aktualisierung durchführen. Besonders die Region us-central1, in der wichtige Quorum-Shards für IAM-Metadaten gehostet werden, zeigte sich als schwerfällig bei der Erholung.

Während die meisten anderen Regionen innerhalb weniger Stunden wieder stabil liefen, zog sich die vollständige Wiederherstellung in us-central1 und bei Spezialdiensten wie Dataflow und Vertex AI bis in den späten Nachmittag. Dieser Vorfall macht einmal mehr deutlich, wie kritisch das Management von Abhängigkeiten in der Cloud-Welt ist. Cloudflare arbeitet zwar als Multi-Cloud-Anbieter, dennoch war eine einzelne, tief verankerte Google Cloud-Komponente der Flaschenhals und damit der Ursprung eines globalen Ausfalls. Dies unterstreicht die Notwendigkeit, verborgene Abhängigkeiten systematisch zu identifizieren und in Notfallplänen zu berücksichtigen. Für Entwickler, Architekten und Betreiber von Cloud-Diensten liefert der Vorfall weitere wichtige Erkenntnisse.

Kontrollplane, die für Authentifizierung, Autorisierung und Steuerung zuständig sind, besitzen eine herausragende Bedeutung. Selbst wenn Daten in mehreren Zonen redundant gespeichert sind, nutzt diese Redundanz wenig, wenn die Authentifizierung ausfällt und Anfragen nicht autorisiert werden können. Außerdem wird klar, dass Statusseiten und Kommunikationskanäle in Krisenzeiten mehr als nur eine Formalität sind – sie müssen schnell, transparent und zuverlässig informieren, um Kunden und Partner nicht im Dunkeln tappen zu lassen. Darüber hinaus regt diese Ereigniskette dazu an, Notfallmechanismen wie Authentifizierungsausweichrouten oder temporäre Bypass-Strategien zu entwickeln. Wenn Authentifizierungsdienste selbst ausfallen, ist es entscheidend, zumindest eingeschränkte Funktionalität gewährleisten zu können, um katastrophale Totalausfälle zu vermeiden.

Auch die Bedeutung regelmäßiger Chaos-Tests und Ausfallsimulationen wird durch diese Ereignisse gestärkt. Solche Übungen helfen, seltene, jedoch gravierende Multi-Anbieter-Ausfälle zu antizipieren und das Reaktionsverhalten zu verbessern. In einer hochvernetzten Cloud-Welt sind Kettenreaktionen möglich und entfalten sich schnell. Nur wer vorbereitet ist, kann die entstehende Komplexität beherrschen. Google hat angekündigt, einen ausführlichen Postmortem-Bericht zu veröffentlichen, der detaillierte Erkenntnisse zum fehlerhaften Rollout, der Ausbreitung und den zukünftigen Schutzmaßnahmen enthalten soll.

Auch Cloudflare plant eine Veröffentlichung, die tief in die Architektur von Workers KV eintauchen und neue Redundanzmaßnahmen vorstellen wird. Im Rückblick zeigt sich, dass der IAM-Ausfall nicht nur eine technische Störung darstellte, sondern ein Spiegelbild der heutigen Cloud-Infrastruktur. Fehlkonfigurationen, die zu solch massiven Problemen führen, können jederzeit passieren – oft zur ungünstigsten Zeit, wie ein Dienstagmorgen. Die eng verflochtenen Dependencies innerhalb und zwischen Cloud-Anbietern führen zu einem fragilen Ökosystem, das große Ausfälle wahrscheinlicher macht. Diese Episode sollte Unternehmen und Technikverantwortliche motivieren, ihre eigenen Abhängigkeiten kritisch zu prüfen, robuste Notfallpläne zu erstellen und ihre Systeme resilienter zu gestalten.

Denn in der immer stärker vernetzen, digitalen Welt kann der Ausfall eines einzigen Services schnell die ganze Kette ins Wanken bringen. Die Botschaft ist klar: Wer in der Cloud arbeitet, muss die Komplexität meistern, Risiken verstehen und aktiv gegen Ausfälle vorsorgen. Nur so kann die digitale Welt stabil, zuverlässig und sicher bleiben – auch wenn Google mal niest.