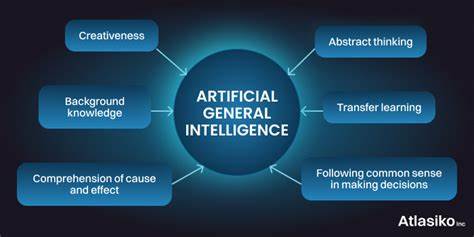

Die rasante Entwicklung im Bereich der Künstlichen Intelligenz hat das Ziel geprägt, Maschinen zu schaffen, die nicht nur auf einzelne Aufgabenstellungen beschränkt sind, sondern ein vielseitiges und tiefgründiges Verständnis besitzen – die sogenannte Artificial General Intelligence (AGI). Innerhalb dieses weiten Feldes nimmt Engineering Artificial General Intelligence, kurz eAGI, eine besondere Rolle ein. Sie fokussiert sich auf die Anwendung von AGI im Ingenieurwesen, speziell auf die Entwicklung und Steuerung physischer Systeme. Die Herausforderung besteht darin, dass diese KI-Agenten neben rein theoretischem Wissen auch praktische Fähigkeiten brauchen, um komplexe technische Probleme zu lösen und kreative Designs zu entwickeln. Doch wie kann man die Leistungsfähigkeit solcher Systeme effektiv bewerten? Die Evaluation von eAGI ist ein Schlüsselaspekt, um Fortschritte messbar zu machen und einen praxisorientierten Einsatz voranzutreiben.

Infolgedessen beschäftigt sich die Forschung zunehmend mit der Entwicklung spezialisierter Bewertungsrahmen, die den Anforderungen des Engineering-Kontexts gerecht werden. Die Bewertung von eAGI-Agenten unterscheidet sich fundamentell von klassischen KI-Evaluierungen. Während beispielsweise Sprachmodelle vor allem anhand ihrer sprachlichen Fähigkeiten und ihres Verständnisses getestet werden, müssen eAGI-Systeme auf breiter Ebene sowohl methodisches Wissen als auch Kreativität und technische Umsetzbarkeit demonstrieren. Sie müssen in der Lage sein, industrielle Komponenten zu verstehen, bewährte Designmuster anzuwenden und ihr Wissen situationsabhängig zu transferieren. Dabei gehen die Anforderungen weit über reine Textanalyse hinaus: Auch strukturierte Artefakte wie CAD- oder SysML-Modelle werden zunehmend zu Evaluationsobjekten.

Ein erfolgreiches Evaluationssystem für eAGI sollte daher flexibel genug sein, um verschiedene Antwortformen zu akzeptieren und dabei auch Automatisierungen zu ermöglichen, die den Aufwand reduzieren und gleichzeitig präzise Ergebnisse liefern. Eines der vielversprechendsten Konzepte für eine solche Bewertung ist die Anpassung von Bloom's Taxonomy – einem etablierten Modell für die Bewertung menschlichen Lernens – auf die Bedürfnisse der technischen Ingenieurswelt. Bloom’s Taxonomy umfasst verschiedene Ebenen kognitiver Fähigkeiten, von der Wissensaufnahme über das Verstehen und Anwenden bis hin zu Analyse, Synthese und Bewertung. Indem diese Ebenen auf technische Fragestellungen und praktische Engineering-Aufgaben übertragen werden, entsteht eine strukturierte Methodik, um eAGI-Agenten differenziert zu bewerten. Ein weiteres Kernmerkmal eines solchen Rahmens ist die Modularität: Die Evaluierung muss an unterschiedliche Fachgebiete innerhalb des Ingenieurwesens angepasst werden können.

So benötigt etwa der Maschinenbau andere Bewertungskriterien als die Elektrotechnik oder die Luft- und Raumfahrt. Ein plattformunabhängiges, erweiterbares System, das sowohl generisches als auch fachspezifisches Wissen abfragt, bietet die notwendige Flexibilität, um in verschiedenen Anwendungen zuverlässig zu funktionieren. Darüber hinaus ist es von großer Bedeutung, dass die Evaluation realitätsnah gestaltet wird. Aufgaben sollten reale Problemstellungen widerspiegeln und sowohl methodische Tiefe als auch kreative Lösungsansätze erfordern. Nur so lässt sich feststellen, ob die eAGI-Agenten tatsächlich in der Lage sind, das breite Spektrum der Herausforderungen im Engineering zu meistern.

Zudem sollte die Bewertung auch die Fähigkeit zur Wissensübertragung prüfen – ein entscheidendes Merkmal intelligenter Systeme, um Innovation und Fortschritt zu fördern. Die Automatisierung der Evaluation wird mit zunehmender Komplexität der Aufgaben ebenfalls essenziell. Standardisierte Bewertungsverfahren erleichtern nicht nur die Vergleichbarkeit verschiedener Systeme, sondern ermöglichen auch kontinuierliches Lernen und Verbesserung. So können KI-Entwickler gezielt Schwachstellen erkennen und Anpassungen vornehmen, während Anwender sich auf objektiv geprüfte Fähigkeiten der Systeme verlassen können. Interessanterweise schließt der Fokus auf eAGI die Software-Entwicklung aus, da diese Domäne eigenes Fachwissen und spezialisierte KI-Agenten erfordert.

Stattdessen konzentriert sich eAGI auf die Herausforderung, physische Systeme zu verstehen, zu planen und zu optimieren – von mechanischen Konstruktionen bis hin zu komplexen Steuerungssystemen. Dies sorgt für eine überschaubare und dennoch anspruchsvolle Ausrichtung, die Kernkompetenzen eines Engineers widerspiegelt. Ein abschließender Blick auf die Zukunft zeigt, dass die fortschreitende Integration von eAGI in den industriellen Alltag eng mit der Etablierung verlässlicher Bewertungsverfahren verbunden sein wird. Nur wenn Ingenieure und Unternehmen den Fähigkeiten dieser KI vertrauen können, sind weitreichende Automatisierungen und Innovationen im technischen Bereich denkbar. Die Entwicklung intelligenter Agenten, die nicht nur Wissen simulieren, sondern aktiv schöpferisch und anwendungsorientiert tätig werden, ist eine der spannendsten Herausforderungen der kommenden Jahre.

Die Schaffung eines robusten, anpassbaren und multidimensionalen Bewertungssystems bildet dabei das Fundament, auf dem langfristiger Erfolg und gesellschaftlicher Mehrwert aufgebaut werden können. Zusammenfassend lässt sich sagen, dass die Evaluation von Engineering Artificial General Intelligence ein komplexes, aber wesentlichen Thema darstellt, um das Leistungsspektrum intelligenter technischer Systeme zu erfassen. Durch die Kombination bewährter pädagogischer Modelle mit spezifischem technischem Kontext entsteht ein Weg, der sowohl die Vielfalt der Anforderungen als auch die Tiefe der Kompetenzen eines eAGI-Agenten angemessen abbildet. Dieser Ansatz fördert nicht nur das technische Verständnis, sondern unterstützt auch die Entwicklung innovativer Lösungen, die letztlich die Zukunft der Technik maßgeblich prägen werden.